梯度下降其实不难

建议大家是去看吴恩达的视频

很好懂

我这里就随笔记录一下了

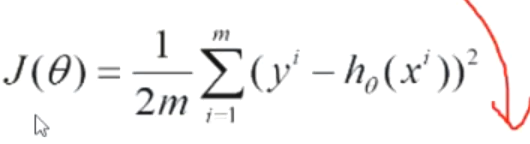

梯度下降总目标:

即loss值,所有真实label和预测出来的结果之间的误差的总和

需要更改theta 即h(x)里的参数使得上式变小,在线性回归中我们介绍了可以直接求解

但不是所有问题都可以直接求解的

这里的话,梯度下降的思想就是,进行求导,参数沿着偏导方向移动,则可以最快的减小目标函数值,导数的方向是变化得最快的对把

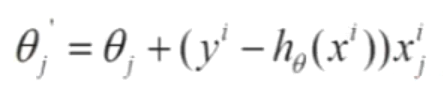

所以对loss求偏导 得到

上式是对所有样本进行的整体考虑,这样太过复杂,太慢,因为整体样本数量可能过多

随机梯度下降,则是一次只考虑一个样本,求导结果:

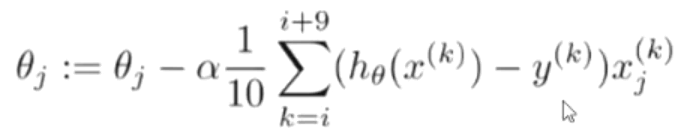

然后是batch梯度下降,也就是一次考虑若干个样本,考虑一个batch的样本,这样更稳

一般而言,batch越大,训练过程就越稳,越不会偏离方向,batch求导:

35万+

35万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?