Reinforcement Recommendation Reasoning through Knowledge Graphs for Explanation Path Quality

- 摘要

人们正在创建大量知识图(KG),以使推荐系统(RS)不仅智能而且知识丰富。 在推荐过程中集成知识图谱可以让底层模型从知识图谱中提取推荐产品和已经体验过的产品之间的推理路径。 可以利用这些路径来生成文本解释,以针对给定的推荐提供给用户。 然而,现有的基于知识图谱的可解释推荐方法仅仅优化了所选择的产品相关性推理路径,而没有考虑解释路径的任何用户级属性。 在本文中,我们提出了一系列定量属性,根据新近度、流行度和多样性,从解释的角度监控推理路径的质量。 然后,我们结合处理中和处理后的方法来优化推荐质量和推理路径质量。 对三个公共数据集的实验表明,我们的方法根据所提出的属性显着提高了推理路径质量,同时保持了推荐质量。

- 动机

向用户解释为什么向他们提供某些结果已成为现代系统的基本属性。 欧洲通用数据保护条例 (GDPR) 等法规要求“解释权”,这意味着在某些情况下,法律强制要求用户了解模型的行为方式 [11]。 从商业角度来看,解释也被证明是有好处的,可以增加对系统的信任,帮助用户更快地做出决策,并说服用户尝试购买[30]。 推荐系统(RS)是一类著名的决策支持系统,它敦促支持性解释。 现有的 RS 通常充当黑匣子,不向用户提供所提供建议的任何理由。 人们一直致力于挑战这些黑匣子,使推荐成为一个透明的社会过程[36]。

3.现有工作不足

最先进的基于路径的方法 依赖于强化学习 (RL) 代理,以用户为条件并经过训练,通过以下方式导航到该用户的潜在相关产品路径推理。 然后,代理根据代理采用现有路径到达给定推荐产品的概率,同时进行产品推荐和路径选择,对用户和 KG 中的产品之间的路径进行采样。 然而,为了选择用户-产品路径进行文本解释,所有现有的基于路径的方法仅考虑内部功能概率。 它们都没有嵌入与用户如何感知所选路径和派生文本解释有关的目标(例如,用户可能更喜欢与最近体验过的产品相关的解释)。 从技术角度来看,这种限制意味着现有的基于路径的方法不包括从解释角度对路径的用户级属性进行优化的术语,而只是衡量产品与用户相关程度的术语。

仅考虑内部功能概率:(个人理解)(A-C网络)

在图谱上进行可解释性推理,状态:(用户embedding,k步历史信息),状态输入到网络中,输出选择动作的概率分布,直接选择动作概率最大的动作。

虽然状态融合了用户信息和历史信息,但在某些情况下,仍可能存在忽略用户主观感受或特定上下文偏好的风险。为了更好地满足用户的个性化需求,可能需要更多地考虑用户反馈、情境和偏好等方面的因素。

例子:假设有一个电子商务推荐系统,该系统基于用户的历史购买记录和浏览行为来推荐产品。状态信息包括用户的个人资料、浏览历史、购买记录等。系统的目标是通过强化学习代理来最大化用户的点击率或购买率。然而,即使状态中包含了用户的个人资料和历史信息,但代理在选择推荐产品时可能仍然会忽略一些重要因素。

例如,用户可能有某种偏好,希望购买与最近生日礼物相关的产品。尽管用户的历史数据中没有明确提及这一点,但这个特定上下文偏好在此时可能对用户非常重要。

3.本文目标

我们的目标是在基于模板的文本解释上实现上述目标,重点关注用于实例化模板的推理路径的用户级离线属性。 假定此类路径是文本解释生成的输入,针对与用户相关的属性优化所选路径可以提高文本解释的感知质量。

实例化模板的推理路径:在生成文本解释时,根据推理路径选择的结果,将该路径中的信息填充到文本模板中,从而生成最终的个性化文本解释。

用户级离线属性:用户在离线环境中已经被确定和收集到的属性信息。这些属性通常是用户的基本信息、历史行为、偏好等,在用户与系统进行交互之前就已经存在,并且可以用来帮助系统理解和个性化地对待用户。

4.考虑的相关推理路径属性的空间

相关路径推理的考虑因素(音乐推荐系统)

新近度:

假设用户最近几次选择了摇滚乐的歌曲,那么基于新近度的路径可能会推荐最近发布的摇滚乐专辑或热门的摇滚歌曲。例如,文本解释可能是:“我们为您推荐最近发布的摇滚乐专辑,因为您最近喜欢听摇滚音乐。”

流行度:

假设某位用户是一位流行音乐爱好者,经常关注流行音乐榜单和热门歌手。在这种情况下,基于流行度的路径可能会推荐当前热门的流行歌曲或知名歌手的新专辑。例如,文本解释可能是:“我们为您推荐Taylor Swift的最新单曲,因为她是目前最流行的歌手之一。”

多样性:

假设用户喜欢流行音乐,但也对其他风格感兴趣,基于多样性的路径可能会推荐一些与用户喜欢的风格不同但相关的音乐。例如,推荐一些来自不同风格的音乐,如爵士乐或电子音乐。文本解释可能是:“除了流行音乐,我们还推荐一些不同风格的音乐,让您体验更丰富的音乐世界。”

考虑到了不同类型的路径:

基于协同过滤的路径:即基于其他用户的观影行为来进行推荐。例如,“因为观看电影A的另一个用户也喜欢电影B”。

基于电影的属性路径:即基于电影的属性信息来进行推荐。例如,推荐与用户最近观看的电影风格相似的电影,或者推荐与用户喜欢的导演相关的电影。

基于流行度的路径:即基于电影的流行程度来进行推荐。例如,推荐当前热门的电影或经典的影片。

基于定向关系的路径:即基于导演、演员或电影类型等定向关系来进行推荐。例如,推荐用户喜欢的特定演员主演的电影,或者推荐用户喜欢的特定类型的电影。

4.本文贡献

1.我们引入推理路径质量指标来衡量解释的新近度、流行度和多样性,并探索现有方法生成的路径在多大程度上保留这些属性。

2.我们提出并结合了一套处理中和处理后的方法,作用于推荐的产品和推理路径,优化所提出的推理路径质量指标。

3. 我们在三个现实世界的公共数据集上,根据七个基线,展示了我们的方法在推荐质量和推理路径质量之间权衡方面的好处和任何副作用。

解释:

处理中方法:

处理中方法指的是在推荐产品生成的过程中,考虑到用户的属性和路径信息来优化推荐结果。这可能涉及到路径选择、排序算法或其他推荐模型的调整,以提高推荐产品的质量和个性化程度。

例如,处理中方法可能会根据用户的偏好和最近的行为,调整推荐算法的权重或参数,以更好地满足用户的需求。

处理后方法:

处理后方法指的是在生成推荐产品之后,对推荐结果进行后处理,以进一步优化用户体验或满足特定需求。

例如,处理后方法可能会对推荐列表进行重新排序,将最相关或最新的产品放在前面,以便用户更容易找到感兴趣的产品。

随附文本解释:

随附文本解释是指在向用户展示推荐产品时,提供相应的解释或说明,以帮助用户理解推荐的原因或背后的逻辑。

例如,对于处理中方法生成的推荐产品,随附文本解释可能会说明:“我们根据您最近的购买记录和喜好,为您推荐了这些产品。”对于处理后方法生成的推荐产品,随附文本解释可能会说明:“我们根据您的反馈重新排序了推荐列表,将最相关的产品放在了前面。”

二、问题定义

1.知识图

我们考虑一个知识图,其中至少存在两种类型的实体:用户的集合 U ⊂ E 和产品的集合 P ⊂ E。 用户和产品之间的特殊关系 rf ∈ R 对用户反馈进行建模,并且取决于域(例如,用户“观看”电影或“听”歌曲)。 示例附加实体(和关系)可能是电影领域中的演员(演员“主演”电影)或导演(导演“导演”电影)或艺术家(艺术家“诠释”歌曲)和制片人(制片人) 在音乐领域“制作”了一首歌)。

2.k跳可解释路径

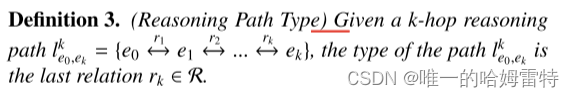

3.推理路径类型:该路径的最后一个三元组的关系

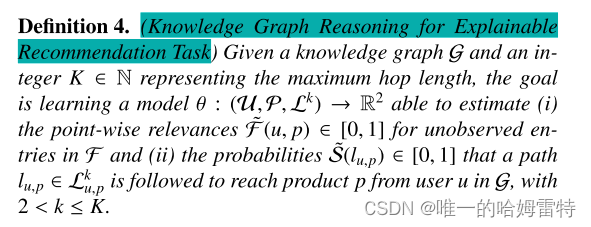

4.可解释推荐任务的知识图推理

5.推荐目标的定义

作者认为仅基于内部功能概率选择推理路径并不一定会产生高质量的解释。因此,假设存在两组函数来评估推荐质量属性和与用户相关的推理路径属性。

推荐质量属性RQ):这是一组函数,用于评估推荐产品的质量属性。这些函数将推荐产品作为输入,并产生一个评估推荐质量的值。这些属性可能包括产品的热度、相关性、新颖性等

推理路径属性(EQ):这是一组函数,用于评估与用户相关的推理路径的属性。这些函数将推理路径作为输入,并产生一个评估推理路径属性的值。这些属性可能包括推理路径中涉及的用户行为的新近度、频率、相关性等。

目标函数

为了简单起见,我们假设推荐和推理路径质量具有相同的权重,将用户的具体权重留给未来的工作。 考虑到推理路径属性的异构性,先前的工作假设原始推荐模型仅在推荐质量(RQ)上进行优化,而推理路径质量(EQ)通过后处理进行优化。 我们在本文中的研究探索了推荐质量和推理路径质量的处理中优化,以及处理中和处理后优化的结合。

6.生成文本解释

所选推理路径用于推荐产品的生成步骤,并作为文本解释生成步骤的输入。这样的生成步骤可能基于模板或高级自然语言生成技术。在我们的研究中,我们专注于基于模板的文本解释生成,根据底层模型选择的推理路径。通常,模板可以被视为包含表达式的字符串文字,其内容由模型生成。形式上:

模板: "根据{{路径}}, 我们为您推荐了{{产品}},因为{{原因}}。"

在这个模板中,{{路径}}、{{产品}}和{{原因}}等表达式会由底层模型根据推理路径和其他信息动态生成,形成最终的文本解释。例如:

根据您最近喜欢的电影类型,我们为您推荐了这部电影,因为它与您的喜好相符。

这个例子展示了如何根据模板和推理路径动态生成文本解释,使得解释更具可解释性和个性化。

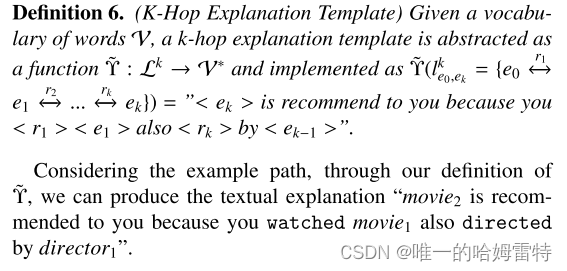

7.k跳模板解释

三、属性设计

所识别的属性考虑了与推理路径有关的三个关键方面,与链接交互的新近度、共享实体的流行度以及解释路径类型的多样性有关。

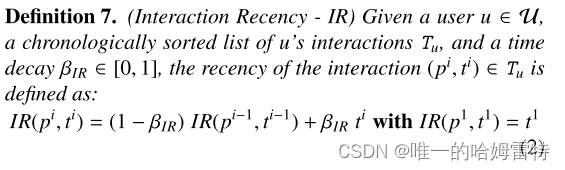

1.链接交互的新近度

将互动时间纳入推荐模型是一种提高推荐质量的做法,并且可能影响用户对最终解释的感知。确实,与最近的互动相关的解释对用户来说会更容易理解,而较旧的互动可能不被用户视为有价值,甚至可能被遗忘。例如,我们可以考虑一个电影平台的用户,过去非常活跃,但最近几年已经不活跃。这个用户重新开始使用平台,进行各种与新电影的互动,并开始接收新的推荐。因此,基于互动新鲜度奖励解释将是有用的。新鲜的互动也更容易理解,而且与与非常旧的互动相关的产品相比,更及时。

互动新近度

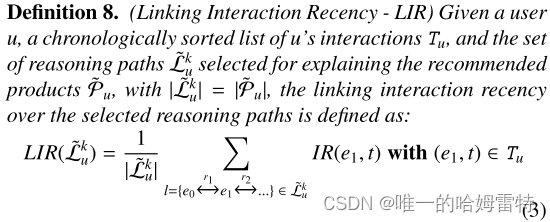

链接互动新近度

所选路径上的链接交互新近度

新近度的局限

如果 LIR 值接近 0 (1),则所选推理路径的链接交互平均是旧的(最近的)。 然而,优化为解释 LIR 的推荐产品而选择的推理路径 L k u 的集合可能会引入可能的副作用。 事实上,所有或大部分选定的推理路径可能都集中在一小部分最近的链接交互上。 非常极端的情况是所有选定的推理路径都包括相同的最新链接交互。 例如,这种效果可能会使所提供的解释与已经体验过的产品的链接重复,并影响感知的解释质量。 由于这个原因,我们决定实施一个额外的相关指标来监控所选推理路径中包含的链接交互的多样性(即有多少不同的交互链接到提供的解释)

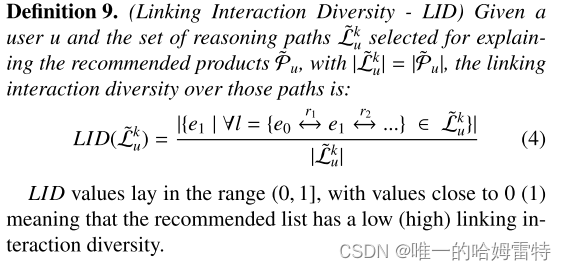

2.链接互动多样性

LID 值位于 (0, 1] 范围内,值接近 0 (1) 意味着推荐列表具有低(高)链接交互多样性。

3.共享实体的受欢迎程度

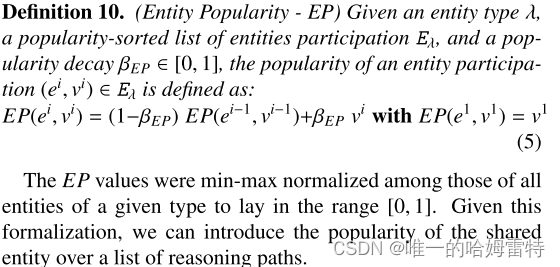

实体流行度

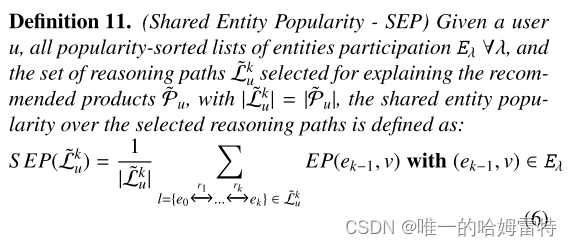

共享实体流行度

SEP 值接近 0 (1) 意味着所包含的共享实体平均具有低(高)受欢迎度

信息茧房

SEP 所选推理路径的优化可能会导致类似于我们讨论的 LIR 类型的副作用。 这意味着所有或大多数选定的推理路径可能都集中在一小部分非常流行的共享实体上(极端情况:所有选定的推理路径都提到了最流行的实体)。 例如,这种现象可能会在解释中提到的共享实体的空间中引入过滤气泡,并对感知的解释质量产生负面影响。 因此,我们引入了另一个指标来监控所选推理路径中包含的共享实体的多样性。

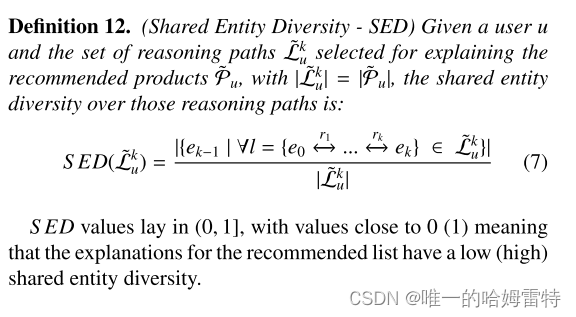

共享实体多样性

4.解释路径类型的多样性

我们引入了一个能够量化推荐列表附带的不同类型路径数量的度量标准。

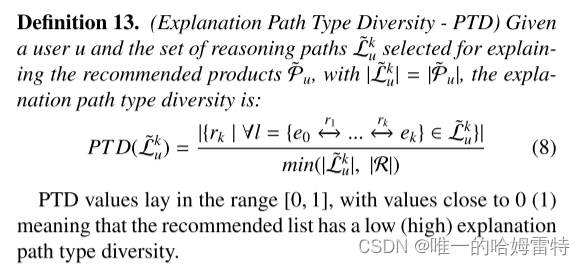

解释路径类型多样性 - PTD

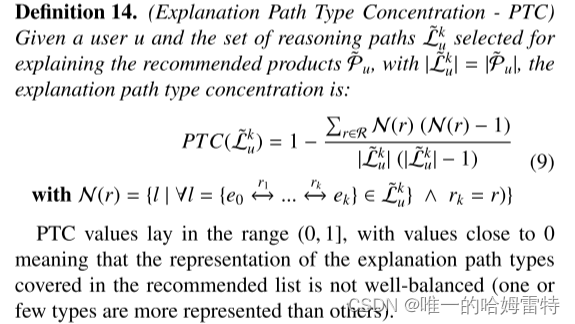

由于 PTD 考虑推荐列表中路径类型的存在而不是它们的表示,因此该指标的优化可能会导致某些路径类型仍然被过度表示的情况(例如,与基于协作的解释相关的路径类型,在 形式“…因为听过您推荐的歌曲的用户也听过您知道的另一首歌曲”),而用户可能更感兴趣和相关的其他歌曲可能只会在推荐中出现一次。 因此,我们决定额外监控所选推理路径上解释路径类型的集中度。 通过这种方式,我们可以评估解释路径类型是否多样化并遵循建议的均衡表示。 这个附加指标是使用逆辛普森指数[24]计算的,测量在推荐列表中选择两种不同类型的解释的概率[9]。

例如,如果在一个推理路径中,大多数解释都是基于相似性的解释,而其他类型的解释很少出现,那么解释路径类型的集中度就很高。相反,如果在一个推理路径中,各种不同类型的解释都被平衡地使用,没有一种类型的解释占据主导地位,那么解释路径类型的集中度就很低。

解释路径类型的集中度可以帮助评估解释的多样性和丰富性。在设计推荐系统或解释模型时,通常希望解释路径类型的集中度较低,以确保用户获得多样化和全面的解释,而不是过于集中在某一类型的解释上。

四、优化

一类(处理中)包括在内部模型学习过程中嵌入推理路径质量属性的方法。 而第二类(后处理)涵盖了重新排列仅针对推荐质量优化的原始推荐模型返回的推荐列表(和解释)的方法。 这两个类别各有优点和缺点。 后处理方法的影响可能有限,因为对一小组建议(和解释)进行重新排序可能比在训练过程中优化它们产生的影响要小。 然而,后处理方法可以应用于任何推荐模型,并且更容易扩展到任何新指标。

1.处理中优化

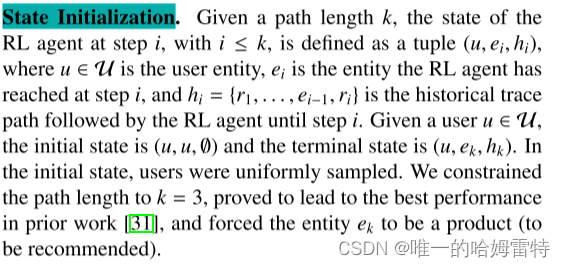

推荐作为MDP过程,采用RL

状态

动作

状态转移

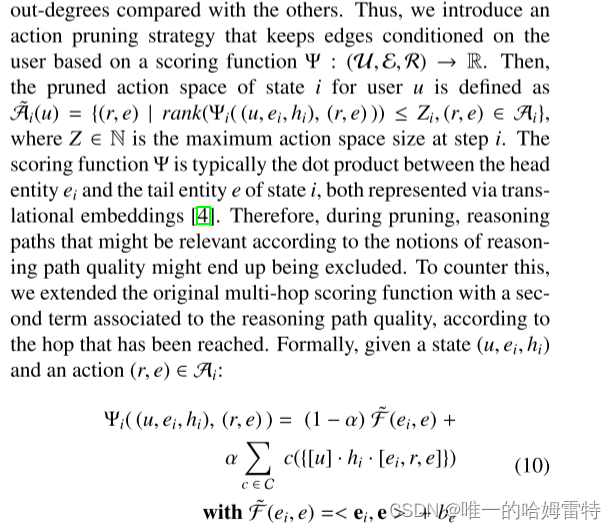

采用动作修剪函数,缩小动作空间

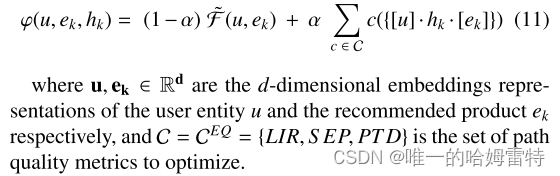

在步骤i=0时,实体e指的是用户u已经体验过的产品。 LIR 将是唯一可以计算的推理路径质量度量 (C = {LIR})。 假设k = 3,第i = 1步的实体e指的是已体验产品和待推荐产品之间共享的实体,也唯一确定路径类型(C = {LIR, S EP, PTD}) 。 由于 PTD 是一组路径的属性,因此当用户 u 在学习过程中尚未看到当前路径的类型时,我们会为该指标给出更高的分数。

奖励函数

最初的累积奖励函数仅代表推荐效用的代理(因此编码推荐质量 - CRQ),并且不考虑推理路径质量的任何概念。 为了解决这个问题,使用与等式相同的符号。 我们计算最终状态 (u, ek, hk) 的奖励函数 为:

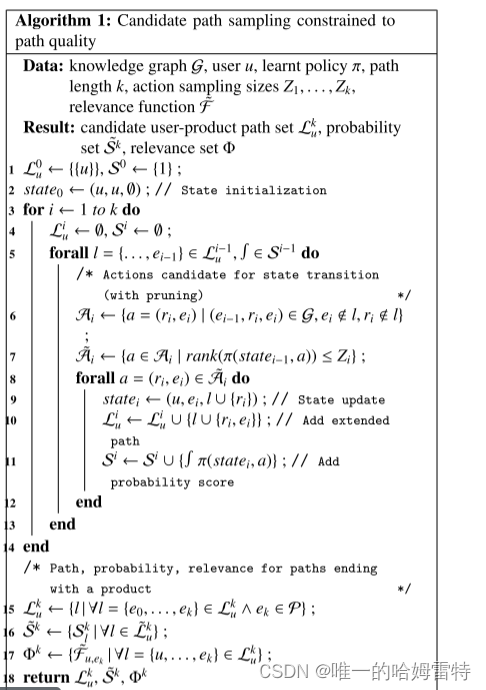

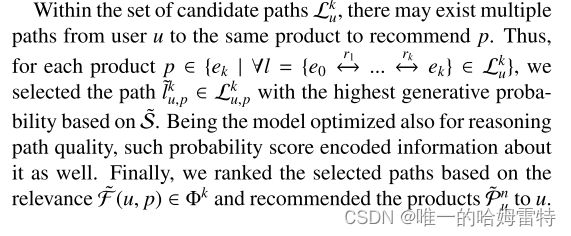

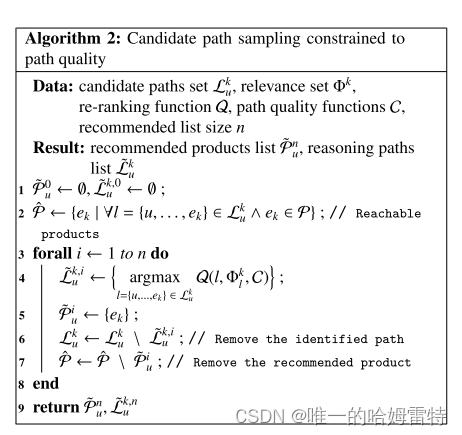

候选路径采样

2.后处理优化

后处理方法对要推荐的产品及其相应的推理路径进行重新排序,以优化某些推理路径质量指标。

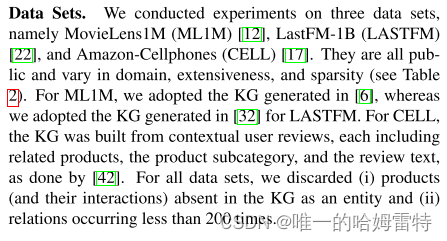

五、实验

986

986

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?