文章目录

- 一、提交任务代码

- 二、Linux提交可能出现的问题及解决方案

- 情况1:JSON解析异常

- 情况2:java.lang.InstantiationException spark.sql.driver

- 情况3 中kafka:java.lang.NoClassDefFoundError: org/apache/kafka/clients/producer/Callback

- 情况4 idea启动报错:Connection to node -1 could not be established. Broker may not be available

- 情况5中kafka: Caused by: java.nio.channels.UnresolvedAddressException master:8080

一、提交任务代码

@Override

public Response submitApplication(String[] args) throws IOException, InterruptedException {

log.info("spark任务传入参数args:{}", args);

args[0] = args[0].replace("}}", "} }").replace("{{", "{ {");

SparkLauncher handle = new SparkLauncher()

.setAppResource(sparkJars) //jar位置,可以是本地可以是hdfs上地址

.setMainClass(sparkMainClass) //运行主函数,项目相对路径,要带包名

.setMaster(sparkMaster) //举例:yarn

.setAppName("Submit Application To Yarn")

.setSparkHome(sparkHome) //linux中地址,举例:/usr/hdp/3.1.0.0-78/spark2

.setDeployMode(sparkDeployMode) //cluster

.setVerbose(true)

.setConf("spark.driver.memory", sparkDriverMemory) //1g

.setConf("spark.executor.memory", sparkExecutorMemory) //1g

.setConf("spark.executor.cores", sparkExecutorCores) //1

.setVerbose(true)

.addAppArgs(args[0]);

handle.startApplication(new SparkAppHandle.Listener() {

//这里监听任务状态,当任务结束时(不管是什么原因结束),isFinal()方法会返回true,否则返回false

@Override

public void stateChanged(SparkAppHandle sparkAppHandle) {

if (sparkAppHandle.getState().isFinal()) {

System.out.println("============stateChanged-getAppId:" + sparkAppHandle.getAppId());

}

System.out.println("getState:" + sparkAppHandle.getState().toString());

}

@Override

public void infoChanged(SparkAppHandle sparkAppHandle) {

System.out.println("============infoChanged-getAppId:" + sparkAppHandle.getAppId());

}

}

});

System.out.println("**********************The task is finished!");

return Response.success();

}

说明:

1)windows下无法运行,必须在linux中进行提交

2)这段代码必须在yarn所在linux服务器上运行,不然标识符.setMaster(“yarn”),不认识

3)这种方式如果在运行中想获得appId,只能在infoChanged中获得或者在stateChanged方法中代表当任务结束后获得,当然推荐使用前者

二、Linux提交可能出现的问题及解决方案

情况1:JSON解析异常

出错原因:spark命令提交参数json,到另一个jar发现{{或者}}消失了,导致解析异常

解决方案:https://blog.csdn.net/u010814849/article/details/78752074 双括号间+空格

情况2:java.lang.InstantiationException spark.sql.driver

出错原因:spark操作mysql数据库缺少驱动

解决方案:

Properties对象设置props.put(“driver”, “com.mysql.jdbc.Driver”);

情况3 中kafka:java.lang.NoClassDefFoundError: org/apache/kafka/clients/producer/Callback

出错原因:运行spark jar(也就是普通maven jar或者java jar,而不是springboot jar)期缺少jar包,问题出在maven程序打包没把依赖打进去

解决方案:添加打包插件指定打入依赖jar

<plugin>

<artifactId>maven-assembly-plugin</artifactId>

<configuration>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

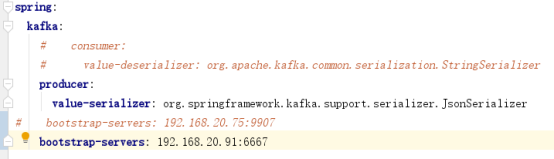

情况4 idea启动报错:Connection to node -1 could not be established. Broker may not be available

出错原因:指定bootstrap-servers前面多了空格,导致层级目录出错,也就是说application.yml文件由于复杂导致多添加 “空格”,造成缩进格式混乱,这点尤其注意

解决方案:

情况5中kafka: Caused by: java.nio.channels.UnresolvedAddressException master:8080

出错原因:ip映射没修改对,导致不认识master,因为我们采用ambari安装的kafka,初始化为:localhost:6667,所以必须把“localhost” -》“IP”

解决方案:如果是ambari安装的kafka修改cinfig下面的,如果是自己linux搭建的,需改动kafka下的cinfig下的server.properties,把PLAINTEXT://localhost:6667 -》 改为PLAINTEXT://192.168.20.91:6667

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?