分享56个Python爬虫源码总有一个是您想要的

学习知识费力气,收集整理更不易。

知识付费甚欢喜,为咱码农谋福利。

源码下载链接:https://pan.baidu.com/s/1YtCYI_6VMF0AAwgnFKOJ-w?pwd=8888

提取码:8888

项目名称:

Python JavaScript 逆向 爬虫

Python 爬虫案例

python 编写,采用广度优先策略,线程池实现的爬虫

Python3爬虫课程代码

python、pysimplegui、GUI、爬虫、可视化、天气查询系统

Python实现基于协程的异步爬虫

import os

import shutil

def void_folder(path):

# 访问path路径下的文件或文件夹

lst = os.listdir(path)

# 打印每一层的文件或文件夹

for name in lst:

# 拼接名称,得到绝对路径,判断该文件是否符合是文件夹

real_path = os.path.join(path, name)

# 如果是文件夹,则打空格表示,并且递归访问下一层

if os.path.isdir(real_path):

# print(name)

files = os.listdir(real_path)

if len(files) == 0:

print("void_folder():"+name)

shutil.rmtree(real_path)

endindex = len(real_path) - len(name)

real_path = real_path[0:endindex]

void_folder(real_path)

else:

void_folder(real_path)

# 如果不是文件夹,直接打印,不再递归访问下一层

else:

#print(name)

pass

def void_file(dirPath):

dirs = os.listdir(dirPath) # 查找该层文件夹下所有的文件及文件夹,返回列表

for file in dirs:

file_full_name = dirPath + '/' + file

file_ext = os.path.splitext(file_full_name)[-1]

if file_ext is None or file_ext=="":

continue

if "rar" == str(file_ext.split(".")[1]):

os.remove(file_full_name)

if "zip" == str(file_ext.split(".")[1]):

os.remove(file_full_name)

if "gz" == str(file_ext.split(".")[1]):

os.remove(file_full_name)

if "tgz" == str(file_ext.split(".")[1]):

os.remove(file_full_name)

# 查找指定文件夹下所有相同名称的文件

def search_file(dirPath, fileName):

dirs = os.listdir(dirPath) # 查找该层文件夹下所有的文件及文件夹,返回列表

for currentFile in dirs: # 遍历列表

absPath = dirPath + '/' + currentFile

if os.path.isdir(absPath): # 如果是目录则递归,继续查找该目录下的文件

search_file(absPath, fileName)

elif currentFile == fileName:

print(absPath) # 文件存在,则打印该文件的绝对路径

os.remove(absPath)

if __name__ == "__main__":

dirPath = 'D:\Spider\Html\DIV+CSS模板\\98个DIV+CSS模板\DIV+CSS模板'

search_file(dirPath, "ReadMe.txt")

search_file(dirPath, "下载网页模板.url")

search_file(dirPath, "下载网页特效.url")

search_file(dirPath, "下载字体.url")

search_file(dirPath, "轻松设计漂亮的网页-mobanwang.com.url")

search_file(dirPath, "松设计漂亮的网页-mobanwang.com.url")

void_file(dirPath)

# search_file(dirPath, "php中文网下载站.url")

# search_file(dirPath, "php中文网免费下载站.txt")

#

# search_file(dirPath, "访问懒人之家.url")

# search_file(dirPath, "lanrenzhijia.com下载说明.txt")

#

#

# search_file(dirPath, "服务器软件.url")

# search_file(dirPath, "downcode.com.txt")

# search_file(dirPath, "中国源码下载站.url")

#

# search_file(dirPath, "脚本之家.url")

# search_file(dirPath, 'jb51.net.txt')

# search_file(dirPath, '说明.htm')

# search_file(dirPath, "cnzzz.com.txt")

# search_file(dirPath, "源码之家说明.txt")

# search_file(dirPath, "服务器常用软件.html")

# search_file(dirPath, "服务器常用软件.html")

# search_file(dirPath, "访问脚本之家.html")

# search_file(dirPath, "chinaz.com.txt")

# search_file(dirPath, "访问查看.url")

# fileName4 = '服务器软件.url'

# fileName3 = '脚本之家.url'

# fileName2 = 'Readme-说明.htm'

# fileName5 = 'jb51.net.txt'

# search_file(dirPath, fileName2)

# search_file(dirPath, fileName3)

# search_file(dirPath, fileName4)

# search_file(dirPath, fileName5)

# void_folder(dirPath)

# void_folder(dirPath)

# void_folder(dirPath)

Python爬虫

Python爬虫, 豆瓣, 逆水寒藏宝阁

python爬虫-旅游景点

python爬虫——抢课原理

Python爬虫基础,爬取王者荣耀、英雄联盟的英雄皮肤

Python爬虫工具库(异步爬虫类、线程池爬虫类、爬虫实用函数)

python爬虫爬取全国高校新闻

Python爬虫爬取公众号所有文章信息,包括标题、url、md链接

python爬虫爬取某度搜索内容

python爬虫练手项目,或许不止爬虫

python爬虫逆向项目合集,每个文件夹都是一个成品项目

Python编写的爬虫合集,欢迎Star(豆瓣,某度翻译,DY,优酷,B站,今日头疼,笔趣阁,Unsplash,起点中文网, 一点资讯,空气质量, 酷酷漫画)

python网络爬虫

python链家网异步IO爬虫,使用aiosync、aiohttp和aiomysql,异步爬取数据和异步存入数据库

spiderTools-master

Weather-master

一个使用Python编写的爬虫,目标是让用户以最简单的方式就可以获得需要的网络数据

一个监控爬虫,用来收集信息生成报表

一些python网络爬虫的项目

一只登录正方教务管理系统,爬取数据的小爬虫

使用celery构建的分布式爬虫

关于behance爬虫项目

利用Fiddler抓包分析毒舌影评社区的APP api接口

利用python爬虫实现某宝爬取网页,源代码来自中国大学慕课嵩天老师的课程,自己做了修改

利用python爬虫抓取了zhihu上所有健身精华帖用户,并将他们的地理信息读取并做数据可视化展示在了某度地图上

利用python爬虫获取同济大学软件学院官网通知

北京理工大学教务系统爬虫选课脚本(纪念那年被别人抢走的课

基于gevent beautifulsoup的链家网 房源信息爬虫

基于Python爬虫+flask框架+echarts的天气展示系统

基于搜狗微信入口的微信爬虫程序

对微信(WeChat)公众号文章内置投票插件的实时数据抓取的Python爬虫

当初为某个站长编写的爬虫,可以用来爬去优酷视频,电影天堂,搜狗等站的资源,采用多线程,可以在配置文件里面给定关键词,数据库配置信息等,自动更新到极光cms中(现在好像找不到了) 所以此代码只给想要学习用python编写爬虫的同学学习

携程机票爬虫 Xiecheng_Airplane_Webspider (Python+Selenium+Chrome)

数据科学与大数据--python入门与爬虫

本仓库记录了我学习Python编程语言的代码记录、爬虫项目等等

条码查询爬虫,提供API

模仿zhihu做的SpringBoot问答社交网站项目,项目技术点SpringBoot+Mybatis+Mysql+redis+solr+velocity+python爬虫进行数据填充,项目亮点有手写异步消息框架、敏感词过滤等

热点新闻,获取各大热门网站热门头条的爬虫程序,使用Python语言编写

爬虫学习笔记

爬虫小工具,能够快速的解析Fiddler里的cookie、data、header信息为python字典模式

用Python写的简单的爬虫,包含某度百科的爬虫和zhihu爬虫

用python写简易爬虫

自己写的python爬虫

记录爬虫学习总结,对拉勾招聘信息、豆瓣电影短评、zhihu用户画像等数据进行网络爬取实战练习,并基于爬取数据利用Python进行数据分析及可视化展示与总结

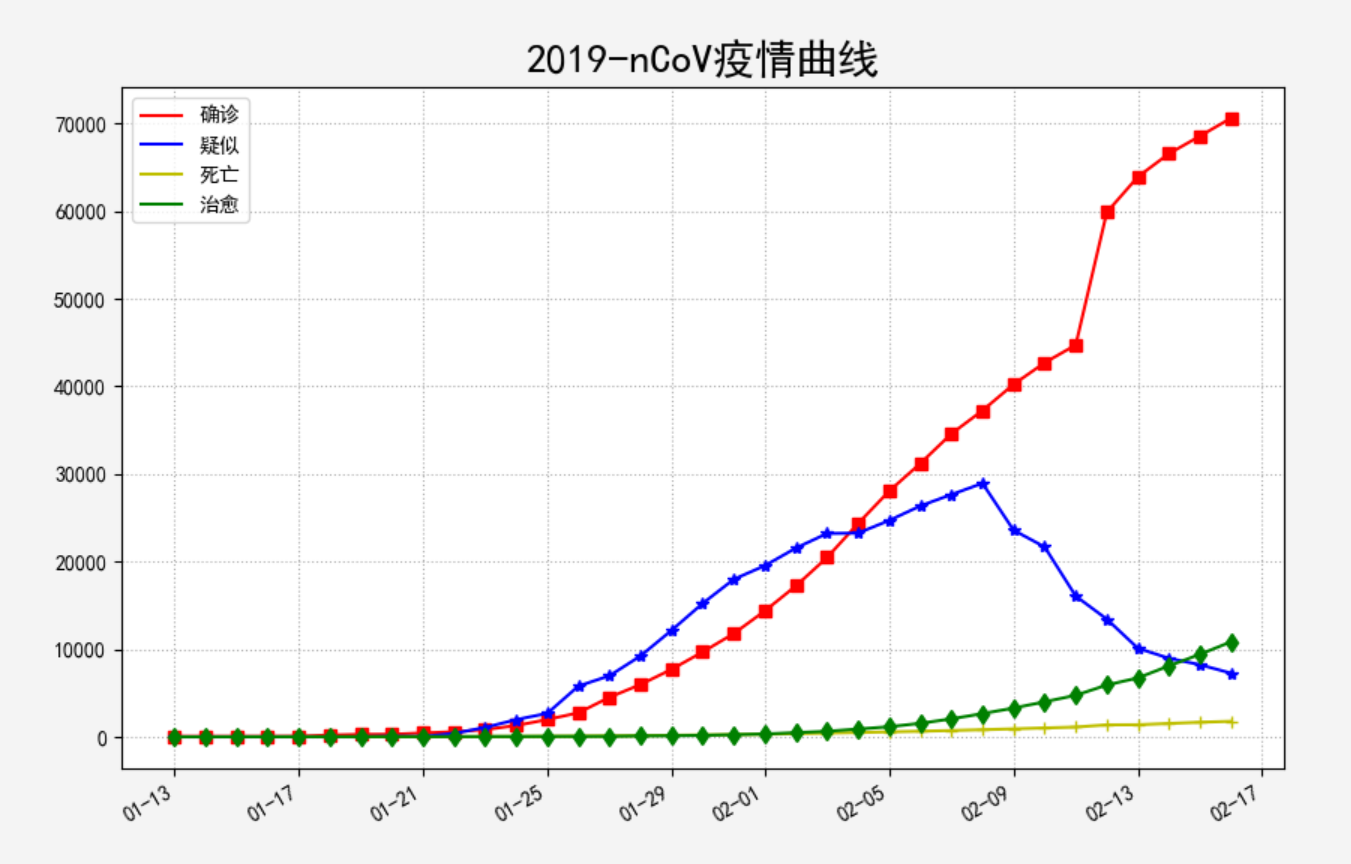

该系列资源是Python疫情大数据分析,涉及网络爬虫、可视化分析、GIS地图、情感分析、舆情分析、主题挖掘、威胁情报溯源、知识图谱、预测预警及AI和NLP应用等

豆瓣爬虫可视化项目

这是一份Python自学的笔记,在没有编程基础的情况下总结如何合理,有逻辑的学习Python

通过python爬虫抓取某度贴吧帖子

针对微博平台的微博文本数据进行舆情分析项目,内容有微博爬虫、LDA主题分析和情感分析

高效的python爬虫组件

Wuhan-data-analysis

该系列资源是Python疫情大数据分析,涉及网络爬虫、可视化分析、GIS地图、情感分析、舆情分析、主题挖掘、威胁情报溯源、知识图谱、预测预警及AI和NLP应用等。推荐大家结合作者CSDN博客阅读,武汉必胜、湖北必胜、中国必胜!

好了就写到这吧

你有时间常去我家看看我在这里谢谢你啦...

我家地址:亚丁号

最后送大家一首诗:

山高路远坑深,大军纵横驰奔,谁敢横刀立马?惟有点赞加关注大军。

感谢您的支持

学习知识费力气,收集整理更不易。

知识付费甚欢喜,为咱码农谋福利。

源码下载链接:https://pan.baidu.com/s/1YtCYI_6VMF0AAwgnFKOJ-w?pwd=8888

提取码:8888

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?