搭建hadoop单机环境(伪分布式)

一、准备工作

1.安装包下载:

链接: https://pan.baidu.com/s/1SIUvMlyaQeLiYddYRQh99g

提取码:c8v6

2.创建一个新的虚拟机

参考: https://blog.csdn.net/and52696686/article/details/107279611

注:本机虚拟机IP地址设为: 192.168.209.129

主机名为:hadoop-single

hostnamectl set-hostname hadoop-single

设置主机列表:vi /etc/hosts

插入ip地址及主机名

192.168.209.129 hadoop-single

如下图所示:

虚拟机创建完成使用MobaXter创建ssh连接虚拟机

二、解压安装jdk及hadoop

1.进入opt目录,创建文件夹software、install,将之前下载的安装包拖拽进文件夹software中,

cd /opt

mkdir software

madir install

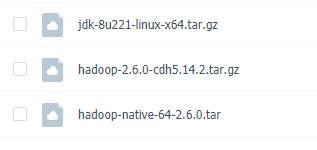

如图:

2.解压安装,将安装包解压至install目录下

cd /software

tar -zxvf jdk-8u221-linux-x64.tar.gz -C /opt/install/

tar -zxvf hadoop-2.6.0-cdh5.14.2.tar.gz -C /opt/install/

3.将解压后的安装包重命名,简短的命名便于之后修改配置文件中的路径

cd /opt/install

mv jdk1.8.0_221/ jdk180

mv hadoop-2.6.0-cdh5.14.2/ hadoop260

三、修改环境及配置文件

1.设置免密登录

①:切换至家目录,生成私钥

cd

ssh-keygen -t rsa -P ""

需连续两次输入enter键

②:复制私钥拷贝到公钥

cat /root/.ssh/id_rsa.pub > /root/.ssh/authorized_keys

③:给公钥授权,可读可写

chmod 600 /root/.ssh/authorized_keys

④:测试登录,自己登录自己,如不需要输入密码直接登录,则设置成功

ssh hadoop-single #第一次切换需要输入yes

exit

ssh hadoop-single #第二次切换不需要

exit

2.配置jdk

①修改系统环境变量

vi /etc/profile

输入 53 ,快速定位到该行,输入 i ,插入以下代码:

#此处路径为jdk安装的根目录

export JAVA_HOME=/opt/install/jdk180

export CLASSPATH=.:$JAVA_HOME/rt.jar:$JAVA_HOME/tools.jar:$JAVA_HOME/dt.jar

export JRE_HOME=$JAVA_HOME/jre

export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

如下图:

按ESC键,输入 冒号 x 保存退出

②:使环境变量生效

soucre /etc/profile

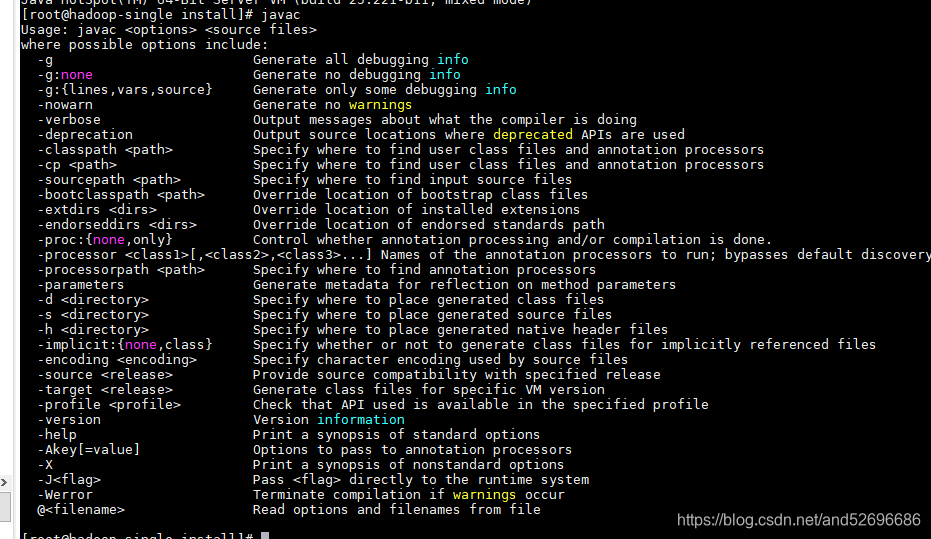

③:测试输入

java -version

javac

显示以下信息说明配置成功

3.配置hadoop

切换至hadoop配置文件的文件夹,修改下图中5个配置文件

cd /opt/install/hadoop260/etc/hadoop

1)修改hadoop-env.sh

vi hadoop-env.sh

修改下图中红框位置的jdk路径

修改为:

2)修改core-site.xml

vi core-site.xml

插入以下代码:

<!-- 设置默认节点ip地址接口 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.206.129:9000</value>

</property>

<!-- 设置用于存放hadoop临时文件的目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/install/hadoop260/tmp</value>

</property>

<!-- 设置允许其他主机root用户可以访问 -->

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<!-- 设置其他组下的root用户可以访问 -->

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

如下图所示:

3)修改hdfs-site.xml

vi hdfs-site.xml

插入以下代码:

<!-- 设置数据块应该被备份的份数(单机设置为1,搭建集群时机器数最少为3,设置备份数为3即可) -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- 设置免权限验证 -->

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

4)修改mapred-site.xml.template

复制 mapred-site.xml.template 重命名为 mapred-site.xml,并进行编辑

cp mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

插入以下代码:

<!-- 设置mapreduce的工作模式:yarn -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 设置mapreduce的工作地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop-single:10020</value>

</property>

<!-- 设置web页面历史服务端口的配置 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop-single:19888</value>

</property>

5)修改yarn-site.xml

vi yarn-site.xml

插入以下代码:

<!-- reducer获取数据方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop-001</value>

</property>

6)配置hadoop环境变量

vi /etc/profile

按 shift+g 定位到末行,输入o 进入编辑模式,插入以下代码:

#此处更改为hadoop的安装根目录

export HADOOP_HOME=/opt/install/hadoop260

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

使环境变量立即生效

source /etc/profile

7)解压安装 hadoop-native-64-2.6.0.tar 包

将 hadoop-native-64-2.6.0.tar 安装包解压安装到hadoop安装目录的lib目录和lib目录下的native目录即可(解压安装两次),不然启动hadoop时会提示错误信息:

WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform… using builtin-java classes where applicable

cd /opt/software

tar -xvf hadoop-native-64-2.6.0.tar -C /opt/install/hadoop260/lib

tar -xvf hadoop-native-64-2.6.0.tar -C /opt/install/hadoop260/lib/native

如下图所示:

8)格式化HDFS

hadoop namenode -format

若显示信息都为INFO级别无报错信息,则格式化执行成功,如下图:

四、启动和关闭

- 启动hdfs和yarn:

start-all.sh - 关闭hdfs和yarn:

stop-all.sh - 启动hdfs:

start-dfs.sh - 关闭hdfs:

stop-dfs.sh - 启动yarn:

start-yarn.sh - 关闭yarn:

stop-yarn.sh - 启动历史服务:

mr-jobhistory-daemon.sh start historyserver - 关闭历史服务:

mr-jobhistory-daemon.sh stop historyserver

注:第一次启动服务需输入yes确认

五、测试

1.启动hdfs、yarn、历史服务

start-all.sh

mr-jobhistory-daemon.sh start historyserver

输入 jps

出现以下7个进程信息说明启动成功

2.网页端口测试

①:.输入:http://192.168.206.129:50070 若能出现如下页面说明hdfs启动成功

②:.输入:http://192.168.206.129:8088 若能出现如下页面说明yarn启动成功

③:.输入:http://192.168.206.129:19888 若能出现如下页面说明历史服务启动成功

1974

1974

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?