一些研究发现,自注意可以通过局部注意增强,即注意范围被限制在重要的局部区域。有利用动态或固定窗口来计算局部注意,也有利用语法约束的。这项工作中提出了一种句法感知的局部注意(SLA)方法。

Approach

首先上模型图:

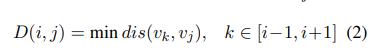

从依赖树解析中导出语法结构,并将其视为无向树。每个token xi映射到树节点vi,节点vi与vj的距离用dis(vi, vj)表示。

然而,依赖关系解析树可能不是非常准确。又,许多注意力头专注于专注于下一个或前一个标记,就用下面公式来表示两节点距离:

这样得到图右边 mask matrix :

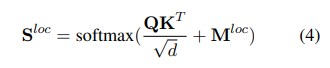

局部注意力计算为:

即,将注意力限制在有句法依赖关系的token间。

即,将注意力限制在有句法依赖关系的token间。

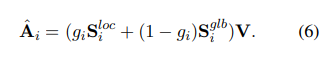

然后,一个门控单元被用来结合全局和局部注意分数:

![]()

S^loc较大意味着更多的注意力集中在句法相关的词上。如果所有门控单元的输出都等于0,则可以获得标准变压器的注意力。

Results

其思想与之前读过的SGNet的类似,实验上也设置了对比实验,相比来说,这篇文章的注意力关注的范围更大,SGNet仅关注有直接父子关系的token。

实验分析也证明在大多数层中,语法感知的局部注意值高于基于窗口的局部注意值。

351

351

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?