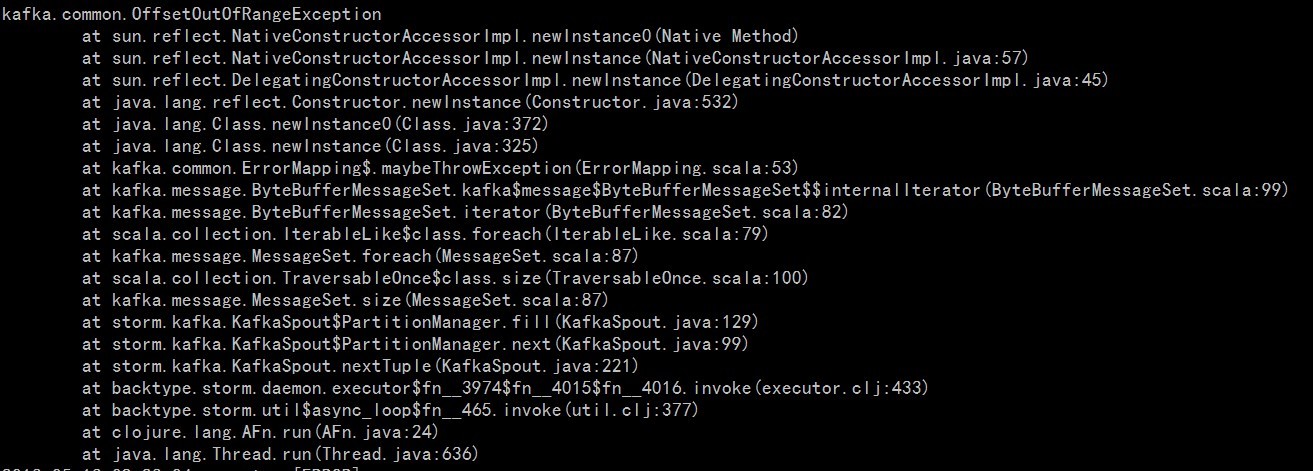

昨天夜里,storm的一个程序出问题了,诚惶诚恐啊。报kafka.common.OffsetOutOfRangeException 异常:

分析一下原因:

是由于 kafka-spout 获取kafka的数据的时候获取不到,kafka 的 offset 超出现存的范围。

深入分析:

由于storm程序启动的时候,读取kafka数据的方式是从头读取(-2),当kafkaspout 的task 发生异常,storm会重新调度,重新起一个kafspout任务运行。新的kafkaspout会从zookeeper中获取最早的offset,而我们的kafka保存数据的时间为一天。这个时候kafkaspout获取的offset仍然是zookeeper中保存的以前初始的offset,这个offset的数据已经不存在了。

后续处理:

首先,将任务重跑,使用的读取模式仍然是从头读取,将任务统计的数据先补上。等到零点,重新运行程序,需要在任务启动的时候使用当前的offset模式(-1)。

深入分析:

由于storm程序启动的时候,读取kafka数据的方式是从头读取(-2),当kafkaspout 的task 发生异常,storm会重新调度,重新起一个kafspout任务运行。新的kafkaspout会从zookeeper中获取最早的offset,而我们的kafka保存数据的时间为一天。这个时候kafkaspout获取的offset仍然是zookeeper中保存的以前初始的offset,这个offset的数据已经不存在了。

后续处理:

首先,将任务重跑,使用的读取模式仍然是从头读取,将任务统计的数据先补上。等到零点,重新运行程序,需要在任务启动的时候使用当前的offset模式(-1)。

1051

1051

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?