Kubernetes 容器编排

前言

知识扩展

早在 2015 年 5 月,Kubernetes 在 Google 上的搜索热度就已经超过了 Mesos 和 Docker Swarm,从那儿之后更是一路飙升,将对手甩开了十几条街,容器编排引擎领域的三足鼎立时代结束。

目前,AWS、Azure、Google、阿里云、腾讯云等主流公有云提供的是基于 Kubernetes 的容器服务;Rancher、CoreOS、IBM、Mirantis、Oracle、Red Hat、VMWare 等无数厂商也在大力研发和推广基于 Kubernetes 的容器 CaaS 或 PaaS 产品。可以说,Kubernetes 是当前容器行业最炙手可热的明星。

Google 的数据中心里运行着超过 20 亿个容器,而且 Google 十年前就开始使用容器技术。最初,Google 开发了一个叫 Borg 的系统(现在命名为 Omega)来调度如此庞大数量的容器和工作负载。在积累了这么多年的经验后,Google 决定重写这个容器管理系统,并将其贡献到开源社区,让全世界都能受益。这个项目就是 Kubernetes。简单的讲,Kubernetes 是 Google Omega 的开源版本。跟很多基础设施领域先有工程实践、后有方法论的发展路线不同,Kubernetes 项目的理论基础则要比工程实践走得靠前得多,这当然要归功于 Google 公司在 2015 年 4 月发布的 Borg 论文了。Borg 系统,一直以来都被誉为 Google 公司内部最强大的"秘密武器"。虽然略显夸张,但这个说法倒不算是吹牛。因为,相比于 Spanner、BigTable 等相对上层的项目,Borg 要承担的责任,是承载 Google 公司整个基础设施的核心依赖。在 Google 公司已经公开发表的基础设施体系论文中,Borg 项目当仁不让地位居整个基础设施技术栈的最底层。

由于这样的定位,Borg 可以说是 Google 最不可能开源的一个项目。而幸运地是,得益于 Docker 项目和容器技术的风靡,它却终于得以以另一种方式与开源社区见面,这个方式就是 Kubernetes 项目。

所以,相比于"小打小闹"的 Docker 公司、"旧瓶装新酒"的 Mesos 社区,Kubernetes 项目从一开始就比较幸运地站上了一个他人难以企及的高度:在它的成长阶段,这个项目每一个核心特性的提出,几乎都脱胎于 Borg/Omega 系统的设计与经验。更重要的是,这些特性在开源社区落地的过程中,又在整个社区的合力之下得到了极大的改进,修复了很多当年遗留在 Borg 体系中的缺陷和问题。

所以,尽管在发布之初被批评是"曲高和寡",但是在逐渐觉察到 Docker 技术栈的"稚嫩"和 Mesos 社区的"老迈"之后,这个社区很快就明白了:k8s 项目在 Borg 体系的指导下,体现出了一种独有的"先进性"与"完备性",而这些特质才是一个基础设施领域开源项目赖以生存的核心价值。

什么是编排

一个正在运行的 Linux 容器,可以分成两部分看待:

1. 容器的静态视图

一组联合挂载在 /var/lib/docker/aufs/mnt 上的 rootfs,这一部分称为"容器镜像"(Container Image)

2. 容器的动态视图

一个由 Namespace+Cgroups 构成的隔离环境,这一部分称为"容器运行时"(Container Runtime)

作为一名开发者,其实并不关心容器运行时的差异。在整个"开发 - 测试 - 发布"的流程中,真正承载着容器信息进行传递的,是容器镜像,而不是容器运行时。这正是容器技术圈在 Docker 项目成功后不久,就迅速走向了"容器编排"这个"上层建筑"的主要原因:作为一家云服务商或者基础设施提供商,我只要能够将用户提交的 Docker 镜像以容器的方式运行起来,就能成为这个非常热闹的容器生态图上的一个承载点,从而将整个容器技术栈上的价值,沉淀在我的这个节点上。

更重要的是,只要从这个承载点向 Docker 镜像制作者和使用者方向回溯,整条路径上的各个服务节点,比如 CI/CD、监控、安全、网络、存储等等,都有可以发挥和盈利的余地。这个逻辑,正是所有云计算提供商如此热衷于容器技术的重要原因:通过容器镜像,它们可以和潜在用户(即,开发者)直接关联起来。

从一个开发者和单一的容器镜像,到无数开发者和庞大的容器集群,容器技术实现了从"容器"到"容器云"的飞跃,标志着它真正得到了市场和生态的认可。这样,容器就从一个开发者手里的小工具,一跃成为了云计算领域的绝对主角;而能够定义容器组织和管理规范的"容器编排"技术,则当仁不让地坐上了容器技术领域的"头把交椅"。

最具代表性的容器编排工具:

1. Docker 公司的 Compose+Swarm 组合

2. Google 与 RedHat 公司共同主导的 Kubernetes 项目

google与k8s

2014 年 6 月,基础设施领域的翘楚 Google 公司突然发力,正式宣告了一个名叫 Kubernetes 项目的诞生。这个项目,不仅挽救了当时的 CoreOS 和 RedHat,还如同当年 Docker 项目的横空出世一样,再一次改变了整个容器市场的格局。这段时间,也正是 Docker 生态创业公司们的春天,大量围绕着 Docker 项目的网络、存储、监控、CI/CD,甚至 UI 项目纷纷出台,也涌现出了很多 Rancher、Tutum 这样在开源与商业上均取得了巨大成功的创业公司。

在 2014~2015 年间,整个容器社区可谓热闹非凡。这令人兴奋的繁荣背后,却浮现出了更多的担忧。这其中最主要的负面情绪,是对 Docker 公司商业化战略的种种顾虑。事实上,很多从业者也都看得明白,Docker 项目此时已经成为 Docker 公司一个商业产品。而开源,只是 Docker 公司吸引开发者群体的一个重要手段。不过这么多年来,开源社区的商业化其实都是类似的思路,无非是高不高调、心不心急的问题罢了。

而真正令大多数人不满意的是,Docker 公司在 Docker 开源项目的发展上,始终保持着绝对的权威和发言权,并在多个场合用实际行动挑战到了其他玩家(比如,CoreOS、RedHat,甚至谷歌和微软)的切身利益。那么,这个时候,大家的不满也就不再是在 GitHub 上发发牢骚这么简单了。

相信很多容器领域的老玩家们都听说过,Docker 项目刚刚兴起时,Google 也开源了一个在内部使用多年、经历过生产环境验证的 Linux 容器:lmctfy(Let Me Container That For You)。然而,面对 Docker 项目的强势崛起,这个对用户没那么友好的 Google 容器项目根本没有招架之力。所以,知难而退的 Google 公司,向 Docker 公司表示了合作的愿望:关停这个项目,和 Docker 公司共同推进一个中立的容器运行时(container runtime)库作为 Docker 项目的核心依赖。不过,Docker 公司并没有认同这个明显会削弱自己地位的提议,还在不久后,自己发布了一个容器运行时库 Libcontainer。这次匆忙的、由一家主导的、并带有战略性考量的重构,成了 Libcontainer 被社区长期诟病代码可读性差、可维护性不强的一个重要原因。

至此,Docker 公司在容器运行时层面上的强硬态度,以及 Docker 项目在高速迭代中表现出来的不稳定和频繁变更的问题,开始让社区叫苦不迭。这种情绪在 2015 年达到了一个高潮,容器领域的其他几位玩家开始商议"切割"Docker 项目的话语权。而"切割"的手段也非常经典,那就是成立一个中立的基金会。于是,2015 年 6 月 22 日,由 Docker 公司牵头,CoreOS、Google、RedHat 等公司共同宣布,Docker 公司将 Libcontainer 捐出,并改名为 RunC 项目,交由一个完全中立的基金会管理,然后以 RunC 为依据,大家共同制定一套容器和镜像的标准和规范。这套标准和规范,就是 OCI( Open Container Initiative )。OCI 的提出,意在将容器运行时和镜像的实现从 Docker 项目中完全剥离出来。这样做,一方面可以改善 Docker 公司在容器技术上一家独大的现状,另一方面也为其他玩家不依赖于 Docker 项目构建各自的平台层能力提供了可能。

不过,OCI 的成立更多的是这些容器玩家出于自身利益进行干涉的一个妥协结果。尽管 Docker 是 OCI 的发起者和创始成员,它却很少在 OCI 的技术推进和标准制定等事务上扮演关键角色,也没有动力去积极地推进这些所谓的标准。这也是迄今为止 OCI 组织效率持续低下的根本原因。OCI 并没能改变 Docker 公司在容器领域一家独大的现状,Google 和 RedHat 等公司于是把第二把武器摆上了台面。

Docker 之所以不担心 OCI 的威胁,原因就在于它的 Docker 项目是容器生态的事实标准,而它所维护的 Docker 社区也足够庞大。可是,一旦这场斗争被转移到容器之上的平台层,或者说 PaaS 层,Docker 公司的竞争优势便立刻捉襟见肘了。在这个领域里,像 Google 和 RedHat 这样的成熟公司,都拥有着深厚的技术积累;而像 CoreOS 这样的创业公司,也拥有像 Etcd 这样被广泛使用的开源基础设施项目。可是 Docker 公司却只有一个 Swarm。

所以这次,Google、RedHat 等开源基础设施领域玩家们,共同牵头发起了一个名为 CNCF(Cloud Native Computing Foundation)的基金会。这个基金会的目的其实很容易理解:它希望,以 Kubernetes 项目为基础,建立一个由开源基础设施领域厂商主导的、按照独立基金会方式运营的平台级社区,来对抗以 Docker 公司为核心的容器商业生态。

为了打造出一个围绕 Kubernetes 项目的"护城河",CNCF 社区就需要至少确保两件事情:Kubernetes 项目必须能够在容器编排领域取得足够大的竞争优势;CNCF 社区必须以 Kubernetes 项目为核心,覆盖足够多的场景。CNCF 社区如何解决 Kubernetes 项目在编排领域的竞争力的问题:

在容器编排领域,Kubernetes 项目需要面对来自 Docker 公司和 Mesos 社区两个方向的压力。Swarm 和 Mesos 实际上分别从两个不同的方向讲出了自己最擅长的故事:Swarm 擅长的是跟 Docker 生态的无缝集成,而 Mesos 擅长的则是大规模集群的调度与管理。

这两个方向,也是大多数人做容器集群管理项目时最容易想到的两个出发点。也正因为如此,Kubernetes 项目如果继续在这两个方向上做文章恐怕就不太明智了。

Kubernetes 选择的应对方式是:Borg

k8s 项目大多来自于 Borg 和 Omega 系统的内部特性,这些特性落到 k8s 项目上,就是 Pod、Sidecar 等功能和设计模式。

这就解释了,为什么 Kubernetes 发布后,很多人"抱怨"其设计思想过于"超前"的原因:Kubernetes 项目的基础特性,并不是几个工程师突然"拍脑袋"想出来的东西,而是 Google 公司在容器化基础设施领域多年来实践经验的沉淀与升华。这正是 Kubernetes 项目能够从一开始就避免同 Swarm 和 Mesos 社区同质化的重要手段。

CNCF 接下来的任务是如何把这些先进的思想通过技术手段在开源社区落地,并培育出一个认同这些理念的生态?

RedHat 发挥了重要作用。当时,Kubernetes 团队规模很小,能够投入的工程能力十分紧张,这恰恰是 RedHat 的长处。RedHat 更是世界上为数不多、能真正理解开源社区运作和项目研发真谛的合作伙伴。RedHat 与 Google 联盟的成立,不仅保证了 RedHat 在 Kubernetes 项目上的影响力,也正式开启了容器编排领域"三国鼎立"的局面。

Mesos 社区与容器技术的关系,更像是"借势",而不是这个领域真正的参与者和领导者。这个事实,加上它所属的 Apache 社区固有的封闭性,导致了 Mesos 社区虽然技术最为成熟,却在容器编排领域鲜有创新。

一开始,Docker 公司就把应对 Kubernetes 项目的竞争摆在首要位置: 一方面,不断强调"Docker Native"的"重要性"一方面,与 k8s 项目在多个场合进行了直接的碰撞。这次竞争的发展态势,很快就超过了 Docker 公司的预期。 Kubernetes 项目并没有跟 Swarm 项目展开同质化的竞争所以 "Docker Native"的说辞并没有太大的杀伤力相反 k8s 项目让人耳目一新的设计理念和号召力,很快就构建出了一个与众不同的容器编排与管理的生态。

Kubernetes 项目在 GitHub 上的各项指标开始一骑绝尘,将 Swarm 项目远远地甩在了身后。

CNCF 社区如何解决第二个问题:

在已经囊括了容器监控事实标准的 Prometheus 项目后,CNCF 社区迅速在成员项目中添加了 Fluentd、OpenTracing、CNI 等一系列容器生态的知名工具和项目。而在看到了 CNCF 社区对用户表现出来的巨大吸引力之后,大量的公司和创业团队也开始专门针对 CNCF 社区而非 Docker 公司制定推广策略。

2016 年,Docker 公司宣布了一个震惊所有人的计划:放弃现有的 Swarm 项目,将容器编排和集群管理功能全部内置到 Docker 项目当中。Docker 公司意识到了 Swarm 项目目前唯一的竞争优势,就是跟 Docker 项目的无缝集成。那么,如何让这种优势最大化呢?那就是把 Swarm 内置到 Docker 项目当中。从工程角度来看,这种做法的风险很大。内置容器编排、集群管理和负载均衡能力,固然可以使得 Docker 项目的边界直接扩大到一个完整的 PaaS 项目的范畴,但这种变更带来的技术复杂度和维护难度,长远来看对 Docker 项目是不利的。不过,在当时的大环境下,Docker 公司的选择恐怕也带有一丝孤注一掷的意味。

k8s 的应对策略:

是反其道而行之,开始在整个社区推进"民主化"架构,即:从 API 到容器运行时的每一层,Kubernetes 项目都为开发者暴露出了可以扩展的插件机制,鼓励用户通过代码的方式介入到 Kubernetes 项目的每一个阶段。

Kubernetes 项目的这个变革的效果立竿见影,很快在整个容器社区中催生出了大量的、基于 Kubernetes API 和扩展接口的二次创新工作,比如:

目前热度极高的微服务治理项目 Istio;被广泛采用的有状态应用部署框架 Operator;还有像 Rook 这样的开源创业项目,它通过 Kubernetes 的可扩展接口,把 Ceph 这样的重量级产品封装成了简单易用的容器存储插件。

在鼓励二次创新的整体氛围当中,k8s 社区在 2016 年后得到了空前的发展。更重要的是,不同于之前局限于"打包、发布"这样的 PaaS 化路线,这一次容器社区的繁荣,是一次完全以 Kubernetes 项目为核心的"百花争鸣"。面对 Kubernetes 社区的崛起和壮大,Docker 公司也不得不面对自己豪赌失败的现实。但在早前拒绝了微软的天价收购之后,Docker 公司实际上已经没有什么回旋余地,只能选择逐步放弃开源社区而专注于自己的商业化转型。

所以,从 2017 年开始,Docker 公司先是将 Docker 项目的容器运行时部分 Containerd 捐赠给 CNCF 社区,标志着 Docker 项目已经全面升级成为一个 PaaS 平台;紧接着,Docker 公司宣布将 Docker 项目改名为 Moby,然后交给社区自行维护,而 Docker 公司的商业产品将占有 Docker 这个注册商标。

Docker 公司这些举措背后的含义非常明确:它将全面放弃在开源社区同 Kubernetes 生态的竞争,转而专注于自己的商业业务,并且通过将 Docker 项目改名为 Moby 的举动,将原本属于 Docker 社区的用户转化成了自己的客户。2017 年 10 月,Docker 公司出人意料地宣布,将在自己的主打产品 Docker 企业版中内置 Kubernetes 项目,这标志着持续了近两年之久的"编排之争"至此落下帷幕。

2018 年 1 月 30 日,RedHat 宣布斥资 2.5 亿美元收购 CoreOS。

2018 年 3 月 28 日,这一切纷争的始作俑者,Docker 公司的 CTO Solomon Hykes 宣布辞职,曾经纷纷扰扰的容器技术圈子,到此尘埃落定。

容器技术圈子在短短几年里发生了很多变数,但很多事情其实也都在情理之中。就像 Docker 这样一家创业公司,在通过开源社区的运作取得了巨大的成功之后,就不得不面对来自整个云计算产业的竞争和围剿。而这个产业的垄断特性,对于 Docker 这样的技术型创业公司其实天生就不友好。在这种局势下,接受微软的天价收购,在大多数人看来都是一个非常明智和实际的选择。可是 Solomon Hykes 却多少带有一些理想主义的影子,既然不甘于"寄人篱下",那他就必须带领 Docker 公司去对抗来自整个云计算产业的压力。

只不过,Docker 公司最后选择的对抗方式,是将开源项目与商业产品紧密绑定,打造了一个极端封闭的技术生态。而这,其实违背了 Docker 项目与开发者保持亲密关系的初衷。相比之下,Kubernetes 社区,正是以一种更加温和的方式,承接了 Docker 项目的未尽事业,即:以开发者为核心,构建一个相对民主和开放的容器生态。这也是为何,Kubernetes 项目的成功其实是必然的。

很难想象如果 Docker 公司最初选择了跟 Kubernetes 社区合作,如今的容器生态又将会是怎样的一番景象。不过我们可以肯定的是,Docker 公司在过去五年里的风云变幻,以及 Solomon Hykes 本人的传奇经历,都已经在云计算的长河中留下了浓墨重彩的一笔。

总结:

容器技术的兴起源于 PaaS 技术的普及;

Docker 公司发布的 Docker 项目具有里程碑式的意义;

Docker 项目通过"容器镜像",解决了应用打包这个根本性难题。

容器本身没有价值,有价值的是"容器编排"。也正因为如此,容器技术生态才爆发了一场关于"容器编排"的"战争"。而这次战争,最终以 Kubernetes 项目和 CNCF 社区的胜利而告终。

容器编排之战

一. kubernetes简要概述

Kubernetes 是用于自动部署, 扩展和管理容器化应用程序的开源系统. 它将组成应用程序的容器组合成逻辑单元, 以便于管理和服务发现. Kubernetes 源自Google 15 年生产环境的运维经验, 同时凝聚了社区的最佳创意和实践

在容器化应用的大趋势下, 越来越多的单体应用被划分成了无数个微小的服务, 从之前的裸机部署单体服务到现今使用容器承载服务运行; 容器越来越贴近研发、运维、测试等IT职能部门, 越来越多的人也渐渐转向了云进行开发, 而不再单独强调单体一致性问题; 这一切的功臣就是 — 容器;

其实容器这个产物, 早在Linux内核诞生后就已经有了它, 那时候程序员创建一个容器需要编写代码, 调用Linux内核中的Cgroup 和 NameSpace用作资源限制, 而创建出来的容器所观看到的底层文件系统却是和宿主机是同一套文件系统, 导致在容器中操作文件就相当于更改了宿主机的文件系统, 这就大大暴露了容器的应用性差的特性; 后来横空出世的docker解决了这个问题, docker创造了一个叫做镜像的东西, 并将其进行分层, 使得用户在启动容器的时候将镜像拷贝一份读写层挂载到容器中, 让容器看到的底层文件系统只是镜像中的内容从而避免了上述的问题, 镜像带来的好处远不止这一个, 比如在生产、测试、研发三个环境中总是因为环境不统一造成上线后的应用很快崩溃的局面, 而有了镜像就不需要考虑环境的问题, 因为所有的服务运行在容器中, 而提供给容器运行的底层文件系统是镜像, 只要使用的是同一个镜像那么不管在什么环境中, 都是一样的效果, 这对于运维、测试、研发三类人而言就能彻底的和应用运行环境要考虑的事情甩手拜拜了; 而docker这个引擎又提供了很多易于使用的控制容器的指令, 大大降低了程序员操作的难度, 又提供相应的镜像和存储镜像的公共仓库, 使得容器技术飞速发展起来;

就在容器飞速发展的第五年里, Google发布了容器编排系统 kubernetes, 它解决了容器在多个宿主机间调度的问题, 同时提供可靠的API接口来控制容器的运行, 并时刻保持容器启动的状态, 融合了故障自愈、服务发现等新功能; 从而占领了容器市场的高地; 从此容器圈内又向容器编排发起了猛烈的攻势;

1.1 kubernetes 功能简介

- 服务发现和负载均衡

Kubernetes 可以使用 DNS 名称或自己的 IP 地址公开容器, 如果进入容器的流量很大, Kubernetes 可以负载均衡并分配网络流量, 从而使部署稳定. 常用的DNS插件为coreDNS, 用作服务发现和集群中容器通讯; 负载均衡器常使用集群内的service资源进行对外暴露服务, 同时也提供ingress插件接口对外暴露服务 - 存储编排

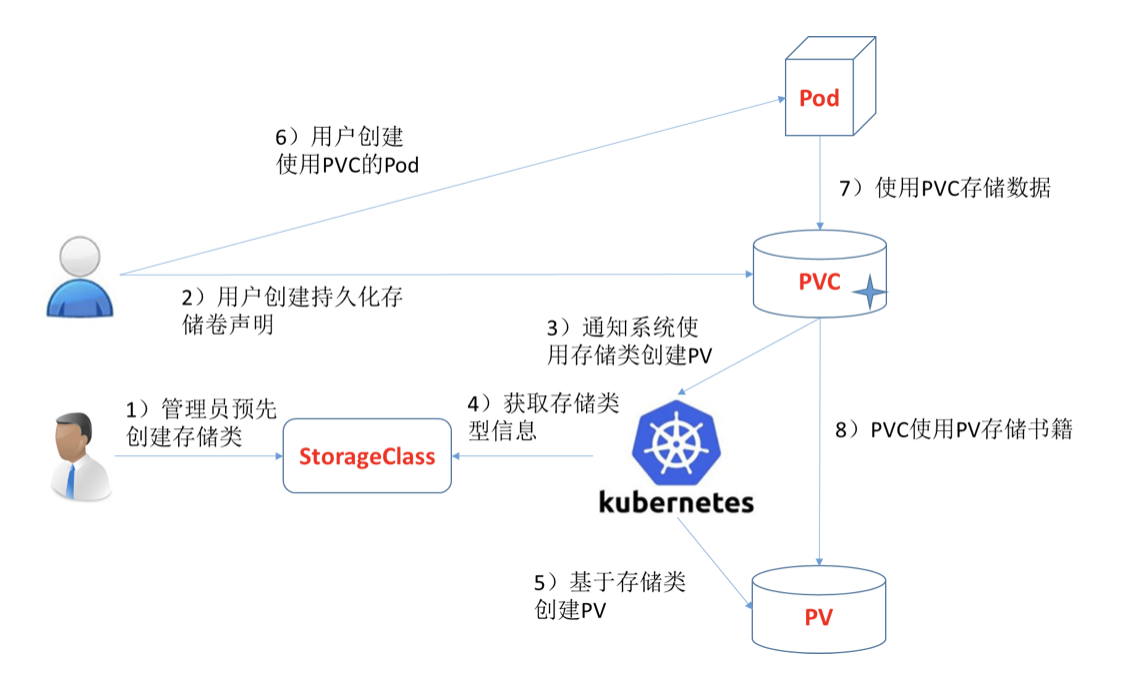

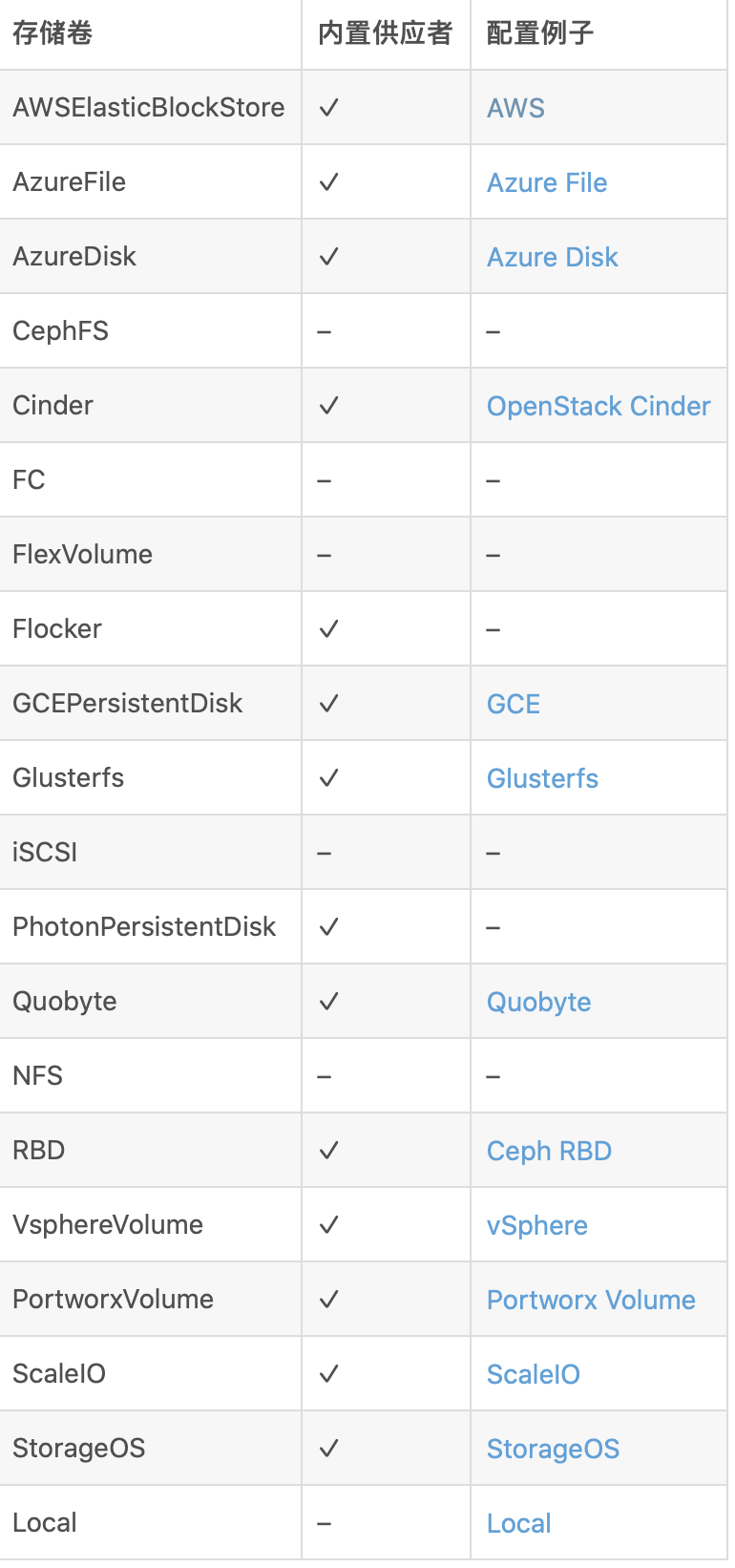

Kubernetes 允许你自动挂载你选择的存储系统, 例如本地存储、公共云提供商等. 对于集群内部的应用有时会需要持久化数据, 这时容器如果被删除数据也会随之消失, 所以一个稳定的外部存储集群就显得很重要了; 常见的对k8s提供存储能力的集群有: heketi + gluesterfs 、Rook + Ceph、阿里云OSS等, 配合集群内的storageclass可直接向存储集群申请存储空间 - 自动部署和回滚

你可以使用 Kubernetes 描述已部署容器的所需状态, 它可以以受控的速率将实际状态 更改为期望状态. 例如, 你可以自动化 Kubernetes 来为你的部署创建新容器, 删除现有容器并将它们的所有资源用于新容器. 控制k8s集群中容器的状态大多数时候都会采用 yaml 资源配置清单的形式, 方便记忆也易于识别 - 自动完成装箱计算

Kubernetes 允许你指定每个容器所需 CPU 和内存(RAM). 当容器指定了资源请求时, Kubernetes 可以做出更好的决策来管理容器的资源. 这就与Linux操作系统中的资源限额有关系了, 有些容器在接收高并发访问的时候, 往往会无限制的占用宿主机资源, 从而导致其他服务容器争抢不到应有的资源进行运行和服务, 从而导致大面积瘫痪 - 自我修复

Kubernetes 重新启动失败的容器、替换容器、杀死不响应用户定义的 运行状况检查的容器, 并且在准备好服务之前不将其通告给客户端. 在创建pod的时候, 只有当设置在pod中的探针全部探测正常后才会将pod连接到集群内网络中对外进行服务, 否则将通过监控告警给运维人员; 同样的对于k8s中的容器会受到kubelet和kube-apiserver的双重管理, kubelet上报容器运行状态, api-server向etcd中请求期望状态, 比较后让其达到期望的状态, 从而保证其功能/服务容器永久保持在线 - 密钥与配置管理

Kubernetes 允许你存储和管理敏感信息, 例如密码、OAuth 令牌和 ssh 密钥. 你可以在不重建容器镜像的情况下部署和更新密钥和应用程序配置, 也无需在堆栈配置中暴露密钥. 对于无状态应用(exam: nginx)的配置文件, 可以使用k8s中的configmap资源进行存储, 但对于密码和某些私密信息而言就可以使用secret资源进行存储, 从而避免频繁更改和私密信息泄漏的风险

1.2 Kubernetes架构及组件

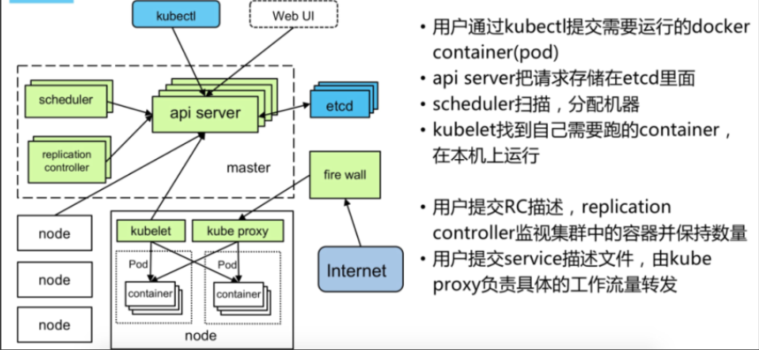

一个 Kubernetes 集群由一组被称作节点的机器组成。这些节点上运行 Kubernetes 所管理的容器化应用。集群具有至少一个工作节点。工作节点托管作为应用负载的组件的 Pod 。控制平面管理集群中的工作节点和 Pod 。 为集群提供故障转移和高可用性,这些控制平面一般跨多主机运行,集群跨多个节点运行。

- kube-apiserver

API 服务器是 Kubernetes 控制面的组件, 该组件公开了 Kubernetes API。 API 服务器是 Kubernetes 控制面的前端。Kubernetes API 服务器的主要实现是 kube-apiserver。 kube-apiserver 设计上考虑了水平伸缩,也就是说,它可通过部署多个实例进行伸缩。 你可以运行 kube-apiserver 的多个实例,并在这些实例之间平衡流量。 - etcd

etcd 是兼具一致性和高可用性的键值数据库,可以作为保存 Kubernetes 所有集群数据的后台数据库。你的 Kubernetes 集群的 etcd 数据库通常需要有个备份计划。要了解 etcd 更深层次的信息,请参考 etcd 文档。 - kube-scheduler

控制平面组件,负责监视新创建的、未指定运行节点(node)的 Pods,选择节点让 Pod 在上面运行。调度决策考虑的因素包括单个 Pod 和 Pod 集合的资源需求、硬件/软件/策略约束、亲和性和反亲和性规范、数据位置、工作负载间的干扰和最后时限。

/etc/kubernetes/manifests/kube-scheduler.yaml 中添加参数

- –node-monitor-grace-period=10s:该参数指定了 Node 节点的监控宽限期(Grace Period),即在节点变为不可用之前的时间间隔。在这段时间内,调度器不会将 Pod 从该节点上驱逐,以便给应用程序一些时间来完成正在进行的任务并正常关闭。在这个例子中,宽限期为 10 秒。

- –node-monitor-period=3s:该参数指定了 Node 节点的监控周期,即调度器检查节点状态的时间间隔。在这个例子中,监控周期为 3 秒。

- –node-startup-grace-period=20s:该参数指定了新节点加入集群后的启动宽限期(Grace Period),即在节点完全准备好之前的时间间隔。在这段时间内,调度器不会将 Pod 调度到该节点上,以便给节点一些时间来初始化和准备运行 Pod。在这个例子中,启动宽限期为 20 秒。

- –pod-eviction-timeout=10s:该参数指定了 Pod 的驱逐超时时间,即在调度器决定驱逐一个 Pod 之后,等待该 Pod 关闭的时间间隔。如果 Pod 在这段时间内没有正常关闭,调度器将强制终止该 Pod。在这个例子中,驱逐超时时间为 10 秒。

- kube-controller-manager

运行控制器进程的控制平面组件。从逻辑上讲,每个控制器都是一个单独的进程, 但是为了降低复杂性,它们都被编译到同一个可执行文件,并在一个进程中运行。这些控制器包括:- 节点控制器(Node Controller):负责在节点出现故障时进行通知和响应

- 任务控制器(Job controller):监测代表一次性任务的 Job 对象,然后创建 Pods 来运行这些任务直至完成

- 端点控制器(Endpoints Controller):填充端点(Endpoints)对象(即加入 Service 与 Pod)

- 服务帐户和令牌控制器(Service Account & Token Controllers):为新的命名空间创建默认帐户和 API 访问令牌

- cloud-controller-manager

云控制器管理器是指嵌入特定云的控制逻辑的 控制平面组件。 云控制器管理器使得你可以将你的集群连接到云提供商的 API 之上, 并将与该云平台交互的组件同与你的集群交互的组件分离开来。cloud-controller-manager仅运行特定于云平台的控制回路。 如果你在自己的环境中运行 Kubernetes,或者在本地计算机中运行学习环境, 所部署的环境中不需要云控制器管理器。与kube-controller-manager类似,cloud-controller-manager将若干逻辑上独立的 控制回路组合到同一个可执行文件中,供你以同一进程的方式运行。 你可以对其执行水平扩容(运行不止一个副本)以提升性能或者增强容错能力。下面的控制器都包含对云平台驱动的依赖:- 节点控制器(Node Controller):用于在节点终止响应后检查云提供商以确定节点是否已被删除

- 路由控制器(Route Controller):用于在底层云基础架构中设置路由

- 服务控制器(Service Controller):用于创建、更新和删除云提供商负载均衡器

- Node 组件: 节点组件在每个节点上运行,维护运行的 Pod 并提供 Kubernetes 运行环境。

- kubelet

一个在集群中每个节点(node)上运行的代理。 它保证容器(containers)都 运行在 Pod 中。kubelet 接收一组通过各类机制提供给它的 PodSpecs,确保这些 PodSpecs 中描述的容器处于运行状态且健康。 kubelet 不会管理不是由 Kubernetes 创建的容器。 - kube-proxy

kube-proxy 是集群中每个节点上运行的网络代理, 实现 Kubernetes 服务(Service) 概念的一部分。kube-proxy 维护节点上的网络规则。这些网络规则允许从集群内部或外部的网络会话与 Pod 进行网络通信。如果操作系统提供了数据包过滤层并可用的话,kube-proxy 会通过它来实现网络规则。否则, kube-proxy 仅转发流量本身。 - 容器运行时(Container Runtime)

容器运行环境是负责运行容器的软件。Kubernetes 支持容器运行时,例如 Docker、 containerd、CRI-O 以及 Kubernetes CRI (容器运行环境接口) 的其他任何实现。 - 插件(Addons)

插件使用 Kubernetes 资源实现集群功能。 因为这些插件提供集群级别的功能,插件中命名空间域的资源属于kube-system命名空间。下面描述众多插件中的几种。有关可用插件的完整列表,请参见 插件(Addons)。- DNS

尽管其他插件都并非严格意义上的必需组件,但几乎所有 Kubernetes 集群都应该 有集群 DNS, 因为很多示例都需要 DNS 服务。集群 DNS 是一个 DNS 服务器,和环境中的其他 DNS 服务器一起工作,它为 Kubernetes 服务提供 DNS 记录。Kubernetes 启动的容器自动将此 DNS 服务器包含在其 DNS 搜索列表中。 - Web 界面(仪表盘)

Dashboard 是 Kubernetes 集群的通用的、基于 Web 的用户界面。 它使用户可以管理集群中运行的应用程序以及集群本身并进行故障排除。 - 容器资源监控

容器资源监控 将关于容器的一些常见的时间序列度量值保存到一个集中的数据库中,并提供用于浏览这些数据的界面。 - 集群层面日志

集群层面日志 机制负责将容器的日志数据 保存到一个集中的日志存储中,该存储能够提供搜索和浏览接口 ELK/Loki+grafana

- DNS

1.3 Kubernetes核心概念

Master

Master节点主要负责资源调度(Scheduler),控制副本(Replication Controller),和提供统一访问集群的入口(API Server)。---核心节点也是管理节点

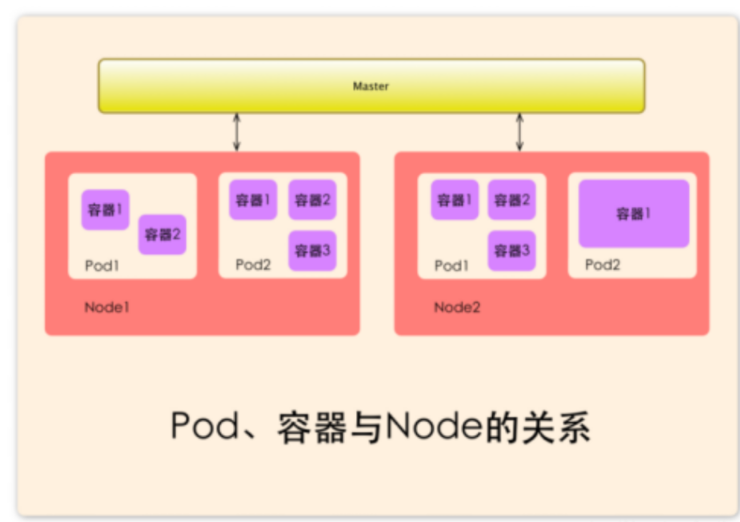

Node

Node是Kubernetes集群架构中运行Pod的服务节点(亦叫agent或minion)。Node是Kubernetes集群操作的单元,用来承载被分配Pod的运行,是Pod运行的宿主机,由Master管理,并汇报容器状态给Master,当Node节点宕机(NotReady状态)时,该节点上运行的Pod会被自动地转移到其他节点上。

Kubelet组件---Kubelet会从API Server接收Pod的创建请求,启动和停止容器,监控容器运行状态并汇报给Kubernetes API Server。

KuberProxy组件--实现将客户端请求流量转发到内部的pod资源。

Docker Engine(docker)组件,Docker引擎,负责本机的容器创建和管理工作;

Node IP

Node节点的IP地址,是Kubernetes集群中每个节点的物理网卡的IP地址,是真是存在的物理网络,所有属于这个网络的服务器之间都能通过这个网络直接通信;

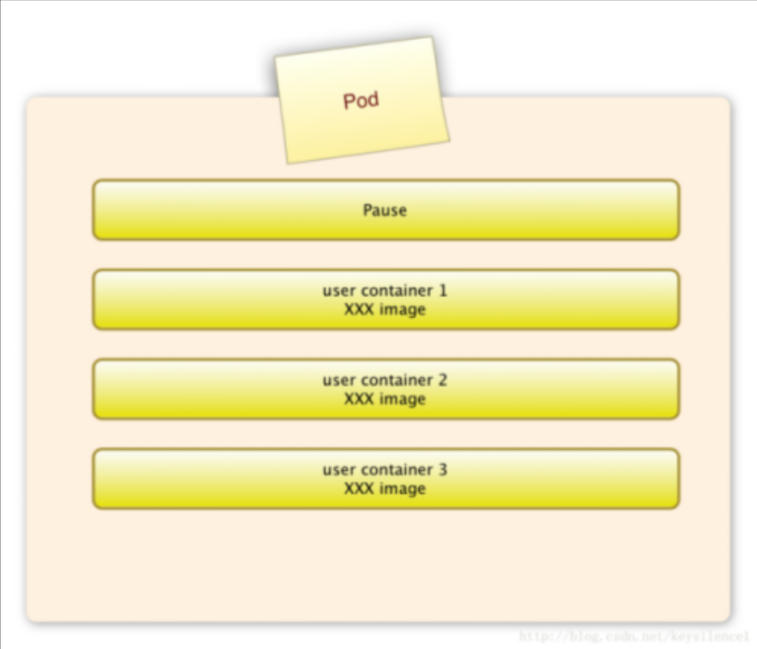

Pod

Pod直译是豆荚,可以把容器想像成豆荚里的豆子,把一个或多个关系紧密的豆子包在一起就是豆荚(一个Pod)。处于同一个Pod中的容器共享同样的存储空间(Volume,卷或存储卷)、网络命名空间IP地址和Port端口。在k8s中我们不会直接操作容器,而是把容器包装成Pod再进行管理

运行于Node节点上,Pod是k8s进行创建、调度和管理的最小单位.一个Pod可以包含一个容器或者多个相关容器。

Pod 就是 k8s 世界里的"应用";而一个应用,可以由多个容器组成。

pause容器

每个Pod中都有一个pause容器,pause容器做为Pod的网络接入点,Pod中其他的容器会使用容器映射模式启动并接入到这个pause容器。

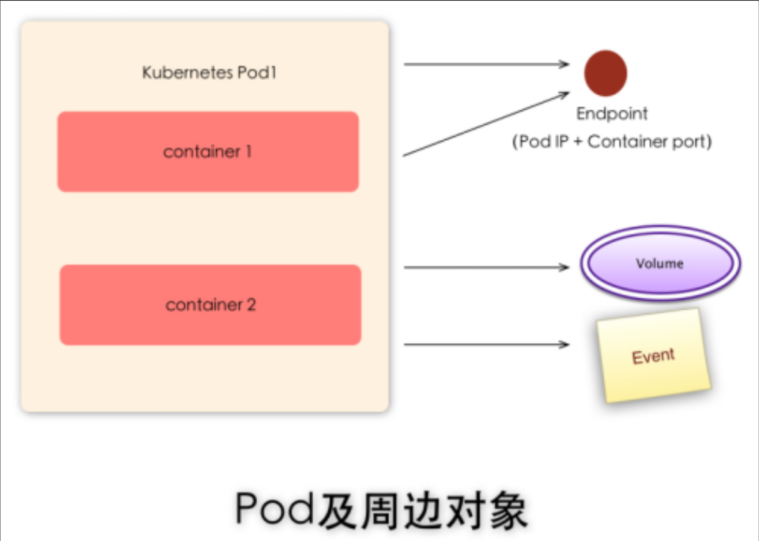

Pod IP

Pod的IP地址,是Docker Engine根据docker0网桥的IP地址段进行分配的,通常是一个虚拟的二层网络,位于不同Node上的Pod能够彼此通信,需要通过Pod IP所在的虚拟二层网络进行通信,而真实的TCP流量则是通过Node IP所在的物理网卡流出的

资源限制:

每个Pod可以设置限额的计算机资源有CPU和Memory;

Pod Volume:

Docker Volume对应Kubernetes中的Pod Volume;数间共享数据。

Event

是一个事件记录,记录了事件最早产生的时间、最后重复时间、重复次数、发起者、类型,以及导致此事件的原因等信息。Event通常关联到具体资源对象上,是排查故障的重要参考信息

Endpoint(pod IP+容器Port)

标识服务进程的访问点;

ReplicaSet

确保任何指定的Pod副本数量,并提供声明式更新等功能。

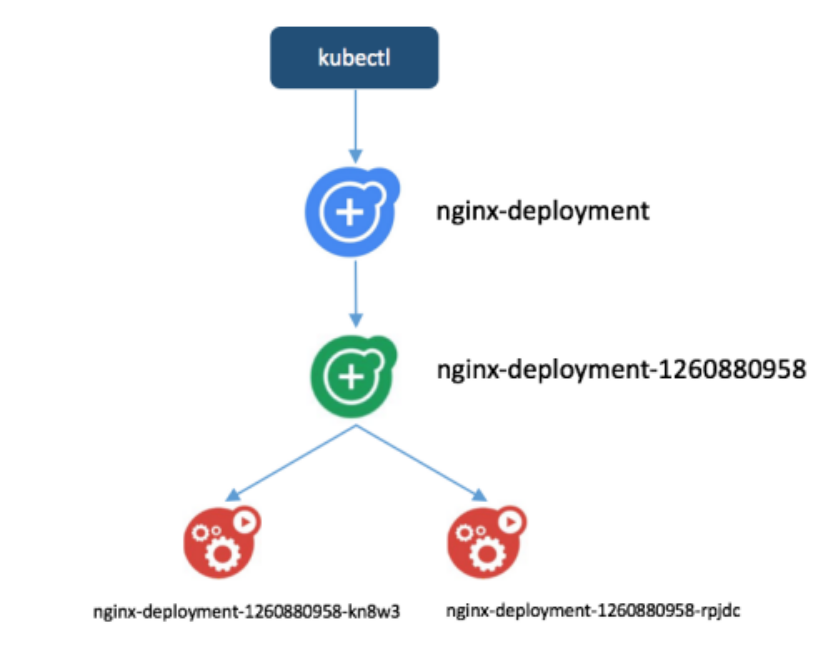

Deployment

Deployment是一个更高层次的API对象,它管理ReplicaSets和Pod,并提供声明式更新等功能。

官方建议使用Deployment管理ReplicaSets,而不是直接使用ReplicaSets,这就意味着可能永远不需要直接操作ReplicaSet对象,因此Deployment将会是使用最频繁的资源对象。

RC-Replication Controller

Replication Controller用来管理Pod的副本,保证集群中存在指定数量的Pod副本。集群中副本的数量大于指定数量,则会停止指定数量之外的多余pod数量,反之,则会启动少于指定数量个数的容器,保证数量不变。Replication Controller是实现弹性伸缩、动态扩容和滚动升级的核心。

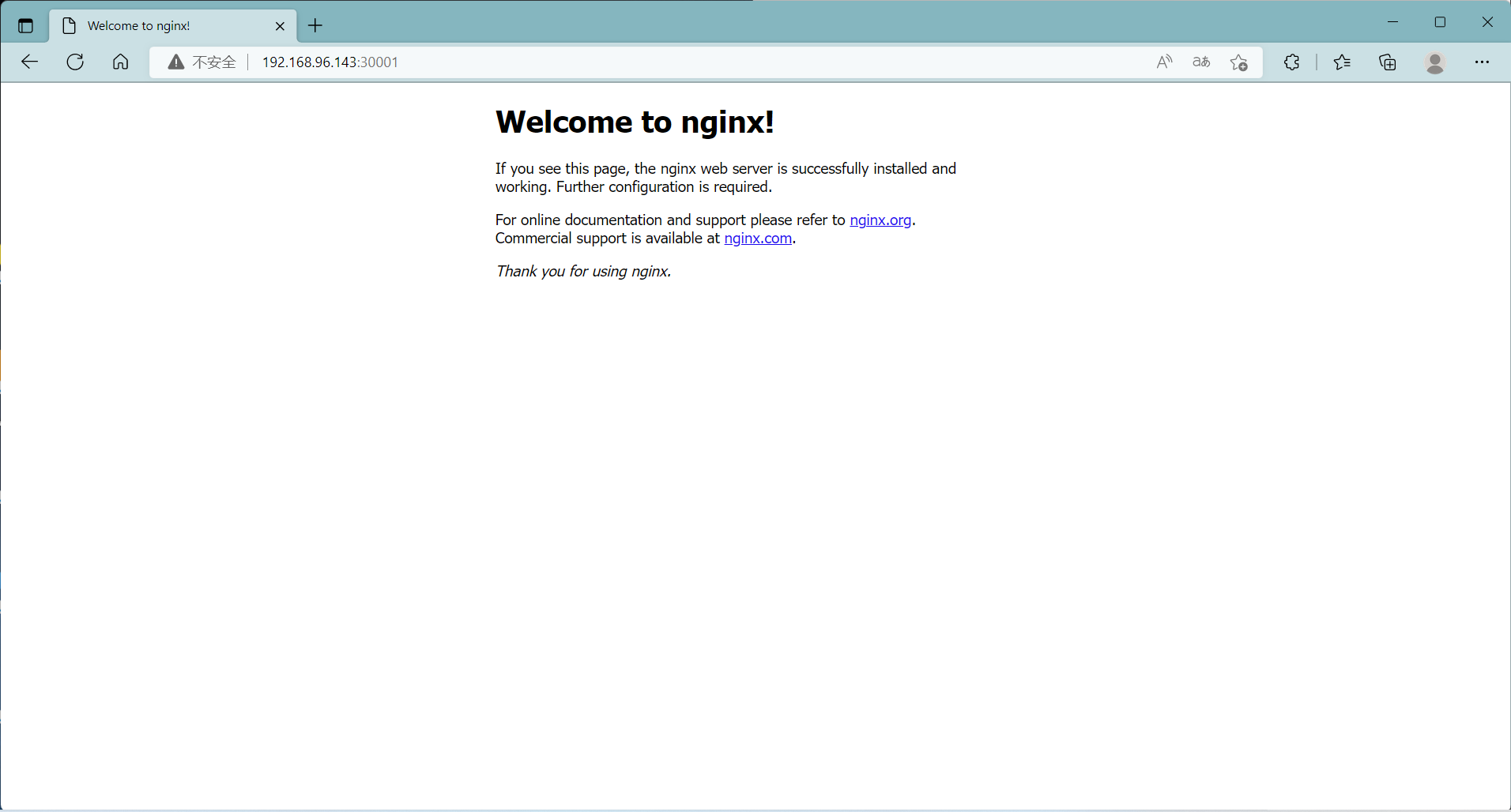

Service

Service定义了Pod的逻辑集合和访问该集合的策略,是真实服务的抽象。它有暴露内部服务的端口到外网的能力。Service提供了一个统一的服务访问入口以及服务代理和发现机制,用户不需要了解后台Pod是如何运行。

一个service定义了访问pod的方式,就像单个固定的IP地址和与其相对应的DNS名之间的关系。

service分为两种ip地址:

一种是对内的叫Cluster IP ,一种是对外的叫external ip:

实现对外ip方式分为:

1.NodePort:通过每个 Node 上的 IP 和内部服务暴露出来的静态端口实现暴露服务。

2.LoadBalancer:使用云提供商的负载均衡器.

3.ingress:使用负载均衡软件实现负载均衡,向外部暴露服务。

Cluster IP

Service的IP地址,特性:

专门给集群内部资源访问的。在k8s集群里面部署的容器,用内部的容器可以访问这个ip地址。但是集群外面的机器不能访问。

1.无法被Ping通;

2.Node IP、Pod IP、Cluster IP之间的通信,采用的是Kubernetes自己设计的一种编程方式的特殊的路由规则,与IP路由有很大的不同

Label—标签与Selectors—选择器

Kubernetes中的任意API对象都是通过Label进行标识,Label的实质是一系列的K/V键值对。Label是Replication Controller和Service运行的基础,二者通过Label来进行关联Node上运行的Pod。

比如,你可能创建了一个"tier"和“app”标签,通过Label(tier=frontend, app=myapp)来标记前端Pod容器,使用 Label(tier=backend, app=myapp)标记后台Pod。然后可以使用 Selectors 选择带有特定Label的Pod,并且将 Service 或者 Replication Controller 应用到上面。

一个label是一个被附加到资源上的键/值对,譬如附加到一个Pod上,为它传递一个用户自定的并且可识别的属性。

注:Node、Pod、Replication Controller和Service等都可以看作是一种"资源对象",几乎所有的资源对象都可以通过Kubernetes提供的kubectl工具执行增、删、改、查等操作并将其保存在etcd中持久化存储。

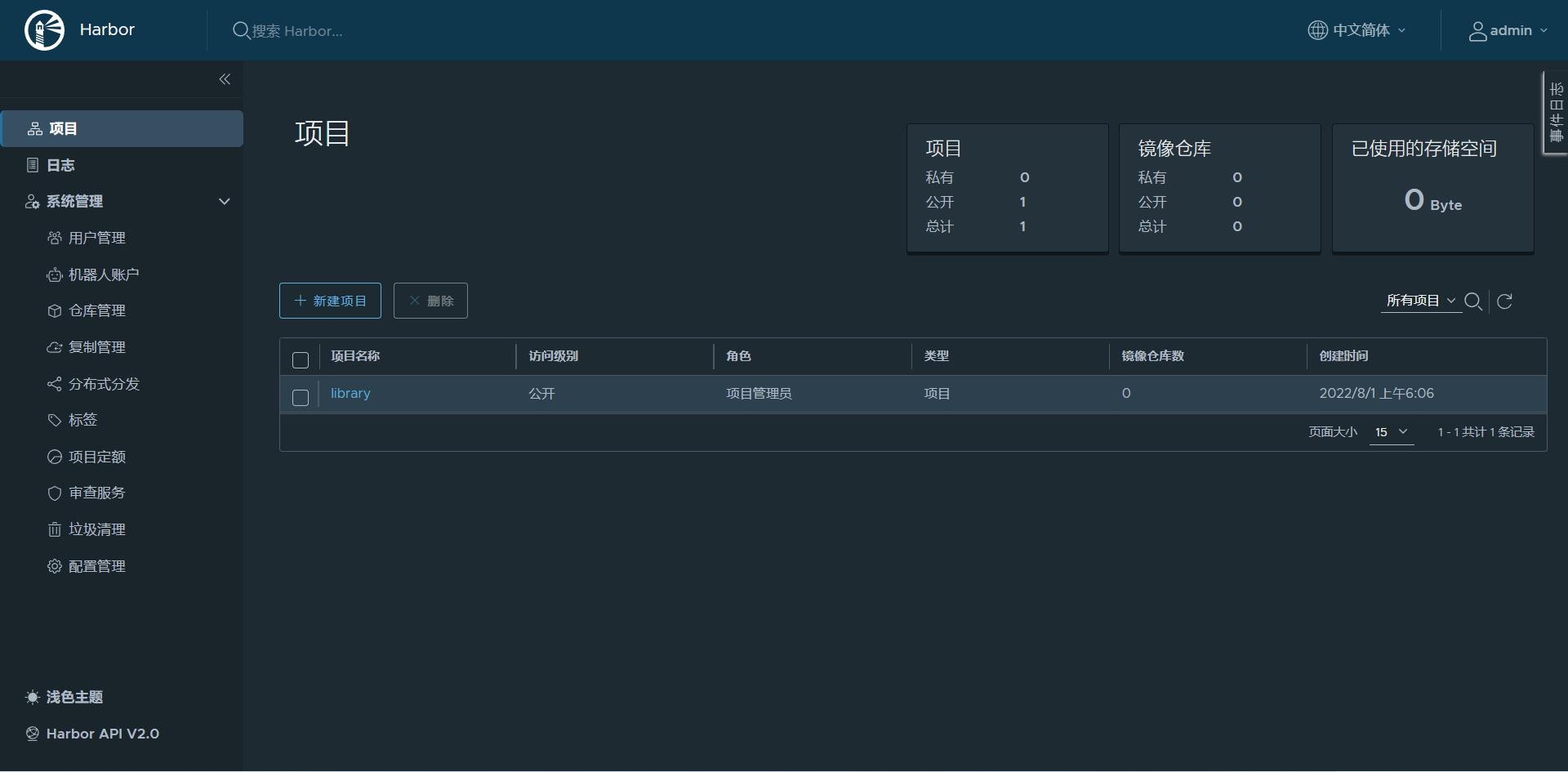

二. 常用镜像库

- 官方 Docker Hub 仓库:

- 官方 Kubernetes 镜像通常存放在 Docker Hub 上。地址通常是 k8s.gcr.io/<镜像名>:<标签>,但实际上你需要通过 Docker Hub 访问这些镜像,例如 docker pull k8s.gcr.io/<镜像名>:<标签>。

- 阿里云容器镜像服务(Aliyun Docker Registry):

- 阿里云的 Kubernetes 镜像仓库地址格式一般为 registry.cn-hangzhou.aliyuncs.com/google_containers/<镜像名>:<标签>。

- 例如,对于 kube-apiserver 镜像,地址可能是 registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:<标签>。

- 腾讯云容器镜像服务(Tencent Cloud Container Registry):

- 腾讯云的 Kubernetes 镜像仓库地址格式可能类似于 ccr.ccs.tencentyun.com/tke-market/<镜像名>:<标签>。

- 华为云容器镜像服务(Huawei Cloud Container Registry):

- 华为云的 Kubernetes 镜像仓库地址格式可能类似于 swr.cn-north-4.myhuaweicloud.com/<镜像名>:<标签>。

三.集群部署方式

- 方式1. minikube

Minikube是一个工具,可以在本地快速运行一个单点的Kubernetes,尝试Kubernetes或日常开发的用户使用。不能用于生产环境。

官方地址:https://kubernetes.io/docs/setup/minikube/

- 方式2. kubeadm

Kubeadm也是一个工具,提供kubeadm init和kubeadm join,用于快速部署Kubernetes集群。

官方地址:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

- 方式3. 直接使用epel-release yum源,缺点就是版本较低 1.5

- 方式4. 二进制包

四.Kubeadm 方式部署集群

kubeadm部署官方文档

kubeadm部署k8s高可用集群的官方文档

主节点CPU核数必须是 ≥2核且内存要求必须≥2G,否则k8s无法启动

| 主机名 | 地址 | 角色 | 配置 |

|---|---|---|---|

| kub-k8s-master1 | 192.168.75.100 | 主节点 | 2核2G 50G |

| kub-k8s-master2 | 192.168.75.101 | 主节点 | 2核2G 50G |

| kub-k8s-master3 | 192.168.75.102 | 主节点 | 2核2G 50G |

| kub-k8s-node1 | 192.168.75.103 | 工作节点 | 1核2G 50G |

| kub-k8s-node2 | 192.168.75.104 | 工作节点/haproxy | 1核2G 50G |

4.1 安装docker[集群]

过程请查看docker安装部分

# 一键安装docker脚本

curl -L https://gitea.beyourself.org.cn/newrain001/shell-project/raw/branch/master/os/get-docker-latest.sh | sh

4.2 获取镜像[集群]

获取镜像版本方法

kubeadm config images list --kubernetes-version=<版本号>

谷歌镜像[由于国内网络原因,无法下载,后续将采用阿里云镜像代替]

# 官方,不采用

docker pull k8s.gcr.io/kube-apiserver:v1.22.0

docker pull k8s.gcr.io/kube-proxy:v1.22.0

docker pull k8s.gcr.io/kube-controller-manager:v1.22.0

docker pull k8s.gcr.io/kube-scheduler:v1.22.0

docker pull k8s.gcr.io/etcd:3.5.0-0

docker pull k8s.gcr.io/pause:3.5

docker pull k8s.gcr.io/coredns/coredns:v1.8.4

4.3 阿里仓库下载[集群]

在线下载

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.22.0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.22.0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.22.0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.22.0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:v1.8.4

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.5.0-0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.5

# 下载完了之后需要将aliyun下载下来的所有镜像打成k8s.gcr.io/kube-controller-manager:v1.22.0这样的tag

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.22.0 k8s.gcr.io/kube-controller-manager:v1.22.0

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.22.0 k8s.gcr.io/kube-proxy:v1.22.0

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.22.0 k8s.gcr.io/kube-apiserver:v1.22.0

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.22.0 k8s.gcr.io/kube-scheduler:v1.22.0

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:v1.8.4 k8s.gcr.io/coredns/coredns:v1.8.4

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.5.0-0 k8s.gcr.io/etcd:3.5.0-0

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.5 k8s.gcr.io/pause:3.5

# 可以清理掉aliyun的镜像标签

docker rmi -f `docker images --format {{.Repository}}:{{.Tag}} | grep aliyun`

离线安装[适用于当前网络环境不佳的情况]

[root@localhost ~]# ls

anaconda-ks.cfg application.tar.xz kube-1.22.0.tar.xz

[root@localhost ~]# tar xvf application.tar.xz

[root@localhost ~]# tar xvf kube-1.22.0.tar.xz

[root@localhost ~]# cd application/images && ls *.tar | xargs -i docker load -i {} && cd ../.. && cd kube-1.22.0/images && ls *.tar | xargs -i docker load -i {} && cd ../.. && docker images | wc -l

4.4 集群部署[集群]

cat >> /etc/hosts <<EOF

192.168.75.100 kub-k8s-master1

192.168.75.101 kub-k8s-master2

192.168.75.102 kub-k8s-master3

192.168.75.103 kub-k8s-node1

192.168.75.104 kub-k8s-node2

EOF

制作本地解析,修改主机名。相互解析

4.5 集群环境配置[集群]

1.关闭防火墙:

# systemctl disable firewalld --now

2.禁用SELinux:

# setenforce 0

3.编辑文件/etc/selinux/config,将SELINUX修改为disabled,如下:

# sed -i 's/SELINUX=enforcing/SELINUX=disabled/' /etc/sysconfig/selinux

SELINUX=disabled

4.时间同步

# timedatectl set-timezone Asia/Shanghai

# yum install -y ntpsec

# ntpdate time.windows.com

# hwclock --systohc

5.配置静态ip

4.6 关闭系统Swap[集群]

Kubernetes 1.8开始要求关闭系统的Swap,如果不关闭,默认配置下kubelet将无法启动。

- 方法一: 通过kubelet的启动参数–fail-swap-on=false更改这个限制。

- 方法二: 关闭系统的Swap。

1.关闭swap分区

# swapoff -a

修改/etc/fstab文件,注释掉SWAP的自动挂载,使用free -m确认swap已经关闭。

2.注释掉swap分区:

# sed -i 's/.*swap.*/#&/' /etc/fstab

# free -m

total used free shared buff/cache available

Mem: 3935 144 3415 8 375 3518

Swap: 0 0 0

4.7 安装Kubeadm包[集群]

配置官方源[需翻墙]

# cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://packages.cloud.google.com/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=0

EOF

配置阿里云源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

所有节点:

1.安装依赖包及常用软件包

# yum install -y conntrack ntpdate ntp ipvsadm ipset jq iptables curl sysstat libseccomp wget vim net-tools git iproute lrzsz bash-completion tree bridge-utils unzip bind-utils gcc

2.安装对应版本

# yum install -y kubelet-1.22.0-0.x86_64 kubeadm-1.22.0-0.x86_64 kubectl-1.22.0-0.x86_64

3.加载ipvs相关内核模块

# cat <<EOF > /etc/modules-load.d/ipvs.conf

ip_vs

ip_vs_lc

ip_vs_wlc

ip_vs_rr

ip_vs_wrr

ip_vs_lblc

ip_vs_lblcr

ip_vs_dh

ip_vs_sh

ip_vs_nq

ip_vs_sed

ip_vs_ftp

ip_vs_sh

nf_conntrack_ipv4

ip_tables

ip_set

xt_set

ipt_set

ipt_rpfilter

ipt_REJECT

ipip

EOF

4.配置:

配置转发相关参数,否则可能会出错

# cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-iptables=1

net.bridge.bridge-nf-call-ip6tables=1

net.ipv4.ip_forward=1

net.ipv4.tcp_tw_recycle=0

vm.swappiness=0

vm.overcommit_memory=1

vm.panic_on_oom=0

fs.inotify.max_user_instances=8192

fs.inotify.max_user_watches=1048576

fs.file-max=52706963

fs.nr_open=52706963

net.ipv6.conf.all.disable_ipv6=1

net.netfilter.nf_conntrack_max=2310720

EOF

5.使配置生效

# sysctl --system

6.如果net.bridge.bridge-nf-call-iptables报错,加载br_netfilter模块

# modprobe br_netfilter

# modprobe ip_conntrack

# sysctl -p /etc/sysctl.d/k8s.conf

7.查看是否加载成功

# lsmod | grep ip_vs

4.8 配置启动kubelet[集群]

1.配置kubelet使用pause镜像

获取docker的cgroups

配置变量:

[root@k8s-master ~]# DOCKER_CGROUPS=`docker info |grep 'Cgroup' | awk ' NR==1 {print $3}'`

[root@k8s-master ~]# echo $DOCKER_CGROUPS

cgroupfs

2.配置kubelet的cgroups

# cat >/etc/sysconfig/kubelet<<EOF

KUBELET_EXTRA_ARGS="--cgroup-driver=$DOCKER_CGROUPS --pod-infra-container-image=k8s.gcr.io/pause:3.5"

EOF

启动

# systemctl daemon-reload

# systemctl enable kubelet && systemctl restart kubelet

在这里使用 # systemctl status kubelet,你会发现报错误信息;

10月 11 00:26:43 node1 systemd[1]: kubelet.service: main process exited, code=exited, status=255/n/a

10月 11 00:26:43 node1 systemd[1]: Unit kubelet.service entered failed state.

10月 11 00:26:43 node1 systemd[1]: kubelet.service failed.

运行 # journalctl -xefu kubelet 命令查看systemd日志才发现,真正的错误是:

unable to load client CA file /etc/kubernetes/pki/ca.crt: open /etc/kubernetes/pki/ca.crt: no such file or directory

#这个错误在运行kubeadm init 生成CA证书后会被自动解决,此处可先忽略。

#简单地说就是在kubeadm init 之前kubelet会不断重启。

4.9 配置master节点[master]

! 4.9.1 和 4.9.2 所有master都执行,4.9.3 只有master1执行

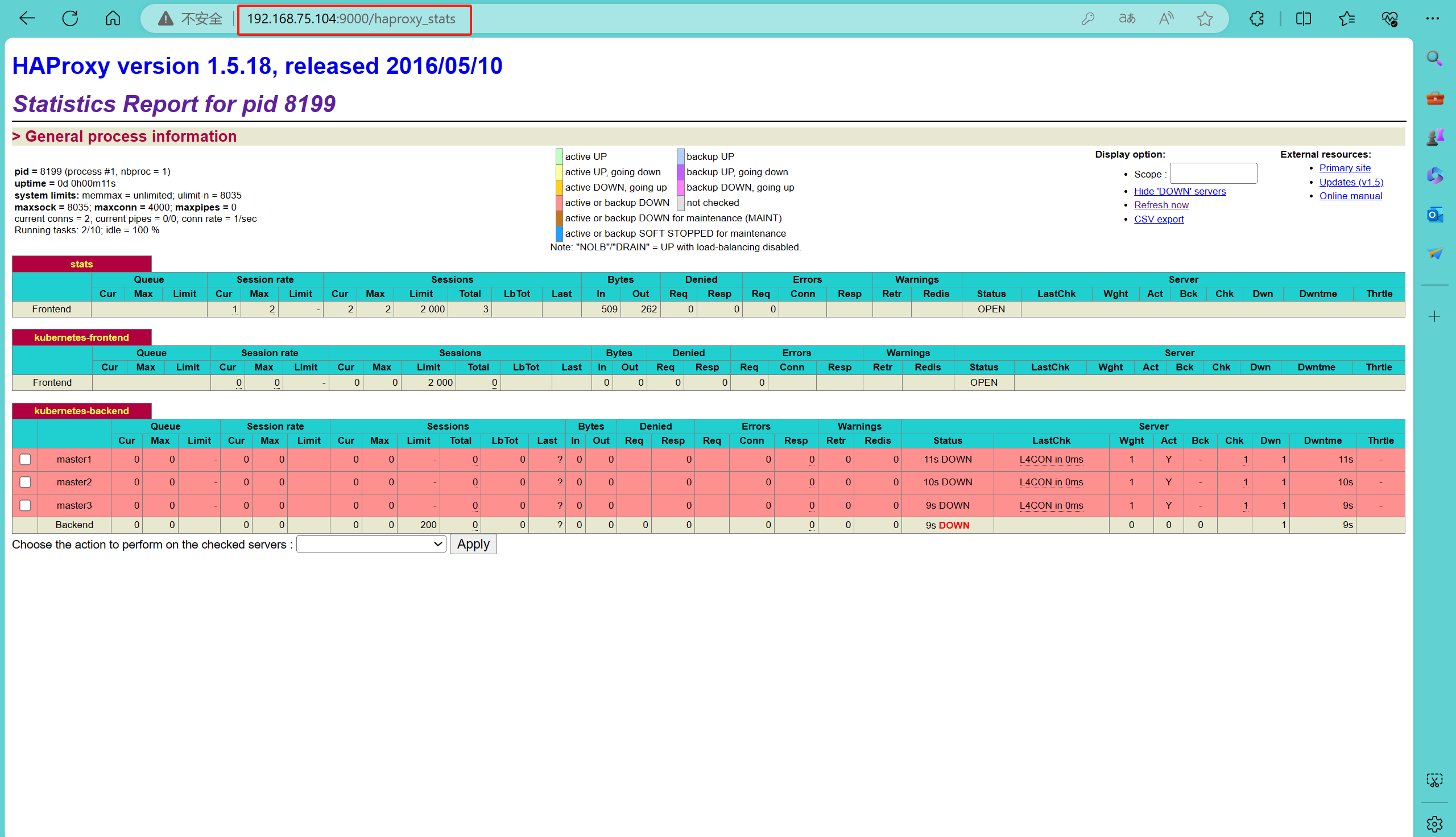

4.9.1 安装haproxy

也可以选择lvs、nginx等

[root@localhost ~]# yum install -y haproxy

[root@localhost ~]# vim /etc/haproxy/haproxy.cfg

# Global settings section

global

log 127.0.0.1 local2 # 设置日志记录,使用本地系统日志服务

chroot /var/lib/haproxy # 设置 HAProxy 的运行环境为隔离模式

pidfile /var/run/haproxy.pid # 指定 HAProxy 进程的 PID 文件位置

maxconn 4000 # 设置最大并发连接数

user haproxy # 指定 HAProxy 运行的用户

group haproxy # 指定 HAProxy 运行的用户组

daemon # 以守护进程模式运行

# 开启状态统计的 UNIX 套接字

stats socket /var/lib/haproxy/stats

# Default settings section

defaults

mode tcp # 默认使用 TCP 模式,适用于非 HTTP 流量

log global # 使用全局日志设置

option tcplog # 开启 TCP 日志记录

timeout connect 10s # 连接超时设置

timeout client 1m # 客户端超时

timeout server 1m # 服务器超时

retries 3 # 连接重试次数

frontend stats

mode http

bind *:9000 # 监听 9000 端口,用于访问统计页面

stats enable # 启用统计报告

stats uri /haproxy_stats # 设置统计报告的 URI,可以通过 http://<your-ip>:9000/haproxy_stats 访问

stats realm HAProxy\ Statistics # 设置认证弹窗的标题

stats auth admin:password # 设置访问统计页面的用户名和密码,这里为 admin 和 password,您应该设置一个更安全的密码

stats admin if TRUE # 如果设置为 TRUE,允许在页面上进行管理操作

# Kubernetes Master 节点的前端配置

frontend kubernetes-frontend

bind *:6443 # 监听 8443 端口,用于 Kubernetes API

default_backend kubernetes-backend # 默认后端设置为 kubernetes-backend

# Kubernetes Master 节点的后端配置

backend kubernetes-backend

balance roundrobin # 使用轮询算法进行负载均衡

option tcp-check # 开启 TCP 检查以检测服务器健康状态

server master1 kub-k8s-master1:6443 check # Kubernetes Master 节点1

server master2 kub-k8s-master2:6443 check # Kubernetes Master 节点2

server master3 kub-k8s-master3:6443 check # Kubernetes Master 节点3

[root@localhost ~]# systemctl start haproxy

4.9.2 配置keepalived

[root@kub-k8s-master1 ~]# yum install -y keepalived

! Configuration File for keepalived

global_defs {

router_id directory1 # master2、3记得修改

}

vrrp_instance VI_1 {

state MASTER # master2、3记得修改

interface ens33

virtual_router_id 80

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.75.104/24 # 网段的vip,也是4.9.3初始化步骤中的 --control-plane-endpoint

}

}

启动并开机启动

4.9.3 初始化集群

注意事项:

- 1、–control-plane-endpoint “192.168.75.104:8443” 指的是vip的地址和haproxy的端口

- 2、–pod-network-cidr=10.244.0.0/16 可以默认,如果修改,所有pod的网段均会修改

- 3、–apiserver-advertise-address=192.168.75.100 指的是当前master1 的ip地址

- 4、–apiserver-cert-extra-sans=后面指的是所有master的ip和vip地址

运行初始化过程如下:

[root@kub-k8s-master1 ~]# kubeadm init --kubernetes-version=v1.22.0 --control-plane-endpoint "192.168.75.104:8443" --pod-network-cidr=10.244.0.0/16 --apiserver-advertise-address=192.168.75.100 --apiserver-cert-extra-sans=192.168.75.104,192.168.75.100,192.168.75.101,192.168.75.102,192.168.75.101 --upload-certs

[init] Using Kubernetes version: v1.22.0

[preflight] Running pre-flight checks

[WARNING SystemVerification]: this Docker version is not on the list of validated versions: 25.0.0. Latest validated version: 20.10

[preflight] Pulling images required for setting up a Kubernetes cluster

[preflight] This might take a minute or two, depending on the speed of your internet connection

[preflight] You can also perform this action in beforehand using 'kubeadm config images pull'

[certs] Using certificateDir folder "/etc/kubernetes/pki"

[certs] Generating "ca" certificate and key

[certs] Generating "apiserver" certificate and key

[certs] apiserver serving cert is signed for DNS names [kub-k8s-master1 kubernetes kubernetes.default kubernetes.default.svc kubernetes.default.svc.cluster.local] and IPs [10.96.0.1 192.168.75.100 192.168.75.104 192.168.75.101 192.168.75.102]

[certs] Generating "apiserver-kubelet-client" certificate and key

[certs] Generating "front-proxy-ca" certificate and key

[certs] Generating "front-proxy-client" certificate and key

[certs] Generating "etcd/ca" certificate and key

[certs] Generating "etcd/server" certificate and key

[certs] etcd/server serving cert is signed for DNS names [kub-k8s-master1 localhost] and IPs [192.168.75.100 127.0.0.1 ::1]

[certs] Generating "etcd/peer" certificate and key

[certs] etcd/peer serving cert is signed for DNS names [kub-k8s-master1 localhost] and IPs [192.168.75.100 127.0.0.1 ::1]

[certs] Generating "etcd/healthcheck-client" certificate and key

[certs] Generating "apiserver-etcd-client" certificate and key

[certs] Generating "sa" key and public key

[kubeconfig] Using kubeconfig folder "/etc/kubernetes"

[endpoint] WARNING: port specified in controlPlaneEndpoint overrides bindPort in the controlplane address

[kubeconfig] Writing "admin.conf" kubeconfig file

[endpoint] WARNING: port specified in controlPlaneEndpoint overrides bindPort in the controlplane address

[kubeconfig] Writing "kubelet.conf" kubeconfig file

[endpoint] WARNING: port specified in controlPlaneEndpoint overrides bindPort in the controlplane address

[kubeconfig] Writing "controller-manager.conf" kubeconfig file

[endpoint] WARNING: port specified in controlPlaneEndpoint overrides bindPort in the controlplane address

[kubeconfig] Writing "scheduler.conf" kubeconfig file

[kubelet-start] Writing kubelet environment file with flags to file "/var/lib/kubelet/kubeadm-flags.env"

[kubelet-start] Writing kubelet configuration to file "/var/lib/kubelet/config.yaml"

[kubelet-start] Starting the kubelet

[control-plane] Using manifest folder "/etc/kubernetes/manifests"

[control-plane] Creating static Pod manifest for "kube-apiserver"

[control-plane] Creating static Pod manifest for "kube-controller-manager"

[control-plane] Creating static Pod manifest for "kube-scheduler"

[etcd] Creating static Pod manifest for local etcd in "/etc/kubernetes/manifests"

[wait-control-plane] Waiting for the kubelet to boot up the control plane as static Pods from directory "/etc/kubernetes/manifests". This can take up to 4m0s

[apiclient] All control plane components are healthy after 5.013483 seconds

[upload-config] Storing the configuration used in ConfigMap "kubeadm-config" in the "kube-system" Namespace

[kubelet] Creating a ConfigMap "kubelet-config-1.22" in namespace kube-system with the configuration for the kubelets in the cluster

[upload-certs] Storing the certificates in Secret "kubeadm-certs" in the "kube-system" Namespace

[upload-certs] Using certificate key:

1d241f4bdfbfb37444221397b0e3522c8096f54d4b301cc49b69ddc735bee9c1

[mark-control-plane] Marking the node kub-k8s-master1 as control-plane by adding the labels: [node-role.kubernetes.io/master(deprecated) node-role.kubernetes.io/control-plane node.kubernetes.io/exclude-from-external-load-balancers]

[mark-control-plane] Marking the node kub-k8s-master1 as control-plane by adding the taints [node-role.kubernetes.io/master:NoSchedule]

[bootstrap-token] Using token: hxyvvg.bzvpv2h1ag28g79m

[bootstrap-token] Configuring bootstrap tokens, cluster-info ConfigMap, RBAC Roles

[bootstrap-token] configured RBAC rules to allow Node Bootstrap tokens to get nodes

[bootstrap-token] configured RBAC rules to allow Node Bootstrap tokens to post CSRs in order for nodes to get long term certificate credentials

[bootstrap-token] configured RBAC rules to allow the csrapprover controller automatically approve CSRs from a Node Bootstrap Token

[bootstrap-token] configured RBAC rules to allow certificate rotation for all node client certificates in the cluster

[bootstrap-token] Creating the "cluster-info" ConfigMap in the "kube-public" namespace

[kubelet-finalize] Updating "/etc/kubernetes/kubelet.conf" to point to a rotatable kubelet client certificate and key

[addons] Applied essential addon: CoreDNS

[endpoint] WARNING: port specified in controlPlaneEndpoint overrides bindPort in the controlplane address

[addons] Applied essential addon: kube-proxy

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Alternatively, if you are the root user, you can run:

export KUBECONFIG=/etc/kubernetes/admin.conf

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

You can now join any number of the control-plane node running the following command on each as root:

# 其他控制节点执行

kubeadm join 192.168.75.104:8443 --token hxyvvg.bzvpv2h1ag28g79m \

--discovery-token-ca-cert-hash sha256:19a140207276157f923d7f962b5a51e93006f282180b439ad5c1390acaea722c \

--control-plane --certificate-key 1d241f4bdfbfb37444221397b0e3522c8096f54d4b301cc49b69ddc735bee9c1

Please note that the certificate-key gives access to cluster sensitive data, keep it secret!

As a safeguard, uploaded-certs will be deleted in two hours; If necessary, you can use

"kubeadm init phase upload-certs --upload-certs" to reload certs afterward.

Then you can join any number of worker nodes by running the following on each as root:

# 其他node节点执行

kubeadm join 192.168.75.104:8443 --token hxyvvg.bzvpv2h1ag28g79m \

--discovery-token-ca-cert-hash sha256:19a140207276157f923d7f962b5a51e93006f282180b439ad5c1390acaea722c

上面记录了完成的初始化输出的内容,根据输出的内容基本上可以看出手动初始化安装一个Kubernetes集群所需要的关键步骤。

其中有以下关键内容:

[kubelet] 生成kubelet的配置文件”/var/lib/kubelet/config.yaml”

[certificates]生成相关的各种证书

[kubeconfig]生成相关的kubeconfig文件

[bootstraptoken]生成token记录下来,后边使用kubeadm join往集群中添加节点时会用到

配置使用kubectl

如下操作在master节点操作

[root@kub-k8s-master1 ~]# rm -rf $HOME/.kube

[root@kub-k8s-master1 ~]# mkdir -p $HOME/.kube

[root@kub-k8s-master1 ~]# cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

[root@kub-k8s-master1 ~]# chown $(id -u):$(id -g) $HOME/.kube/config

查看node节点

[root@k8s-master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master NotReady master 2m41s v1.22.0

4.10 配置使用网络插件[master]

# 版本差异 https://projectcalico.docs.tigera.io/archive/v3.22/getting-started/kubernetes/requirements

#> 部署calico网络插件

[root@kub-k8s-master1 ~]# curl -L https://docs.projectcalico.org/v3.22/manifests/calico.yaml -O

# 修改 文件

4205 - name: IP_AUTODETECTION_METHOD

4206 value: "interface=ens33"

[root@kub-k8s-master1 ~]# kubectl apply -f calico.yaml

[root@kub-k8s-master1 ~]# kubectl get pod -A -w

NAMESPACE NAME READY STATUS RESTARTS AGE

kube-system calico-kube-controllers-7c87c5f9b8-q2vth 1/1 Running 0 36s

kube-system calico-node-5th7f 1/1 Running 0 36s

kube-system calico-node-g996t 1/1 Running 0 36s

kube-system calico-node-n94v5 1/1 Running 0 36s

kube-system calico-node-qjmth 1/1 Running 0 36s

kube-system calico-node-rfzf7 1/1 Running 0 36s

kube-system coredns-78fcd69978-5sg7p 1/1 Running 0 11m

kube-system coredns-78fcd69978-btws4 1/1 Running 0 11m

kube-system etcd-kub-k8s-master1 1/1 Running 6 11m

kube-system etcd-kub-k8s-master2 1/1 Running 0 10m

kube-system etcd-kub-k8s-master3 1/1 Running 0 10m

kube-system kube-apiserver-kub-k8s-master1 1/1 Running 6 11m

kube-system kube-apiserver-kub-k8s-master2 1/1 Running 2 (10m ago) 11m

kube-system kube-apiserver-kub-k8s-master3 1/1 Running 0 10m

kube-system kube-controller-manager-kub-k8s-master1 1/1 Running 10 (10m ago) 11m

kube-system kube-controller-manager-kub-k8s-master2 1/1 Running 0 11m

kube-system kube-controller-manager-kub-k8s-master3 1/1 Running 0 10m

kube-system kube-proxy-4bsm2 1/1 Running 0 8m2s

kube-system kube-proxy-bb5rd 1/1 Running 0 10m

kube-system kube-proxy-bnxj5 1/1 Running 0 8m4s

kube-system kube-proxy-cfm5m 1/1 Running 0 11m

kube-system kube-proxy-smhd6 1/1 Running 0 11m

kube-system kube-scheduler-kub-k8s-master1 1/1 Running 10 (10m ago) 11m

kube-system kube-scheduler-kub-k8s-master2 1/1 Running 0 11m

kube-system kube-scheduler-kub-k8s-master3 1/1 Running 0 10m

calico 原理

- 基于 BGP 的网络连接:Calico 使用 BGP 协议在 Kubernetes 集群中的节点之间建立网络连接。每个节点运行一个 Calico 代理【daemonset】,该代理负责与其他节点建立 BGP 连接,并将容器的网络流量路由到正确的目的地。

- 网络策略:Calico 提供了一种灵活的网络策略模型,允许定义容器之间的访问规则。可以使用标签来标识容器,并使用网络策略来控制容器之间的流量。

- IP 地址管理:Calico 自动管理 Kubernetes 集群中的 IP 地址分配。它使用 IPIP 隧道技术将容器的 IP 地址映射到节点的 IP 地址,以确保容器之间的通信。

- 网络隔离:Calico 提供了网络隔离功能,允许将不同的容器和应用程序隔离到不同的网络中。

flannel 原理

- 网络覆盖:Flannel 在 Kubernetes 集群中的每个节点上运行一个守护进程,该守护进程使用 VXLAN。

- 网络配置:Flannel 守护进程负责配置虚拟网络,并将容器的网络流量路由到正确的目的地。

- IP 地址分配:Flannel 自动管理 Kubernetes 集群中的 IP 地址分配。它使用 IPAM(IP Address Management)模块来分配 IP 地址,并将它们分配给容器。

- 网络策略:Flannel 支持网络策略,允许定义容器之间的访问规则。可以使用网络策略来控制容器之间的流量,以确保应用程序的安全性。

4.11 加入集群[node]

注意,如果丢失了初始化命令,可以通过一下命令重新生成

kubeadm token create --print-join-command

master 节点[master2、master3]

[root@kub-k8s-master1 ~]# kubeadm join 192.168.75.104:8443 --token hxyvvg.bzvpv2h1ag28g79m --discovery-token-ca-cert-hash sha256:19a140207276157f923d7f962b5a51e93006f282180b439ad5c1390acaea722c --control-plane --certificate-key 1d241f4bdfbfb37444221397b0e3522c8096f54d4b301cc49b69ddc735bee9c1

node 节点

配置node节点加入集群:

如果报错开启ip转发:

# sysctl -w net.ipv4.ip_forward=1

在所有node节点操作,此命令为初始化master成功后返回的结果

# kubeadm join 192.168.75.104:8443 --token hxyvvg.bzvpv2h1ag28g79m \

--discovery-token-ca-cert-hash sha256:19a140207276157f923d7f962b5a51e93006f282180b439ad5c1390acaea722c

4.12 后续检查[master]

各种检测:

1.查看pods:

[root@kub-k8s-master1 ~]# kubectl get pod -A -w

NAMESPACE NAME READY STATUS RESTARTS AGE

kube-system calico-kube-controllers-7c87c5f9b8-q2vth 1/1 Running 0 36s

kube-system calico-node-5th7f 1/1 Running 0 36s

kube-system calico-node-g996t 1/1 Running 0 36s

kube-system calico-node-n94v5 1/1 Running 0 36s

kube-system calico-node-qjmth 1/1 Running 0 36s

kube-system calico-node-rfzf7 1/1 Running 0 36s

kube-system coredns-78fcd69978-5sg7p 1/1 Running 0 11m

kube-system coredns-78fcd69978-btws4 1/1 Running 0 11m

kube-system etcd-kub-k8s-master1 1/1 Running 6 11m

kube-system etcd-kub-k8s-master2 1/1 Running 0 10m

kube-system etcd-kub-k8s-master3 1/1 Running 0 10m

kube-system kube-apiserver-kub-k8s-master1 1/1 Running 6 11m

kube-system kube-apiserver-kub-k8s-master2 1/1 Running 2 (10m ago) 11m

kube-system kube-apiserver-kub-k8s-master3 1/1 Running 0 10m

kube-system kube-controller-manager-kub-k8s-master1 1/1 Running 10 (10m ago) 11m

kube-system kube-controller-manager-kub-k8s-master2 1/1 Running 0 11m

kube-system kube-controller-manager-kub-k8s-master3 1/1 Running 0 10m

kube-system kube-proxy-4bsm2 1/1 Running 0 8m2s

kube-system kube-proxy-bb5rd 1/1 Running 0 10m

kube-system kube-proxy-bnxj5 1/1 Running 0 8m4s

kube-system kube-proxy-cfm5m 1/1 Running 0 11m

kube-system kube-proxy-smhd6 1/1 Running 0 11m

kube-system kube-scheduler-kub-k8s-master1 1/1 Running 10 (10m ago) 11m

kube-system kube-scheduler-kub-k8s-master2 1/1 Running 0 11m

kube-system kube-scheduler-kub-k8s-master3 1/1 Running 0 10m

2.查看节点:

[root@kub-k8s-master1 ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

kub-k8s-master Ready master 43m v1.22.0

kub-k8s-node1 Ready <none> 6m46s v1.22.0

kub-k8s-node2 Ready <none> 6m37s v1.22.0

到此集群配置完成

4.13 集群数据库相关操作

由k8s集群数据库文档单独记录

kubernetes命令自动补全

[root@kub-k8s-master1 ~]# yum install -y epel-release bash-completion

[root@kub-k8s-master1 ~]# source /usr/share/bash-completion/bash_completion

[root@kub-k8s-master1 ~]# source <(kubectl completion bash)

[root@kub-k8s-master1 ~]# echo "source <(kubectl completion bash)" >> ~/.bashrc

# 输入kubectl, 双击Tab

[root@kub-k8s-master1 ~]# kubectl

alpha apply certificate convert delete edit get options proxy scale uncordon

annotate attach cluster-info cordon describe exec kustomize patch replace set version

api-resources auth completion cp diff explain label plugin rollout taint wait

api-versions autoscale config create drain expose logs port-forward run top

[root@kub-k8s-master1 ~]# kubectl

错误整理

#> 如果集群初始化失败:(每个节点都要执行)

$ kubeadm reset -f; ipvsadm --clear; rm -rf ~/.kube

$ systemctl restart kubelet

#> 如果忘记token值

$ kubeadm token create --print-join-command

$ kubeadm init phase upload-certs --upload-certs

五.可视化部署

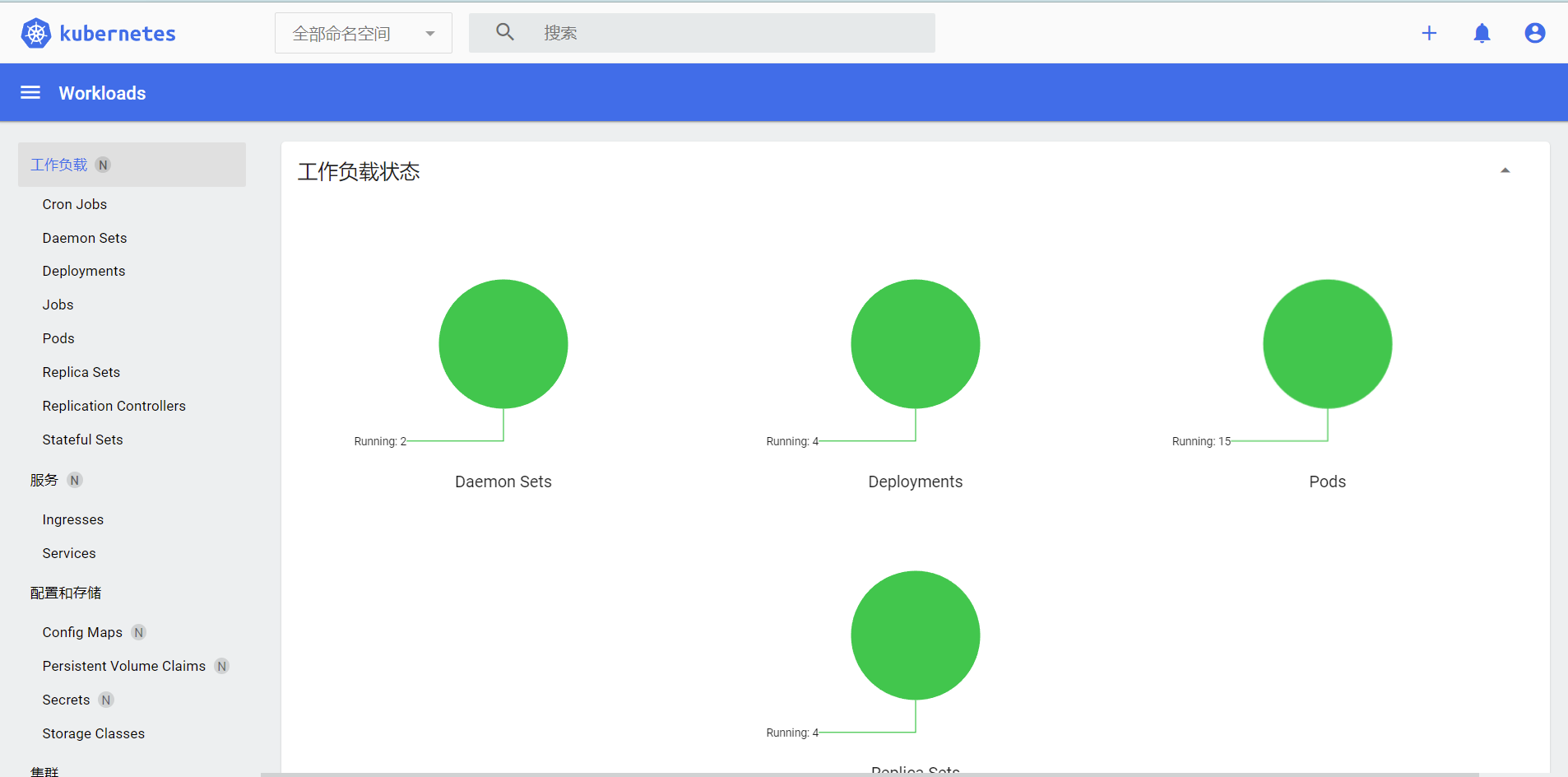

5.1 官方Dashboard

5.1.1 部署Dashboard

# kubectl apply -f https://raw.githubusercontent.com/kubernetes/dashboard/v2.4.0/aio/deploy/recommended.yaml

# kubectl edit svc kubernetes-dashboard -n kubernetes-dashboard

# 注意将 type: ClusterIP 改为 type: NodePort

# kubectl get svc -A |grep kubernetes-dashboard

kubernetes-dashboard dashboard-metrics-scraper ClusterIP 10.107.179.10 <none> 8000/TCP 38s

kubernetes-dashboard kubernetes-dashboard NodePort 10.110.18.72 <none> 443:32231/TCP 38s

5.1.2 创建访问账号

#创建访问账号,准备一个yaml文件; vi dash.yaml

apiVersion: v1

kind: ServiceAccount

metadata:

name: admin-user

namespace: kubernetes-dashboard

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: admin-user

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: cluster-admin

subjects:

- kind: ServiceAccount

name: admin-user

namespace: kubernetes-dashboard

# kubectl apply -f dash.yaml

5.1.3 获取访问令牌

#获取访问令牌

# kubectl -n kubernetes-dashboard get secret $(kubectl -n kubernetes-dashboard get sa/admin-user -o jsonpath="{.secrets[0].name}") -o go-template="{{.data.token | base64decode}}"

eyJhbGciOiJSUzI1NiIsImtpZCI6ImhRa2Q3UDFGempzb3VneVdUS0R0dk50SHlwUHExc0tuT21SOTdWQkczaG8ifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJrdWJlcm5ldGVzLWRhc2hib2FyZCIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VjcmV0Lm5hbWUiOiJhZG1pbi11c2VyLXRva2VuLXBmbGxyIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQubmFtZSI6ImFkbWluLXVzZXIiLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlcnZpY2UtYWNjb3VudC51aWQiOiJlNDk0MTFhYS0zOTVhLTRkYzUtYmZmYS04MDZiODE3M2VmZWEiLCJzdWIiOiJzeXN0ZW06c2VydmljZWFjY291bnQ6a3ViZXJuZXRlcy1kYXNoYm9hcmQ6YWRtaW4tdXNlciJ9.k3Gd9vRF6gP3Zxy89x14y4I2RCGn232bGLo9A5iEmeMl6BRPdJXZPbwy9fm3OT6ZjVc7LHiRgArczjZuCU3Sis4tIA_24A55h74WQE_JTeiZ5XnSGRknYQRHFSqyBrTaTxgDJb-O-DHol8GQLQjr6gIPzppHc-RhWhUFFNnPVP1nr2MLFBkvIT_qAcbHP6McFf2N6IsYwVFuvyIO77qWcmyFlgSr8a3A0INEJYB2bFPRL82rNc41c0TsUwOguQbJYrDA9lBqVpSff_7Uk_-7ycabZclbZX1HPz2-F59LQW7NWQy7biZw5b25AZaXAG3kL3SDuRRBoMNS92MmDFsVyA

5.1.4 浏览器访问

任意节点ip+端口[上面查看到为32231]

url https://192.168.246.216:32231/

使用token登录

5.2 kuboard 部署

[root@kube-master ~]# kubectl apply -f https://addons.kuboard.cn/kuboard/kuboard-v3.yaml

[root@kube-master ~]# kubectl get pod -n kuboard

NAME READY STATUS RESTARTS AGE

kuboard-agent-2-5c54dcb98f-4vqvc 1/1 Running 24 (7m50s ago) 16d

kuboard-agent-747b97fdb7-j42wr 1/1 Running 24 (7m34s ago) 16d

kuboard-etcd-ccdxk 1/1 Running 16 (8m58s ago) 16d

kuboard-etcd-k586q 1/1 Running 16 (8m53s ago) 16d

kuboard-questdb-bd65d6b96-rgx4x 1/1 Running 10 (8m53s ago) 16d

kuboard-v3-5fc46b5557-zwnsf 1/1 Running 12 (8m53s ago) 16d

[root@kube-master ~]# kubectl get svc -n kuboard

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kuboard-v3 NodePort 10.96.25.125 <none> 80:30080/TCP,10081:30081/TCP,10081:30081/UDP 16d

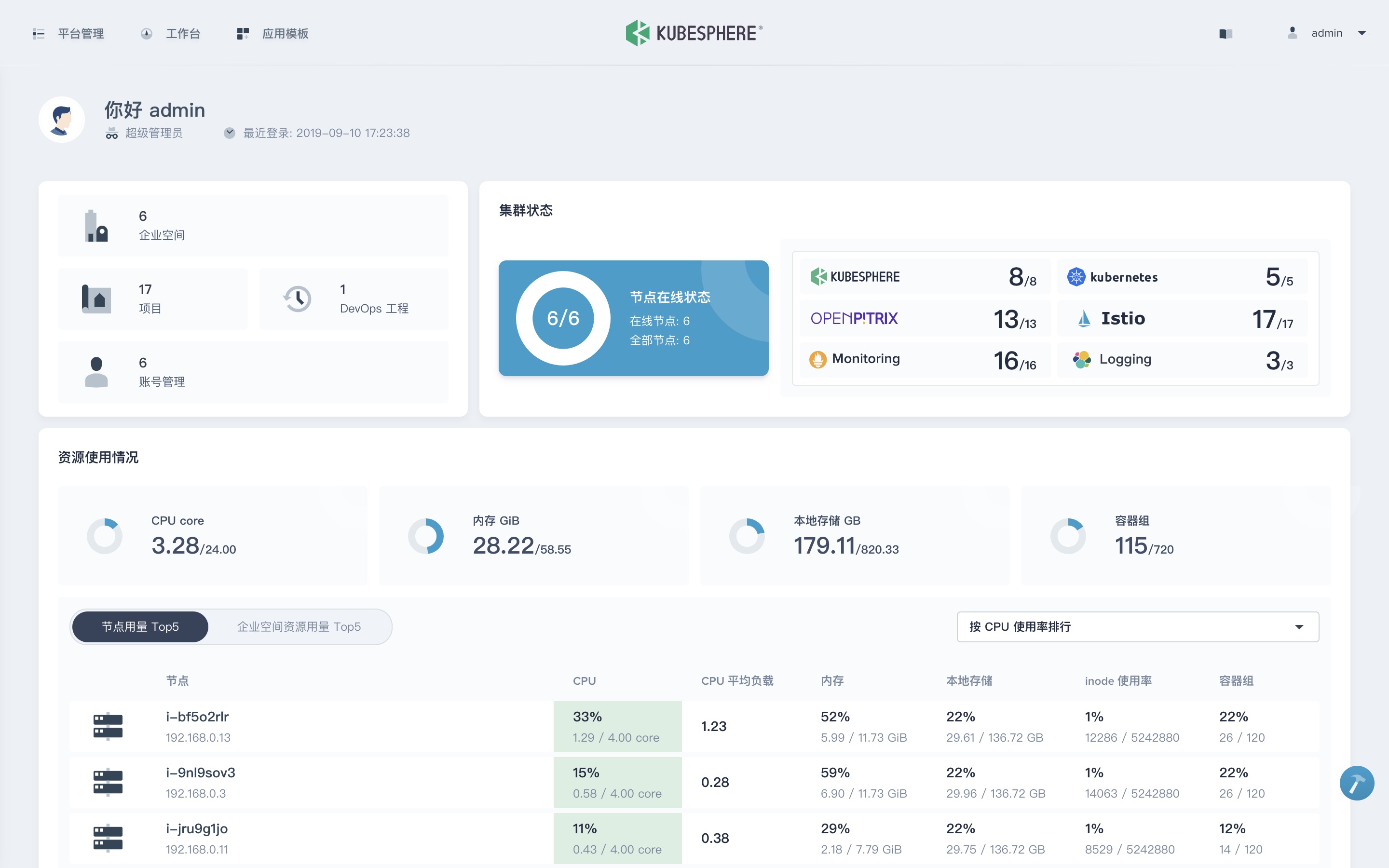

5.3 kubesphere 部署

官方文档:

在 Kubernetes 上最小化安装 KubeSphere

# 运行安装

[root@kube-master ~]# kubectl apply -f https://github.com/kubesphere/ks-installer/releases/download/v3.4.0/kubesphere-installer.yaml

[root@kube-master ~]# kubectl apply -f https://github.com/kubesphere/ks-installer/releases/download/v3.4.0/cluster-configuration.yaml

# 查看日志

[root@kube-master ~]# kubectl logs -n kubesphere-system $(kubectl get pod -n kubesphere-system -l 'app in (ks-install, ks-installer)' -o jsonpath='{.items[0].metadata.name}') -f

卸载kubesphere

[root@kube-master ~]# curl https://raw.githubusercontent.com/kubesphere/ks-installer/release-3.4/scripts/kubesphere-delete.sh | sh

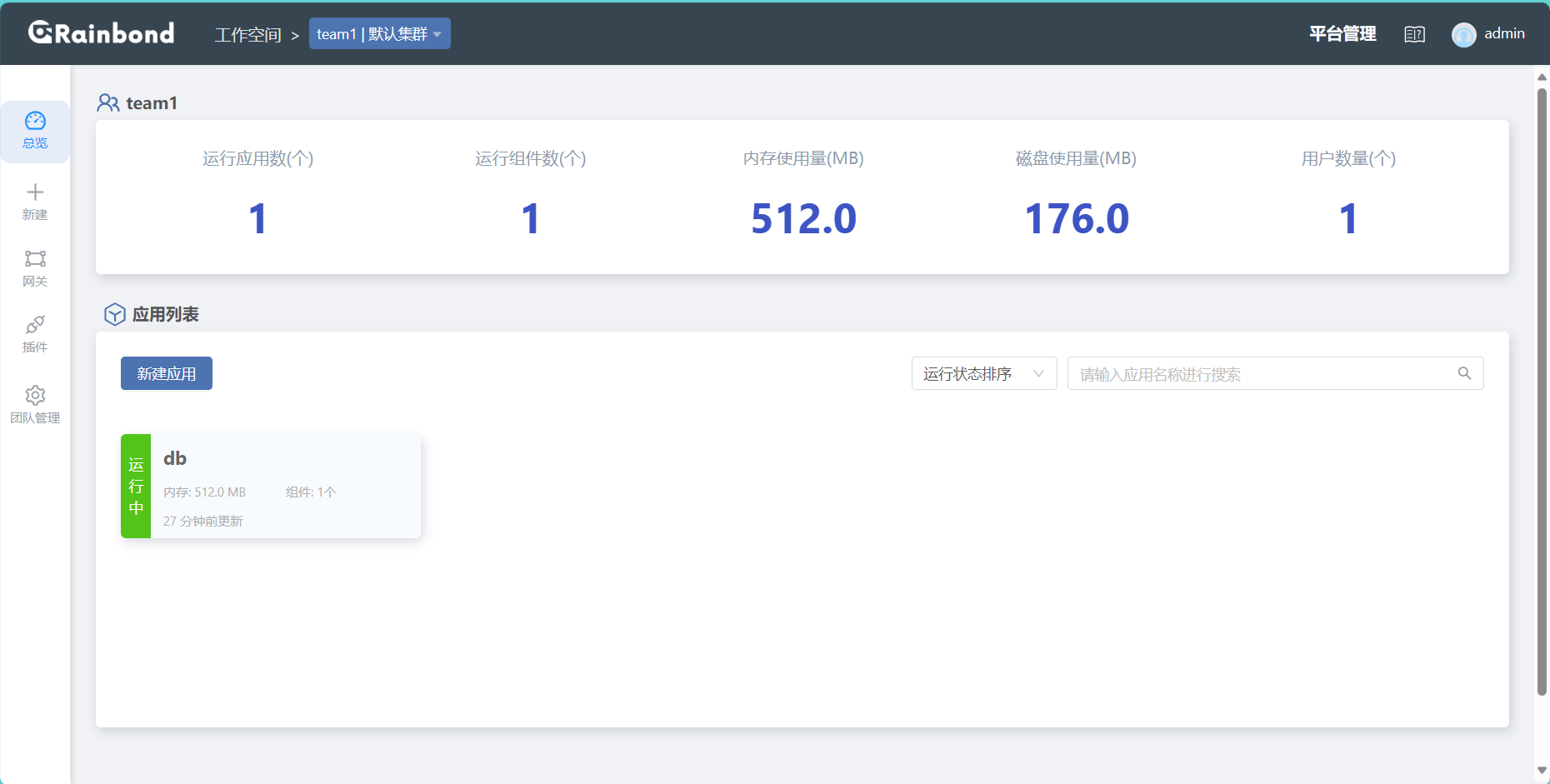

5.4 rainbond 部署

[root@kube-master ~]# curl -o install.sh https://get.rainbond.com && bash ./install.sh

RO

[root@kube-master ~]# helm repo add rainbond https://openchart.goodrain.com/goodrain/rainbond

[root@kube-master ~]# helm repo update

[root@kube-master ~]# kubectl create namespace rbd-system

卸载

如果是基于helm创建的rainbond

[root@kube-master ~]# helm uninstall rainbond -n rbd-system

如果是基于官方脚本创建的rainbond

# Delete PVC

[root@kube-master ~]# kubectl get pvc -n rbd-system | grep -v NAME | awk '{print $1}' | xargs kubectl delete pvc -n rbd-system

# Delete PV

[root@kube-master ~]# kubectl get pv | grep rbd-system | grep -v NAME | awk '{print $1}' | xargs kubectl delete pv

# Delete CRD

[root@kube-master ~]# kubectl delete crd componentdefinitions.rainbond.io \

helmapps.rainbond.io \

rainbondclusters.rainbond.io \

rainbondpackages.rainbond.io \

rainbondvolumes.rainbond.io \

rbdcomponents.rainbond.io \

servicemonitors.monitoring.coreos.com \

thirdcomponents.rainbond.io \

rbdabilities.rainbond.io \

rbdplugins.rainbond.io \

servicemeshclasses.rainbond.io \

servicemeshes.rainbond.io \

-n rbd-system

# Delete NAMESPACE

[root@kube-master ~]# kubectl delete ns rbd-system

六.集群常用指令

6.1 基础控制指令

# 查看对应资源: 状态

$ kubectl get <SOURCE_NAME> -n <NAMESPACE> -o wide

# 查看对应资源: 事件信息

$ kubectl describe <SOURCE_NAME> <SOURCE_NAME_RANDOM_ID> -n <NAMESPACE>

# 查看pod资源: 日志

$ kubectl logs -f <SOURCE_NAME_RANDOM_ID> [CONTINER_NAME] -n <NAMESPACE>

# 创建资源: 根据资源清单

$ kubectl apply[or create] -f <SOURCE_FILENAME>.yaml

# 删除资源: 根据资源清单

$ kubectl delete -f <SOURCE_FILENAME>.yaml

# 修改资源: 根据反射出的etcd中的配置内容, 生产中不允许该项操作, 且命令禁止

$ kubectl edit <SOURCE_NAME> <SOURCE_NAME_RANDOM_ID> -n <NAMESPACE>

6.2 命令实践

# 查看node状态

$ kubectl get node # -o wide 显示更加详细的信息

# 查看service对象

$ kubectl get svc

# 查看kube-system名称空间内的Pod

$ kubectl get pod -n kube-system

# 查看所有名称空间内的pod

$ kubectl get pod -A

# 查看集群信息

$ kubectl cluster-info

# 查看各组件信息

$ kubectl -s https://api-server:6443 get componentstatuses

# 查看各资源对象对应的api版本

$ kubectl explain pod

# 查看帮助信息

$ kubectl explain deployment

$ kubectl explain deployment.spec

$ kubectl explain deployment.spec.replicas

6.3 备注

问题一 查看各组件信息,可能会发现错误

$ kubectl -s https://192.168.96.143:6443 get componentstatuses

Warning: v1 ComponentStatus is deprecated in v1.19+

NAME STATUS MESSAGE ERROR

scheduler Unhealthy Get "http://127.0.0.1:10251/healthz": dial tcp 127.0.0.1:10251: connect: connection refused

controller-manager Unhealthy Get "http://127.0.0.1:10252/healthz": dial tcp 127.0.0.1:10252: connect: connection refused

etcd-0 Healthy {"health":"true"}

问题一解决

$ vim /etc/kubernetes/manifests/kube-scheduler.yaml

10 spec:

11 containers:

12 - command:

13 - kube-scheduler

14 - --authentication-kubeconfig=/etc/kubernetes/scheduler.conf

15 - --authorization-kubeconfig=/etc/kubernetes/scheduler.conf

16 - --bind-address=127.0.0.1

17 - --kubeconfig=/etc/kubernetes/scheduler.conf

18 - --leader-elect=true

19 - --port=0 # 将此行注释或删除

$ vim /etc/kubernetes/manifests/kube-controller-manager.yaml

10 spec:

11 containers:

12 - command:

13 - kube-controller-manager

14 - --allocate-node-cidrs=true

15 - --authentication-kubeconfig=/etc/kubernetes/controller-manager.conf

16 - --authorization-kubeconfig=/etc/kubernetes/controller-manager.conf

17 - --bind-address=127.0.0.1

18 - --client-ca-file=/etc/kubernetes/pki/ca.crt

19 - --cluster-cidr=10.244.0.0/16

20 - --cluster-name=kubernetes

21 - --cluster-signing-cert-file=/etc/kubernetes/pki/ca.crt

22 - --cluster-signing-key-file=/etc/kubernetes/pki/ca.key

23 - --controllers=*,bootstrapsigner,tokencleaner

24 - --kubeconfig=/etc/kubernetes/controller-manager.conf

25 - --port=0 # 将此行注释或删除

$ systemctl restart kubelet

$ kubectl -s https://192.168.96.143:6443 get componentstatuses

Warning: v1 ComponentStatus is deprecated in v1.19+

NAME STATUS MESSAGE ERROR

scheduler Healthy ok

controller-manager Healthy ok

etcd-0 Healthy {"health":"true"}

七.Yaml语法解析

YAML是一个类似 XML、JSON 的标记性语言。它强调以数据为中心,并不是以标识语言为重点。因而YAML本身的定义比较简单,号称"一种人性化的数据格式语言"。

YAML的语法比较简单,主要有下面几个:

1、大小写敏感

2、使用缩进表示层级关系

3、缩进不允许使用tab,只允许空格( 低版本限制 )

4、缩进的空格数不重要,只要相同层级的元素左对齐即可

5、'#'表示注释

YAML支持以下几种数据类型:

1、纯量:单个的、不可再分的值

2、对象:键值对的集合,又称为映射(mapping)/ 哈希(hash) / 字典(dictionary)

3、数组:一组按次序排列的值,又称为序列(sequence) / 列表(list)

补充说明:

1、书写yaml切记: 后面要加一个空格

2、如果需要将多段yaml配置放在一个文件中,中间要使用---分隔

举个例子,通过声明式配置yaml 创建名称空间

$ vim namespace.yaml

apiVersion: v1

kind: Namespace

metadata:

name: webserver

$ kubectl apply -f namespace.yaml

# 如果通过命令行创建

$ kubectl create namespace webserver

# 删除名称空间[注意,这将删除名称空间下的所有资源]

$ kubectl delete namespace webserver

八.k8s中的Pod

Pod 是可以在 Kubernetes 中创建和管理的、最小的可部署的计算单元; Pod 中会启动一个或一组紧密相关的业务容器, 各个业务容器相当于_Pod_ 中的各个进程, 此时就可以将_Pod_ 作为虚拟机看待; 在创建 Pod 时会启动一个init容器, 用来初始化存储和网络, 其余的业务容器都将在init容器启动后启动, 业务容器共享init容器的存储和网络; Pod 只是一个逻辑单元, 并不是真实存在的“主机”, 这种类比主机的概念可以更好的符合现有互联网中几乎所有的虚拟化设计; 像之前运行在虚拟机中的 nginx、mysql、php均可以使用对应的镜像运行出对应的容器在Pod中, 来类比虚拟机中运行这三者;

对于 Pod 而言, 在运行的过程中, k8s为了控制其生命周期的状态, 增加了_容器探测指针_、资源限额、期望状态保持、多容器结合、安全策略设定、控制器受管、故障处理策略 等; Pod在平时是不能够被单独创建的, 而是需要使用控制器对其创建, 这样可以时刻保持Pod的期望状态;

在Kubernetes中所有的资源均可通过命令行参数或者资源清单[yaml/json]的方式进行创建和修改, 但由于Kubernetes属于声明式资源控制集群, 故大多管理Kubernetes集群的方式采用资源配置清单; 资源配置清单可以很好的追溯资源的原型和详细的配置, 且配合版本控制能够完成更好的溯源、回滚、发布等操作; 所以课程中所有的资源创建和修改都会采用资源配置清单的方式, 除部分命令行操作以外;

Pod API 对象

问题:

通过yaml文件创建pod的时候里面有容器,这个文件里面到底哪些属性属于 Pod 对象,哪些属性属于 Container?

解决:

共同特征是,它们描述的是"机器"这个整体,而不是里面运行的"程序"。

容器可选的设置属性包括:

Pod是 k8s 项目中的最小编排单位。将这个设计落实到 API 对象上,容器(Container)就成了 Pod 属性里一个普通的字段。

把 Pod 看成传统环境里的"虚拟机机器"、把容器看作是运行在这个"机器"里的"用户程序",那么很多关于 Pod 对象的设计就非常容易理解了。

凡是调度、网络、存储,以及安全相关的属性,基本上是 Pod 级别的

比如:

配置这个"机器"的网卡(即:Pod 的网络定义)

配置这个"机器"的磁盘(即:Pod 的存储定义)

配置这个"机器"的防火墙(即:Pod 的安全定义)

这台"机器"运行在哪个服务器之上(即:Pod 的调度)

kind:指定了这个 API 对象的类型(Type),是一个 Pod,根据实际情况,此处资源类型可以是Deployment、Job、Ingress、Service等。

metadata:包含Pod的一些meta信息,比如名称、namespace、标签等信息.

spec:specification of the resource content 指定该资源的内容,包括一些container,storage,volume以及其他Kubernetes需要的参数,以及诸如是否在容器失败时重新启动容器的属性。可在特定Kubernetes API找到完整的Kubernetes Pod的属性。

ˌ

specification----->[spesɪfɪˈkeɪʃn]

"name": 容器名称

"image": 容器镜像

"command": 容器启动指令

"args": 指令参数

"workingDir": 工作目录

"ports": 容器端口

"env": 环境变量

"resource": 资源限制

"volumeMounts": 卷挂载

"livenessProbe": 存活探针

"readinessProbe": 就绪探针

"startupProbe": 启动探针

"livecycle": 钩子函数

"terminationMessagePath": 容器的异常终止消息的路径,默认在 /dev/termination-log

"imagePullPolicy": 镜像拉去策略

"securityContext": 安全上下文

"stdin": 给容器分配标准输入,类似docker run -i

"tty": 分配终端

8.1 创建一个pod

$ vim nginx.yaml

apiVersion: v1

kind: Pod

metadata:

name: nginx

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.16.1

ports:

- containerPort: 80

$ kubectl apply -f nginx.yaml

8.2 pod是如何被创建的

- step1: kubectl 向 k8s api server 发起一个create pod 请求

- step2: k8s api server接收到pod创建请求后,不会去直接创建pod;而是生成一个包含创建信息的yaml。

- step3: apiserver 将刚才的yaml信息写入etcd数据库。

- step4: scheduler 查看 k8s api,判断:pod.spec.Node == null,若为null,表示这个Pod请求是新来的,需要创建;因此先进行调度计算,找到最适合的node。并更新数据库

- step5: node节点上的Kubelet通过监听数据库更新,发现有新的任务与自己的node编号匹配,则进行任务创建

8.3 创建一个单容器pod

$ vim mysql.yaml

apiVersion: v1

kind: Pod

metadata:

name: mysql

labels:

name: mysql

spec:

restartPolicy: OnFailure

containers:

- name: mysql

image: mysql:5.7

imagePullPolicy: IfNotPresent

env:

- name: MYSQL_ROOT_PASSWORD

value: "123456"

resources:

limits:

memory: "1024Mi"

cpu: "1000m"

ports:

- containerPort: 3306

nodeSelector:

kubernetes.io/hostname: kub-k8s-node2

# nodeName: kub-k8s-node2

$ kubectl apply -f mysql.yaml

# 字段解析

restartPolicy:

pod 重启策略,可选参数有:

1、Always:Pod中的容器无论如何停止都会自动重启

2、OnFailure: Pod中的容器非正常停止会自动重启

3、Never: Pod中的容器无论怎样都不会自动重启

imagePullPolicy:

镜像拉取策略,可选参数有:

1、Always:总是重新拉取

2、IfNotPresent:默认,如果本地有,则不拉取

3、Never:只是用本地镜像,从不拉取

nodeSelector:

节点选择器:可以指定node的标签,查看标签指令:

nodeName:

节点名称: 可以指定node的名称进行调度

$ kubectl get node --show-labels

8.4 创建一个多容器pod

#vim lnmp.yaml

---

apiVersion: v1

kind: Pod

metadata:

name: nginx-many

namespace: default

labels:

app: nginx

spec:

restartPolicy: OnFailure

containers:

- name: nginx

image: nginx:1.16.1

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

- name: php-fpm

image: php:8.0-fpm-alpine

imagePullPolicy: IfNotPresent

ports:

- containerPort: 9000

$ kubectl apply -f lnmp.yaml

# 字段解析

nodeSelector:

节点选择器:可以指定node的标签,查看标签指令:

$ kubectl get node --show-labels

8.4.1 配置节点标签

添加标签

kubectl label nodes node3 name=value

删除标签

kubectl label nodes node3 name-

8.5 Pod容器的交互

8.5.1 创建pod,并做本地解析

vim host-alias.yaml

---

apiVersion: v1

kind: Pod

metadata:

name: centos

labels:

name: centos

spec:

containers:

- name: centos

image: centos:7

command:

- "tail"

- "-f"

- "/dev/null"

hostAliases:

- ip: "192.168.100.128"

hostnames:

- "master"

- "k8s-master"

- "apiserver"

# 字段解析

command:

启动容器时执行的指令,类似于docker run -it 镜像 tail -f /dev/null

hostAliases:

在容器中的/etc/hosts文件中配置本地解析

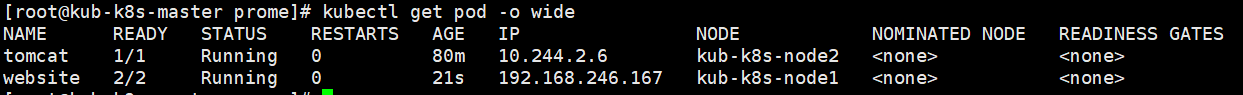

8.5.2 pod共享进程

[root@kub-k8s-master prome]# kubectl delete -f pod.yml

pod "website" deleted

[root@kub-k8s-master prome]# vim pod.yml #修改如下。最好是提前将镜像pull下来。

---

apiVersion: v1

kind: Pod

metadata:

name: website

labels:

app: website

spec:

shareProcessNamespace: true #共享进程名称空间

containers:

- name: test-web

image: daocloud.io/library/nginx

ports:

- containerPort: 80

- name: busybox

image: daocloud.io/library/busybox

stdin: true

tty: true

2.创建

[root@kub-k8s-master prome]# kubectl apply -f pod.yml

pod/website created

1. 定义了 shareProcessNamespace=true

表示这个 Pod 里的容器要共享进程(PID Namespace)如果是false则为不共享。

2. 定义了两个容器:

一个 nginx 容器

一个开启了 tty 和 stdin 的 busybos 容器

在 Pod 的 YAML 文件里声明开启它们俩,等同于设置了 docker run 里的 -it(-i 即 stdin,-t 即 tty)参数。此 Pod 被创建后,就可以使用 shell 容器的 tty 跟这个容器进行交互了。

我们通过kubectl可以查看到

# kubectl exec -it website -c busybox -- ps aux

PID USER TIME COMMAND

1 root 0:00 /pause

7 root 0:00 nginx: master process nginx -g daemon off;

35 101 0:00 nginx: worker process

36 root 0:00 sh

66 root 0:00 ps aux

在busybox中可以查看到nginx的进程

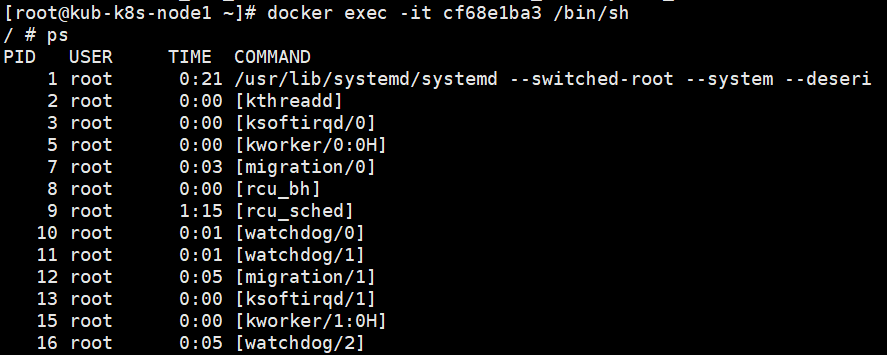

8.5.2 pod共用宿主机namespace

刚才的都是pod里面容器的Namespace,并没有和本机的Namespace做共享,接下来我们可以做与本机的Namespace共享,可以在容器里面看到本机的进程。

[root@kub-k8s-master prome]# kubectl delete -f pod.yml

pod "website" deleted

[root@kub-k8s-master prome]# vim pod.yml #修改如下

---

apiVersion: v1

kind: Pod

metadata:

name: website

labels:

app: website

spec:

hostNetwork: true #共享宿主机网络

hostIPC: true #共享ipc通信

hostPID: true #共享宿主机的pid

containers:

- name: test-web

image: daocloud.io/library/nginx

ports:

- containerPort: 80

- name: busybos

image: daocloud.io/library/busybox

stdin: true

tty: true

创建pod

[root@kub-k8s-master prome]# kubectl apply -f pod.yml

pod/website created

定义了共享宿主机的 Network、IPC 和 PID Namespace。这样,此 Pod 里的所有容器,会直接使用宿主机的网络、直接与宿主机进行 IPC 通信、看到宿主机里正在运行的所有进程。

8.6 钩子函数lifecycle

kubernetes 在主容器启动之后和删除之前提供了两个钩子函数:

- post start:容器创建之后执行,如果失败会重启容器

- pre stop:容器删除之前执行,执行完成之后容器将成功删除,在其完成之前会阻塞删除容器的操作

- 钩子函数有三种定义方式

- 第一种 exec 执行指令

- 第二种 在容器中请求端口

- 第三种 向容器发起http请求

lifecycle:

postStart:

exec:

command:

- cat

- /etc/hosts

lifecycle:

postStart:

tcpSocket:

port: 8080

lifecycle:

postStart:

httpGet:

path: / # URI地址

port: 80 # 端口号

host: 192.168.75.100 # 主机地址

scheme: HTTP

一个钩子函数的示例

$ cat nginx-lifecycle.yaml

apiVersion: v1

kind: Pod

metadata:

name: nginx-lifecycle

namespace: default

labels:

app: nginx

spec:

containers:

- name: nginx-lifecycle

image: nginx:1.16.1

ports:

- containerPort: 80

protocol: TCP

lifecycle:

postStart:

exec:

command: ["/bin/sh", "-c", "echo '<h1>this is a nginx-lifecycle test page</h1>' > /usr/share/nginx/html/index.html"]

preStop:

exec:

command: ["/usr/sbin/nginx", "-s", "quit"]

$ kubectl apply -f nginx-lifecycle.yaml

pod/pod-lifecycle created

九.容器监控检查及恢复机制

在 k8s 中,可以为 Pod 里的容器定义一个健康检查"探针"(Probe)。kubelet 就会根据这个 Probe 的返回值决定这个容器的状态,而不是直接以容器是否运行(来自 Docker 返回的信息)作为依据。这种机制,是生产环境中保证应用健康存活的重要手段。

9.1 命令模式探针

Kubernetes 文档中的例子:

[root@kub-k8s-master1 ~]# cd prome/

[root@kub-k8s-master prome]# vim test-liveness-exec.yaml

---

apiVersion: v1

kind: Pod

metadata:

labels:

test: liveness

name: test-liveness-exec

spec:

containers:

- name: liveness

image: daocloud.io/library/nginx

args:

- /bin/sh

- -c

- touch /tmp/healthy; sleep 30; rm -rf /tmp/healthy; sleep 50

livenessProbe: #探针,健康检查

exec: #类型

command: #命令

- cat

- /tmp/healthy

initialDelaySeconds: 5 #健康检查,在容器启动5s后开始执行

periodSeconds: 5 #每5s执行一次

它在启动之后做的第一件事是在/tmp目录下创建了一个healthy文件,以此作为自己已经正常运行的标志。而30s过后,它会把这个文件删除掉。

与此同时,定义了一个这样的 livenessProbe(健康检查)。它的类型是 exec,它会在容器启动后,在容器里面执行一句我们指定的命令,比如:"cat /tmp/healthy"。这时,如果这个文件存在,这条命令的返回值就是 0,Pod就会认为这个容器不仅已经启动,而且是健康的。这个健康检查,在容器启动5s后开始执行(initialDelaySeconds: 5),每5s执行一次(periodSeconds: 5)。

创建Pod:

[root@kub-k8s-master prome]# kubectl apply -f test-liveness-exec.yaml

pod/test-liveness-exec created

查看 Pod 的状态:

[root@kub-k8s-master prome]# kubectl get pod

NAME READY STATUS RESTARTS AGE

nginx-configmap 1/1 Running 0 16h

nginx-pod 1/1 Running 0 12h

test-liveness-exec 1/1 Running 0 75s

由于已经通过了健康检查,这个 Pod 就进入了 Running 状态。

然后30 s 之后,再查看一下 Pod 的 Events:

[root@kub-k8s-master prome]# kubectl describe pod test-liveness-exec

发现,这个 Pod 在 Events 报告了一个异常:

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Warning Unhealthy 54s (x9 over 3m34s) kubelet, kub-k8s-node1 Liveness probe failed: cat: /tmp/healthy: No such file or directory

这个健康检查探查到 /tmp/healthy 已经不存在了,所以它报告容器是不健康的。那么接下来会发生什么呢?

再次查看一下这个 Pod 的状态:

[root@kub-k8s-master prome]# kubectl get pod test-liveness-exec

NAME READY STATUS RESTARTS AGE

test-liveness-exec 1/1 Running 4 5m19s

这时发现,Pod 并没有进入 Failed 状态,而是保持了 Running 状态。这是为什么呢?

RESTARTS 字段从 0 到 1 的变化,就明白原因了:这个异常的容器已经被 Kubernetes 重启了。在这个过程中,Pod 保持 Running 状态不变。

#注

k8s 中并没有 Docker 的 Stop 语义。所以如果容器被探针检测到有问题,查看状态虽然看到的是 Restart,但实际却是重新创建了容器。这个功能就是 Kubernetes 里的Pod 恢复机制,也叫 restartPolicy。它是 Pod 的 Spec 部分的一个标准字段(pod.spec.restartPolicy),默认值是 Always,即:任何时候这个容器发生了异常,它一定会被重新创建。

小提示:

Pod 的恢复过程,永远都是发生在当前节点上,而不会跑到别的节点上去。事实上,一旦一个 Pod 与一个节点(Node)绑定,除非这个绑定发生了变化(pod.spec.node 字段被修改),否则它永远都不会离开这个节点。这也就意味着,如果这个宿主机宕机了,这个 Pod 也不会主动迁移到其他节点上去。

9.2 http get方式探针

[root@kub-k8s-master prome]# vim liveness-httpget.yaml

---

apiVersion: v1

kind: Pod

metadata:

name: liveness-httpget-pod

namespace: default

spec:

containers:

- name: liveness-exec-container

image: daocloud.io/library/nginx

imagePullPolicy: IfNotPresent

ports:

- name: http

containerPort: 80

livenessProbe: #探针,健康检查

httpGet:

port: http

path: /index.html

initialDelaySeconds: 1

periodSeconds: 3

创建该pod

[root@kub-k8s-master prome]# kubectl create -f liveness-httpget.yaml

pod/liveness-httpget-pod created

查看当前pod的状态

[root@kub-k8s-master prome]# kubectl describe pod liveness-httpget-pod

...

Liveness: http-get http://:http/index.html delay=1s timeout=1s period=3s #success=1 #failure=3

...

登陆容器

测试将容器内的index.html删除掉

[root@kub-k8s-master prome]# kubectl exec -it liveness-httpget-pod /bin/bash

root@liveness-httpget-pod:/# mv /usr/share/nginx/html/index.html index.html

root@liveness-httpget-pod:/# command terminated with exit code 137

可以看到,当把index.html移走后,这个容器立马就退出了。

此时,查看pod的信息

[root@kub-k8s-master prome]# kubectl describe pod liveness-httpget-pod

...

Normal Killing 49s kubelet, kub-k8s-node2 Container liveness-exec-container failed liveness probe, will be restarted

Normal Pulled 49s kubelet, kub-k8s-node2 Container image "daocloud.io/library/nginx" already present on machine

...

看输出,容器由于健康检查未通过,pod会被杀掉,并重新创建

[root@kub-k8s-master prome]# kubectl get pods

NAME READY STATUS RESTARTS AGE

lifecycle-demo 1/1 Running 1 34h

liveness-httpget-pod 1/1 Running 1 5m42s

#restarts 为 1

重新登陆容器,发现index.html又出现了,证明容器是被重拉了。

[root@kub-k8s-master prome]# kubectl exec -it liveness-httpget-pod /bin/bash

root@liveness-httpget-pod:/# cat /usr/share/nginx/html/index.html

9.3 POD 的恢复策略

Pod 恢复策略:

可以通过设置 restartPolicy,改变 Pod 的恢复策略。一共有3种:

1. Always: 在任何情况下,只要容器不在运行状态,就自动重启容器;

2. OnFailure: 只在容器 异常时才自动重启容器;

3. Never: 从来不重启容器。

实际使用时,需要根据应用运行的特性,合理设置这三种恢复策略。

十.投射数据卷 Projected Volume

注:Projected Volume 是 Kubernetes v1.11 之后的新特性

10.1 什么是Projected Volume

在 k8s 中,有几种特殊的 Volume,它们的意义不是为了存放容器里的数据,"而是为容器提供预先定义好的数据。"

从容器的角度来看,这些 Volume 里的信息仿佛是被 k8s "投射"(Project)进入容器当中的。

10.2 k8s 支持的 Projected Volume 方式

Secret

ConfigMap

Downward API

十一.Secret 实现

11.1 secret 详解

secret用来保存小片敏感数据的k8s资源,例如密码,token,或者秘钥。这类数据当然也可以存放在Pod或者镜像中,但是放在Secret中是为了更方便的控制如何使用数据,并减少暴露的风险。

用户可以创建自己的secret,系统也会有自己的secret。

Pod需要先引用才能使用某个secret

Pod使用secret方式:

作为volume的一个域被一个或多个容器挂载

內建的Secrets:

由ServiceAccount创建的API证书附加的秘钥k8s自动生成的用来访问apiserver的Secret,所有Pod会默认使用这个Secret与apiserver通信

创建自己的Secret:

方式1:使用kubectl create secret命令

方式2:yaml文件创建Secret

11.2 secret 使用

创建Secret

假如某个Pod要访问数据库,需要用户名密码,现在我们分别设置这个用户名和密码

Secret 对象要求这些数据必须是经过 Base64 转码的,以免出现明文密码显示的安全隐患。

创建一个secret.yaml文件,内容用base64编码:明文显示容易被别人发现,这里先转码。

[root@kub-k8s-master1 ~]# echo -n 'admin' | base64

YWRtaW4=

[root@kub-k8s-master1 ~]# echo -n '1f2d1e2e67df' | base64

MWYyZDFlMmU2N2Rm

创建一个secret.yaml文件,内容用base64编码

[root@kub-k8s-master prome]# vim secret.yml

---

apiVersion: v1

kind: Secret

metadata:

name: mysecret

type: Opaque #模糊

data:

username: YWRtaW4=

password: MWYyZDFlMmU2N2Rm

创建:

[root@kub-k8s-master prome]# kubectl apply -f secret.yml

secret/mysecret created

解析Secret中内容,还是经过编码的—需要解码

查看secret

[root@kub-k8s-master1 ~]# kubectl get secrets

NAME TYPE DATA AGE

default-token-7vc82 kubernetes.io/service-account-token 3 30h

mysecret Opaque 2 6s

查看secret详细信息

[root@kub-k8s-master prome]# kubectl get secret mysecret -o yaml

apiVersion: v1

data:

password: MWYyZDFlMmU2N2Rm

username: YWRtaW4=

kind: Secret

metadata:

creationTimestamp: "2019-10-21T03:07:56Z"

name: mysecret

namespace: default

resourceVersion: "162855"

selfLink: /api/v1/namespaces/default/secrets/mysecret

uid: 36bcd07d-92eb-4755-ac0a-a5843ed986dd

type: Opaque

手动base64解码方式:

[root@kub-k8s-master1 ~]# echo 'MWYyZDFlMmU2N2Rm' | base64 --decode

11.3 使用Secret

secret可以作为数据卷挂载或者作为环境变量暴露给Pod中的容器使用,也可以被系统中的其他资源使用。

一个Pod中引用Secret的列子:

创建一个Secret,多个Pod可以引用同一个Secret

修改Pod的定义,在spec.volumes[]加一个volume,给这个volume起个名字,spec.volumes[].secret.secretName记录的是要引用的Secret名字

[root@kub-k8s-master prome]# vim pod_use_secret.yaml

apiVersion: v1

kind: Pod

metadata:

name: mypod

spec:

containers:

- name: testredis

image: daocloud.io/library/redis

volumeMounts: #挂载一个卷

- name: foo #这个名字需要与定义的卷的名字一致

mountPath: "/etc/foo" #挂载到容器里哪个目录下,随便写

readOnly: true

volumes: #数据卷的定义

- name: foo #卷的名字这个名字自定义

secret: #卷是直接使用的secret。

secretName: mysecret #调用刚才定义的secret

创建:

[root@kub-k8s-master prome]# kubectl apply -f pod_use_secret.yaml

pod/mypod created

[root@kub-k8s-master prome]# kubectl exec -it mypod /bin/bash

root@mypod:/data# cd /etc/foo/

root@mypod:/etc/foo# ls

password username

root@mypod:/etc/foo# cat password

1f2d1e2e67df

结果中看到,保存在 Etcd 里的用户名和密码信息,已经以文件的形式出现在了容器的 Volume 目录里。

而这个文件的名字,就是 kubectl create secret 指定的 Key,或者说是 Secret 对象的 data 字段指定的 Key。

每一个被引用的Secret都要在spec.volumes中定义

如果Pod中的多个容器都要引用这个Secret那么每一个容器定义中都要指定自己的volumeMounts,但是Pod定义中声明一次spec.volumes就好了。

映射secret key到指定的路径

可以控制secret key被映射到容器内的路径,利用spec.volumes[].secret.items来修改被映射的具体路径

[root@kub-k8s-master prome]# kubectl delete -f pod_use_secret.yaml

pod "mypod" deleted

[root@kub-k8s-master prome]# vim pod_use_secret.yaml

---

apiVersion: v1

kind: Pod

metadata:

name: mypod

spec:

containers:

- name: testredis

image: daocloud.io/library/redis

volumeMounts:

- name: foo

mountPath: "/etc/foo"

readOnly: true

volumes:

- name: foo

secret:

secretName: mysecret

items: #定义一个items

- key: username #将那个key重新定义到那个目录下

path: my-group/my-username #相对路径,相对于/etc/foo的路径

2.创建

[root@kub-k8s-master prome]# kubectl apply -f pod_use_secret.yaml

pod/mypod created

3.从volume中读取secret的值

[root@kub-k8s-master prome]# kubectl exec -it mypod /bin/bash

root@mypod:/data# cd /etc/foo/my-group

root@mypod:/etc/foo/my-group# ls

my-username

root@mypod:/etc/foo/my-group# cat my-username

admin

root@mypod:/etc/foo/my-group#

username被映射到了文件/etc/foo/my-group/my-username而不是/etc/foo/username,而password没有被使用,这种方式每个key的调用需要单独用key像username一样调用

被挂载的secret内容自动更新

也就是如果修改一个Secret的内容,那么挂载了该Secret的容器中也将会取到更新后的值,但是这个时间间隔是由kubelet的同步时间决定的。

1.设置base64加密

[root@kub-k8s-master prome]# echo qianfeng | base64

cWlhbmZlbmcK

2.将admin替换成qianfeng

[root@kub-k8s-master prome]# vim secret.yml

---

apiVersion: v1

kind: Secret

metadata:

name: mysecret

type: Opaque

data:

username: cWlhbmZlbmcK #修改为qianfeng的base64加密后的

password: MWYyZDFlMmU2N2Rm

1.创建

[root@kub-k8s-master prome]# kubectl apply -f secret.yml

Warning: kubectl apply should be used on resource created by either kubectl create --save-config or kubectl apply

secret/mysecret configured

2.连接pod容器

[root@kub-k8s-master prome]# kubectl exec -it mypod /bin/bash

root@mypod:/data# cd /etc/foo/my-group

root@mypod:/etc/foo/my-group# ls

my-username

root@mypod:/etc/foo/my-group# cat my-username

qianfeng

以环境变量的形式使用Secret

[root@kub-k8s-master prome]# kubectl delete -f pod_use_secret.yaml

pod "mypod" deleted

[root@kub-k8s-master prome]# vim pod_use_secret.yaml

---

apiVersion: v1

kind: Pod

metadata:

name: mypod

spec:

containers:

- name: testredis

image: daocloud.io/library/redis

env: #定义环境变量

- name: SECRET_USERNAME #创建新的环境变量名称

valueFrom:

secretKeyRef: #调用的key是什么

name: mysecret #变量的值来自于mysecret

key: username #username里面的值

2.创建使用secret的pod容器

[root@kub-k8s-master prome]# kubectl apply -f pod_use_secret.yaml

pod/mypod created

3.连接

[root@kub-k8s-master prome]# kubectl exec -it mypod /bin/bash

root@mypod:/data# echo $SECRET_USERNAME #打印一下定义的变量

qianfeng

11.4 实战案例

1.创建数据库用户的密码secret

[root@kub-k8s-master test]# echo -n 'QianFeng@123!' | base64

UWlhbkZlbmdAMTIzIQ==

[root@kub-k8s-master test]# cat secret.yml

apiVersion: v1

kind: Secret

metadata:

name: mysql-secret

type: Opaque

data:

password: UWlhbkZlbmdAMTIzIQ==

[root@kub-k8s-master test]# kubectl apply -f secret.yml

2.创建数据库并使用secret

[root@kub-k8s-master test]# cat mysql.yaml

apiVersion: v1

kind: Pod

metadata:

name: my-mysql

spec:

containers:

- name: mysql

image: daocloud.io/library/mysql:5.7

ports:

- containerPort: 3306

env:

- name: MYSQL_ROOT_PASSWORD

valueFrom:

secretKeyRef:

name: mysql-secret

key: password

[root@kub-k8s-master test]# kubectl apply -f myslq.yaml

[root@kub-k8s-master test]# kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

my-mysql 1/1 Running 0 2m47s 10.244.2.13 node2 <none> <none>

测试:

[root@kub-k8s-master test]# mysql -uroot -p'QianFeng@123!' -h 10.244.2.13 -P3306

十二.ConfigMap祥解

ConfigMap与 Secret 类似,用来存储配置文件的kubernetes资源对象,所有的配置内容都存储在etcd中。

与 Secret 的区别:

ConfigMap 保存的是不需要加密的、应用所需的配置信息。

ConfigMap 的用法几乎与 Secret 完全相同:可以使用 kubectl create configmap 从文件或者目录创建 ConfigMap,也可以直接编写 ConfigMap 对象的 YAML 文件。

12.1 创建ConfigMap的方式

创建ConfigMap的方式有4种:

命令行方式

方式1:通过直接在命令行中指定configmap参数创建,即--from-literal

方式2:通过指定文件创建,即将一个配置文件创建为一个ConfigMap,--from-file=<文件>

方式3:通过指定目录创建,即将一个目录下的所有配置文件创建为一个ConfigMap,--from-file=<目录>

配置文件方式

方式4:事先写好标准的configmap的yaml文件,然后kubectl create -f 创建

12.2 通过命令行参数创建

创建命令:

[root@kub-k8s-master prome]# kubectl create configmap test-configmap --from-literal=user=admin --from-literal=pass=1122334

configmap/test-configmap created

结果如下面的data内容所示:

[root@kub-k8s-master prome]# kubectl get configmap test-configmap -o yaml

apiVersion: v1

data:

pass: "1122334"

user: admin

kind: ConfigMap

metadata:

creationTimestamp: "2019-10-21T07:48:15Z"

name: test-configmap

namespace: default

resourceVersion: "187590"

selfLink: /api/v1/namespaces/default/configmaps/test-configmap

uid: 62a8a0d0-fab9-4159-86f4-a06aa213f4b1

12.3 通过指定文件创建

编辑文件server.conf内容如下:

[root@kub-k8s-master prome]# vim server.conf

server {

listen 80;

server_name localhost;

location / {

root /var/www/html;

index index.html index.htm;

}

}

创建(可以有多个–from-file):

[root@kub-k8s-master prome]# kubectl create configmap test-config2 --from-file=server.conf

configmap/test-config2 created

结果如下面data内容所示:

[root@kub-k8s-master prome]# kubectl get configmap test-config2 -o yaml

apiVersion: v1

data:

server.conf: |

server {

listen 80;

server_name localhost;

localtion / {

root /var/www/html;

index index.html index.htm;

}

}

kind: ConfigMap

metadata:

creationTimestamp: "2019-10-21T08:01:43Z"

name: test-config2

namespace: default

resourceVersion: "188765"

selfLink: /api/v1/namespaces/default/configmaps/test-config2

uid: 790fca12-3900-4bf3-a017-5af1070792e5

通过指定文件创建时,configmap会创建一个key/value对,key是文件名,value是文件内容。

12.4 指定目录创建

configs 目录下的config-1和config-2内容如下所示:

[root@kub-k8s-master prome]# mkdir config

[root@kub-k8s-master prome]# cd config/

[root@kub-k8s-master config]# vim config1

aaa

bbb

c=d

[root@kub-k8s-master config]# vim config2

eee

fff

h=k

创建:

[root@kub-k8s-master config]# cd ..

[root@kub-k8s-master prome]# kubectl create configmap test-config3 --from-file=./config

configmap/test-config3 created

结果下面data内容所示:

[root@kub-k8s-master prome]# kubectl get configmap test-config3 -o yaml

apiVersion: v1

data:

config1: |

aaa

bbb

c=d

config2: |

eee

fff

h=k

kind: ConfigMap

metadata:

creationTimestamp: "2019-10-21T08:20:42Z"

name: test-config3

namespace: default

resourceVersion: "190420"

selfLink: /api/v1/namespaces/default/configmaps/test-config3

uid: 6e00fded-80a8-4297-aeb3-4c48795e6eb9

指定目录创建时,configmap内容中的各个文件会创建一个key/value对,key是文件名,value是文件内容。

12.5 通过yaml文件创建

yaml文件内容如下: 注意其中一个key的value有多行内容时的写法

[root@kub-k8s-master prome]# vim configmap.yaml

---

apiVersion: v1

kind: ConfigMap

metadata:

name: test-config4

namespace: default

data:

cache_host: memcached-gcxt

cache_port: "11211"

cache_prefix: gcxt

my.cnf: |

[mysqld]

log-bin = mysql-bin

haha = hehe

创建:

[root@kub-k8s-master prome]# kubectl apply -f configmap.yaml

configmap/test-config4 created

结果如下面data内容所示:

[root@kub-k8s-master prome]# kubectl get configmap test-config4 -o yaml

apiVersion: v1

data:

cache_host: memcached-gcxt

cache_port: "11211"

cache_prefix: gcxt

my.cnf: |

[mysqld]

log-bin = mysql-bin

haha = hehe

kind: ConfigMap

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: |

{"apiVersion":"v1","data":{"cache_host":"memcached-gcxt","cache_port":"11211","cache_prefix":"gcxt","my.cnf":"[mysqld]\nlog-bin = mysql-bin\nhaha = hehe\n"},"kind":"ConfigMap","metadata":{"annotations":{},"name":"test-config4","namespace":"default"}}

creationTimestamp: "2019-10-21T08:30:24Z"

name: test-config4

namespace: default

resourceVersion: "191270"

selfLink: /api/v1/namespaces/default/configmaps/test-config4

uid: 2a8cd6e7-db2c-4781-b005-e0b76d26394b

查看configmap的详细信息:

# kubectl describe configmap

12.6 使用ConfigMap

使用ConfigMap的方式,一种是通过环境变量的方式,直接传递pod,另一种是使用volume的方式挂载入到pod内

示例ConfigMap文件:

[root@kub-k8s-master prome]# vim config-map.yml

---

apiVersion: v1

kind: ConfigMap

metadata:

name: config-map

namespace: default

data:

special.how: very

special.type: charm

创建

[root@kub-k8s-master prome]# kubectl apply -f config-map.yml

configmap/config-map created

12.6.1 通过变量使用

(1) 使用valueFrom、configMapKeyRef、name、key指定要用的key:

1.设置指定变量的方式

[root@kub-k8s-master prome]# vim testpod.yml

---

apiVersion: v1

kind: Pod

metadata:

name: dapi-test-pod

spec:

containers:

- name: test-container

image: daocloud.io/library/nginx

env: #专门在容器里面设置变量的关键字

- name: SPECIAL_LEVEL_KEY #这里的-name,是容器里设置的新变量的名字

valueFrom:

configMapKeyRef:

name: config-map #这里是来源于哪个configMap

key: special.how #configMap里的key

- name: SPECIAL_TYPE_KEY

valueFrom:

configMapKeyRef:

name: config-map

key: special.type

restartPolicy: Never

创建pod

[root@kub-k8s-master prome]# kubectl apply -f testpod.yml

pod/dapi-test-pod created

测试:

[root@kub-k8s-master prome]# kubectl exec -it dapi-test-pod /bin/bash