数据清洗是数据处理的重要环节,其目的是通过一系列方法和工具去除数据中的错误、重复、缺失值等“脏数据”,从而提高数据的质量和可靠性。以下是关于数据清洗流程、方法及工具的详细介绍:

一、数据清洗流程

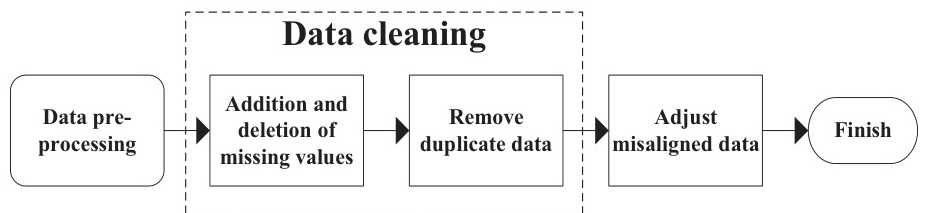

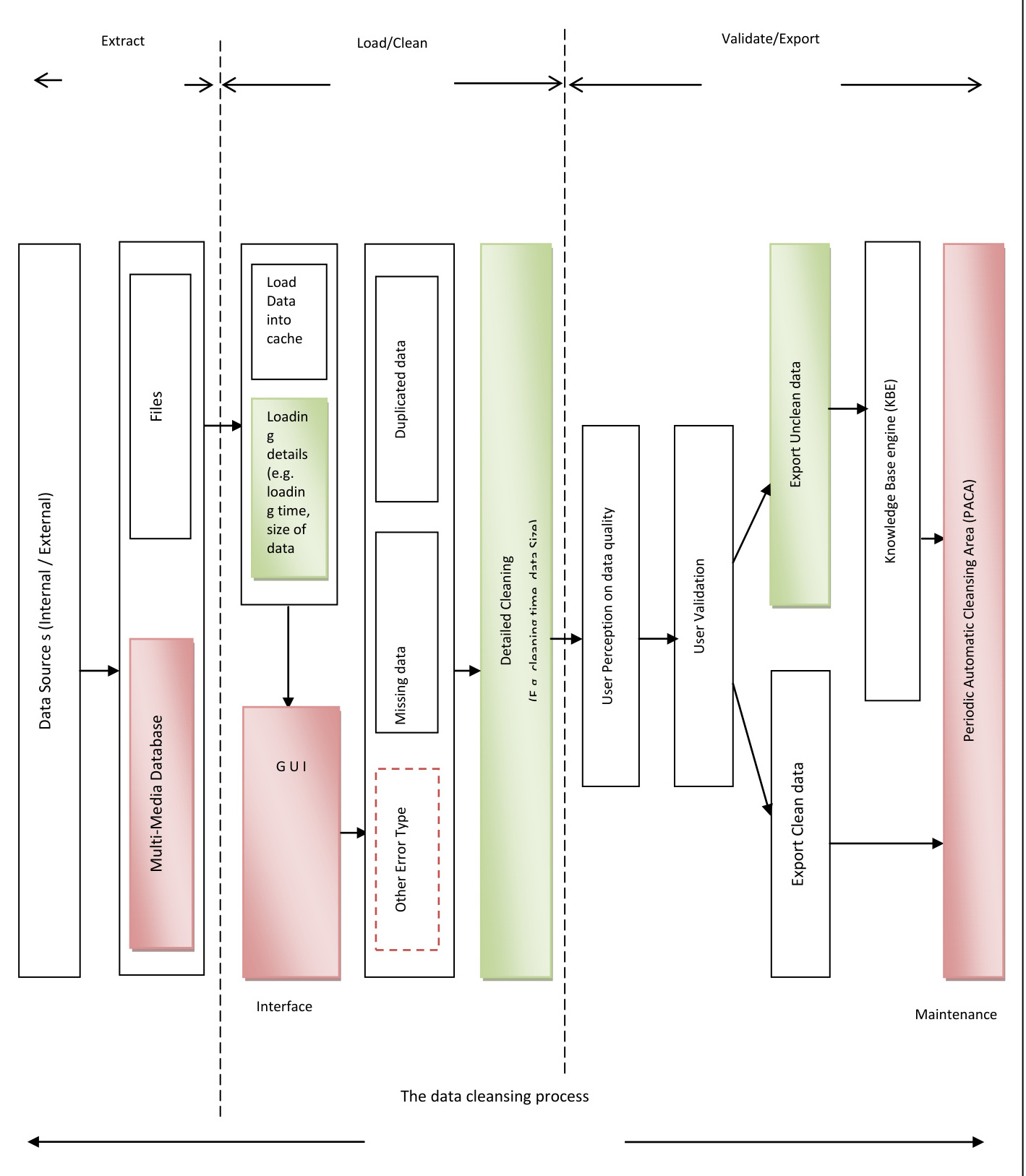

数据清洗通常包括以下几个关键步骤:

-

数据预处理:

- 数据抽取:从原始数据源中提取所需的数据,可能涉及全量抽取或增量抽取。

- 数据过滤:初步筛选数据,去除无效或不符合规则的数据。

- 数据转换:对数据进行格式化、标准化处理,例如日期格式转换、数据类型转换等。

- 数据加载:将清洗后的数据加载到目标系统或存储中。

-

清洗规则的应用:

-

缺失值处理:根据缺失值的比例和重要性,采用估算(如均值、中位数填充)、整例删除或成对删除等策略。

-

错误检测与修正:识别并纠正数据中的错误值,例如拼写错误、格式不一致等。

-

重复数据处理:删除重复记录,保留唯一性。

-

逻辑一致性检查:确保数据在逻辑上的一致性,例如检查主键重复、非法值等。

-

-

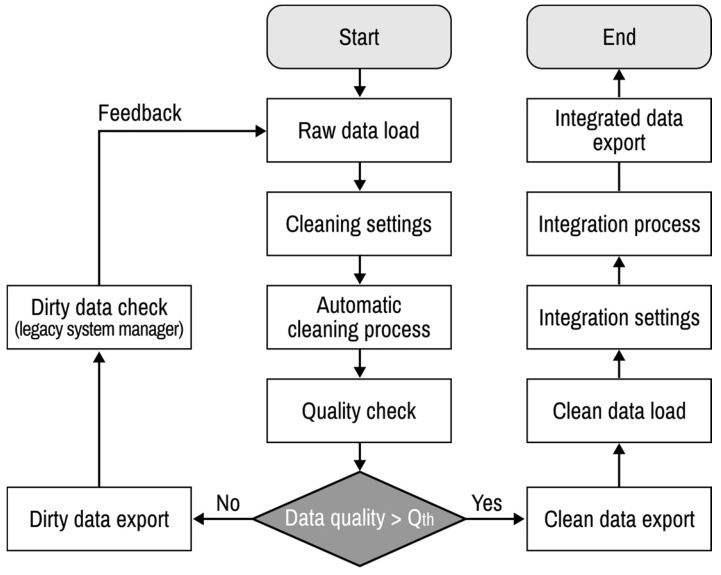

质量评估与验证:

- 清洗后需对数据质量进行评估,确保清洗目标达成,并通过用户反馈或自动化工具验证清洗结果。

- 清洗后需对数据质量进行评估,确保清洗目标达成,并通过用户反馈或自动化工具验证清洗结果。

-

持续监控与优化:

- 定期检查数据质量,发现新的问题并进行调整。

二、数据清洗的方法

数据清洗的方法多种多样,具体选择取决于清洗目标和业务需求:

-

缺失值处理:

- 使用统计方法(如均值、中位数、众数)填充缺失值。

- 删除含有缺失值的记录(适用于缺失比例较低的情况)。

-

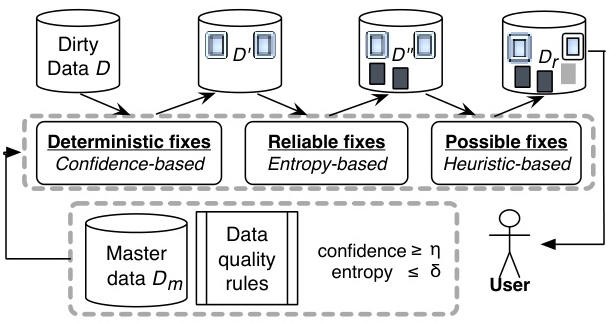

错误检测与修正:

-

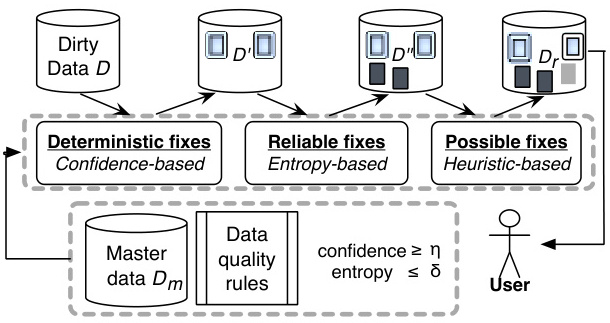

确定性修复:基于置信度的方法自动修正明显错误。

-

可靠修复:使用熵方法修正错误。

-

可能修复:启发式方法修正模糊错误。

-

-

重复数据处理:

- 比较记录间的相似性,删除重复项。

-

逻辑一致性检查:

- 检查主键重复、非法值、数据范围是否合理。

-

数据标准化与转换:

- 格式化日期、统一单位、归一化数值等。

-

异常值处理:

- 使用统计方法(如四分位距法、Z-Score)识别并处理异常值。

-

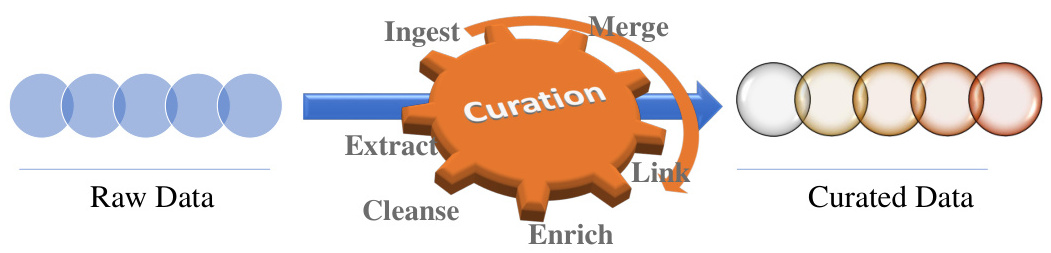

数据集成:

- 将多个来源的数据合并,解决不一致性问题。

- 将多个来源的数据合并,解决不一致性问题。

三、数据清洗工具

市面上有许多工具可用于数据清洗,它们可以手动操作或自动化完成任务:

-

开源工具:

- OpenRefine:强大的数据清洗工具,支持批量处理和交互式操作。

- Data Wrangler:可视化工具,适合非技术用户。

- Talend Data Ladder:支持复杂的数据清洗任务。

-

编程语言与库:

- Python:利用Pandas库进行数据清洗,支持缺失值处理、去重、标准化等功能。

- R语言:通过dplyr等包实现高效的数据清洗。

-

商业工具:

- SAP Data Cleanse:提供数据质量统计报告和分析选项。

- Tableau Prep:专注于交互式数据准备。

-

专利技术:

- 北京三维天地科技有限公司开发了一种支持自定义清洗流程的可视化方法。

四、案例分析

以下是一

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1371

1371

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?