如果是我的个人主页那种自己搭建服务器啥的,反正就是不用登录的也就是没有任何安全防范的网站,我们用之前一中的例子即可,如果要爬csdn这种网站,我们必须模拟成模拟器登录。

先介绍一个工具吧,pycharm 官网

下载pycharm,然后这里面就会方便很多,而且会有很多包。

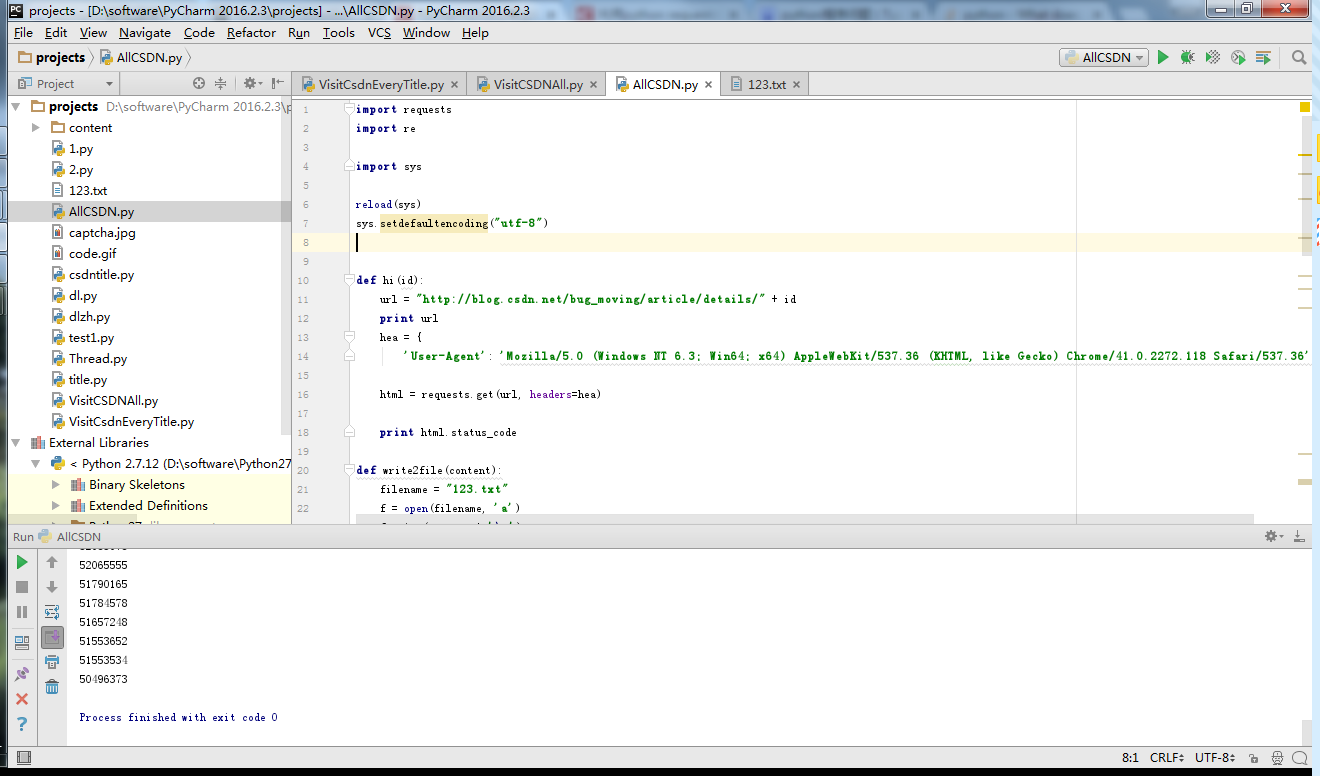

pycharm大致界面如下

直接上代码。

import requests

import re

import sys

reload(sys)

sys.setdefaultencoding("utf-8")

def hi(id):

url = "http://blog.csdn.net/bug_moving/article/details/" + id

print url

hea = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2272.118 Safari/537.36'}

html = requests.get(url, headers=hea)

print html.status_code

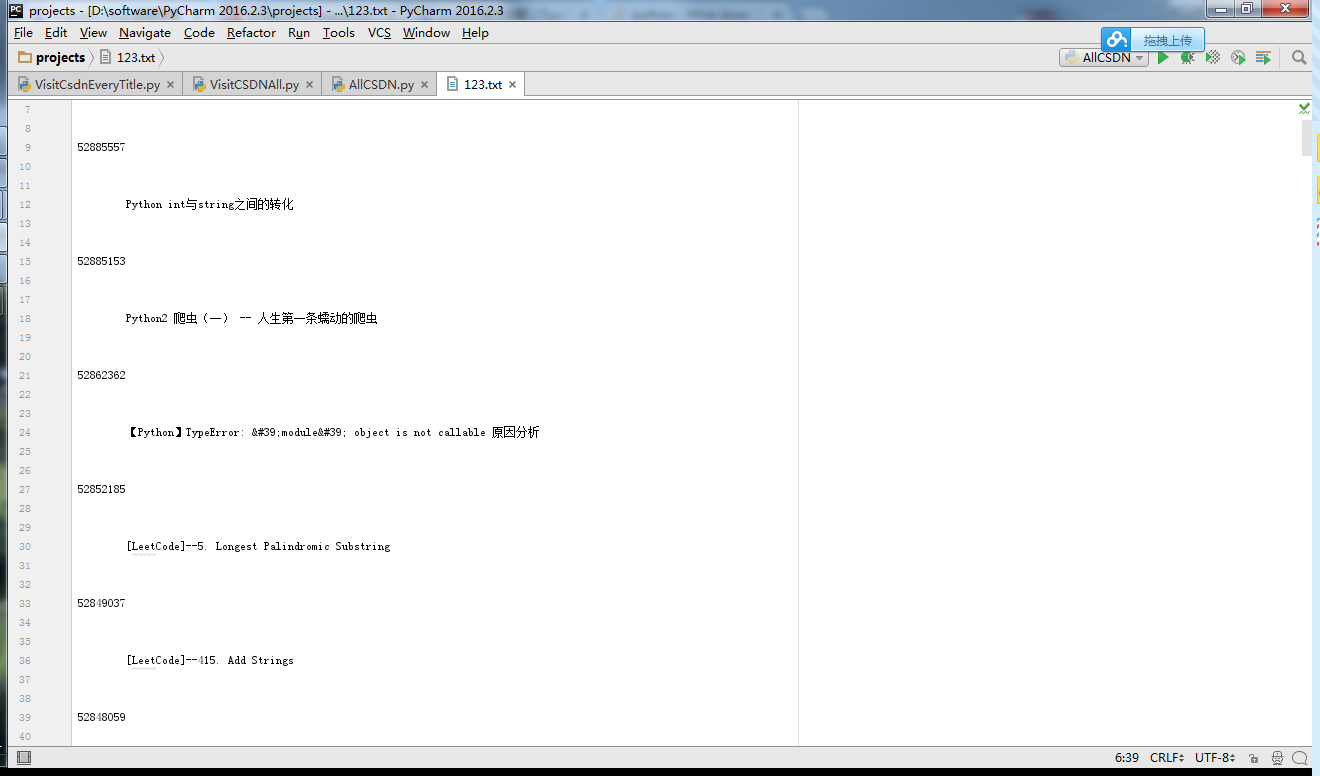

def write2file(content):

filename = "123.txt"

f = open(filename, 'a')

f.write(content + '\n')

f.close()

def visit(urlnum):

hea = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2272.118 Safari/537.36'}

url = 'http://blog.csdn.net/bug_moving/article/list/' + str(urlnum)

#url = 'http://blog.csdn.net/bug_moving'

# url = 'http://jp.tingroom.com/yuedu/yd300p/'

html = requests.get(url, headers=hea)

html.encoding = 'utf-8'

title = re.findall('<a href="/bug_moving/article/details/([0-9]*?)">', html.text, re.S)

for each in title:

print each

write2file(each)

name = re.findall('<a href="/bug_moving/article/details/'+each+'">(.*?)</a>', html.text, re.S)

for na in name:

write2file(na)

def loopvisit(f, n): # f repeats n times

if n > 11:

return

else:

f(n)

loopvisit(f, n + 1)

loopvisit(visit,1)所有博文的id,题目都在此了,如果需要其他的信息我相信大家应该都会了吧。

2687

2687

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?