以下内容来自Datewhale的学习笔记

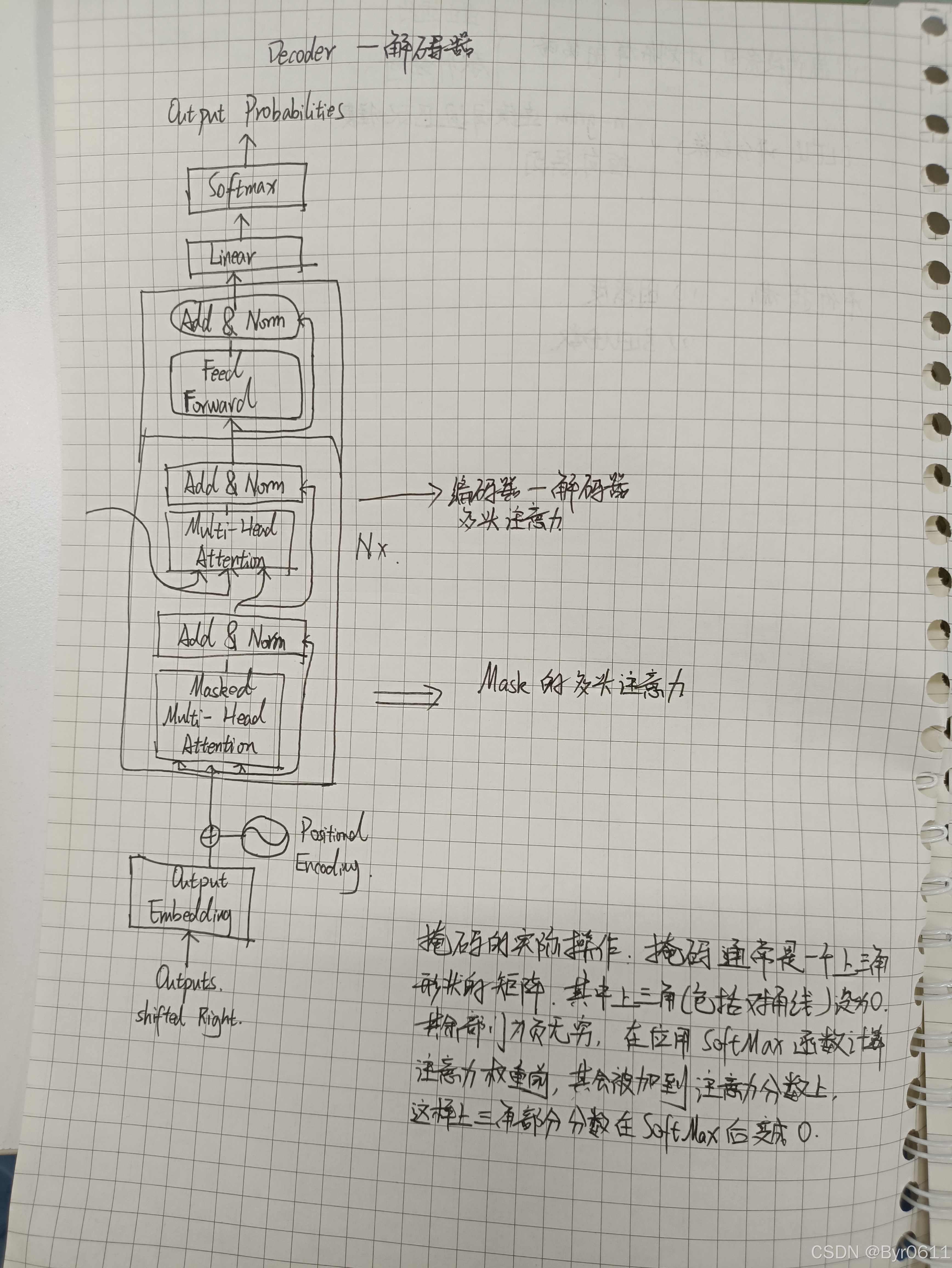

在神经网络中,Decoder(解码器)是一个重要的组件,通常与 **Encoder(编码器)** 配合使用,用于处理序列到序列(Seq2Seq)任务,如机器翻译、文本生成、语音识别等。Decoder 的核心作用是将编码器生成的中间表示(通常是上下文向量或隐藏状态)解码为目标序列。

1. Decoder 的作用

Decoder 的主要任务是将编码器生成的抽象表示(通常是高维向量或隐藏状态)转换回目标数据形式(如文本、图像等)。它通过逐步生成输出序列的每个元素来完成这一任务。

输入:编码器的输出(上下文向量或隐藏状态)以及前一步的输出(如上一个生成的词)。

输出:目标序列(如翻译后的句子、生成的文本等)。

2. Decoder 的结构

Decoder 的结构通常包括以下几个部分:

2.1 核心组件

RNN/LSTM/GRU:Decoder 通常基于循环神经网络(RNN)或其变体(如 LSTM 或 GRU),用于逐步生成输出序列。

Attention 机制:现代 Decoder 通常结合 Attention 机制,动态关注编码器的不同部分,从而更好地处理长序列。

全连接层(Linear Layer):用于将隐藏状态映射到目标词汇表的概率分布。

2.2 工作流程

1. 初始状态:Decoder 的初始状态通常由编码器的最后隐藏状态初始化。

2. 逐步生成:

- 每一步接收前一步的输出(如生成的词)和当前隐藏状态。

- 通过 RNN/LSTM/GRU 计算当前隐藏状态。

- 使用全连接层将隐藏状态映射到目标词汇表的概率分布。

- 根据概率分布选择下一个词(如通过贪心搜索或 Beam Search)。

3. 终止条件:生成结束符号(如 `<EOS>`)时停止。

3. Decoder 的应用场景

Decoder 广泛应用于以下任务:

机器翻译:将源语言句子解码为目标语言句子。

文本生成:根据上下文生成连贯的文本。

语音识别:将语音特征解码为文本。

图像描述生成:将图像特征解码为描述文本。

4. Decoder 的代码示例

以下是一个简单的基于 PyTorch 的 Decoder 实现:

```python

import torch

import torch.nn as nn

class Decoder(nn.Module):

def __init__(self, output_dim, emb_dim, hid_dim, n_layers, dropout):

super().__init__()

self.output_dim = output_dim # 目标词汇表大小

self.hid_dim = hid_dim # 隐藏层维度

self.n_layers = n_layers # RNN 层数

# 词嵌入层

self.embedding = nn.Embedding(output_dim, emb_dim)

# RNN 层(这里使用 GRU)

self.rnn = nn.GRU(emb_dim, hid_dim, n_layers, dropout=dropout)

# 全连接层,将隐藏状态映射到词汇表

self.fc_out = nn.Linear(hid_dim, output_dim)

# Dropout 层

self.dropout = nn.Dropout(dropout)

def forward(self, input, hidden):

# input: [batch_size]

# hidden: [n_layers, batch_size, hid_dim]

# 将输入扩展为 [1, batch_size]

input = input.unsqueeze(0)

# 词嵌入 [1, batch_size, emb_dim]

embedded = self.dropout(self.embedding(input))

# RNN 计算 [1, batch_size, hid_dim]

output, hidden = self.rnn(embedded, hidden)

# 全连接层映射到词汇表 [batch_size, output_dim]

prediction = self.fc_out(output.squeeze(0))

return prediction, hidden

```5. Decoder 的优化技巧

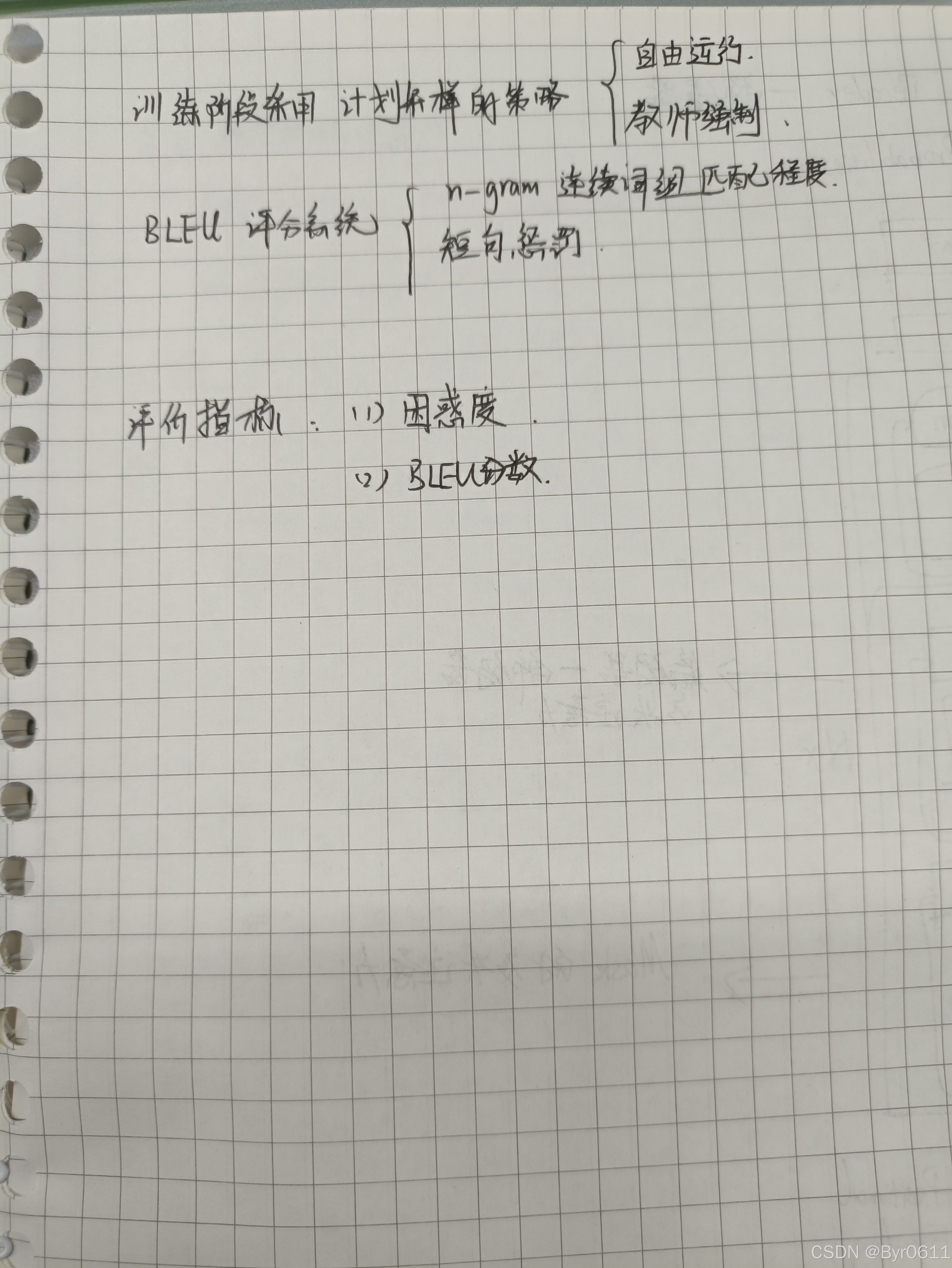

Attention 机制:通过 Attention 动态关注编码器的不同部分,提升长序列生成效果。

Beam Search:在生成过程中保留多个候选序列,避免贪心搜索的局部最优问题。

Teacher Forcing:在训练时使用真实标签作为下一步的输入,加速模型收敛。

6. 总结

Decoder 是序列生成任务中的核心组件,通过与 Encoder 配合,能够将抽象表示解码为目标序列。理解 Decoder 的结构和工作原理,对于掌握 Seq2Seq 模型至关重要。希望本文能帮助你更好地理解 Decoder 的作用和实现方式!

参考资料

- [PyTorch 官方文档](https://pytorch.org/docs/stable/nn.html)

- 《深度学习》(花书)

- Seq2Seq 模型论文:[Sequence to Sequence Learning with Neural Networks](https://arxiv.org/abs/1409.3215)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?