端侧 ChatGPT 时刻到来!

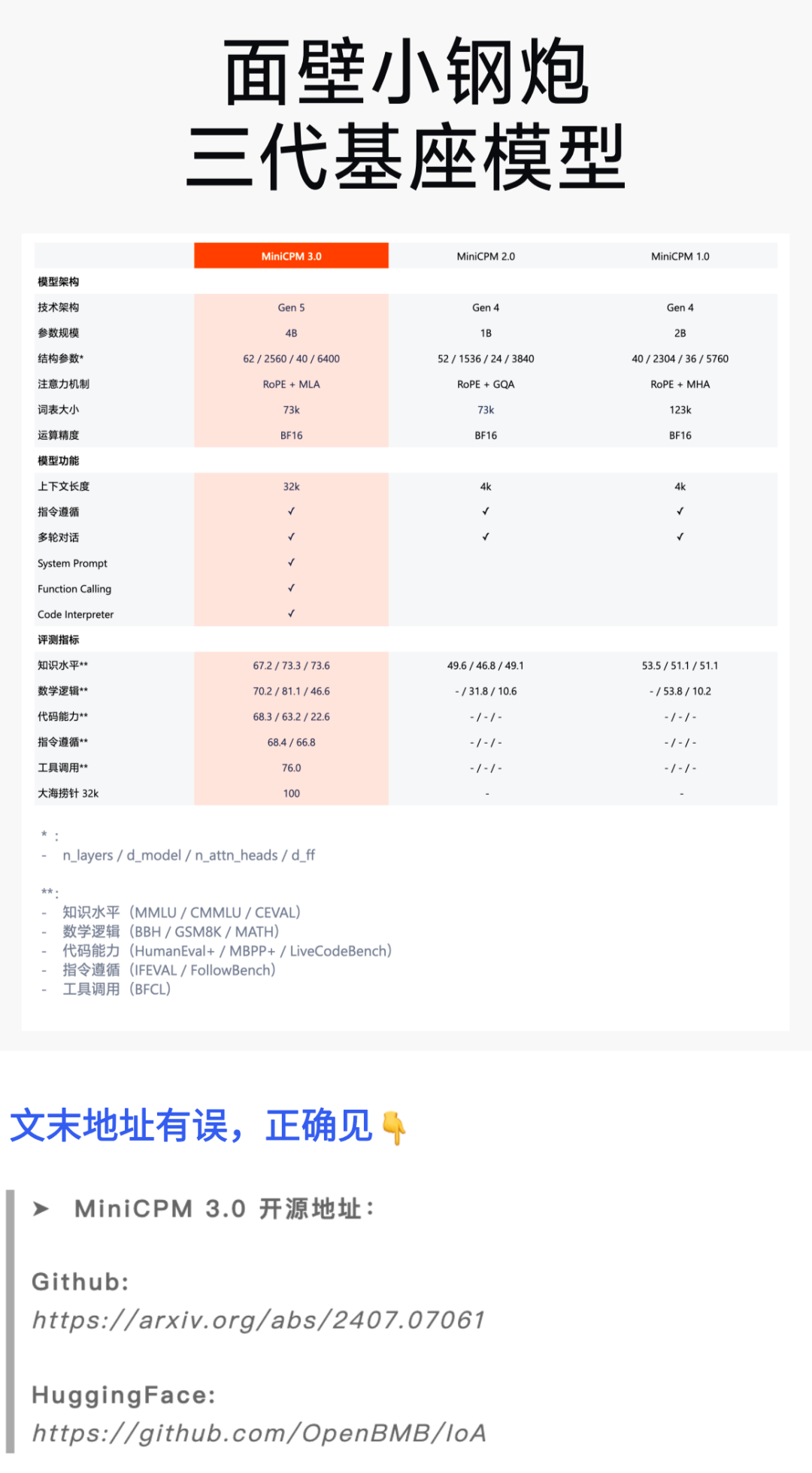

旗舰端侧模型面壁「小刚炮」系列进化为全新 MiniCPM 3.0 基座模型,再次以小博大,以 4B 参数,带来超越 GPT-3.5 的性能,强得不像端侧模型。并且,量化后仅 2GB 内存,端侧友好。

这还是一款瑞士军刀般全面开挂的基座模型,一口气带来:

无限长文本,榜单性能超越 Kimi,超长文本也不崩;

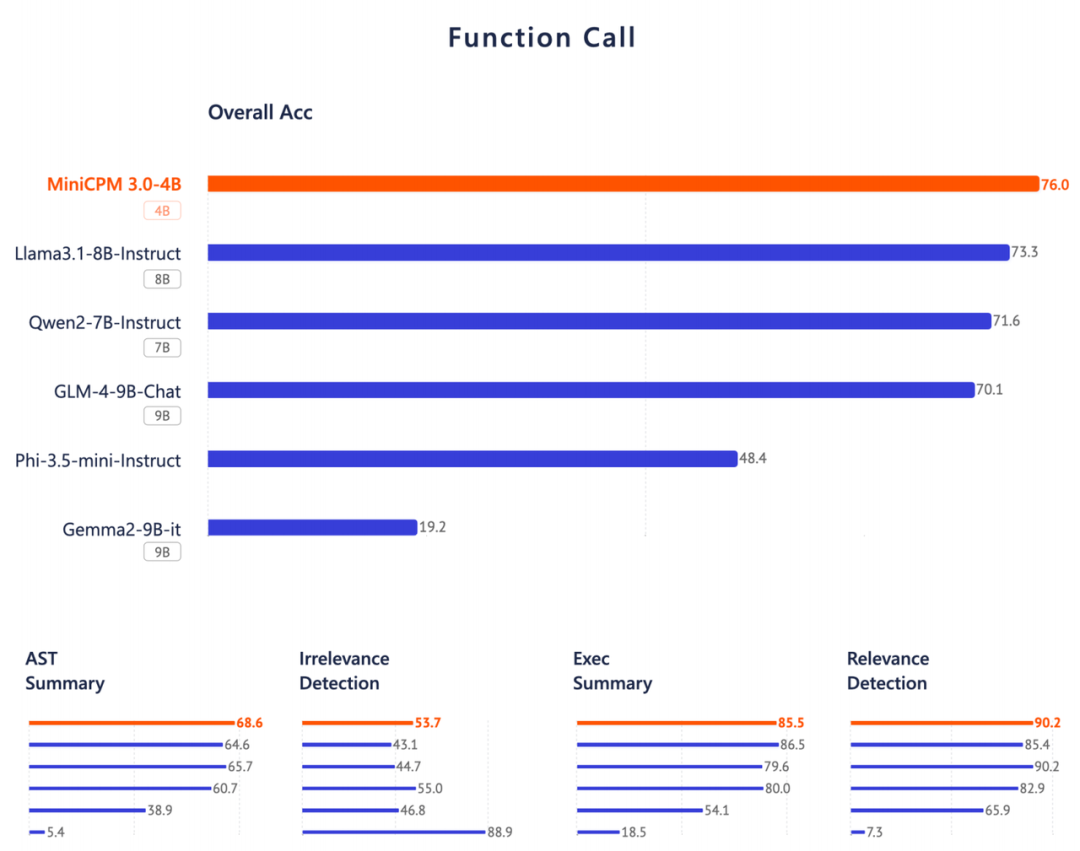

性能比肩 GPT-4o 的端侧最强 Function Calling;

超强 RAG 外挂三件套,中文检索第一、生成超 Llama3-8B。

➤ MiniCPM 3.0 【此处地址有误】

Github:

https://arxiv.org/abs/2407.07061

HuggingFace:

https://github.com/OpenBMB/IoA

让「GPT-3.5 」在端侧跑起来!

提前近 4 个月,面壁智能实现了初代面壁小钢炮发布时立下的 Flag:今年内让 GPT-3.5 水平的模型在端侧跑起来!

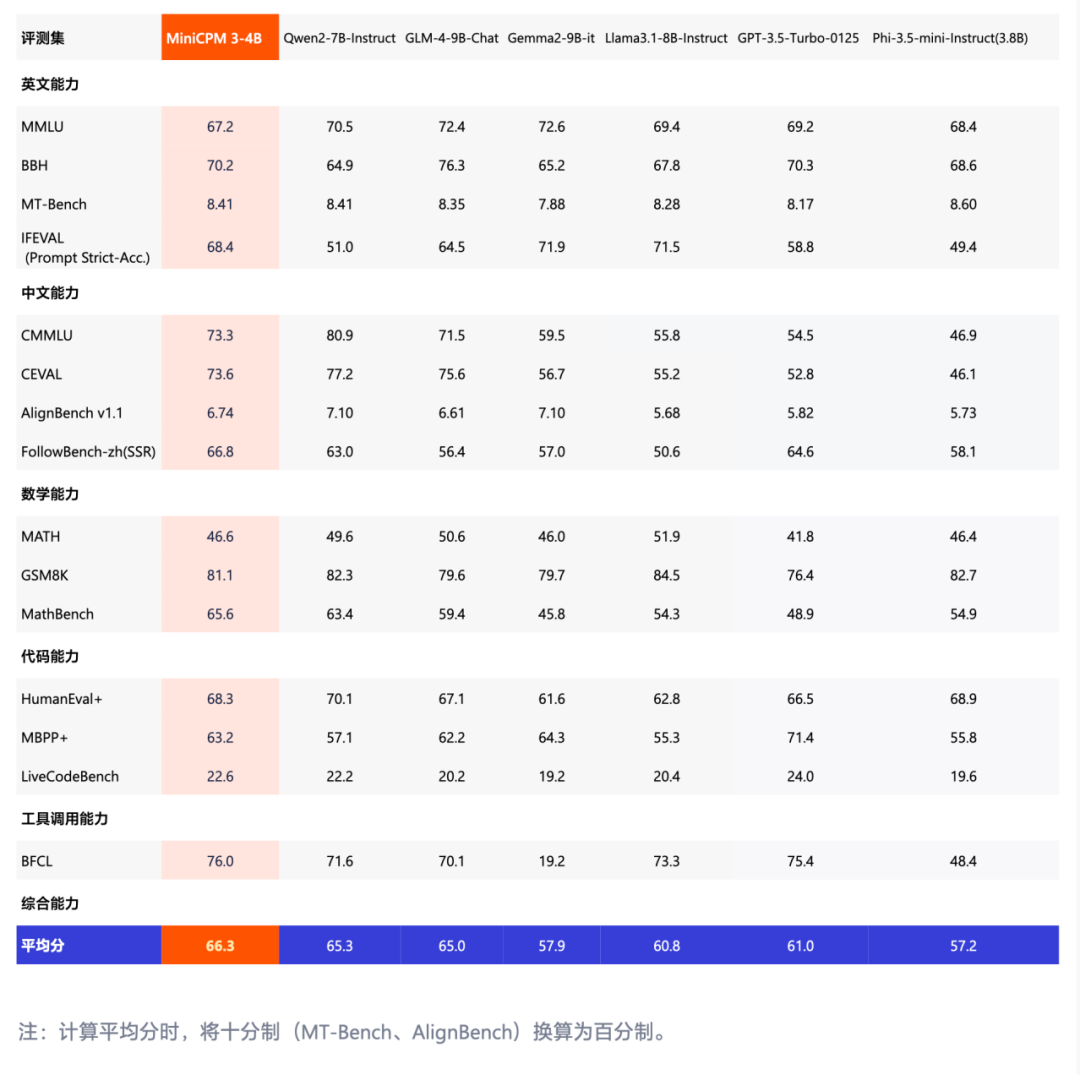

MiniCPM 3.0 再次挖掘端侧模型的极致性能,仅 4B 参数,在包括自然语言理解、知识、代码、数学等多项能力上对 GPT-3.5 实现赶超,在 Qwen2-7B、 Phi-3.5、GLM4-9B、LLaMa3-8B 等一众中外知名模型脱颖而出。

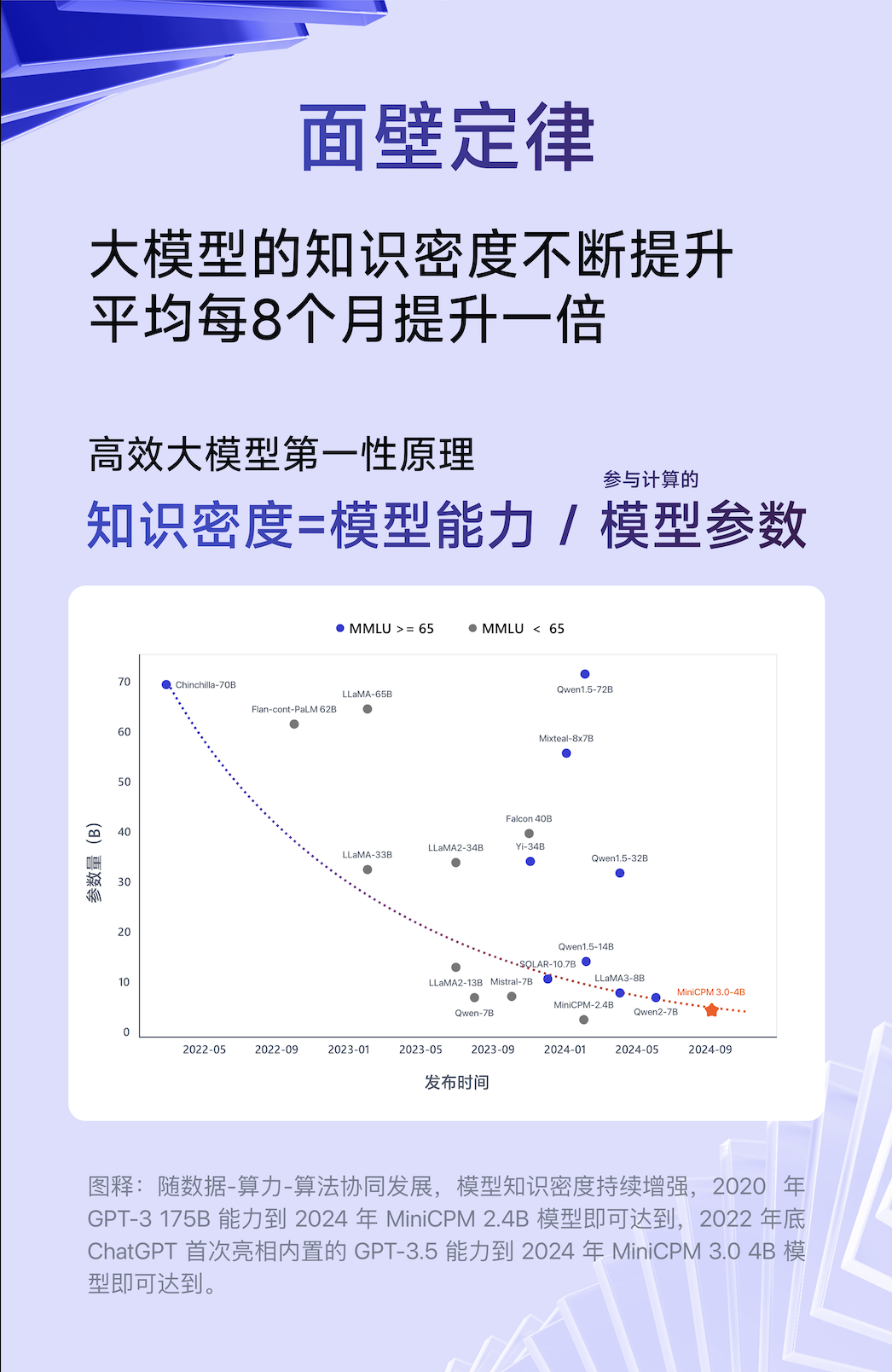

在面壁高效构建大模型的科学化方法论的指导下,每一代面壁小钢炮基座模型的发布,都以小博大,超预期的高效与强悍,向业界吹响端侧模型的性能最强音。这次也不例外——历经数次调整,面壁智能构建了全新技术架构,于面壁定律的趋势曲线再落一子。

超预期的高效与强悍来自哪里?我们紧紧围绕 Scaling Law 的核心,将提升知识密度视为高效大模型的第一性原理(知识密度 =模型能力/参与计算的模型参数),并且提出了大模型时代的「摩尔定律」:模型知识密度不断提升,平均每 8 个月提升一倍,称之为「面壁定律」。

顶尖实力大集结,大模型中的“瑞士军刀”

新一代小钢炮集长文本、Function Call 与 RAG 等大模型重要能力于一身,小而强,小而全。仅 4B 体量,在这些呼声极高的模型功能上,MiniCPM 3.0 集结各家所长,并且对业界颇有口碑的模型实现超越,堪称是大模型中的“瑞士军刀”。

面壁「无限」长文本,性能超 Kimi:长长长文本不崩!

上下文长度是衡量大模型基础能力的一项重要指标,更长的上下文长度意味大模型拥有更大的“内存”和更长的“记忆”,不仅能提高大模型处理数据的能力上限,还能拓宽大模型应用的广度和深度。

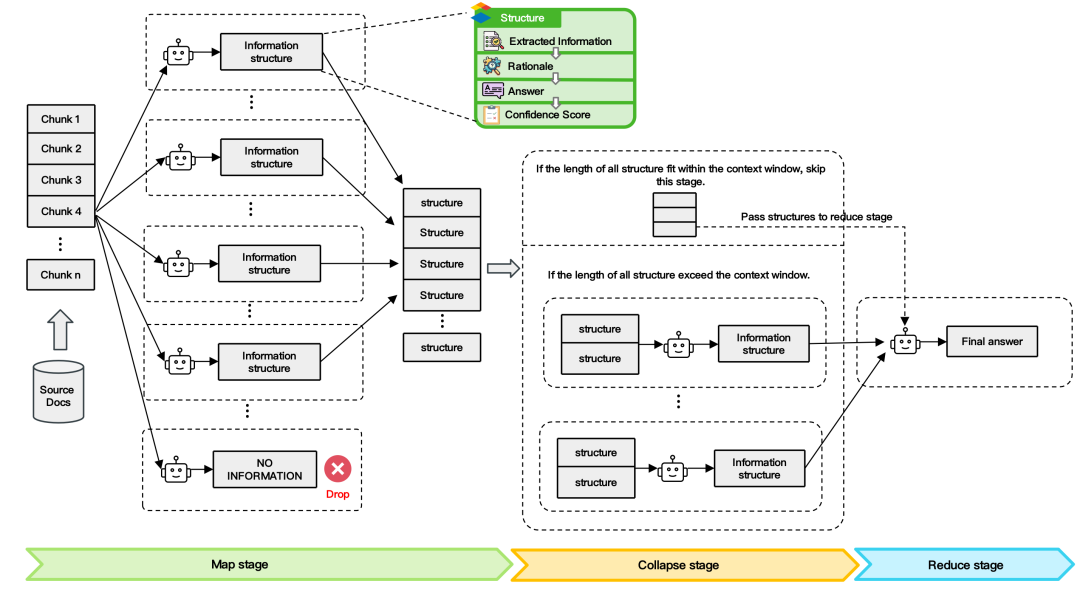

面壁提出 LLMxMapReduce长本文分帧处理技术,一举实现「无限」长文本!32, 128, 256, 512K…MiniCPM 3.0 打破大模型记忆限制,可以将上下文长度无限稳定拓展,想多长就多长!

除了超越 GPT-4、KimiChat 等标杆模型的优异表现( InfiniteBench 榜单成绩);更神奇的是,文本越长,这个4B小钢炮凭借愈加稳定的表现,展现出的性能优势越强。

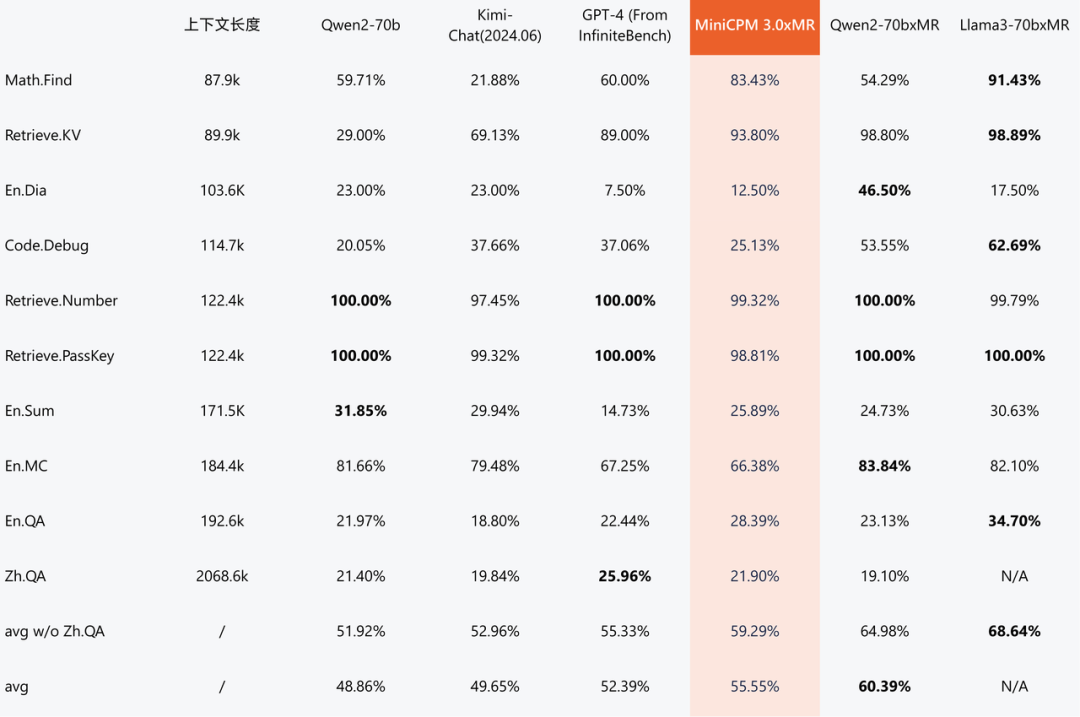

▲ InfiniteBench大模型长文本能力的权威评测集,检索、数学、代码、问答和摘要等多维度能力评估 ① MiniCPM 3.0 表现超越 GPT-4、KimiChat、Qwen2-70B;② 千亿模型 Qwen2-70B、Llama3-70b 结合LLMxMapReduce也取得更佳表现。

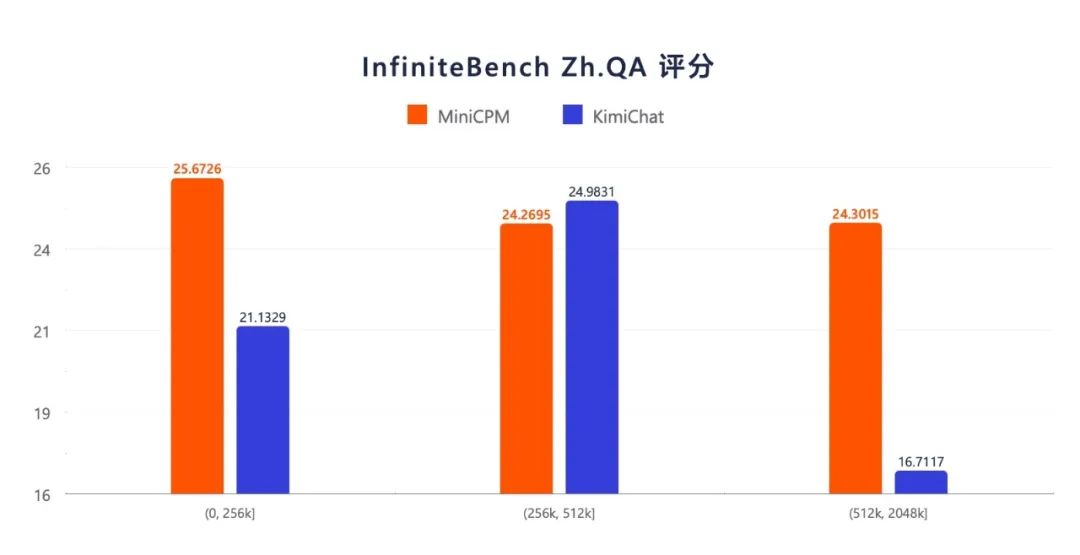

▲ InfiniteBench Zh.QA 评测结果显示,4B参数的面壁小钢炮整体性能优于Kimi,在更长的文本上表现出相较更强的稳定性。

▲ LLMxMapReduce 技术框架图

拥有无限上下文, 可以让模型一次性读取不限字数的书籍或不限量的学术论文、简历等材料,成为你身边更加强大的终端个人助手。模型还可以读取你的大众点评美食、酒店评价、微博互动内容,并牢牢记住你和 AI 跨越多年的聊天记录,成为最懂你的 AI 陪伴者。

GPT-4o 级 Function calling,终端 Agent 应用蓄势待发

智能体应用是端侧 AI 必争之地,其中一项至关重要的技术是 Function Calling(函数调用),它能够将用户模糊化的输入语义转换为机器可以精确理解执行的结构化指令,并让大模型连接外部工具和系统,例如通过语音在手机上调用日历、天气、邮件、浏览器等 APP 或相册、文件等本地数据库,从而打开终端设备 Agent 应用的无限可能,也让人机交互更加自然和方便。

MiniCPM 3.0 拥有端侧最强 Function calling 性能 ,在权威评测榜单 Berkeley Function-Calling Leaderboard 上,其性能接近 GPT-4o,并超越 Llama 3.1-8B、Qwen-2-7B、GLM-4-9B 等众多模型。

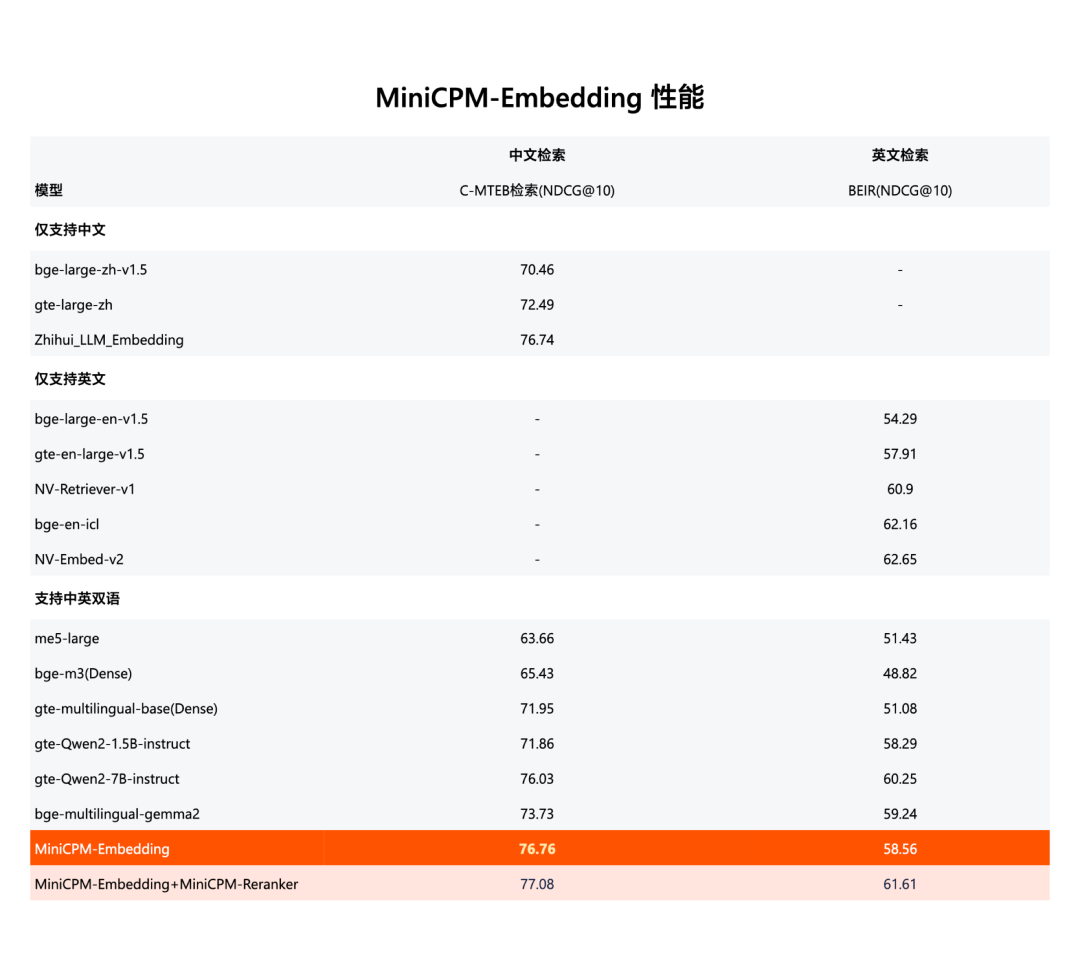

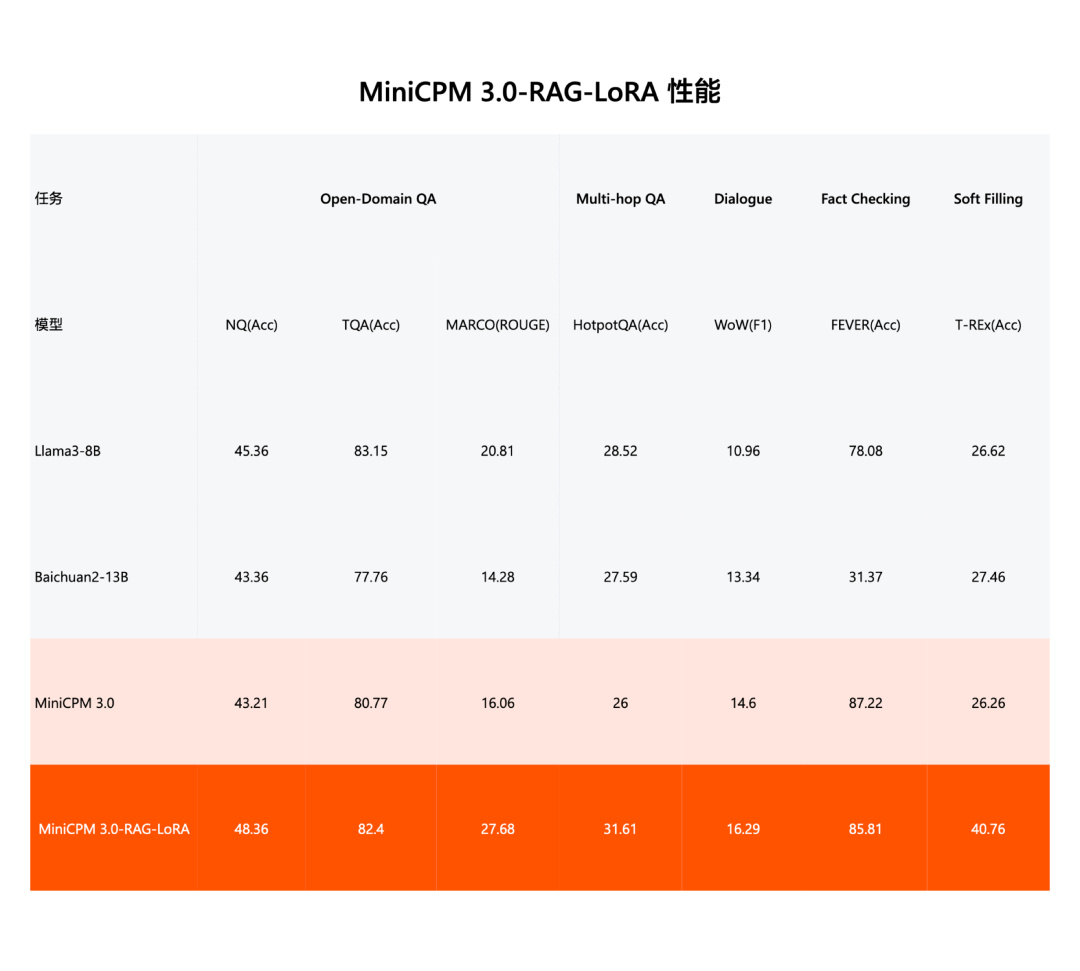

RAG 外挂三件套,中文检索第一,生成超 Llama3-8B

端侧模型也能开外挂,RAG(检索增强生成技术)让模型引用外部知识库,检索到最新、最可靠的专业知识,确保生成内容更加可信,大大减少大模型的幻觉问题。大模型+RAG 在行业中极其实用,尤其是对法律、医疗等依赖专业知识库、对大模型幻觉容忍度极低的垂直行业。

面壁智能一口气带来超强 RAG 外挂三件套:MiniCPM-Embedding(检索模型)、MiniCPM-Reranker(重排序模型)和面向 RAG 场景的 LoRA 插件(生成模型),款款优秀:

MiniCPM-Embedding(检索模型)中英跨语言检索取得 SOTA 性能,在评估模型文本嵌入能力的权威评测集 MTEB 的检索榜单上中文第一、英文第十三 ;

MiniCPM-Reranker(重排序模型)在中文、英文、中英跨语言测试上取得 SOTA 性能;

经过针对 RAG 场景的 LoRA 训练后,MiniCPM 3.0-RAG-LoRA 在开放域问答(NQ、TQA、MARCO)、多跳问答(HotpotQA)、对话(WoW)、事实核查(FEVER)和信息填充(T-REx)等多项任务上的性能表现,超越 Llama3-8B 和 Baichuan2-13B 等业内优秀模型。

左右滑动查看更多图片

安全,可靠,皮实,端侧大模型就看面壁小钢炮

轻、快、高效低成本,更友好的端侧体验,是面壁小钢炮系列一以贯之的优点。MiniCPM 3.0 量化后仅 2.2 G 内存,端侧应用十分友好。

相比云端模型,面壁小钢炮 MiniCPM 系列模型有一颗陪你行走世界的大心脏,天然具有弱网、断网可用、超低时延、数据隐私安全等本地优势。无论是陪你闯荡精彩远方、勇敢探索,还是将眼前的琐碎默默打理与守护,MiniCPM 都是值得信任的大模型好朋友。

左右滑动查看更多图片

MiniCPM 旗舰端侧模型系列,是面壁智能长期以来「大模型科学化」探索的结晶。通过科学提升训练方法与数据质量,不断提升大模型「知识密度」,得到同等参数,性能更强、成本更低的高效模型。

专注于端侧的先天技术优势,让面壁智能不断将高效高性能大模型放到离用户最近的地方,让大模型的能力像电力一样被随意调用、无处不在、普适且安全,尽可能快地让更多的人享受大模型的价值和作用。

➤ MiniCPM 3.0【此处地址有误】

Github:

https://arxiv.org/abs/2407.07061

HuggingFace:

https://github.com/OpenBMB/IoA

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

·

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?