自 2023 年 3 月推出第一代语言基座模型 ChatGLM 以来,智谱 AI 在大模型的性能和模态上不断探索并取得显著进展。经过多次技术迭代和性能优化,智谱 AI 在 2024 年的 ACM SIGKDD 大会上隆重发布了新一代基座模型。这些模型包括 GLM-4-Plus、CogView-3-Plus、GLM-4V-Plus 等,均在各自领域达到了国际领先水平。

我们对刚刚发布的 GLM-4V-Plus 的科研阅读与问询能力进行了一轮测验。

科研阅读与问询能力实测

文本的总结和科研概括能力:方便起见,我们之间将 CogVLM2 的 tex 源码输入给模型,并使用如下 prompt 让其对文章进行总结:

作为一名专业的多模态大模型研究人员,请对以下 paper 进行总结,用中文对文章的核心内容以及要点进行陈述并分条列举: \n。

GLM-4V-Plus 的指令跟随能力相当不错,对多模态大模型的每个核心组件都进行了详细的介绍,包括编码器,适配器的技术细节,模型大小,以及训练细节都总结的非常完善,最后也是对我所关注的核心点进行了总结。

科研专属名词的理解和解释能力:在其总结完整体论文内容后,基本对文章有了一定的了解,但是由于这篇文章包括了三个不同的模型,有很多的技术细节,我们仍然对部分内容充满了疑惑,因此对其中的技术名词进行了进一步的查询。可以看到,GLM-4V-Plus 对于很多计算机领域的专业知识也是相当了解的,可以不错的解释一些专有名词。

response = client.chat.completions.create(

model="glm-4v-plus", # 填写需要调用的模型编码

messages=[

{"role": "user", "content": f"作为一名专业的多模态大模型研究人员,请对以下paper进行总结,用中文对文章的核心内容以及要点进行陈述并分条列举: \n {text}"},

{"role": "assistant", "content": output1},

{"role": "user", "content": f"对于其中的部分专业名词我不是很了解,请详细解释他们是做什么的,在该文章中如何起作用,比如Q-former,SwiGLU,什么是感知视频中的时间戳信息;以及CogVLM2-Video是如何做到感知视频中的时间戳信息"},

],

)模型回复:

1. Q-former:Q-former 是一种用于处理序列数据的神经网络架构,通常用于自然语言处理(NLP)任务。在视觉语言模型中,Q-former 可以用来处理图像序列,例如视频中的帧序列。Q-former 通过学习序列中每个元素之间的关系来捕捉上下文信息,从而能够理解序列中的模式和结构。

2. SwiGLU:SwiGLU(Switchable Gated Linear Unit)是一种激活函数,它结合了 ReLU 和 GLU(Gated Linear Unit)的优点。SwiGLU 可以根据输入数据的特性动态选择合适的激活函数,从而提高模型的性能。在视觉语言模型中,SwiGLU 可以用于特征变换和融合,帮助模型更好地捕捉视觉和语言特征之间的关系。

3. 感知视频中的时间戳信息:在视频处理中,时间戳信息指的是视频帧的播放时间或拍摄时间。感知视频中的时间戳信息意味着模型能够理解视频帧与时间的关系,例如,能够回答关于视频特定时间点的问题,或者能够根据时间戳信息对视频内容进行排序和分析。

4. CogVLM2-Video 如何感知视频中的时间戳信息:CogVLM2-Video 通过将视频帧与时间戳信息结合起来,使模型能够理解视频中的时间顺序和事件发生的时间点。具体来说,CogVLM2-Video 可能使用以下方法来感知时间戳信息:

时间戳标注:在训练数据中,每个视频帧都标注了对应的时间戳。模型通过学习这些标注,能够将视觉信息与时间信息联系起来。

时间序列处理:模型可能使用时间序列处理技术,如循环神经网络(RNN)或 Transformer 架构,来捕捉视频帧之间的时间依赖关系。

多模态融合:模型可能将视觉特征与时间特征(如帧率、时间戳)结合起来,以更好地理解视频内容。

通过这些方法,CogVLM2-Video 能够处理与时间相关的问题,如视频问答、事件定位和视频摘要等任务。

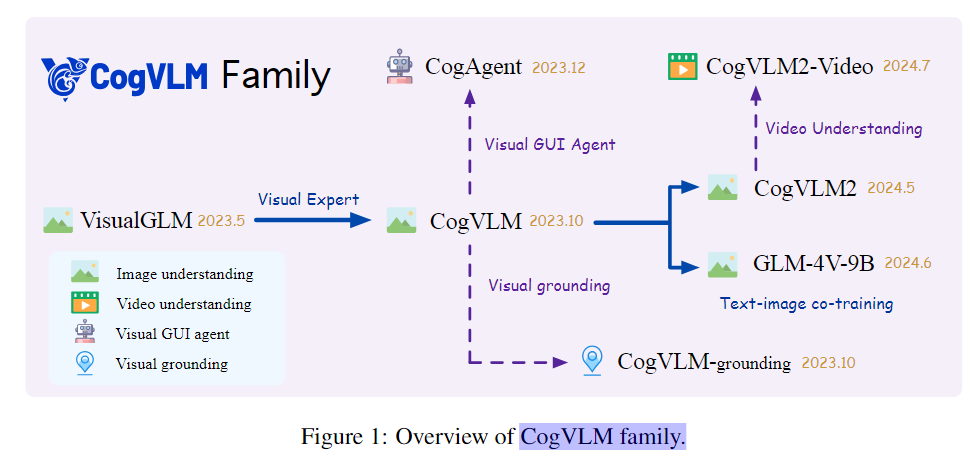

流程图理解能力:GLM-4V-Plus 作为一款多模态大模型,自然不仅仅局限于文字问答,我们也可以对文章中的图表进行质询。比如我们可以询问下图中关于 CogVLM 的发展历程问题,GLM-4V-Plus 能够很好的梳理流程图中各个部件的关系,年份,以及其他详细信息,具有不错的识图能力。

根据上下文和图中的信息,CogVLM family 的详细发展历程可以概括如下:

1. 2023.5 年,VisualGLM 发布,具备图像理解、视频理解和视觉 GUI 代理能力。

2. 2023.10 年,CogVLM 发布,在 VisualGLM 的基础上增加了视觉专家模块,具备视觉接地能力。

3. 2023.12 年,CogAgent 发布,作为视觉 GUI 代理。

4. 2024.5 年,CogVLM2 发布,在 CogVLM 的基础上进行了改进,包括使用 LLaMA3-8B 作为语言模型主干等。

5. 2024.6 年,GLM-4V-9B 发布,作为文本-图像共同训练的模型。

6. 2024.7 年,CogVLM2-Video 发布,具备视频理解能力。

7. 2024.7 年,GLM-4V-Plus 发布,在 GLM-4V-9B 的基础上增加了视频理解能力。

综上,CogVLM family 从 2023.5 年的 VisualGLM 开始,逐步增加了视觉专家模块、视觉 GUI 代理、视频理解等能力,最终形成了包含图像理解、视频理解、视觉接地等能力的系列模型。

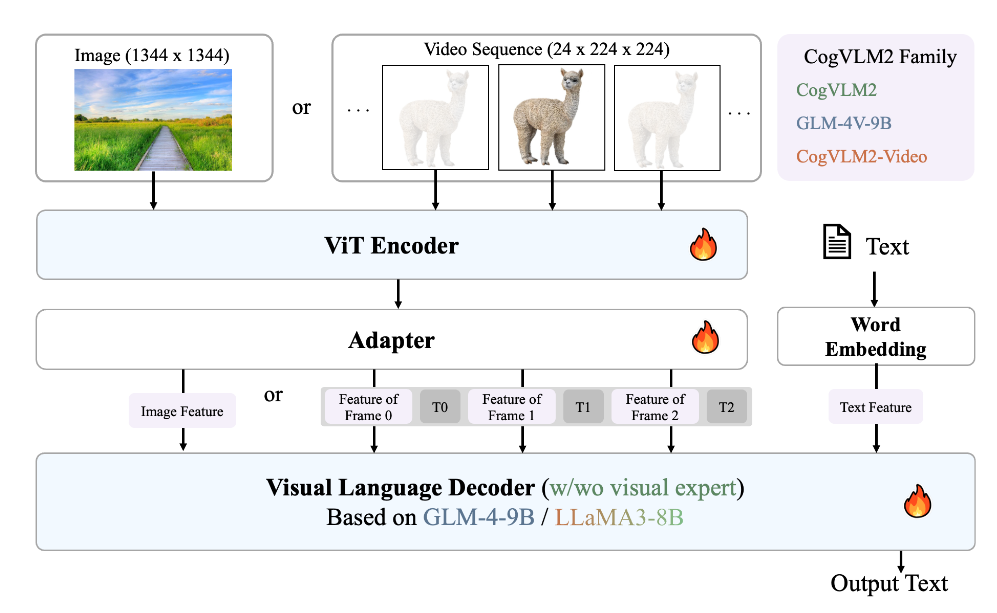

模型图理解能力:很多 paper 在画模型图时 caption 写的不会很详细,会造成很大的阅读负担,那么根据上下文,GLM-4V-Plus 能否对一个缺少 caption 的模型图进行详细的解释帮助我们理解?可以看到,即使没有 caption,当我们把所有上下文都扔给模型后,他依然可以对图进行详细的解释,大大减小了我们的阅读阻力。

图 2 展示了 CogVLM 家族的模型架构,它将视觉信息与预训练的 ViT 编码器和适配器相结合,然后将嵌入的视觉特征发送到视觉语言解码器。以下是该图所体现的模型框架、数据流和技术细节的详细说明:

模型框架:

1. ViT 编码器:将高分辨率图像或视频中的提取帧转换为连续的图像特征。编码器基于 EVA-CLIP 模型,该模型在多种语言模型大小和架构设计上表现出色。

2. 适配器:作为视觉和语言特征之间的桥梁。适配器采用 2x2 卷积层和 SwiGLU 模块,实现视觉和语言特征的无损对齐。

3. 视觉语言解码器:基于 GLM-4-9B 或 LLaMA3-8B 的语言模型。解码器基于 GLM-4-9B 或 LLaMA3-8B,它接受来自 ViT 编码器和适配器的视觉特征,并生成输出文本。

数据流:

1. 图像(1344x1344)或视频序列(24x224x224)输入到 ViT 编码器,生成图像特征或帧特征。

2. 图像特征或帧特征通过适配器与文本嵌入(单词嵌入)相结合,生成文本特征。

3. 文本特征输入到视觉语言解码器,生成输出文本。

技术细节:

1. ViT 编码器使用 EVA-CLIP 模型,将原始图像输入转换为连续的图像特征。

2. 适配器采用 2x2 卷积层和 SwiGLU 模块,实现视觉和语言特征的无损对齐。

3. 视觉语言解码器基于 GLM-4-9B 或 LLaMA3-8B 的语言模型,它接受来自 ViT 编码器和适配器的视觉特征,并生成输出文本。

4. CogVLM2-Video 能够感知视频中的时间戳信息,实现时间定位和相关问答。

5. GLM-4V-9B 采用类似的训练策略,是一个 13 亿参数的双语视觉语言模型,旨在探索英语和中文的图像理解能力。

6. GLM-4V-Plus 模型,使用相同的训练策略进行图像和视频理解任务的预训练。GLM-4V-Plus 在一系列图像和视频理解基准上实现了先进性能。

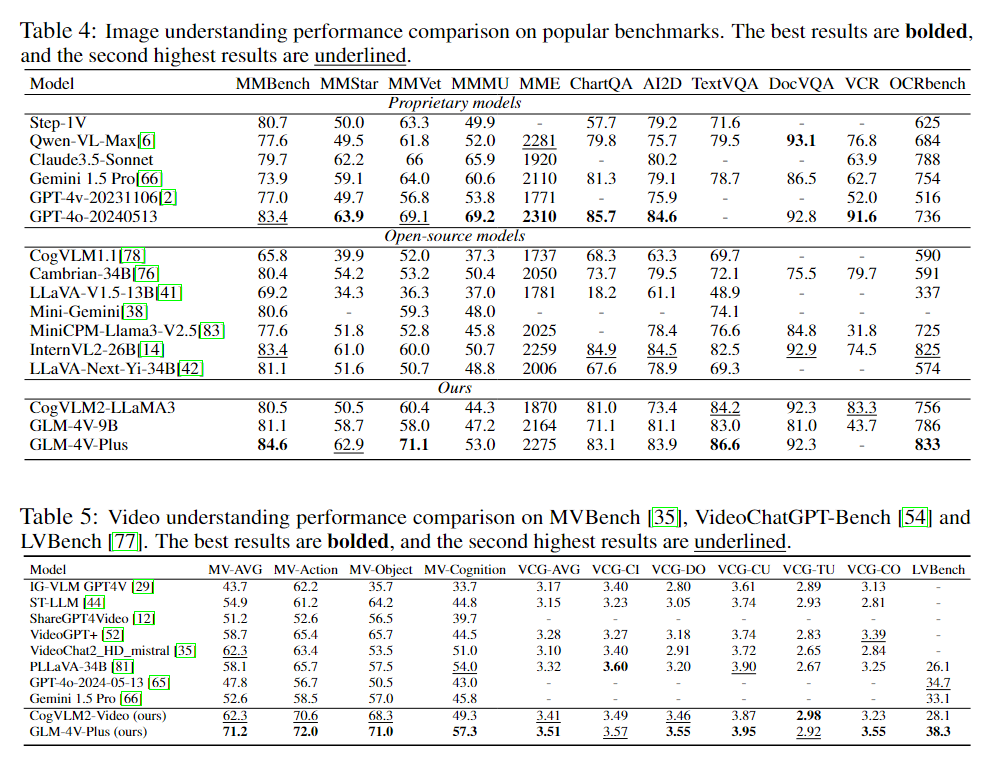

表格理解能力:我们也尝试着让 GLM-4V-Plus 对于其中的一些非常复杂的表格进行分析,看看他能否理解复杂表格,减轻我们的阅读负担,直接总结出实验发现。可以看到,对于非常复杂的表格,GLM-4V-Plus 有时会有一些误判(将 GPT-4o 识别为 GPT-4 以及对 LVBench 的部分性能识别错误),但是总体来说瑕不掩瑜,主要的实验观察还是值得借鉴的。

Table 4 展示了不同模型在流行基准上的图像理解性能比较。表格分为两个部分:专有模型和开源模型。在专有模型中,GPT-4-2024-05-13 在 MMMU 和 MMStar 上取得了最佳结果,而 Owen-VL-Max在DocVQA 上表现最好。在开源模型中,GLM-4V-Plus 在 MMBench、MMStar 和 MMVet 上取得了最佳结果。总的来说,GLM-4V-Plus 和 GLM-4V-9B 在大多数基准上表现最好。

Table 5 展示了不同模型在 MV-Bench、VideoChatGPT-Bench 和 LVBench 上的视频理解性能比较。在 MV-AVG、MV-Action、MV-Object 和 MV-Cognition 基准上,GLM-4V-Plus 取得了最佳结果。在 LVBench 基准上,Gemini 1.5 Pro 取得了最佳结果。总的来说,GLM-4V-Plus 在大多数基准上表现最好。

我的主要发现与总结如下:

1. GLM-4V-Plus 和 CogVL2-LLaMA3 在大多数视频理解基准上表现最好,而 GPT-4-2024-05-13 在图像理解基准上表现最好。

2. GLM-4V-Plus 和 CogVL2-LLaMA3 在大多数基准上表现相似,但在某些基准上,GLM-4V-Plus 表现更好。

其他更新与模型水平

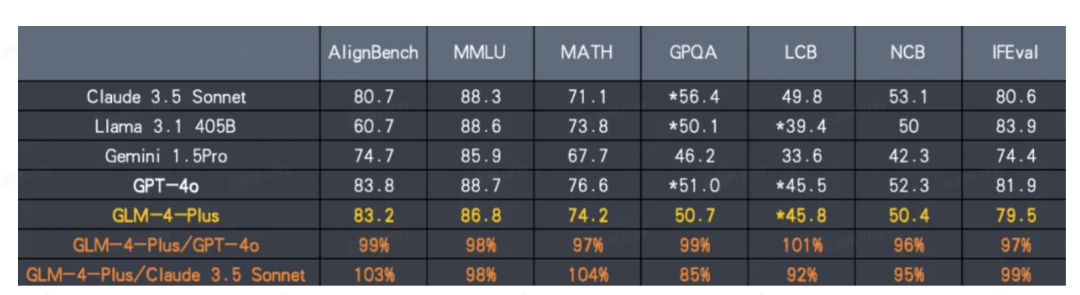

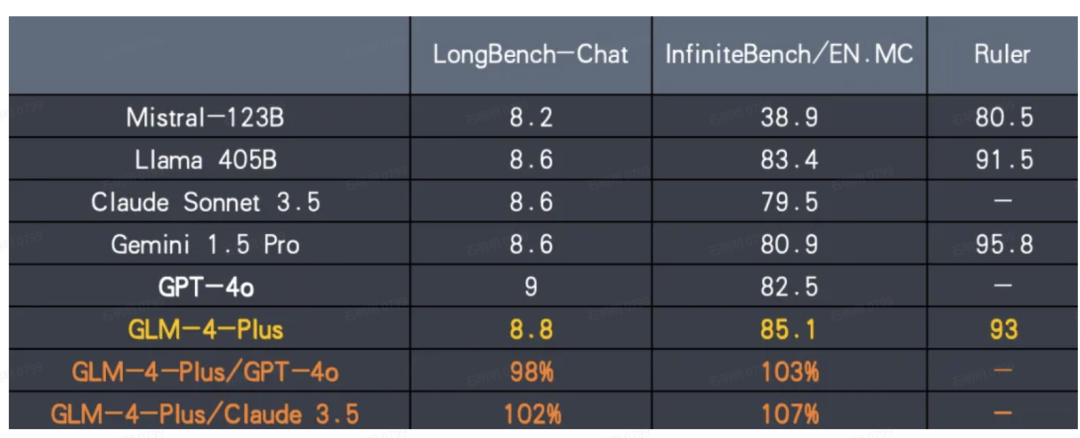

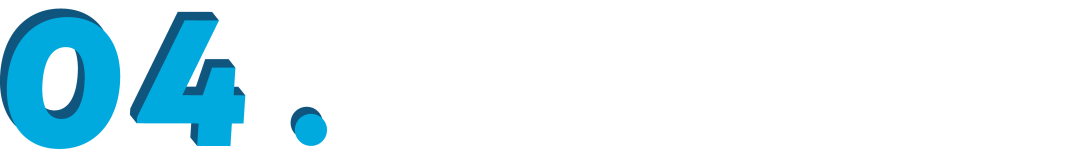

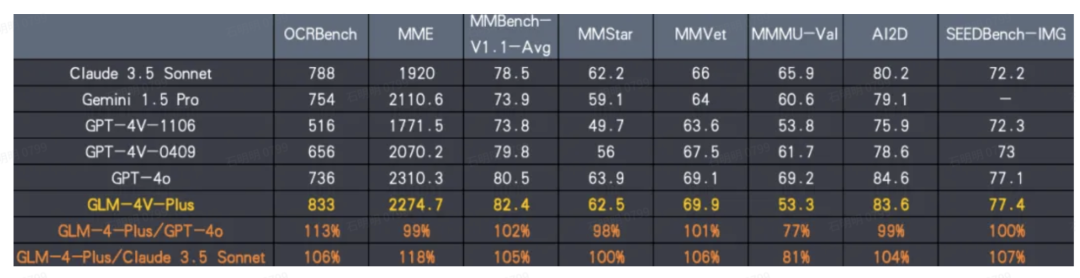

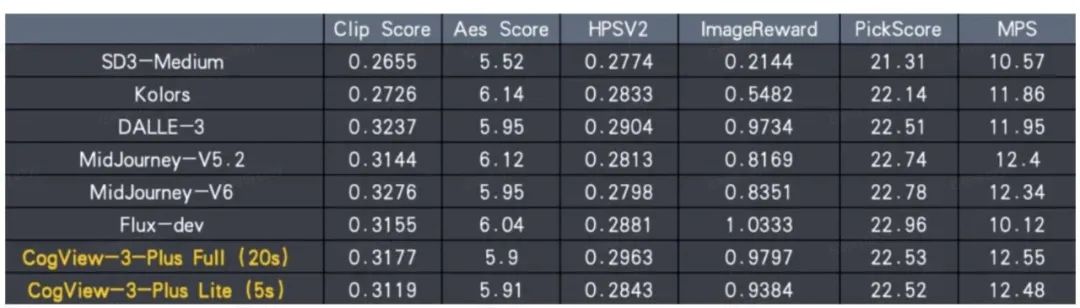

此次更新的主要亮点在于 GLM-4-Plus、CogView-3-Plus 和 GLM-4V-Plus 三大基座模型的全面提升:

1. GLM-4-Plus:作为语言基座模型,GLM-4-Plus 在语言理解、指令遵循以及长文本处理等方面取得了显著的性能提升,确保其在国际上的领先地位。该模型通过大量模型辅助构造高质量合成数据,显著提升了推理能力,尤其在数学和代码算法题的解决上更好地反映了人类的思维偏好。

2. CogView-3-Plus:在文生图领域,CogView-3-Plus 的性能接近目前最优的 MJ-V6 和 FLUX 等模型。其在图像生成和编辑能力上实现了高精度的提升,成为当前最具竞争力的文生图模型之一。

3. GLM-4V-Plus:作为图像和视频理解的基座模型,GLM-4V-Plus 具备卓越的图像理解能力,并引入了基于时间感知的视频理解功能。该模型即将在智谱大模型开放平台上线,并成为国内首个通用视频理解模型 API,极大地提升了视频内容分析的精准度和深度。

接下来笔者将对其更新的三个行业领先模型进行详细的介绍。

GLM-4-Plus

功能与优势

高质量数据构建与模型优化:通过多种方式构建了海量高质量的合成数据,并利用 PPO(Proximal Policy Optimization)等先进技术,显著提升了模型在推理、指令遵循等任务上的表现。这些技术改进使得 GLM-4-Plus 在处理复杂的数学问题、代码算法以及各类逻辑推理题时,能够更好地反映人类的思维偏好,达到了与国际领先模型如 GPT-4o 和 Llama3.1 相媲美的水平。

▲ LCB: LiveCodeBench; NCB: NaturalCodeBench

长文本推理能力:GLM-4-Plus 在长文本推理方面取得了重大突破。通过采用更精准的长短文本数据混合策略,该模型能够在复杂的语境下保持高水平的理解和推理能力,表现出了比肩国际先进水平的长文本推理效果。无论是处理简单的故事叙述还是解决经典的逻辑难题,如动物过河问题,GLM-4-Plus 都能够给出准确且符合逻辑的回答,展现了其卓越的文本推理能力。

GLM-4V-Plus

功能与优势

卓越的图像与视频理解能力:GLM-4V-Plus 具备强大的图像理解能力,并在视频理解上实现了显著的进展。该模型能够精准识别视频中的物体、场景、人物及其行为,甚至可以捕捉微妙的情绪变化和场景转换。

通过时间感知能力,GLM-4V-Plus 能够分析视频中连续帧之间的细微变化,从而准确追踪物体运动轨迹、预测行为模式,并识别出视频中的关键转折点和高潮部分。这种能力使得 GLM-4V-Plus 在视频内容的分析和总结方面表现得尤为出色。

时间感知与问答能力:GLM-4V-Plus 的时间感知能力不仅使其在视频理解中如虎添翼,还在时间问答任务中表现突出。用户可以通过该模型快速提取和理解视频中的关键信息,极大地提升了视频内容的学习和复习效率。这种时间感知能力对于教育、培训等领域具有重要应用价值,能够帮助用户高效地处理和理解长时间的视频内容。

CogView-3-Plus

功能与优势

其最新版本的文生图模型——CogView-3-Plus。这一新模型在图像生成领域取得了显著进步,尤其是在美学效果和功能多样性方面,与当前顶尖的 MJ-V6 和 FLUX 模型相当,并在多个方面展现了其独特的优势。

架构创新与技术突破:CogView-3-Plus 采用了最新的 Transformer 架构来替代传统的 UNet 架构,这一架构创新为模型带来了显著的性能提升。Transformer 架构的引入,不仅提升了模型的表达能力,还优化了扩散模型的噪声规划。这种深度研究和技术创新,使得 CogView-3-Plus 在图像生成的质量和效率上都有了显著提高,进一步缩小了与全球顶尖模型的差距。

支持图像编辑功能:CogView-3-Plus 的一大亮点是其对图像编辑功能的全面支持。用户可以在已生成的图像基础上进行精细化的编辑和调整,通过简单的文本指令或直观的界面操作,实现个性化定制。这种灵活的编辑能力使得 CogView-3-Plus 不仅能够生成高质量的初始图像,还能在生成后的阶段进行进一步的优化和调整,满足不同用户的特定需求。

结语

通过对 GLM-4V-Plus 科研阅读与问询能力的实测,我们可以看出,这款多模态大模型在科研工作中具有极大的实用价值。其在文本总结、科研专属名词解释、流程图与模型图理解等方面的出色表现,能够极大地减轻科研工作者的阅读负担,提高他们对复杂科研论文的理解效率。

对于繁杂的科研文献,GLM-4V-Plus 不仅能准确提取核心信息,还能帮助用户深入理解关键技术细节和复杂图表,为科研人员提供了高效的辅助工具。这种能力在当今信息爆炸的时代尤为重要,它能让科研工作者更快速地掌握前沿研究进展,从而专注于创新性研究,为科学发现和技术突破提供坚实的支持。

除了 GLM-4V-Plus,智谱 AI 还发布了其他几款性能卓越的大模型,各自在不同领域展现了领先的能力,为未来的大规模智能应用奠定了坚实的基础。

立即试用

点击「阅读原文」或下方链接即刻体验 GLM-4V-Plus👇

https://zhipuaishengchan.datasink.sensorsdata.cn/t/fB

解锁 AI 新知,与技术大咖并肩!

扫描下列二维码加入「ZHIPUer 技术社区」,分享最新案例,交流技术心得,还有更多社区活动奖励、内测福利、企业内推等机会等你解锁。

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

·

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?