第八章 提升方法

文章目录

8.1 提升方法AdaBoost算法

8.1.1 提升方法的基本思路

小组讨论(相互取长补短)比每个个体的讨论成果更优;

强可学习算法可以由弱学习算法提升而来;

如何提升,这就需要提升方法了,例如本章论述的AdaBoost算法;

在分类问题中,一系列通过弱学习算法求得的一系列弱分类器可以组成强分类器;

对于提升方法要解决两个问题:

1.每一轮怎样改变训练数据的权值或概率分布;

2.如何将弱分类器组合成强分类器;

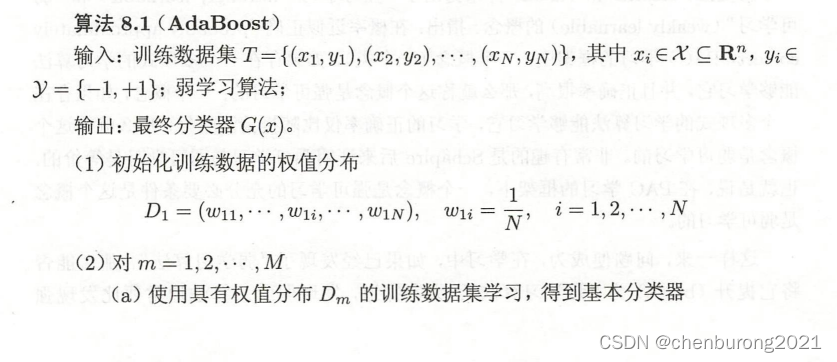

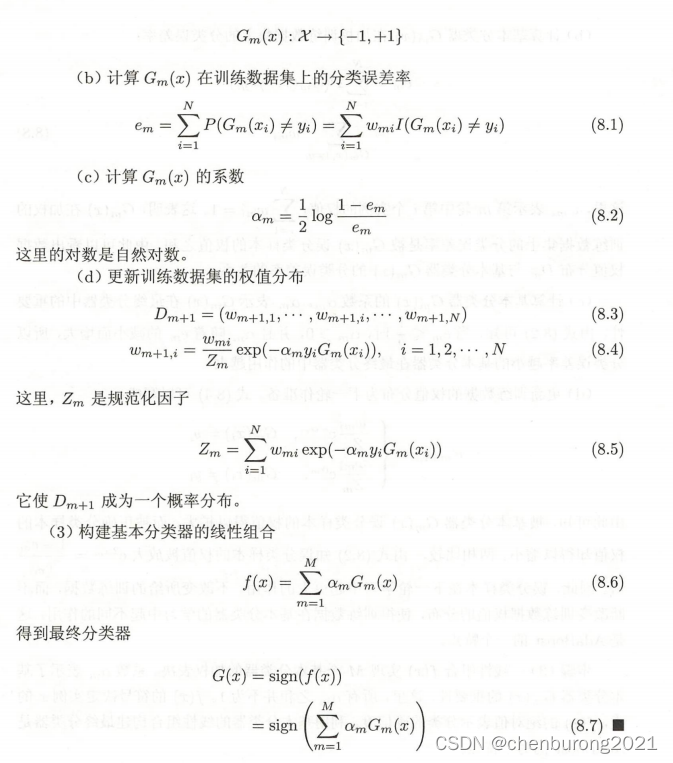

8.1.2 AdaBoost 算法

说明:

(1)假设初始权值均匀分布;

(2)

a.使用Dm加权训练数据;

b.分类误差率是误分类样本的权值之和;

c.分类误差率小的分类模型在最终分类模型中作用越大;

d.误分类样本权值扩大,正确分类样本权值减小;//权值大使得下个样本的分类误差率大,使得下一个分类模型在最终分类模型中的系数α变小,作用变小(相当于惩罚作用,抑制误分类);

AdaBoost特点:不改变训练数据集,改变其权值分布;

(3)αm之和不等于1;

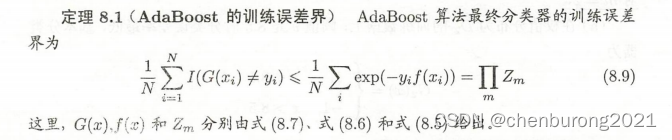

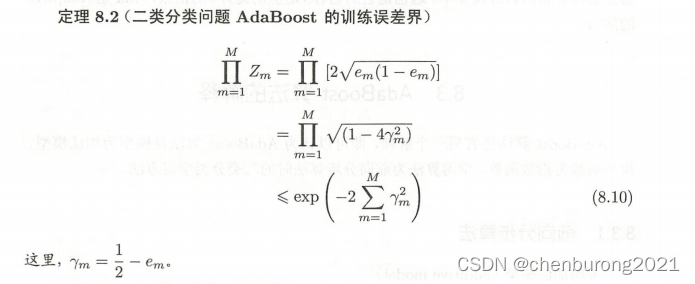

8.2 AdbBoost 算法的训练误差分析

定理 8.2

//函数0点泰勒展开得:

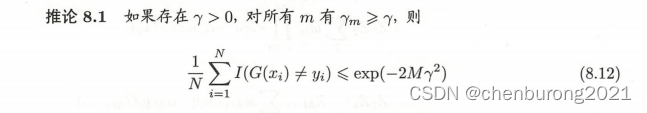

推论 8.1 选择指数作为边界是因为,可以把累成问题转化为累加问题;

AdaBoost算法无需下界,且有适应(abaptive)性,能适应弱分类器各自的误差,这也是该适应性提升算法的由来;

8.3 AdaBoost算法的解释

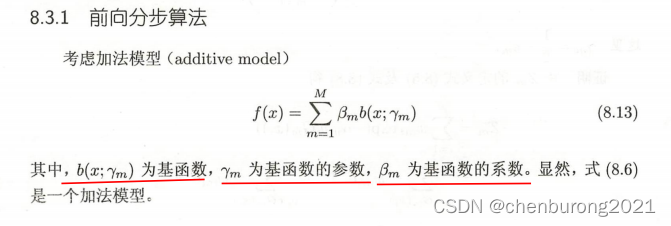

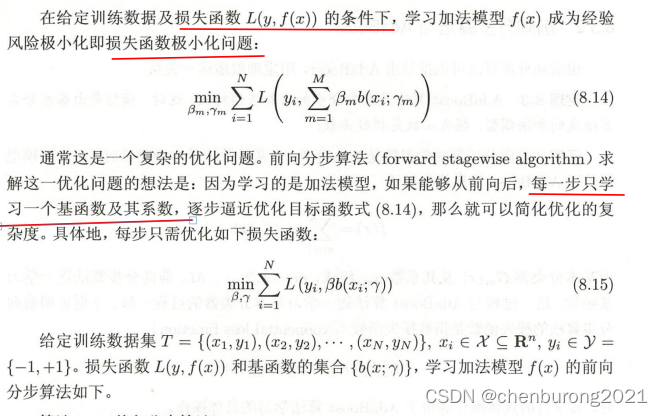

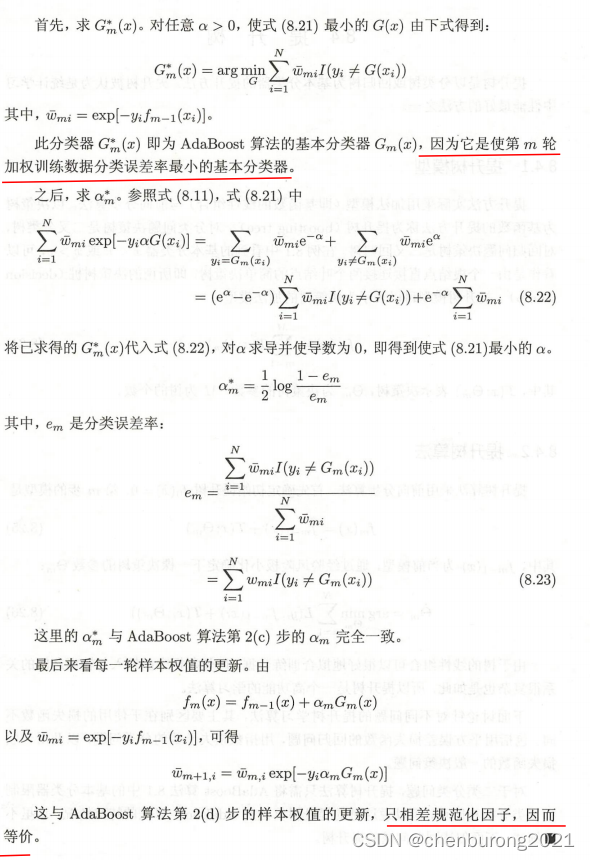

认为AdaBoost算法,是以加法模型为模型,指数函数为损失函数,前向分布算法为算法的二分类学习方法;

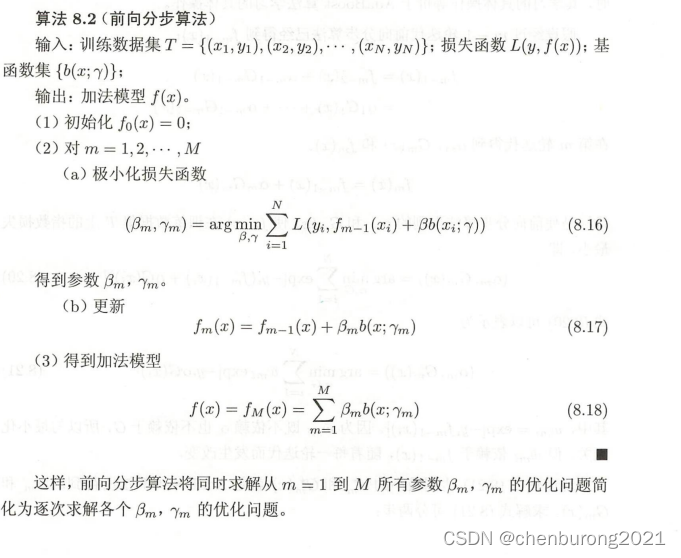

8.3.1 前向分布算法

//每步只优化一个基函数和系数;

8.3.2 前向分步算法于AdaBoost算法

8.4 提升树

提升树是以回归树和分类树为基本分类器的提升方法

8.4.1 提升树模型

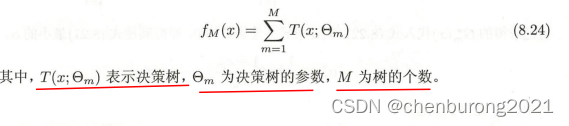

提升方法实际采用加法模型(基函数的线性组合与前向分类算法),以决策树为基函数的提升方法称为提升树;

此处决策树为二叉树;

提升树模型表示为决策树加法模型(即决策树的线性组合)

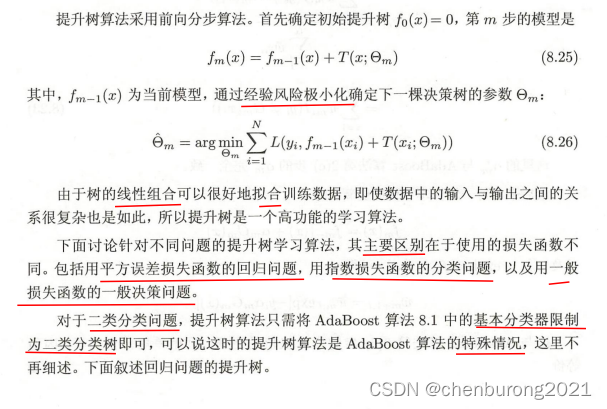

8.4.2 提升树算法

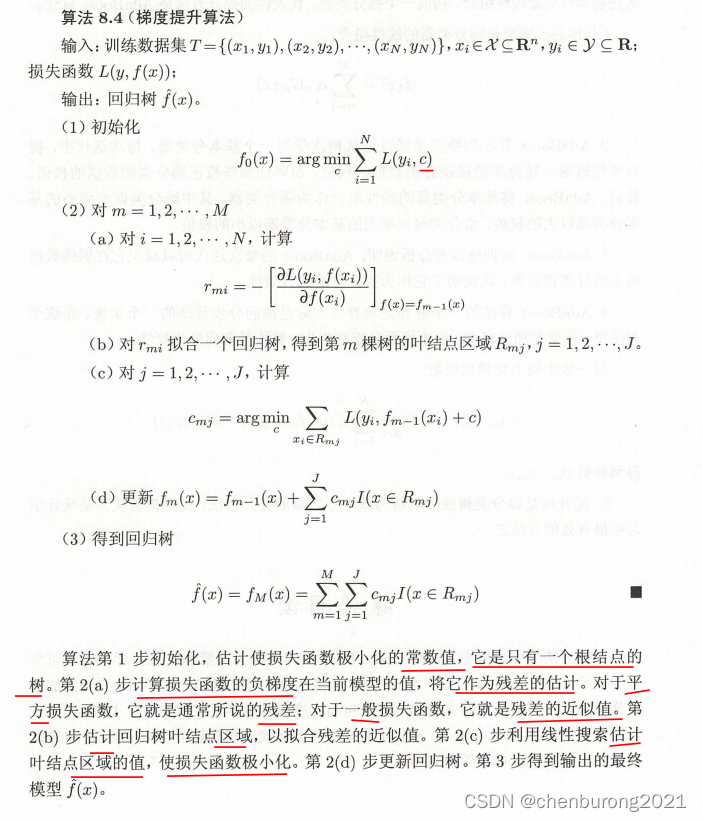

8.4.3 梯度提升

当损失函数是一般损失函数时,优化并不容易,梯度提升算法应运而生;

利用最速下降法的近似方法,利用损失函数的负梯度作为回归提升树残差的近似值,拟合一个回归树;

第一步,初始化一个根结点树,所有输出都是同一个常数;

上文的c类似一个决策树;

( b ) ( c ) 两步类似学习一个决策树;

320

320

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?