第4章 HDFS的Java API

4.2 Eclipse+Maven

http://www.eclipse.org/downloads/packages/

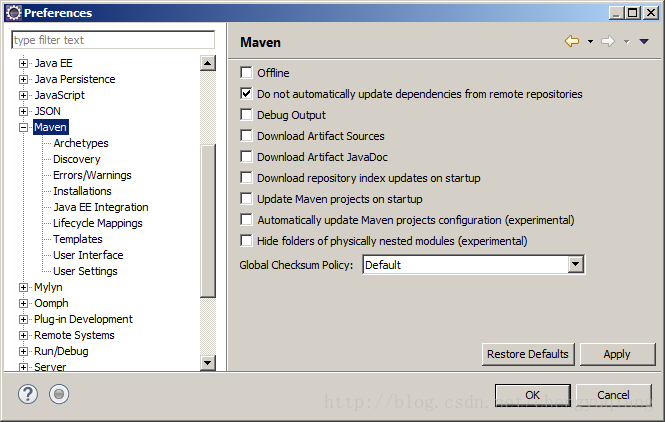

4.2.1 Eclipse的Maven配置

目前的eclipse-javee版本已经自带maven插件了

winows–>preferences–>左边maven

在Maven下选择“Installations”,右边窗口中单击“Add”按钮

单击“Directory”按钮,选择Maven安装目录,单击“Finish”按钮

再单击“User Settings”,右侧选择Maven的配置文件settings.xml的位置

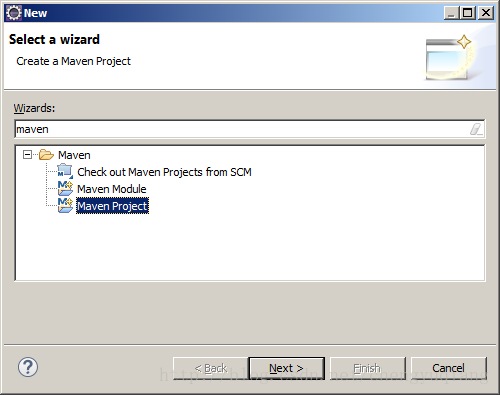

4.2.2 创建Maven项目

在Wizards中输入maven

如果创建的是web项目,则在filter中输入web进行过滤

这里我们需要创建普通的maven工程,选择“quickstart”

输入

单击“Finish”按钮,生成Maven项目

右键单击“JRE System Library”,在弹出的快捷菜单中选“Properties”

选择“workspace default JRE”

JRE更新后

4.4.3 强制更新

刚创建好的Maven项目,可能出现错误。

需要强制更新:

右键单击maven项目,快捷菜单中选择Maven–>Update Project

在“Update Maven Project”

4.4.4 Maven项目结构

- pom.xml:用于定义或者添加jar包的依赖

- src/main/java:用于存放java源文件

- src/test/java:用于存放测试用例。

pom.xml文件

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>cn.hadron</groupId>

<artifactId>hdfsDemo</artifactId>

<version>0.0.1-SNAPSHOT</version>

<packaging>jar</packaging>

<name>hdfsDemo</name>

<url>http://maven.apache.org</url>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties>

<dependencies>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>3.8.1</version>

<scope>test</scope>

</dependency>

</dependencies>

</project>

405

405

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?