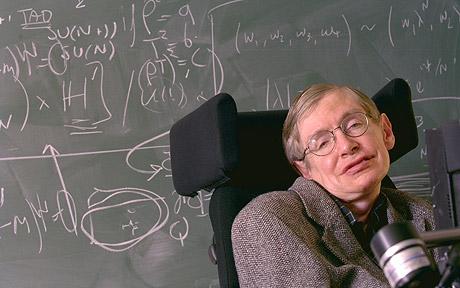

《编者按》:本文是人工智能科学家和科技界名人反对将AI用于“自主武器”的公开信,在Hacker News上已经讨论得相当热烈。发起者包括:斯蒂芬·霍金(Stephen Hawking)、特斯拉CEO Elon Musk,以及一批当今最著名的AI和机器人领域专家。全文信如下:

自主武器(Autonomous Weapons)不需要人力介入便可自主攻击目标物,例如:武装四轴飞行器能根据预定规则搜索并伤害人类。自主武器并不包括寻航导弹、或是能让人类对攻击目标拥有所有决策权的远程飞行器。

近些年,人工智能技术的发展已令部署这类系统变得极尽可能,假如没有法律制约,未来几年(不是几十年内),自主武器会极具威胁:这是继火药和核武之后的第三次武器革命。

关于自主武器的争论已经颇多,例如通过机器取代军人可以减少伤亡,但这也降低了战争的门坎。对人类而言,核心的问题是,在今日,我们是否要让全球加入人工智能的武力竞赛,还是该防止它的发生。如果任何主要的军事武力都借由人工智能持续发展与进行,全球武力竞赛将是必然发生,结局亦相当明显:自主武器将成为明日的AK步枪。

因为人工智能不像核武需要庞大成本,它几乎零成本,更不需担心原料难以获取,不仅廉价,而且处处可以复制。这些武器出现在黑市甚至恐怖份子的手中,只是时间的问题。自主武器很可能用于暗杀、颠覆政权、镇压、种族屠杀,我们相信将AI用于武力竞赛绝不利于人类。

如同大部分的生物学家与化学家对于生物武器不抱兴趣,大部分的人工智能研究者,也对将人工智能用于武器不感兴趣,而且更不希望因为其他人这样做而玷污了人工智能的领域。甚至可能造成大众舆论对人工智能的强烈反对,而扼杀了它未来能带来的社会贡献。其实,化学家和生物学家大体上支持国际共识,已成功地禁止了化学和生物武器,如同大多数物理学家对禁止太空核武和激光致盲武器条款的支持。

总而言之,我们相信人工智在很多方面能对人类利益有极大的潜力,而这个领域的目标应该就是要如此。展开军事上的人工智能竞赛是个糟糕的想法,应该要在法律上禁止自主武器超越人类意志的控制。

署名:Stephen Hawking、Elon Musk、Steve Wozniak、Stuart Russell、Peter Norvig、Yann LeCun等。

点击原文

照片为斯蒂芬·霍金(Stephen Hawking),其他连署人还包括:苹果电脑共同创办人沃兹尼亚克(Steve Wozniak),以及学界知名教授Stuart Russell、Yann LeCun。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?