讲师:Vincent 谷歌科学家 ,研究机器学习和人工智能方向

一,从机器学习到深度学习

1.深度学习是什么?深度学习是机器学习的一个分支,它利用大量的数据来教会计算机做事情。

2.历史:神经网络很多理论研究工作在八九十年代就已经完成了(eg: 1990年 LENET-5),但当时计算机的计算能力还很弱,能用于训练的数据也不多,所以通训练过神经网络来解决问题的这种方案被认为是天荒夜谈,逐渐被人们冷落摒弃。在2009年左右神经网络应用于了语音识别,在2012年应用于机器视觉,并取得很好的效果,2014年神经网络应用于机器翻译,,,,,,,,当然,产生这些变化的原因不是某个人的研究突破,也不是某个组织的项目成功,而是整个社会和科技发展促使了神经网络的复兴。比如:GPU变得更快更廉价,随着电子产品的普及人们活动产生的数据越来越多,越来越丰富。当今神经网络已无处不在,,,,,,,,,

3.监督学习: 给出一个训练集dataset,其中每一条记录有给神经网络的输入也有神经网络的输出,让神经网络调整w和b,使网络对每条记录的输出与我们dataset里给出的输出尽量一致,通过大量的训练,神经网络就具备了给出正确结果的功能。

4.非监督学习:给出的训练集dataset中没有标准结果,只是让神经网络通过调整w和b对输入进行相应,并且把调整后的参数记录下来,这种方式可以用于图片的压缩保存,当然是有损压缩。非监督学习没有目标没有对错的调整,怎么让她实现有用功能呢?总是没搞明白,我总感觉非监督学习一定要配合监督学习使用,不然一个目标都没有的事物,你让她何去何从呢?

5.逻辑回归分类器:它是一种线性分类器,wx + b = y 这是其基础公式,也所有神经网络的基本原理。6.softmax 函数能输出每个分类对应的概率,把输出结果转出成功概率的过程叫做logits。softmax 函数:

scores = [3.0, 1.0, 0.2]

import numpy as np

def softmax(x):

return np.exp(x) / np.sum(np.exp(x), axis=0)softmax函数有个特点:当对输出结果乘以10时,其输出的结果会比较极端,要么趋近与1,要么趋近于0。当对输出的结果除以10时,其输出的结果会比较平均,所有结果都趋近于1/n , n为结果种类数,即趋近于平均分布。这种特点在实际应用时,可以增大输出值让网络变得很自信。

7.One-Hot 编码:该编码为在每一行只有一个为1的数,其余都是0,每一行仅表示一种结果,很多行就组成一个结果集。对结果集的这种编码方式叫One-Hot编码。

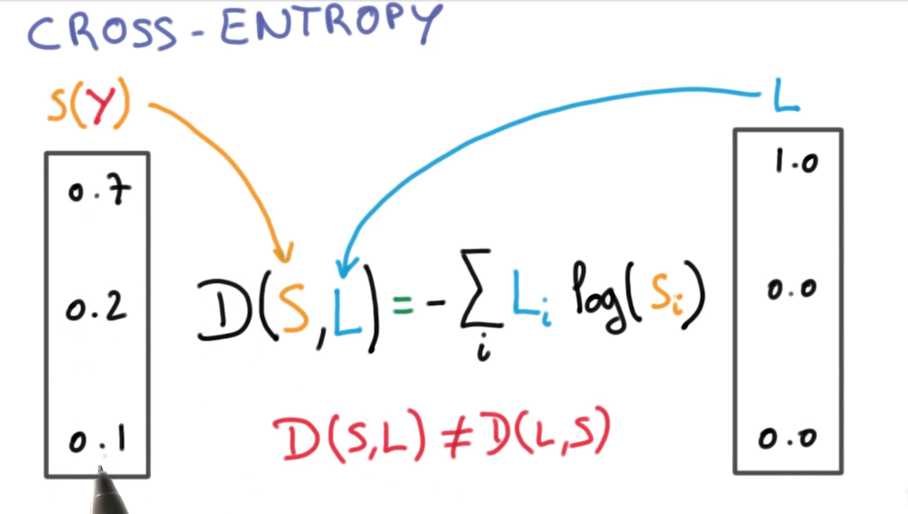

8.交叉熵:当输出的结果种类非常多时,这时候输出矩阵是一个非常大的矩阵,而且大多数值都是0,运算非常浪费时间,所以用交叉熵来解决这个问题。

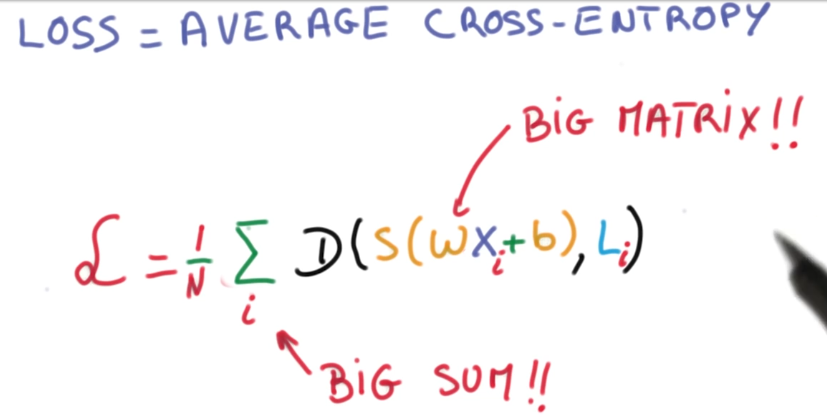

9.最小化交叉熵:其实整个训练过程可以转换为寻找最小交叉熵的问题,也就是寻找最小平均交叉熵,也就是寻找最小罚函数值的问题。其实说白了还是通过调整权重w和偏置b来让网络的预测值尽量接近实际值。在tensorflow中这个寻找过程已经封装成了几个方法:tf.train.GradientDescentOptimizer(),tf.train.AdamOptimizer()、tf.train.AdadeltaOptimizer()、tf.train.AdagradOptimizer()。

10.梯度下降法GradientDescent:对罚函数在每个w方向都求偏导数,并且对每个w都加上这个偏导数,每次训练都这样做,直到罚函数值不在变小为止。

11.数值计算的稳定性问题:一个很小的数min加上一个很大的数max,连续加n次,得到的结果并不是max+n*min,因为这个问题我们在进行神经网络训练过程中尽量不要产生很大的数或者很小的数,尽量让数值都保持在一定大小范围内。

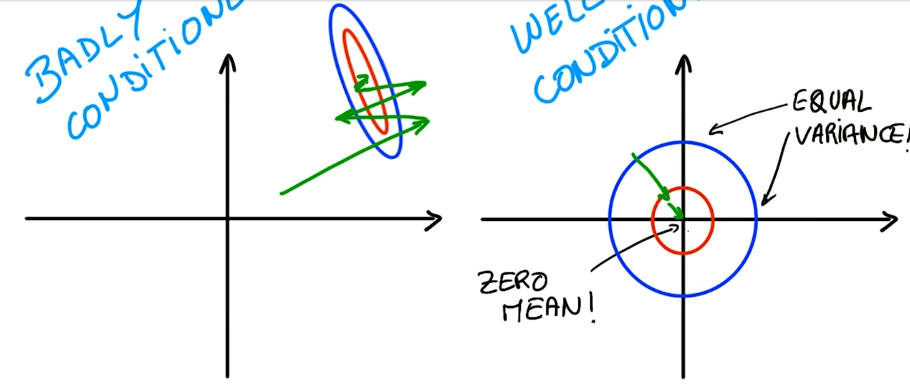

12.正则化输入:因为数值计算的稳定性问题,它是计算机计算数值的缺陷,很难解决。所以我们只能调整我们输入的值来规避这个问题,这就要求我们要对输入的值正则化,也就是让其均值趋近于0,而且尽可能同方差。这样做除了能规避数值计算的稳定性问题,还能让神经网络尽快收敛。收敛路径比较如下图:

所以我们在训练图片识别的神经网络时,要对三原色的数值都做这样的处理:(R-128)/128、(G-128)/128、(B-128)/128。这就是正则化处理。

13.初始化权重与偏置:最简单的初始化权重的方法是在正态分布中随机取值tf.truncated_normal();偏置全部取值为0。

650

650

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?