我们开发时候经常会统计一些访问日志,访问日志中的url是海量的,并且好多是重复内容。以url为例,统计url中出现频率次数前10的url,并按出现次数的降序排序。

linux命令:

cat url.log | sort | uniq -c |sort -n -r -k 1 -t ' ' | awk -F '//' '{print $2}' | head -10

现在来一一分析这些命令组合的含义。

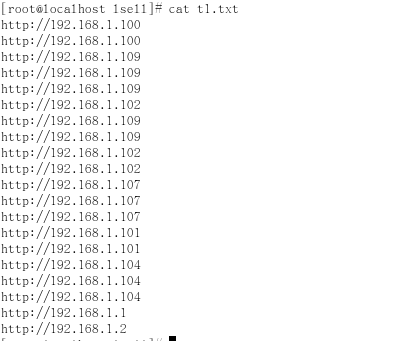

1、原始访问日志

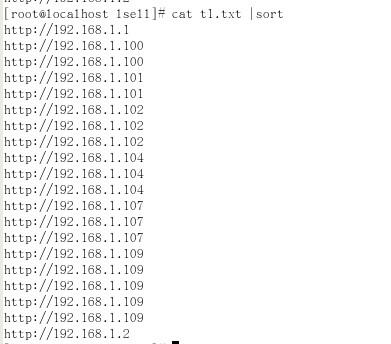

2、排序

cat t1.log | sort

表示对data文件中的内容进行排序。sort命令是对于每一行的内容根据字典序(ASCII码)进行排序,这样可以保证重复的记录时相邻的。

3、合并相邻重复记录,统计重复数

cat t1.log | sort | uniq -c

这里,通过管道(|)将左边部分的命令的输出作为右边部分的输入。uniq -c 表示合并相邻的重复记录,并统计重复数。因为uniq -c 只会合并相邻的记录,所以在使用该命令之前需要先排序。

4、对记录重新排序,需要用到sort命令的 -k 1 、-n、-r 三个命令参数

cat t1.log | sort | uniq -c | sort -k 1 -n -r

经过uniq -c 处理之后的数据格式形如"2 data",第一个字段是数字,表示重复的记录数;第二个字段为记录的内容。我们将对此内容进行排序。sort -k 1表示对于每行的第一个字段进行排序,这里即指代表重复记录数的那个字段。因为sort命令的默认排序是按照ASCII,这就会导致按从大到小进行排序时,数值2会排在数值11的前面,所以需要使用-n 参数指定sort命令按照数值大小进行排序。-r 表示逆序,即按照从大到小的顺序进行排序。

5、使用awk -F命令分隔IP地址,并取数组的第二部分

cat t1.log | sort | uniq -c | sort -k 1 -n -r | awk -F '//' '{print $2}'

经过sort data | uniq -c | sort -k 1 -n -r 处理后的文本是 http://192.168.1.100 这样的格式,我们需要的结果是192.168.1.100这样的格式,需要去掉http://这些字段,采用awk才处理,awk -F '//' 是将http://192.168.1.100分组成2部分 http:// 和 192.168.1.100,{print $2}的作用是取数组的第二部分,即192.168.1.100

6、使用head -n命令选取前n行

cat t1.log | sort | uniq -c | sort -k 1 -n -r | awk -F '//' '{print $2}'| head -10

head 命令表示选取文本的前x行。通过head -10 就可以得到排序结果中前十行的内容。

1448

1448

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?