数据挖掘比赛—— 02特征工程

1)含义

将数据转换为能更好表示潜在问题的特征,从而更好提高机器学习的性能。

包括数据理解,清洗,构造,选择和不平衡等。

2)目的

将数据转换为能更好地表示潜在问题的特征,从而提高机器学习的性能。比如,异 常值处理是为了去除噪声,填补缺失值可以加入先验知识,增强数据的表达。特征工程是一个入门简单,但想精通非常难的一件事。

3)内容介绍

常见的特征工程包括:

异常处理:

通过箱线图(或 3-Sigma)分析删除异常值; BOX-COX 转换(处理有偏分布); 长尾截断;

特征归一化/标准化:

标准化(转换为标准正态分布);归一化(抓换到 [0,1] 区间); 针对幂律分布,可以采用公式:

数据分桶:

等频分桶; 等距分桶; Best-KS 分桶(类似利用基尼指数进行二分类); 卡方分桶;

缺失值处理:

不处理(针对类似 XGBoost 等树模型); 删除(缺失数据太多);插值补全,包括均值/中位数/众数/建模预测/多重插补/压缩感知补全/矩阵补全等; 分箱,缺失值一个箱;

特征构造:

构造统计量特征,报告计数、求和、比例、标准差等; 时间特征,包括相对时间和绝对时间,节假日,双休日等; 地理信息,包括分箱,分布编码等方法;

非线性变换,包括 log/ 平方/ 根号等; 特征组合,特征交叉; 仁者见仁,智者见智。 𝑙𝑜𝑔( 1+𝑥)-log(1+𝑚𝑒𝑑𝑖𝑎𝑛)

1、特征筛选 过滤式(filter):

先对数据进行特征选择,然后在训练学习器,常见的方法有 Relief/方差选择发/相关系数法/卡方检验法/互信息法;

2、包裹式(wrapper):

直接把最终将要使用的学习器的性能作为特征子集的评价准则,常见方法有 LVM(Las Vegas Wrapper) ;

3、嵌入式(embedding):

结合过滤式和包裹式,学习器训练过程中自动进行了特征选择,常见的有 lasso 回归;降维 PCA/ LDA/ ICA;

特征选择也是一种降维。

2、接下来具体介绍代码实现部分

处理代码如下:

2.1导入数据

import pandas as pd

import numpy as np

import matplotlib

import matplotlib.pyplot as plt

import seaborn as sns

from operator import itemgetter

%matplotlib inline

Train_data = pd.read_csv('used_car_train_20200313.csv', sep=' ')

Test_data = pd.read_csv('used_car_testA_20200313.csv', sep=' ')

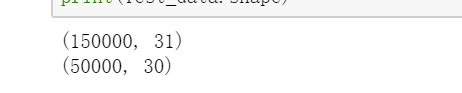

print(Train_data.shape)

print(Test_data.shape)

2.2查看数据

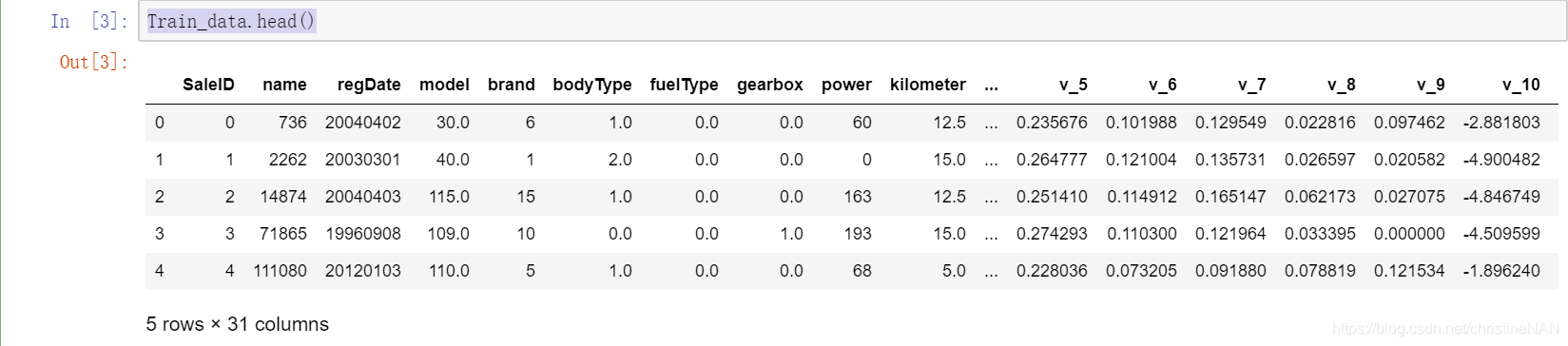

Train_data.head()

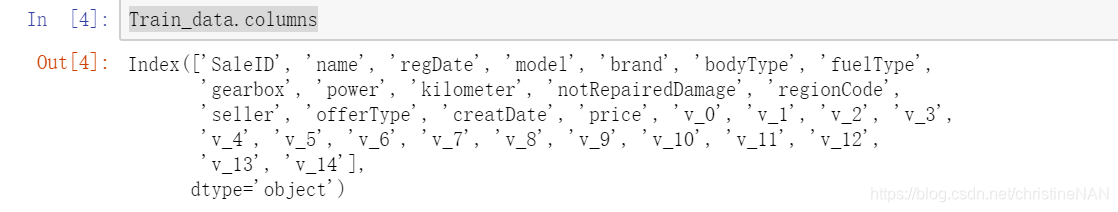

Train_data.columns

2.3异常值处理

查看数据之后,接下来进行异常值处理,此处我们选择删除异常值,因为异常值的个数较少,且与平均值相差太大

# 这里我包装了一个异常值处理的代码,可以随便调用。

def outliers_proc(data, col_name, scale=3):

"""

用于清洗异常值,默认用 box_plot(scale=3)进行清洗

:param data: 接收 pandas 数据格式

:param col_name: pandas 列名

:param scale: 尺度

:return:

"""

def box_plot_outliers(data_ser, box_scale):

"""

利用箱线图去除异常值

:param data_ser: 接收 pandas.Series 数据格式

:param box_scale: 箱线图尺度,

:return:

"""

iqr = box_scale * (data_ser.quantile(0.75) - data_ser.quantile(0.25))

val_low = data_ser.quantile(0.25) - iqr

val_up = data_ser.quantile(0.75) + iqr

rule_low = (data_ser < val_low)

rule_up = (data_ser > val_up)

return (rule_low, rule_up), (val_low, val_up)

data_n = data.copy()

data_series = data_n[col_name]

rule, value = box_plot_outliers(data_series, box_scale=scale)

index = np.arange(data_series.shape[0])[rule[0] | rule[1]]

print("Delete number is: {}".format(len(index)))

data_n = data_n.drop(index)

data_n.reset_index(drop=True, inplace=True)

print("Now column number is: {}".format(data_n.shape[0]))

index_low = np.arange(data_series.shape[0

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?