Pytorch 顾名思义,就是 Torch 7 移植到 Python 的版本,其最大亮点就是自动微分、动态计算图和 Numpy 集成。

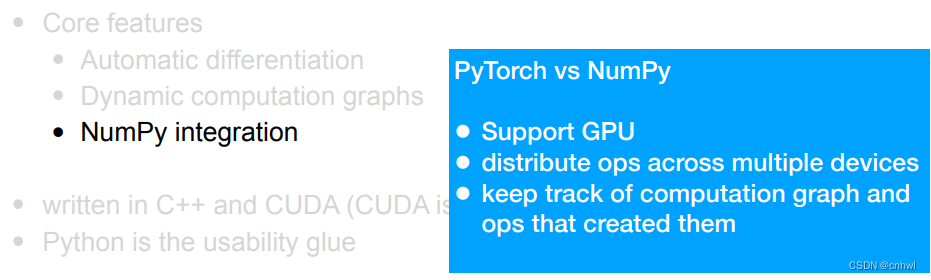

Pytorch 相比于 Numpy,优点在于支持 GPU 计算甚至是多设备计算,以及动态计算图。

在 import 的时候,得记住 import 的是 torch 而不是 pytorch

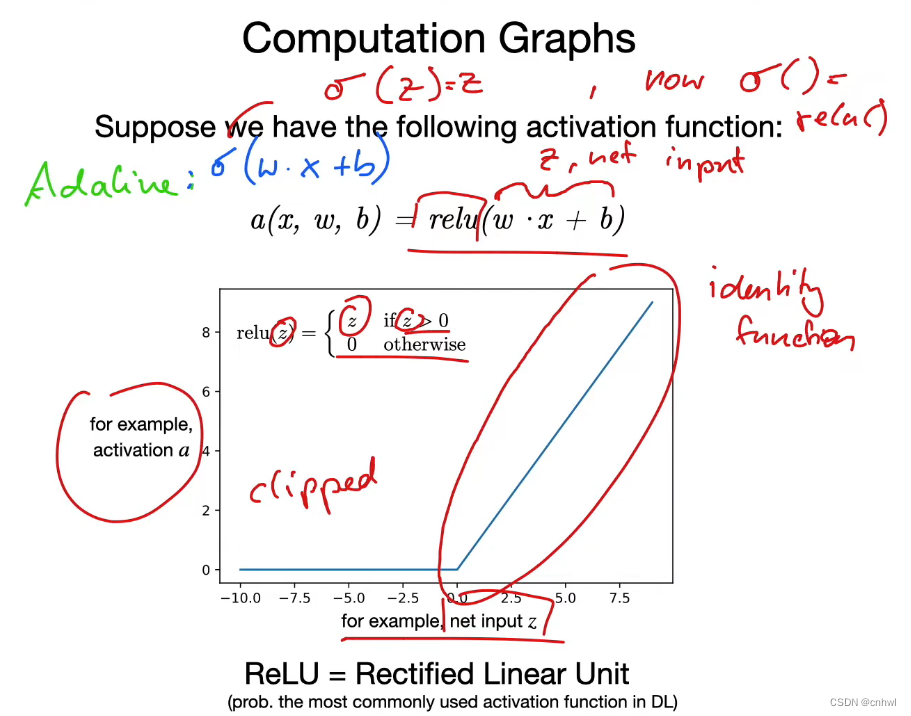

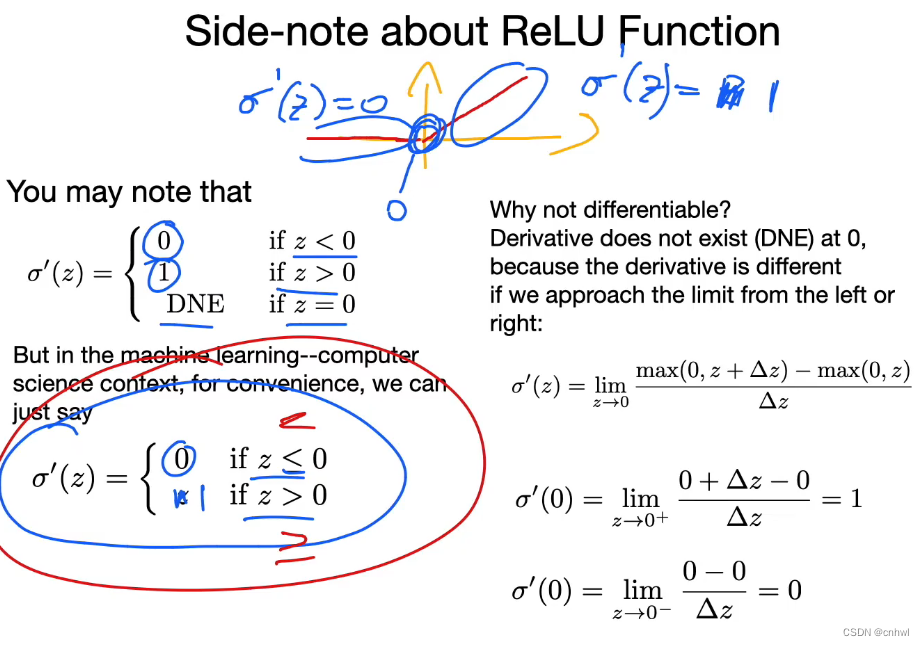

最常用的激活函数之一是 ReLU 函数,它可以看作是恒等函数 y = x 在 x 小于等于 0 时被截掉了(y 等于 0)。由于它在 x = 0 处的左右极限不相同,所以显然它在零点处不可导,但在实际中我们会忽略 x = 0 的情况(因为很罕见),将它的导数看作是一个分两段的函数即可。

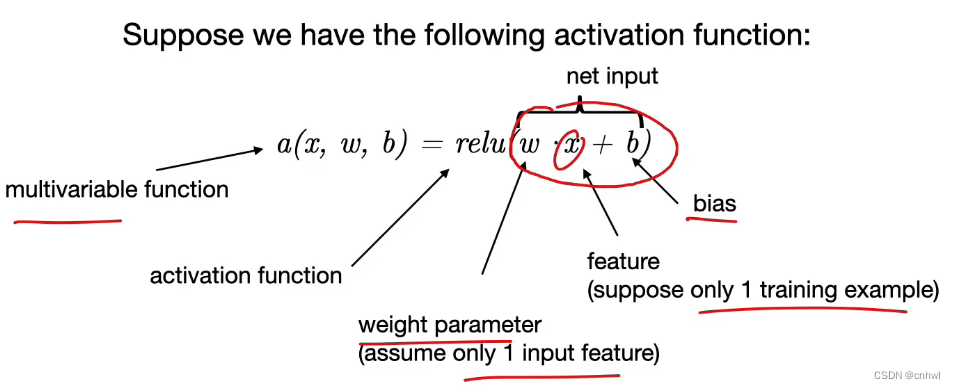

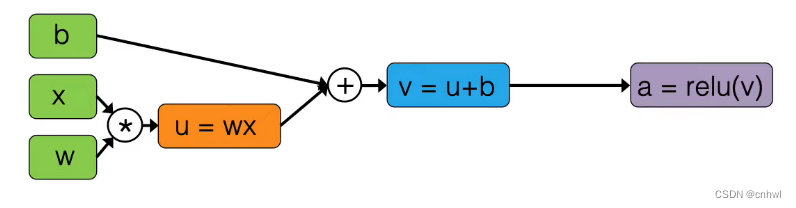

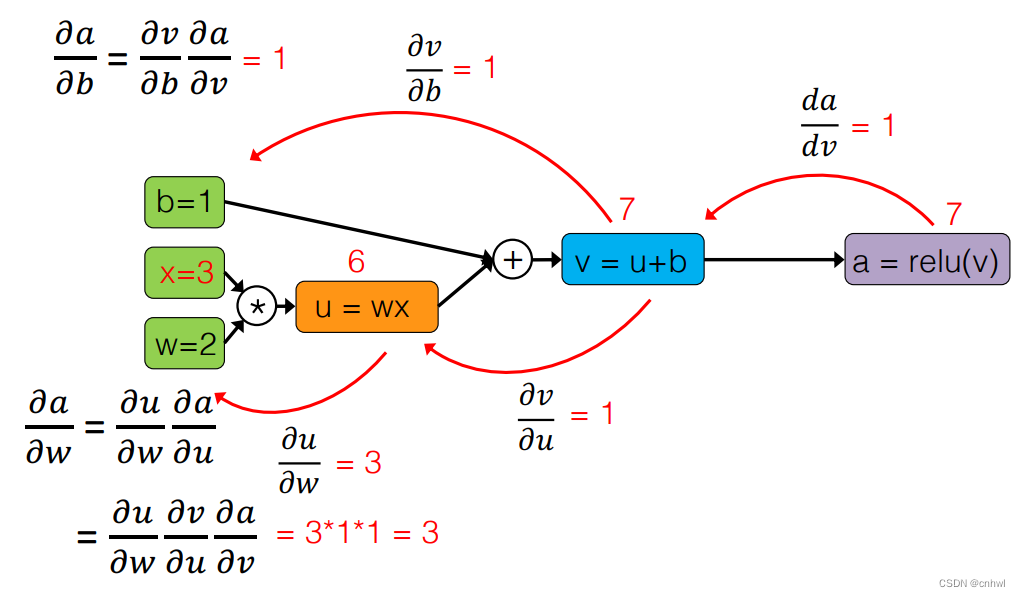

ReLU 函数及其计算图,实际上就是把复杂函数分解为变量通过简单函数(四则运算、单个函数)的组合。

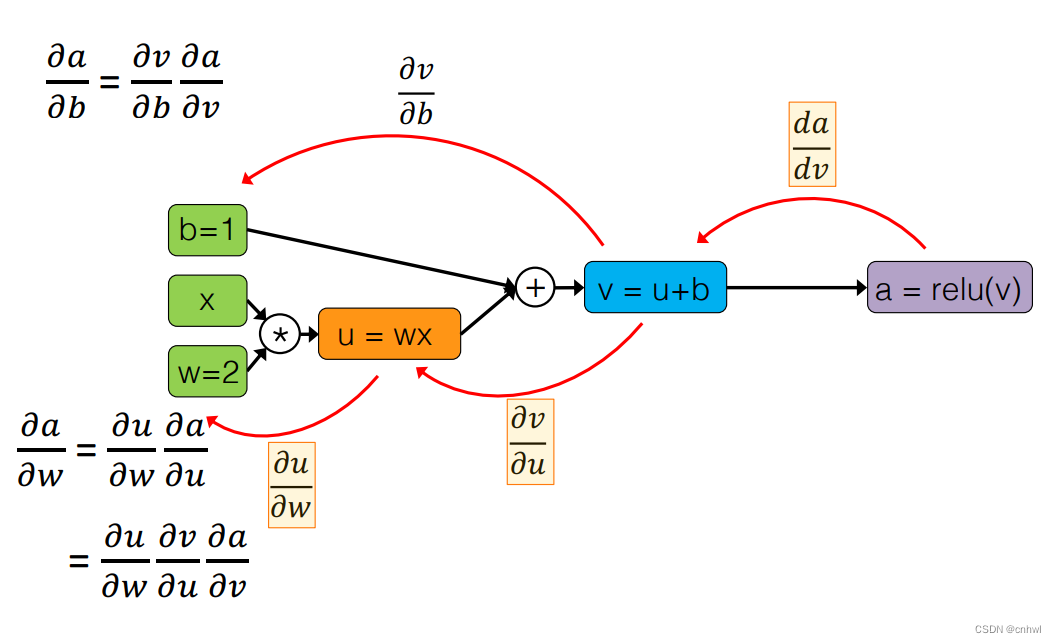

这样做的好处是可以很方便地求导,特别是输出对于参数的导数,利用链式法则,将目标导数分解为多个子步骤的导数之积,又因为子步骤的导数都是很简单的,所以目标导数也能轻松求取。

代入实际的数字,令 b = 1、x = 3、w = 2,导数求取过程如上。

Pytorch是Torch7的Python版本,以其自动微分和动态计算图功能著称,支持GPU计算。ReLU作为常用激活函数,简化了复杂函数的导数求取,利于神经网络训练。在实际应用中,通过链式法则计算导数,即便在不可导点也能有效处理。例如,当b=1、x=3、w=2时,可以直观理解导数计算过程。

Pytorch是Torch7的Python版本,以其自动微分和动态计算图功能著称,支持GPU计算。ReLU作为常用激活函数,简化了复杂函数的导数求取,利于神经网络训练。在实际应用中,通过链式法则计算导数,即便在不可导点也能有效处理。例如,当b=1、x=3、w=2时,可以直观理解导数计算过程。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?