什么是Spark?

官网:http://spark.apache.org

我的翻译:Spark是一个针对大规模数据处理的快速通用引擎

Spark是一种快速、通用、可扩展的大数据分析引擎,2009年诞生于加州大学伯克利分校AMPLab,2010年开源,2013年6月成为Apache孵化项目,2014年2月成为Apache顶级项目。目前,Spark生态系统已经发展成为一个包含多个子项目的集合,其中包含SparkSQL、Spark Streaming、GraphX、MLlib等子项目,Spark是基于内存计算的大数据并行计算框架。Spark基于内存计算,提高了在大数据环境下数据处理的实时性,同时保证了高容错性和高可伸缩性,允许用户将Spark部署在大量廉价硬件之上,形成集群。Spark得到了众多大数据公司的支持,这些公司包括Hortonworks、IBM、Intel、Cloudera、MapR、Pivotal、百度、阿里、腾讯、京东、携程、优酷土豆。当前百度的Spark已应用于凤巢、大搜索、直达号、百度大数据等业务;阿里利用GraphX构建了大规模的图计算和图挖掘系统,实现了很多生产系统的推荐算法;腾讯Spark集群达到8000台的规模,是当前已知的世界上最大的Spark集群。

Spark的优势

(*)Hadoop的MapReduce计算模型存在的问题:

学习过Hadoop的MapReduce的学员都知道,MapReduce的核心是Shuffle(洗牌)。在整个Shuffle的过程中,至少会产生6次的I/O。下图是我们在讲MapReduce的时候,画的Shuffle的过程。

中间结果输出:基于MapReduce的计算引擎通常会将中间结果输出到磁盘上,进行存储和容错。另外,当一些查询(如:Hive)翻译到MapReduce任务时,往往会产生多个Stage(阶段),而这些串联的Stage又依赖于底层文件系统(如HDFS)来存储每一个Stage的输出结果,而I/O的效率往往较低,从而影响了MapReduce的运行速度。

(*)Spark的最大特点:基于内存

Spark是MapReduce的替代方案,而且兼容HDFS、Hive,可融入Hadoop的生态系统,以弥补MapReduce的不足。

Spark的特点:快、易用、通用、兼容性

(*)快

与Hadoop的MapReduce相比,Spark基于内存的运算速度要快100倍以上,即使,Spark基于硬盘的运算也要快10倍。Spark实现了高效的DAG执行引擎,从而可以通过内存来高效处理数据流。

(*)易用

Spark支持Java、Python和Scala的API,还支持超过80种高级算法,使用户可以快速构建不同的应用。而且Spark支持交互式的Python和Scala的shell,可以非常方便地在这些shell中使用Spark集群来验证解决问题的方法。

(*)通用

Spark提供了统一的解决方案。Spark可以用于批处理、交互式查询(Spark SQL)、实时流处理(Spark Streaming)、机器学习(Spark MLlib)和图计算(GraphX)。这些不同类型的处理都可以在同一个应用中无缝使用。Spark统一的解决方案非常具有吸引力,毕竟任何公司都想用统一的平台去处理遇到的问题,减少开发和维护的人力成本和部署平台的物力成本。

另外Spark还可以很好的融入Hadoop的体系结构中可以直接操作HDFS,并提供Hive on Spark、Pig on Spark的框架集成Hadoop。

(*)兼容性

Spark可以非常方便地与其他的开源产品进行融合。比如,Spark可以使用Hadoop的YARN和Apache Mesos作为它的资源管理和调度器,器,并且可以处理所有Hadoop支持的数据,包括HDFS、HBase和Cassandra等。这对于已经部署Hadoop集群的用户特别重要,因为不需要做任何数据迁移就可以使用Spark的强大处理能力。Spark也可以不依赖于第三方的资源管理和调度器,它实现了Standalone作为其内置的资源管理和调度框架,这样进一步降低了Spark的使用门槛,使得所有人都可以非常容易地部署和使用Spark。此外,Spark还提供了在EC2上部署Standalone的Spark集群的工具。

Spark的体系结构与安装部署

Spark集群的体系结构

官方的一张图:

我自己的一张图:

Spark的安装与部署

Spark的安装部署方式有以下几种模式:

- Standalone

- YARN

- Mesos

- Amazon EC2

(*)Spark Standalone伪分布的部署

配置文件:conf/spark-env.sh

- export JAVA_HOME=/root/training/jdk1.7.0_75

- export SPARK_MASTER_HOST=spark81

- export SPARK_MASTER_PORT=7077

- 下面的可以不写,默认

- export SPARK_WORKER_CORES=1

- export SPARK_WORKER_MEMORY=1024m

配置文件:conf/slave

- spark81

(*)Spark Standalone全分布的部署

配置文件:conf/spark-env.sh

- export JAVA_HOME=/root/training/jdk1.7.0_75

- export SPARK_MASTER_HOST=spark82

- export SPARK_MASTER_PORT=7077

- 下面的可以不写,默认

- export SPARK_WORKER_CORES=1

- export SPARK_WORKER_MEMORY=1024m

配置文件:conf/

- spark83

- spark84

(*)启动Spark集群:sbin/start-all.sh

ip:8080

Spark HA的实现

(*)基于文件系统的单点恢复

主要用于开发或测试环境。当spark提供目录保存spark Application和worker的注册信息,并将他们的恢复状态写入该目录中,这时,一旦Master发生故障,就可以通过重新启动Master进程(sbin/start-master.sh),恢复已运行的spark Application和worker的注册信息。

基于文件系统的单点恢复,主要是在spark-en.sh里对SPARK_DAEMON_JAVA_OPTS设置

| 配置参数 | 参考值 |

|---|---|

| spark.deploy.recoveryMode | 设置为FILESYSTEM开启单点恢复功能,默认值:NONE |

| spark.deploy.recoveryDirectory | Spark 保存恢复状态的目录 |

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=FILESYSTEM -Dspark.deploy.recoveryDirectory=/root/training/spark-2.1.0-bin-hadoop2.7/recovery"

测试:

1、在spark82上启动Spark集群

2、在spark83上启动spark shell

MASTER=spark://spark82:7077 spark-shell

3、在spark82上停止master

stop-master.sh

4、观察spark83上的输出:

5、在spark82上重启master

==start-master.sh=

(*)基于Zookeeper的Standby Masters

ZooKeeper提供了一个Leader Election机制,利用这个机制可以保证虽然集群存在多个Master,但是只有一个是Active的,其他的都是Standby。当Active的Master出现故障时,另外的一个Standby Master会被选举出来。由于集群的信息,包括Worker, Driver和Application的信息都已经持久化到ZooKeeper,因此在切换的过程中只会影响新Job的提交,对于正在进行的Job没有任何的影响。加入ZooKeeper的集群整体架构如下图所示。

| 配置参数 | 参考值 |

|---|---|

| spark.deploy.recoveryMode | 设置为ZOOKEEPER开启单点恢复功能,默认值:NONE |

| spark.deploy.zookeeper.url | ZooKeeper集群的地址 |

| spark.deploy.zookeeper.dir | Spark信息在ZK中的保存目录,默认:/spark |

参考

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=bigdata12:2181,bigdata13:2181,bigdata14:2181 -Dspark.deploy.zookeeper.dir=/spark"

另外:每个节点上,需要将以下两行注释掉

ZooKeeper中保存的信息

启动:在主节点上启动 start-all

在另外从节点上 start-master.sh

执行Spark Demo程序

执行Spark Example程序

(1)示例程序:$SPARK_HOME/examples/jars/spark-examples_2.11-2.1.0.jar

(2)所有的示例程序:$EXAMPLE_HOME/examples/src/main

有Java、Scala等等等

(3)Demo:蒙特卡罗求PI

命令:

spark-submit --master spark://spark81:7077 --class org.apache.spark.examples.SparkPi examples/jars/spark-examples_2.11-2.1.0.jar 100

使用Spark Shell

park-shell是Spark自带的交互式Shell程序,方便用户进行交互式编程,用户可以在该命令行下用scala编写spark程序。

(*)启动Spark Shell:spark-shell

也可以使用以下参数:

参数说明:

–master spark://spark81:7077 指定Master的地址

–executor-memory 2g 指定每个worker可用内存为2G

–total-executor-cores 2 指定整个集群使用的cup核数为2个

例如:

spark-shell --master spark://spark81:7077 --executor-memory 2g --total-executor-cores 2

(*)注意:

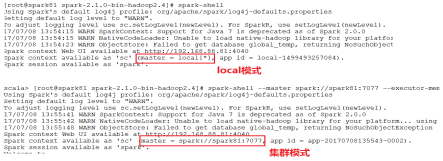

如果启动spark shell时没有指定master地址,但是也可以正常启动spark shell和执行spark shell中的程序,其实是启动了spark的local模式,该模式仅在本机启动一个进程,没有与集群建立联系。

请注意local模式和集群模式的日志区别:

(*)在Spark Shell中编写WordCount程序

**程序如下:

sc.textFile(“hdfs://192.168.88.111:9000/data/data.txt”).flatMap(.split(" ")).map((,1)).reduceByKey(+).saveAsTextFile(“hdfs://192.168.88.111:9000/output/spark/wc”)

说明:

- sc是SparkContext对象,该对象时提交spark程序的入口

- textFile(“hdfs://192.168.88.111:9000/data/data.txt”)是hdfs中读取数据

- flatMap(_.split(" "))先map在压平

- map((_,1))将单词和1构成元组

- reduceByKey(+)按照key进行reduce,并将value累加

- saveAsTextFile(“hdfs://192.168.88.111:9000/output/spark/wc”)将结果写入到hdfs中

在IDEA中编写WordCount程序

()需要的jar包:$SPARK_HOME/jars/.jar

()创建Scala Project,并创建Scala Object、或者Java Class

()书写源代码,并打成jar包,上传到Linux

Scala版

(*)运行程序:

spark-submit --master spark://spark81:7077 --class mydemo.WordCount jars/wc.jar hdfs://192.168.88.111:9000/data/data.txt hdfs://192.168.88.111:9000/output/spark/wc1

import org.apache.spark.{SparkConf, SparkContext}

/**

* @Autho: Administrator and wind

* @Version: 2019/11/9 & 1.0

*

* scala WordCounts

*/

object TestWordCounts {

def main(args: Array[String]): Unit = {

//创建spark环境

val conf = new SparkConf().setAppName("TestWordCounts").setMaster("local")

//如果在集群模式下,spark不用设置,spark-submit指定

//本地模式,master设置成local

//创建SparkContext对象

val sc = new SparkContext(conf)

val result = sc.textFile("E:\\test\\abc\\test.txt")

.flatMap(_.split(" "))

.map((_,1))

.reduceByKey(_+_)

/**

* reduceByKey:对相对应的key分组

* (I,1)

* (I,1)

*

* (I,1+1)

*

* (I,1)

* (I,1)

* (I,1)

*

* (I,1+1)

*(I,1)

*

* (I,2+1)

*/

result.foreach(println)

//停止sc

sc.stop()

}

}

Java版

(*)运行程序:

spark-submit --master spark://spark81:7077 --class mydemo.JavaWordCount jars/wc.jar hdfs://192.168.88.111:9000/data/data.txt

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.FlatMapFunction;

import org.apache.spark.api.java.function.Function2;

import org.apache.spark.api.java.function.PairFunction;

import scala.Tuple2;

import java.util.Arrays;

import java.util.Iterator;

import java.util.List;

/**

* @Autho: Administrator and wind

* @Version: 2019/11/9 & 1.0

*/

public class JavaWordCounts {

public static void main(String[] args) {

//创建环境

SparkConf conf = new SparkConf().setAppName("JavaWordCounts").setMaster("local");

JavaSparkContext jsp = new JavaSparkContext(conf);

JavaRDD<String> lines = jsp.textFile("E:\\test\\abc\\test.txt");

JavaRDD<String> words = lines.flatMap(new FlatMapFunction<String, String>() {

public Iterator<String> call(String input) throws Exception {

return Arrays.asList(input.split(" ")).iterator();

}

});

JavaPairRDD<String,Integer> ones = words

.mapToPair(new PairFunction<String, String, Integer>() {

public Tuple2<String, Integer> call(String s) throws Exception {

return new Tuple2<String, Integer>(s,1);

}

});

JavaPairRDD<String,Integer> counts = ones

.reduceByKey(new Function2<Integer, Integer, Integer>() {

public Integer call(Integer arg0, Integer arg1) throws Exception {

return arg0 + arg1;

}

});

List<Tuple2<String,Integer>> output = counts.collect();

for (Tuple2<String,Integer> tuple2 : output){

System.out.println(tuple2._1() + " : " + tuple2._2());

}

jsp.stop();

}

}

Spark运行机制及原理分析

WordCount执行的流程分析

需要看源码一步步看。

Spark提交任务的流程

Spark是一个快速、通用的大数据分析引擎,对比Hadoop MapReduce,Spark基于内存计算速度提升100倍,硬盘计算也快10倍。Spark具备易用性,支持Java、Python和Scala API,提供批处理、交互式查询、实时流处理、机器学习和图计算的统一解决方案。Spark兼容Hadoop生态系统,可部署在Standalone、YARN或Mesos上,并支持EC2。本文介绍了Spark的体系结构、安装部署、高可用实现及WordCount执行流程。

Spark是一个快速、通用的大数据分析引擎,对比Hadoop MapReduce,Spark基于内存计算速度提升100倍,硬盘计算也快10倍。Spark具备易用性,支持Java、Python和Scala API,提供批处理、交互式查询、实时流处理、机器学习和图计算的统一解决方案。Spark兼容Hadoop生态系统,可部署在Standalone、YARN或Mesos上,并支持EC2。本文介绍了Spark的体系结构、安装部署、高可用实现及WordCount执行流程。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?