实验环境:

Win7操作系统

Eclipse3.7

JDK 1.7

centos 6.4

Hadoop2.2.0

hadoop-eclipse-plugin-2.2.0.jar

Eclipse用来开发Hadoop项目的插件 可以从GitHub上面下载下来,地址如下:

下载hadoop2x-eclipse-plugin

https://github.com/winghc/hadoop2x-eclipse-plugin

使用Ant工具来编译,我直接从CSDN上找到了一个已经编译过的Hadoop2x-eclipse-plugin的插件,省去了编译的功夫。假设此时linux环境已经搭建好了,Hadoop在Linux下的配置也已经OK。

操作步骤:

1.将Hadoop2x-eclipse-plugin.jar插件放入到Eclipse安装目录下的Plugin目录下即可。同时将从Hadoop官网下载下来的hadoop-2.2.0.tar.gz放到Win7的磁盘上面。重启Eclipse。

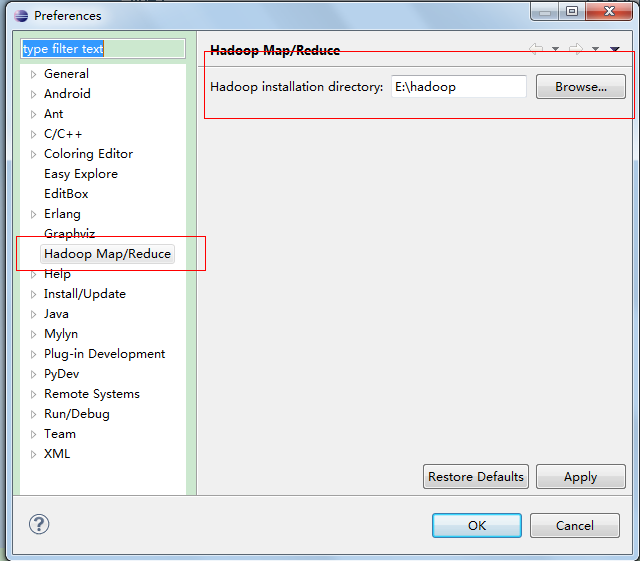

打开菜单Window–Preference可以看到Hadoop Map/Reduce,对其进行进行配置,Hadoop install directory为Win7系统下Hadoop2.2.0.tar.gz文件解压后的目录文件,如下图所示:

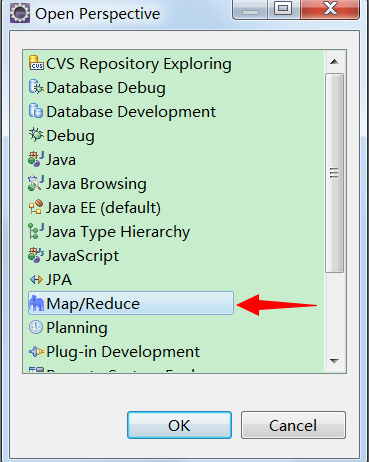

2.配置Map/Reduce Locations,打开Windows–>Open Perspective–>Other 可以看到如下图:

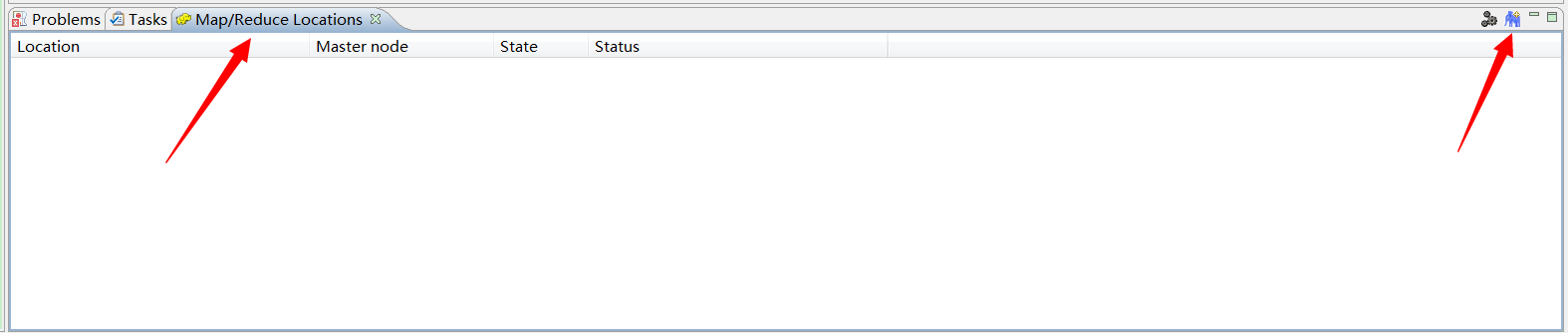

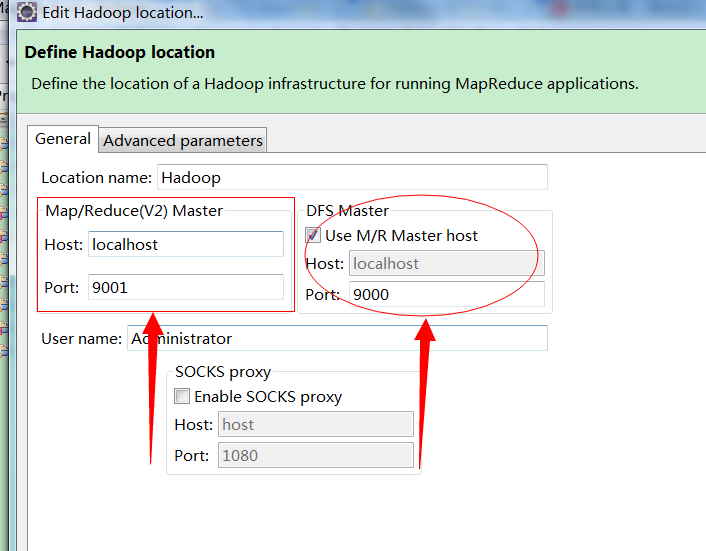

选择Map/reduce之后再Eclipse的控制台中会出现一栏为Map/Reduce Locations,可以通过右键new Hadoop location 或者是点击小象图标,打开Hadoop Location配置窗口,如下图所示:

3.配置连接Hadoop Location

在Hadoop2之前Map/Reduce(V2)Master 为Map/Reduce 代表的是Hadoop1.0 ,配置Host和port是根据Marped.site.xml中的

<name>mapred.job.tracker</name>

<value>hdfs://localhost:9001</value>故此此处的配置和DFS Master配置一样根据Hadoop中的core-site.xml.而Location name的取名随意。

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

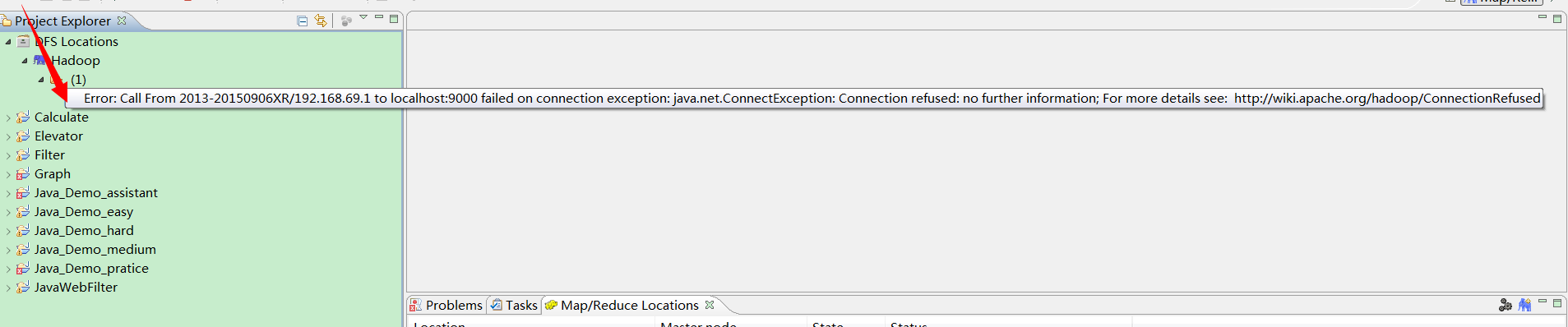

</property>可是在点击finish之后发现会报如下

Call to 192.168.69.1/192.168.69.102:9000 failed on connection exception: java.net.ConnectException: Connection refused: no further information

能由于是在Win7操作系统中,localhost映射为127.0.0.1可能会出错,所以可以有两种解决方法:

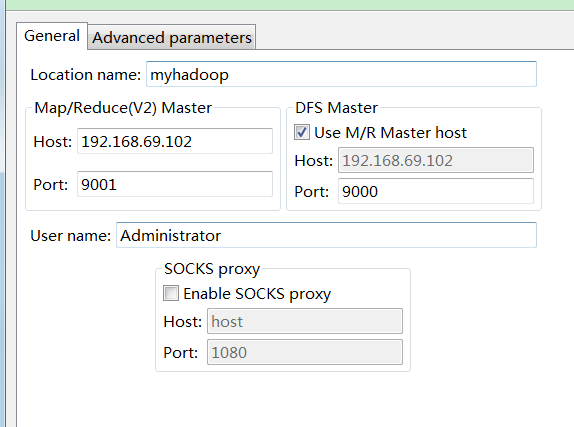

1.把配置中的Host修改为centos中的静态Ip地址

2.在C:/windows/system32/drivers/etc/hosts,下进行地址映射。

我采用了前者,如下图所示:

注:192.168.69.102位虚拟机下centos的IP地址。

在centos中对hadoop的配置文件:hdfs-site.xml 和 core-site.xml 和 mapred-site.xml进行value值的修改

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>修改为:

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.69.102:9000</value>

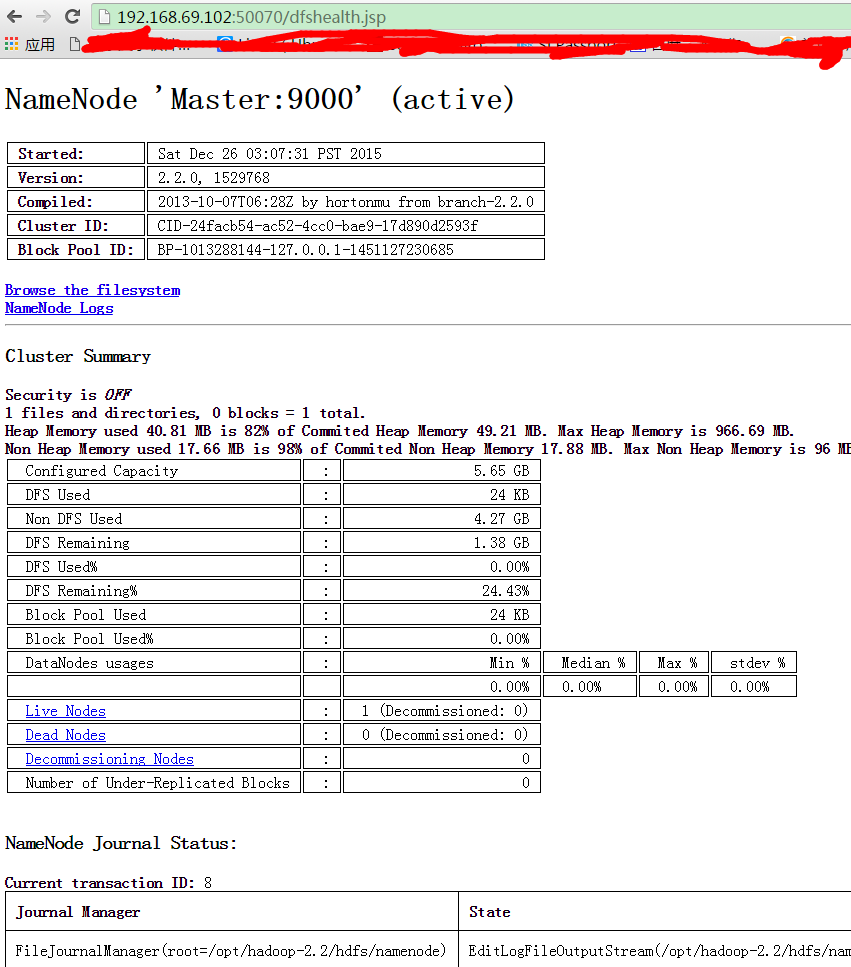

</property>于是当我尝试在win7下访问192,168.69.102:50070 是可以访问的:

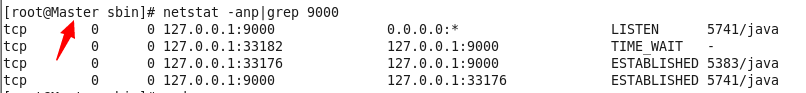

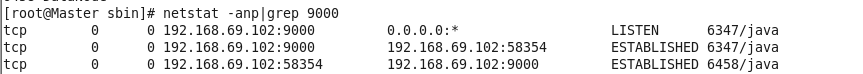

但是访问192.168.69.102:9000提示访问失败,于是怀疑是否是centos下9000段扣是否开启或者是被占用了。于是乎在centos下输入命令:netstat -anp|grep 9000

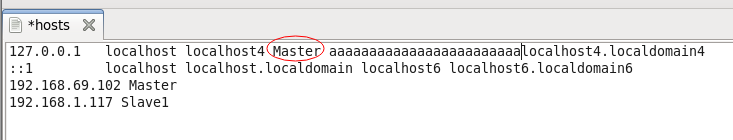

可以看到9000端口处于开启状态,但是用来监听127.0.0.1,于是乎打算kill这个进程,但是发现,kill后,namenode进程也被kill掉了。看来是ip解析的问题,看一下namenode的hosts文件。

只需要把红圈部分的Master注释掉就行了,然后重启hdfs后检查一下端口监听情况:

此时:

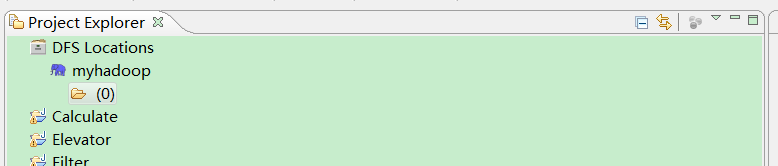

连接成功

在连接中又还有可能会报此错误,权限错误:

Error: Permission denied: user=root,access=READ_EXECUTE,inode=”/tmp”;hadoop:supergroup:drwx。。。

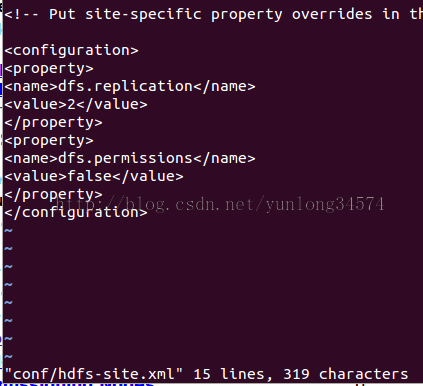

修改下hadoop的配置文件hdfs-site.xml

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?