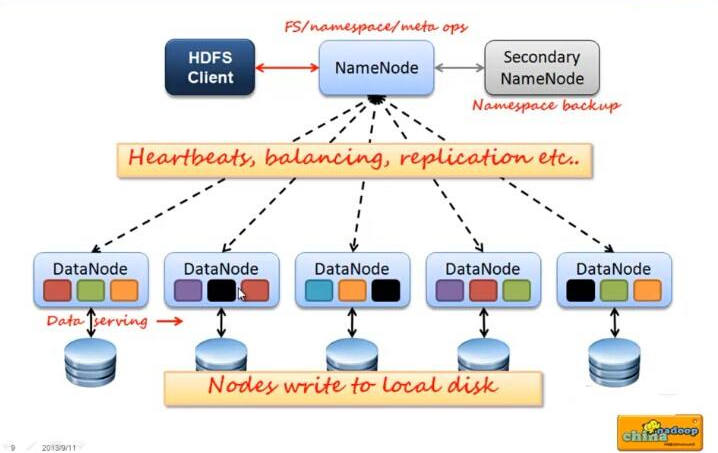

1. 框架图

在hadoop当中,分布式文件系统(HDFS),对文件系统有一个抽象,HDFS属于当中的一个实现类,也就是说分布式文件系统类似于一个接口,定义了标准,下面有很多的实现类,其中HDFS是一个子实现类而已,但是现在很多人都只知道一种就是HDFS的实现,并没有了解过其他的实现类,其实分布式文件系统的实现有很多种。

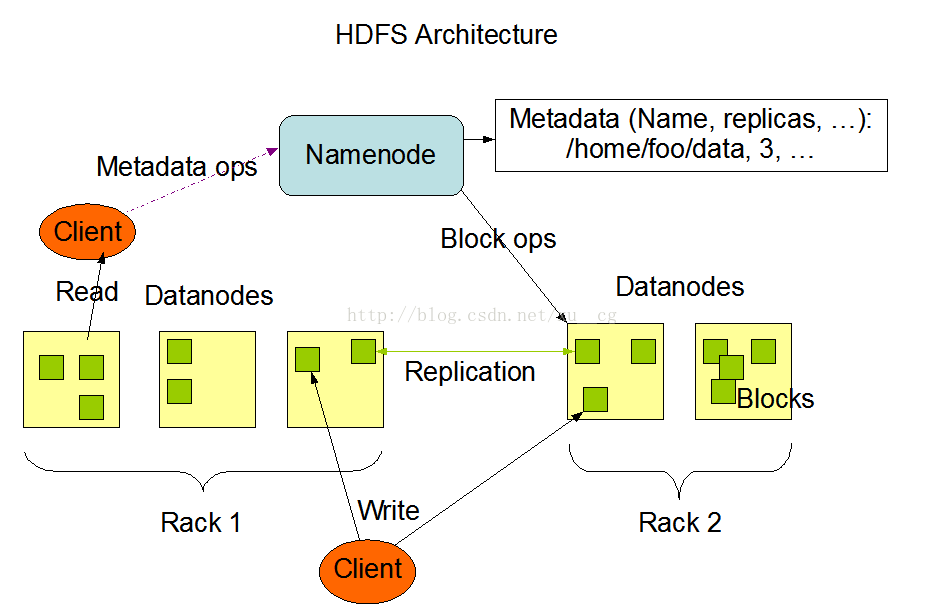

2. block块存储及副本机制

(1)block块

所有的文件都是以block块的方式存放在HDFS文件系统当中。默认块大小:

| hadoop1.x | hadoop2.x | hadoop3.x |

|---|---|---|

| 64M | 128M | 256M |

在hdfs-site.xml可以配置其大小

<property>

<name>dfs.block.size</name>

<value>块大小 以字节为单位</value>//只写数值就可以

</property>

数据抽象成块的好处

- 可以解决大于磁盘的文件

- 简化存储子系统

- 块,适合数据的备份

块缓存

通常DataNode从磁盘中读取块,但对于访问频繁的文件,其对应的块可能被显示的缓存在DataNode的内存中,以堆外块缓存的形式存在。默认情况下,一个块仅缓存在一个DataNode的内存中,当然可以针对每个文件配置DataNode的数量。作业调度器通过在缓存块的DataNode上运行任务,可以利用块缓存的优势提高读操作的性能。(其典型应用是join连接)

hdfs的文件权限校验

hdfs的文件权限机制和linux系统相似。HDFS文件权限的目的,防止好人做错事,而不是阻止坏人做坏事。HDFS相信你告诉我你是谁,你就是谁。

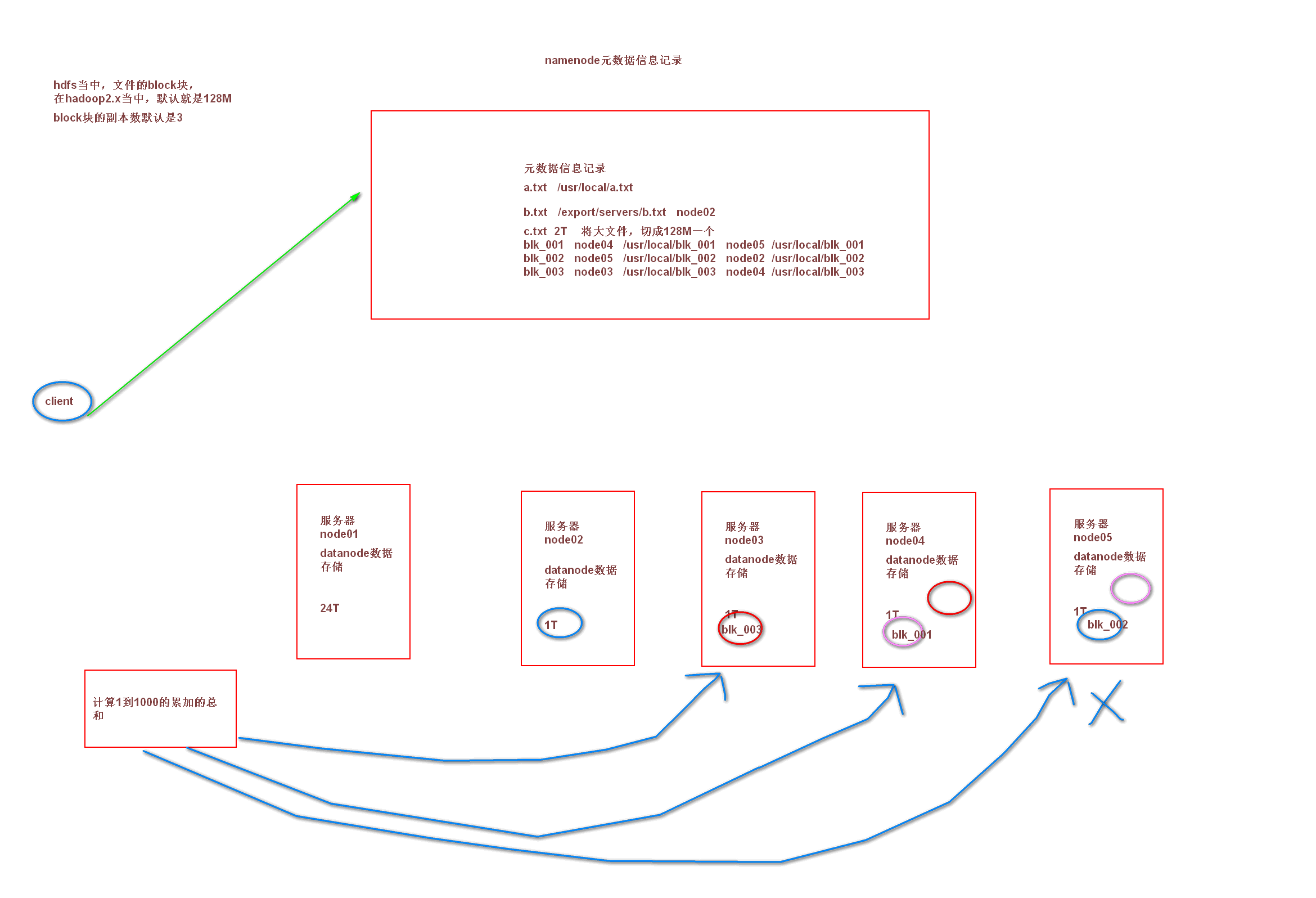

3. 元信息的处理

namenode就一个的时候,所有的元数据信息都保存在了FsImage与Eidts文件当中(其内存中也有一份),这两个文件就记录了所有的数据的元数据信息,元数据信息的保存目录配置在了hdfs-site.xml。

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/namenodeDatas</value>

</property>

<property>

<name>dfs.namenode.edits.dir</name>

<value>file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/edits</value>

</property>

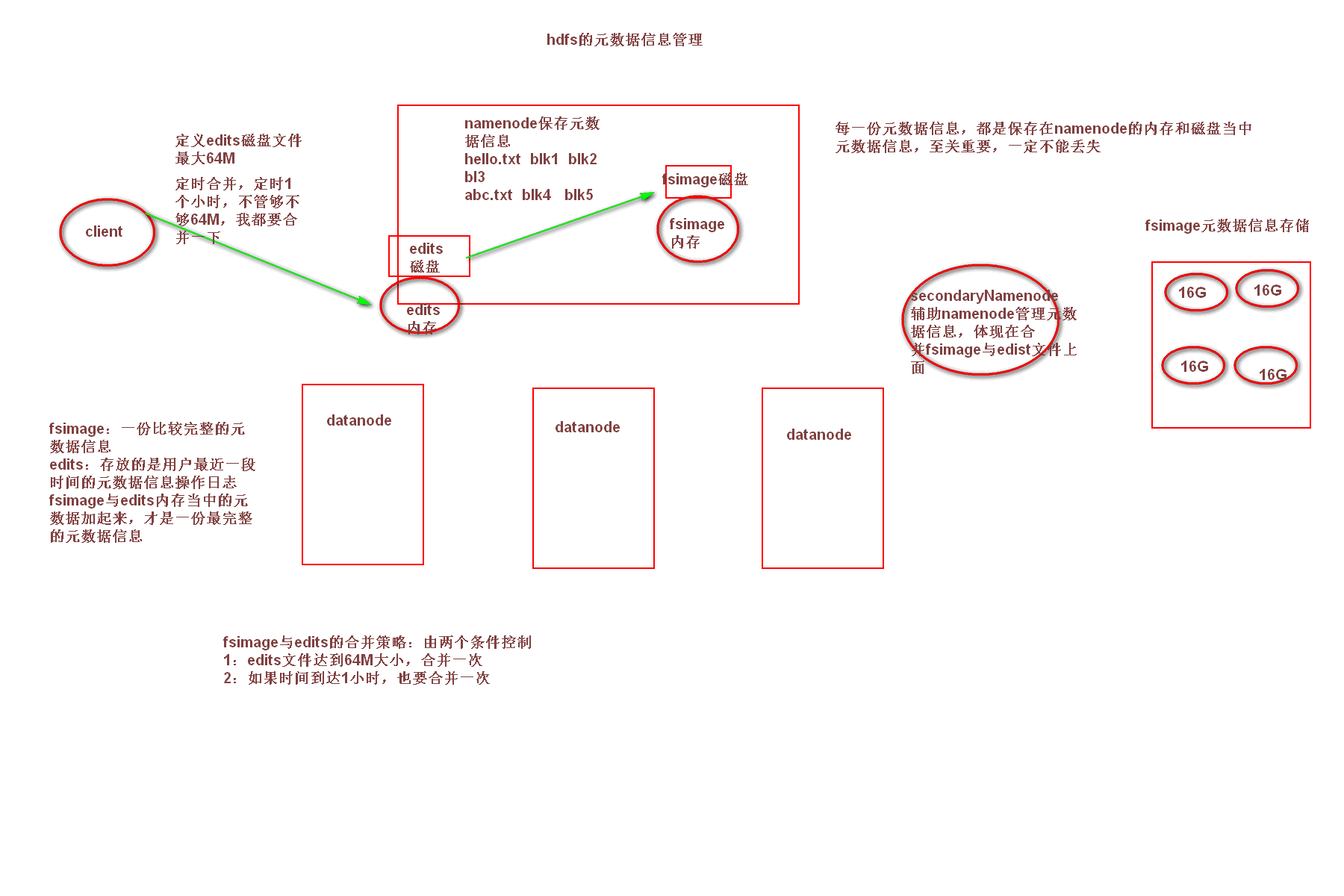

3.1 fsimage和edits

客户端对hdfs进行写文件时会首先被记录在edits文件中。edits修改时元数据也会更新。每次hdfs更新时edits先更新后客户端才会看到最新信息。

fsimage : 是namenode中关于元数据的镜像,一般称为检查点。fsimage内容包含了namenode管理下的所有datanode中文件及文件block及block所在的datanode的元数据信息。随着edits内容增大,就需要在一定时间点和fsimage合并。

一般开始时对namenode的操作都放在edits中,为什么不放在fsimage中呢?

因为fsimage是namenode的完整的镜像,内容很大,如果每次都加载到内存的话生成树状拓扑结构,这是非常耗内存和CPU。

FSimage文件当中的文件信息查看

hdfs oiv -i fsimage文件 -p XML -o 转换后的文件名.xml

edits当中的文件信息查看

hdfs oev -i edits文件 -o 转换后的文件.xml -p XML

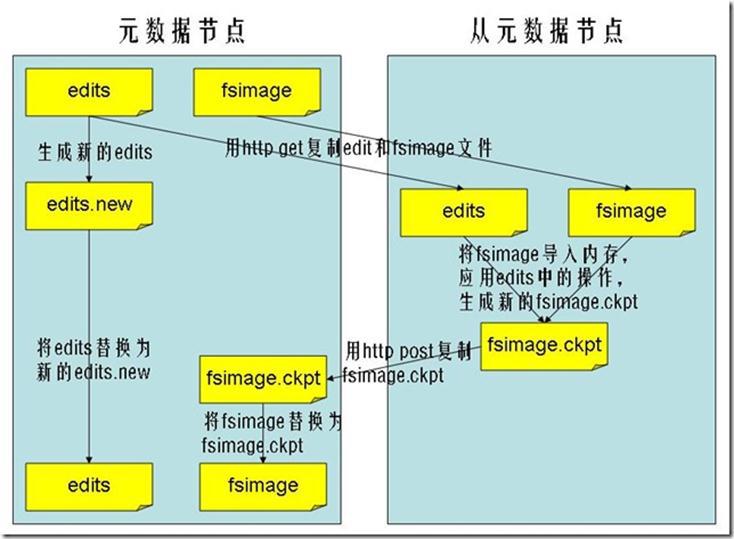

3.2 secondaryNameNode合并fsimage、edits

- secnonaryNN通知NameNode切换editlog

- secondaryNN从NameNode中获得FSImage和editlog(通过http方式)

- secondaryNN将FSImage载入内存,然后开始合并editlog,合并之后成为新的fsimage

- secondaryNN将新的fsimage发回给NameNode

- NameNode用新的fsimage替换旧的fsimage

fs.checkpoint.period: 默认是一个小时(3600s)

fs.checkpoint.size: edits达到一定大小时也会触发合并(默认64MB)

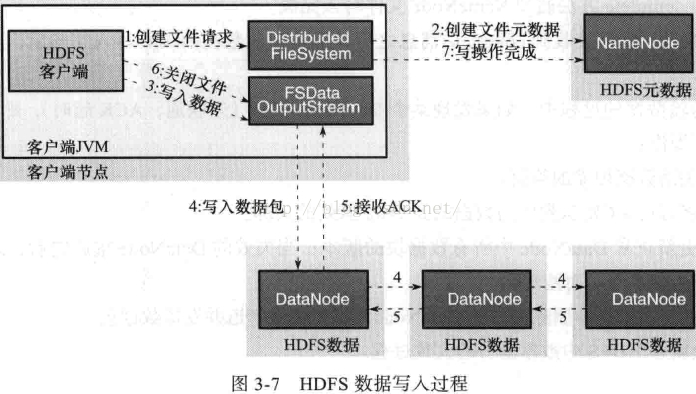

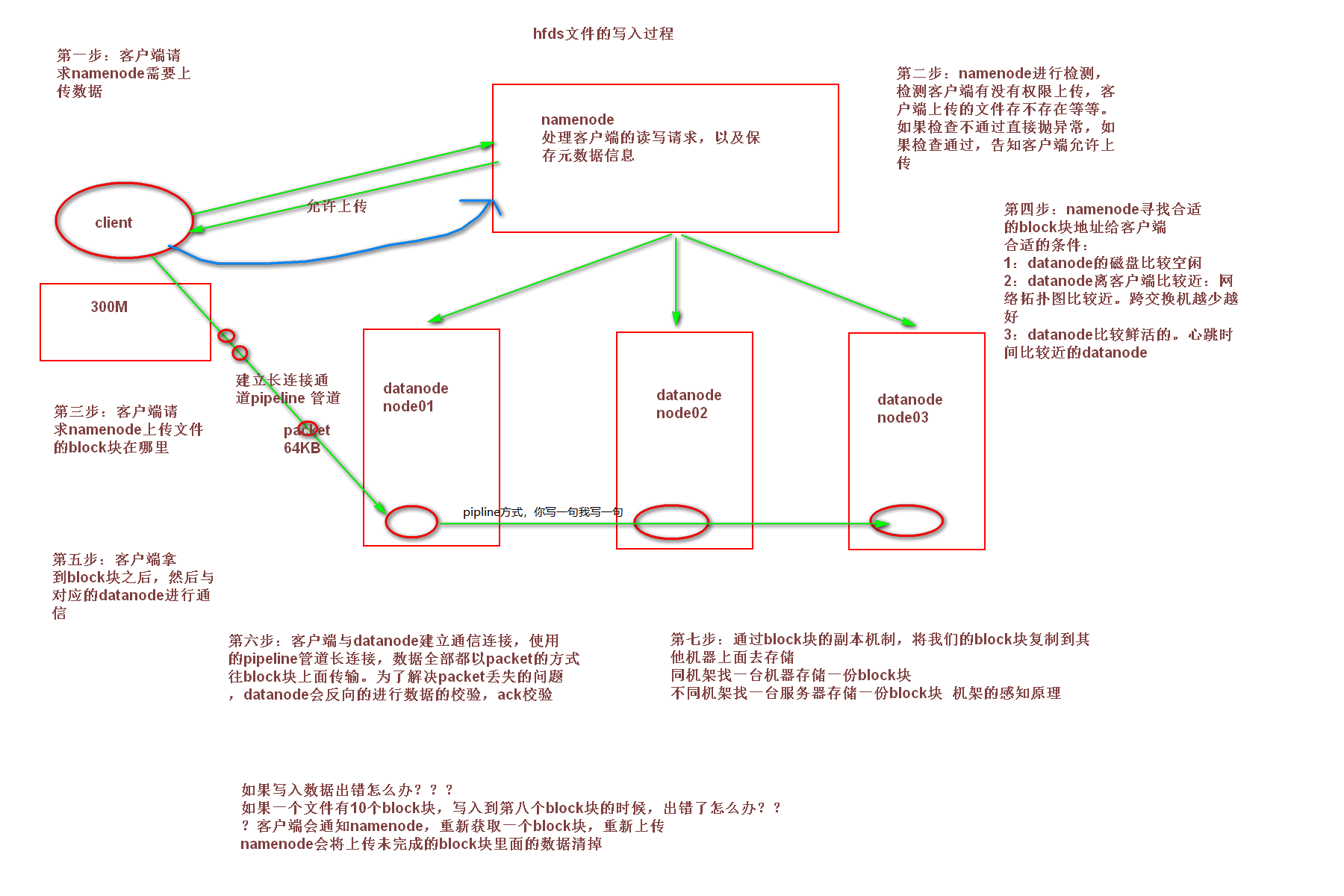

4. 文件的写入过程

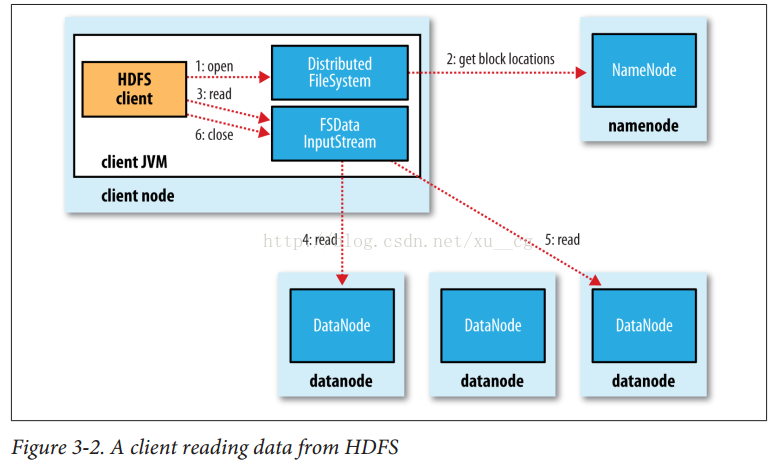

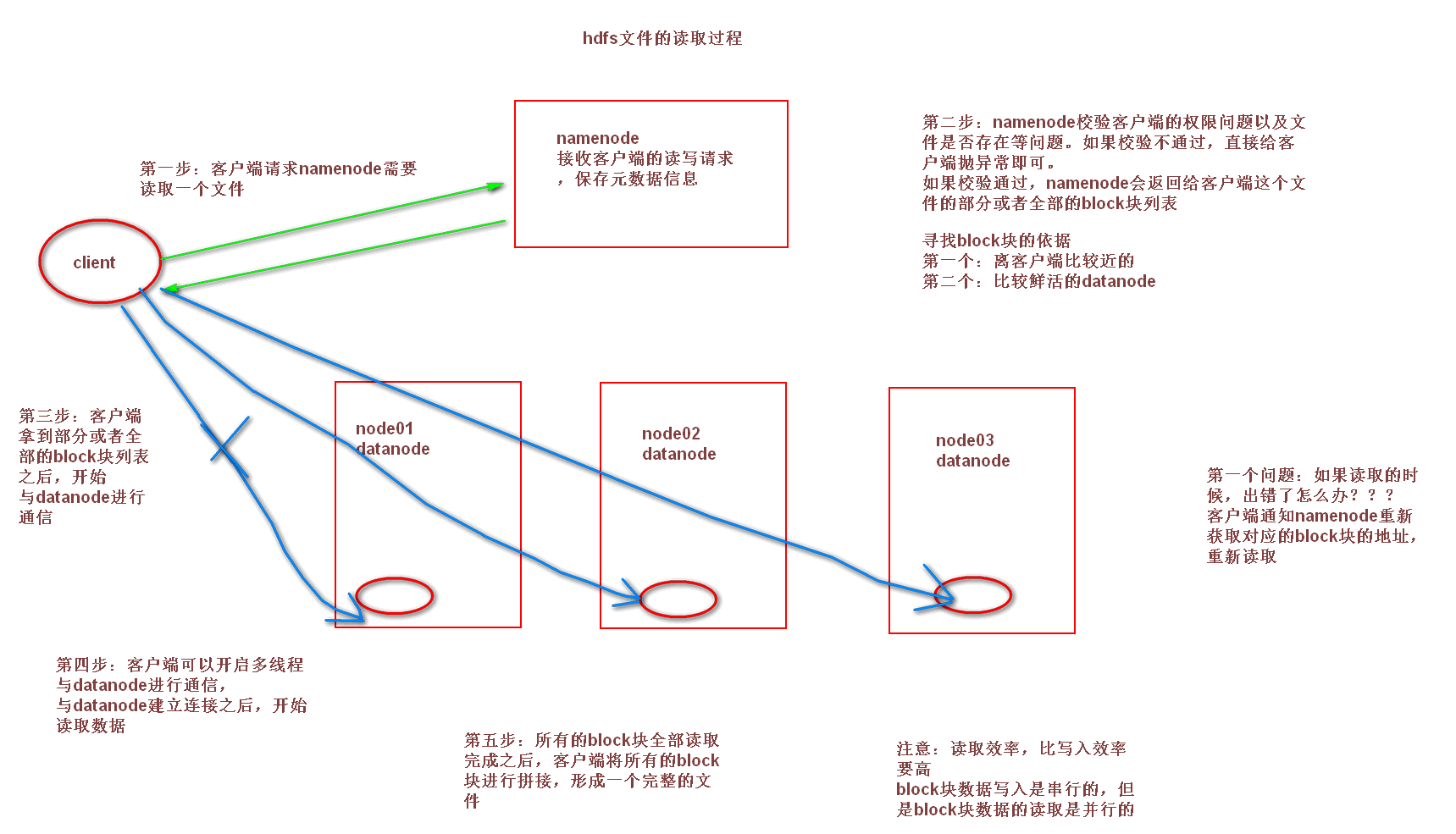

5. 文件的读取过程

6. 文件的API操作

由于cdh版本的所有的软件涉及版权的问题,所以并没有将所有的jar包托管到maven仓库当中去,而是托管在了CDH自己的服务器上面,所以我们默认去maven的仓库下载不到,需要自己手动的添加repository去CDH仓库进行下载,以下两个地址是官方文档说明,请仔细查阅。

https://www.cloudera.com/documentation/enterprise/release-notes/topics/cdh_vd_cdh5_maven_repo.html

https://www.cloudera.com/documentation/enterprise/release-notes/topics/cdh_vd_cdh5_maven_repo_514x.html

<repositories>

<repository>

<id>cloudera</id>

<url>https://repository.cloudera.com/artifactory/cloudera-repos/</url>

</repository>

</repositories>

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.6.0-mr1-cdh5.14.0</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.6.0-cdh5.14.0</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.6.0-cdh5.14.0</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>2.6.0-cdh5.14.0</version>

</dependency>

<!-- https://mvnrepository.com/artifact/junit/junit -->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.11</version>

<scope>test</scope>

</dependency>

<dependency>

<groupId>org.testng</groupId>

<artifactId>testng</artifactId>

<version>RELEASE</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.0</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

<encoding>UTF-8</encoding>

<!-- <verbal>true</verbal>-->

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>2.4.3</version>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<minimizeJar>true</minimizeJar>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>

6.1 使用url方式访问数据

public void demo1()throws Exception{

//第一步:注册hdfs 的url,让java代码能够识别hdfs的url形式

URL.setURLStreamHandlerFactory(new FsUrlStreamHandlerFactory());

InputStream inputStream = null;

FileOutputStream outputStream =null;

//定义文件访问的url地址

String url = "hdfs://192.168.75.103:8020/test/input/install.log";

//打开文件输入流

try {

inputStream = new URL(url).openStream();

outputStream = new FileOutputStream(new File("c://hello.txt"));

IOUtils.copy(inputStream, outputStream);

} catch (IOException e) {

e.printStackTrace();

}finally {

IOUtils.closeQuietly(inputStream);

IOUtils.closeQuietly(outputStream);

}

}

6.2 使用文件系统访问数据

- 方式一

public void getFileSystem1() throws URISyntaxException, IOException {

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.75.103:8020"), configuration);

System.out.println(fileSystem.toString());

}

- 方式二

public void getFileSystem2() throws URISyntaxException, IOException {

Configuration configuration = new Configuration();

configuration.set("fs.defaultFS","hdfs://192.168.75.103:8020");

FileSystem fileSystem = FileSystem.get(new URI("/"), configuration);

System.out.println(fileSystem.toString());

}

- 方式三

public void getFileSystem3() throws URISyntaxException, IOException {

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.newInstance(new URI("hdfs://192.168.52.100:8020"), configuration);

System.out.println(fileSystem.toString());

}

- 方式四

public void getFileSystem4() throws Exception{

Configuration configuration = new Configuration();

configuration.set("fs.defaultFS","hdfs://192.168.52.100:8020");

FileSystem fileSystem = FileSystem.newInstance(configuration);

System.out.println(fileSystem.toString());

}

6.3 遍历文件系统中的文件

- 方式一

public void listFile() throws Exception{

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.75.103:8020"), new Configuration());

FileStatus[] fileStatuses = fileSystem.listStatus(new Path("/"));

for (FileStatus fileStatus : fileStatuses) {

if(fileStatus.isDirectory()){

Path path = fileStatus.getPath();

listAllFiles(fileSystem,path);

}else{

System.out.println("文件路径为"+fileStatus.getPath().toString());

}

}

}

public void listAllFiles(FileSystem fileSystem,Path path) throws Exception{

FileStatus[] fileStatuses = fileSystem.listStatus(path);

for (FileStatus fileStatus : fileStatuses) {

if(fileStatus.isDirectory()){

listAllFiles(fileSystem,fileStatus.getPath());

}else{

Path path1 = fileStatus.getPath();

System.out.println("文件路径为"+path1);

}

}

}

- 方式二

public void listMyFiles()throws Exception{

//获取fileSystem类

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.75.103:8020"), new Configuration());

//获取RemoteIterator 得到所有的文件或者文件夹,第一个参数指定遍历的路径,第二个参数表示是否要递归遍历

RemoteIterator<LocatedFileStatus> locatedFileStatusRemoteIterator = fileSystem.listFiles(new Path("/"), true);

while (locatedFileStatusRemoteIterator.hasNext()){

LocatedFileStatus next = locatedFileStatusRemoteIterator.next();

System.out.println(next.getPath().toString());

}

fileSystem.close();

}

6.4 下载文件到本地

public void getFileToLocal()throws Exception{

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.75.103:8020"), new Configuration());

FSDataInputStream open = fileSystem.open(new Path("/test/input/install.log"));

FileOutputStream fileOutputStream = new FileOutputStream(new File("c://install.log"));

IOUtils.copy(open,fileOutputStream );

IOUtils.closeQuietly(open);

IOUtils.closeQuietly(fileOutputStream);

fileSystem.close();

6.5 创建文件夹

public void mkdirs() throws Exception{

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.75.103:8020"), new Configuration());

boolean mkdirs = fileSystem.mkdirs(new Path("/hello/mydir/test"));

fileSystem.close();

}

6.6 文件上传

public void putData() throws Exception{

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.75.103:8020"), new Configuration());

fileSystem.copyFromLocalFile(new Path("file:///c://install.log"),new Path("/hello/mydir/test"));

fileSystem.close();

}

6.7 权限问题

权限控制在hdfs-site.xml(所有节点上的配置文件都需要修改)

<property>

<name>dfs.permissions</name>

<value>true</value>

</property>

代码中就需要加入对应的用户

public void getConfig()throws Exception{

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.75.103:8020"), new Configuration(),"root ");

fileSystem.copyToLocalFile(new Path("/config/core-site.xml"),new Path("file:///c:/core-site.xml"));

fileSystem.close();

}

6.8 小文件的合并

这里实现的是上传时的小文件合并(个人更倾向于理解为这是流的方式实现文件的合并)

public void mergeFile() throws Exception{

//获取分布式文件系统

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.75.103:8020"), new Configuration(),"root");

FSDataOutputStream outputStream = fileSystem.create(new Path("/bigfile.xml"));

//获取本地文件系统

LocalFileSystem local = FileSystem.getLocal(new Configuration());

//通过本地文件系统获取文件列表,为一个集合

FileStatus[] fileStatuses = local.listStatus(new Path("file:///F://上传小文件合并"));

for (FileStatus fileStatus : fileStatuses) {

FSDataInputStream inputStream = local.open(fileStatus.getPath());

IOUtils.copy(inputStream,outputStream);

IOUtils.closeQuietly(inputStream);

}

IOUtils.closeQuietly(outputStream);

local.close();

fileSystem.close();

}

125

125

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?