dataflow

在你开始之前

- 选择或创建一个Cloud Platform Console项目。

转到项目页面 - 为您的项目启用结算。

启用帐单 - 启用Cloud Dataflow,Compute Engine,Cloud Logging,Cloud Storage,Cloud Storage JSON,BigQuery,Cloud Pub / Sub和Cloud Datastore API。

启用API - 安装Cloud SDK 。

- 使用Google Cloud Platform验证

gcloud:gcloud init - 创建一个云存储桶:

- 在Cloud Platform Console中,转到Cloud Storage浏览器。

转到云存储浏览器 - 点击创建存储区 。

- 在“ 创建存储桶”对话框中,指定以下属性:

- 名称 :唯一的存储桶名称。 存储桶名称中请勿包含敏感信息,因为存储桶名称空间是全局的并且是公开可见的。

- 储藏等级 :标准

- 所在地 :美国

- 点击创建 。

- 在Cloud Platform Console中,转到Cloud Storage浏览器。

- 下载并安装Java Development Kit(JDK) 1.7版或更高版本。 验证是否已设置JAVA_HOME环境变量并指向您的JDK安装。

- 按照适用于您特定操作系统的Maven 安装指南 ,下载并安装Apache Maven 。

马丁·高纳(Martin Gorner)将在伦敦JAX上发表两个演讲。

创建一个包含Java的Cloud Dataflow SDK和示例的Maven项目

- 使用Maven原型插件创建一个包含Java的Cloud Dataflow SDK的Maven项目。 在您的Shell或终端中运行

mvn archetype:generate命令,如下所示:mvn archetype:generate \ -DarchetypeArtifactId=google-cloud-dataflow-java-archetypes-examples \ -DarchetypeGroupId=com.google.cloud.dataflow \ -DgroupId=com.example \ -DartifactId=first-dataflow \ -Dversion="[1.0.0,2.0.0]" \ -DinteractiveMode=false \ -Dpackage=com.google.cloud.dataflow.examples

- 使用Maven原型插件创建一个包含Java的Cloud Dataflow SDK的Maven项目。 在您的Shell或终端中运行

运行命令后,您应该在当前目录下看到一个名为first-dataflow的新目录。 first-dataflow包含一个Maven项目,该项目包括Java的Cloud Dataflow SDK和示例管道。

在Cloud Dataflow服务上运行示例管道

- 转到

first-dataflow/目录。 - 通过在Shell或终端窗口中使用

mvn compile exec:java命令,在Cloud Dataflow托管服务上构建并运行名为WordCount的Cloud Dataflow示例管道。 对于--project变量,您需要为创建的Cloud Platform项目指定Project ID。 对于--stagingLocation和--output参数,您需要指定在路径中创建的Cloud Storage存储桶的名称,例如,如果您的Cloud Platform Project ID是my-cloud-project而您的Cloud存储桶名称为my-wordcount-storage-bucket ,输入以下命令以运行WordCount管道:mvn compile exec:java \ -Dexec.mainClass=com.google.cloud.dataflow.examples.WordCount \ -Dexec.args="--project=<my-cloud-project> \ --stagingLocation=gs://<my-wordcount-storage-bucket>/staging/ \ --output=gs://<your-bucket-id>/output \ --runner=BlockingDataflowPipelineRunner" - 检查您的工作是否成功:

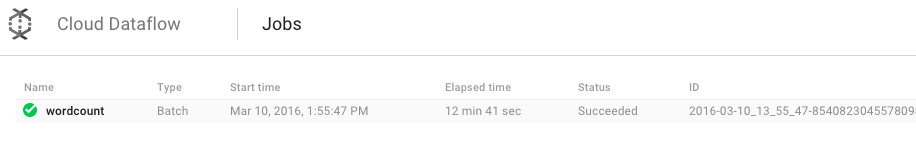

- 在Google Cloud Platform Console中打开Cloud Dataflow Monitoring UI。

转到Cloud Dataflow Monitoring UI

首先,您应该看到单词计数作业的状态为“正在运行” ,然后显示“ 成功” :

- 在Google Cloud Platform Console中打开Cloud Dataflow Monitoring UI。

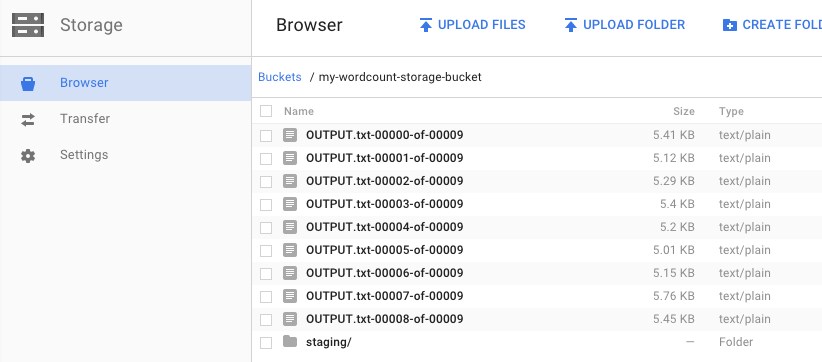

- 在Google Cloud Platform Console中打开Cloud Storage Browser。 转到云存储浏览器

在存储桶中,您应该看到作业创建的输出文件和登台文件:

清理

为避免在此快速入门中对您的Google Cloud Platform帐户产生费用,请执行以下操作:

- 在Google Cloud Platform Console中打开Cloud Storage浏览器 。

- 选中您创建的存储桶旁边的复选框。

- 单击删除 。

- 单击删除以永久删除存储桶及其内容。

翻译自: https://jaxenter.com/cloud-dataflow-quickstart-in-java-128647.html

dataflow

3598

3598

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?