-

对象存储介绍之:S3 WORM

S3 object lock,也被称为对象存储的WORM特性:write-once-read-many。这个特性主要目的是确保object在设定的时间内永远不会被删除或者覆盖。其主要的应用场景就是数据保护场景,例如法规遵从。

3 object lock 提供了两种模式:

retention period:对象保存一定的时间,在这段时间内不允许删除或者覆盖。

Legal hold:和retention period类似,只是没有保护时间期限。

两种模式是相互独立的不冲突,一个对象可以同时拥有两种模式的锁。

Object Lock只能工作在 versioned buckets模式下,也就是Object Lock的bucket必须开启多版本功能。如果bucket没有开启多版本,设置了Object lock的模式下也会自动开启多版本。Object Lock的是绑定在特定版本对象上的。

retention period

Governance mode 在这种模式下,大部分user都没有权限去删除该对象。但是部分用户拥有该权限。

Compliance mode:任何人,包括root用户都没有权限去删除对象。rentention mode 和 retention period 也不能修改。

保存的时间:

在retention period模式下,可以设置一个过期的时间。这个时间如果在put object时没有设置,就使用bucekt 默认的到期时间。用户也可以延长到期时间,但只能延长。

到期时间的计算:对象创建的时间+设置的时间

-

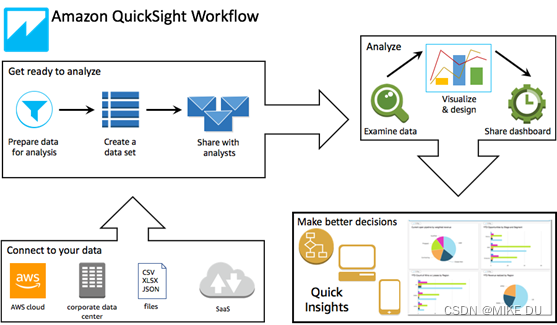

什么是 Amazon QuickSight?

Amazon QuickSight 是一种云级商业智能(BI)服务,无论共事之人身处何地,都可提供易于理解的见解。Amazon QuickSight 会连接到您在云中的数据,并合并众多不同来源的数据。在单个数据控制面板中,QuickSight 可以包含亚马逊云科技数据、第三方数据、大数据、电子表格数据、SaaS 数据、B2B 数据等。作为一项完全托管式云服务,Amazon QuickSight 提供企业级安全性、全球可用性和内置冗余。此外还提供将用户数从 10 个扩展到 1 万个所需的管理工具,无需部署或管理任何基础架构。

-

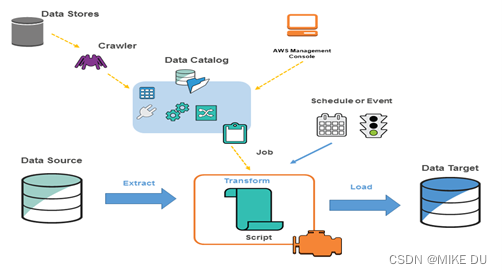

什么是AWS Glue

WS Glue 是一项完全托管的提取、转换和加载 (ETL) 服务,让客户能够轻松准备和加载数据进行分析。您只需在 AWS 管理控制台中单击几次,即可创建并运行 ETL 作业。您只需将 AWS Glue 指向存储在 AWS 上的数据,AWS Glue 便会发现您的数据,并将关联的元数据 (例如表定义和架构) 存储在 AWS Glue 数据目录中。存入目录后,您的数据可立即供 ETL 搜索、查询和使用。AWS Glue 可生成代码执行数据转换和数据加载流程

AWS Glue 可生成可自定义、可重复使用且可移植的 Python 代码。ETL 作业准备就绪后,您便可以安排它在 AWS Glue 完全托管的横向扩展 Apache Spark 环境中运行。AWS Glue 可提供一个具有依赖关系解析、作业监控和警报功能的灵活计划程序。

一、什么是AWS Glue

AWS Glue 是一项无服务器数据集成服务,可让使用分析功能的用户轻松发现、准备、移动和集成来自多个来源的数据。您可以将其用于分析、机器学习和应用程序开发。它还包括用于编写、运行任务和实施业务工作流程的额外生产力和数据操作工具。

AWS Glue 将主要数据集成功能整合到一项服务中。其中包括数据发现、现代 ETL、清理、转换和集中式编目。这也是一项无服务器服务,即无需管理基础设施。通过在一项服务中灵活支持 ETL、ELT 和流式传输之类的所有工作负载,AWS Glue 可为不同工作负载和类型的用户提供支持。

二、 AWS Glue 环境的架构

以在 AWS Glue 中定义作业以完成所需的工作从数据源提取、转换和加载 (ETL) 数据到数据目标。通常 执行以下操作:

对于数据存储源,可以定义一个爬网程序来填充 包含元数据表定义的 AWS Glue 数据目录。将爬网程序指向数据存储, 爬网程序在数据目录中创建表定义。对于流式传输源,手动定义数据目录表并指定数据流属性。

除了表定义之外,AWS Glue 数据目录还包含其他元数据,这些元数据是需要定义 ETL 作业。在将作业定义为 转换数据。

AWS Glue 可以生成脚本来转换您的数据。或者,可以提供 AWS Glue 控制台或 API 中的脚本。 可以按需运行作业,也可以将其设置为在发生指定触发器时启动。触发器可以是基于时间的计划,也可以是 一个事件。

作业运行时,脚本会从数据源中提取数据,转换数据,并将其加载到数据目标。该脚本在Apache Spark中运行 AWS Glue 中的环境

-

什麼是 AWS Lake Formation

AWS Lake Formation協助您集中控管、保護並全球共用資料,以進行分析和機器學習。使用 Lake Formation,您可以在 Amazon Simple Storage Service (Amazon S3) 及其中的中AWS Glue Data Catalog繼資料上管理資料湖資料的精細存取控制。

Lake Formation 提供了自己的許可模型來增強 IAM 許可模型。Lake Formation 權限模型可透過簡單的授權或撤銷機制,對儲存在資料湖中的資料進行細粒度存取,就像關聯式資料庫管理系統 (RDBMS) 一樣。使用跨AWS分析和機器學習服務 (包括亞馬遜雅典娜、Amazon Amazon Redshift Spectrum、Amazon EMR 和) 的欄、列和儲存格層級的精細控制來強制執行 Lake Formation 許可。Amazon QuickSight AWS Glue

Lake Formation 混合存取模式AWS Glue Data Catalog可讓您使用 Amazon S3 的 Lake Formation 許可和 IAM 許可政策和AWS Glue動作來保護和存取已編目的資料。透過混合式存取模式,資料管理員可以選擇性地逐步上載 Lake Formation 權限,一次專注於一個資料湖使用案例。

-

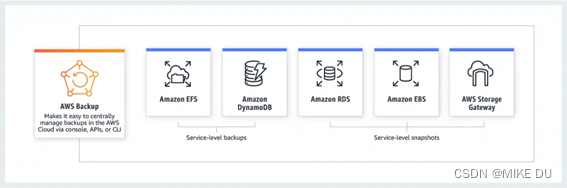

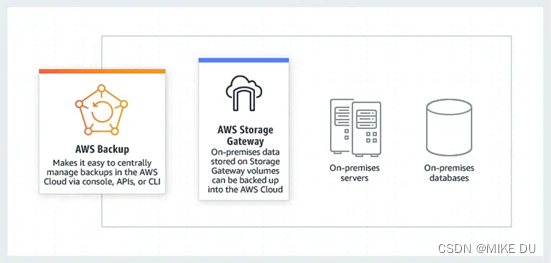

AWS Backup

AWS Backup 是一项完全托管的备份服务,提供了在 AWS 平台管理数据备份的集中场所,无需借助定制解决方案或手动流程。仅需在 AWS 管理控制面板上点击几下鼠标,即可制定相应策略,限定数据的备份频率和存储时间长短。然后,客户可将这些策略运用于 AWS 资源,AWS Backup 自动针对相应的 AWS 资源计划备份作业,在各项 AWS 服务之间进行编排并管理备份数据保留时限,从而自动处理其余事项。

云原生备份

AWS Backup 提供了一个集中式控制台,用于跨多种 AWS 服务自动执行和管理备份。AWS Backup 与 Amazon EBS、Amazon RDS、Amazon DynamoDB、Amazon EFS、Amazon EC2 和 AWS Storage Gateway 集成,使您能够备份关键数据存储,例如存储卷、数据库和文件系统

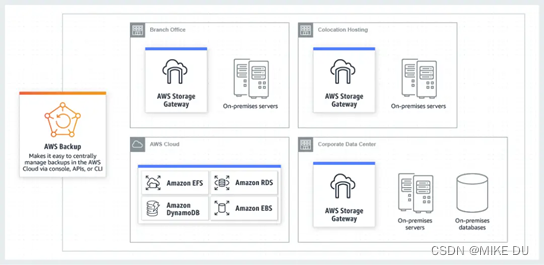

混合备份

AWS Backup 提供了在云端和本地备份应用程序数据的通用方法。AWS Backup 集成了 AWS Storage Gateway,后者是一种混合存储服务,您的本地应用程序可以借助它来无缝地使用 AWS 云存储。通过此集成,您可以将相同的备份策略应用于 AWS 云资源和存储在 AWS Storage Gateway 卷上的本地数据。

本地备份

AWS Backup 提供了在云端和本地备份应用程序数据的通用方法。AWS Backup 集成了 AWS Storage Gateway,后者是一种混合存储服务,您的本地应用程序可以借助它来无缝地使用 AWS 云存储。您可以使用 AWS Backup 备份存储在 AWS Storage Gateway 卷中的应用程序数据。AWS Storage Gateway 卷的备份安全存储在 AWS 云中,并与 Amazon EBS 兼容,从而允许您将卷恢复到 AWS 云或本地环境

-

AWS 常用CLI命令总结

AWS 常用CLI命令

对AWS服务操作可以通过管理控制台、各语言SDK、CLI以及API等方式。管理控制台最简单,可以直接通过Web界面操作,但是有些服务或者服务下的某些操作无法直接用控制台调用;API的方式最复杂,需要自己生成哈希值签署请求以及处理请求错误等低级别的操作,AWS 的大部分服务都提供REST的API以及类似于REST的查询API,API提供的服务操作是最新最全面的;SDK 的好处是封装好了请求签署与请求错误处理以及重试机制,用户只需要直接调用相关接口即可,但对于新的服务及操作的支持可能会滞后于API接口的发布。CLI 其实也可以看成SDK的一种,它是AWS 服务操作的一把瑞士军刀。本文针对项目实践中所用到的 AWS 服务的常用 CLI 命令进行一个简单总结,方便以后查阅。

EC2挂载 EBS

linux

查看块设备: lsblk

格式化磁盘: sudo mkfs -t ext4 /dev/xvdb

挂载卷: sudo mount /dev/xvdb /mnt/mydir

卸载卷: sudo umount /dev/xvdb

windows

diskpart

san policy=onlineall

list disk

disk yourdiskid

attributes disk clear readonly

online disk

实例操作

aws ec2 describe-instances

aws ec2 describe-instances --instance-ids "instanceid1" "instanceid2"

aws ec2 start-instances --instance-ids "instanceid1" "instanceid2"

aws ec2 stop-intances --instance-ids "instanceid1" "instanceid2"

aws ec2 run-instances --image-id ami-b6b62b8f --security-group-ids sg-xxxxxxxx --key-name mytestkey --block-device-mappings "[{\"DeviceName\": \"/dev/sdh\",\"Ebs\":{\"VolumeSize\":100}}]" --instance-type t2.medium --count 1 --subnet-id subnet-e8330c9c --associate-public-ip-address

(Note: 若不指定subnet-id则会在默认vpc中去选,此时若指定了非默认vpc的安全组会出现请求错误。如无特殊要求,建议安全组和子网都不指定,就不会出现这种问题。)

查看region与AZ

aws ec2 describe-region

aws ec2 describe-availability-zones --region region-name

查看实例元数据和用户数据

curl http://169.254.169.254/latest/meta-data/

curl http://169.254.169.254/latest/user-data/

查看ami

aws ec2 describe-images

key-pair

aws ec2 create-key-pair --key-name mykeyname

安全组

aws ec2 create-security-group --group-name mygroupname --description mydescription --vpc-id vpc-id (若不指定vpc,则在默认vpc中创建安全组)

aws ec2 authorize-security-group-ingress --group-id sg-xxxxyyyy --protocol tcp --port 22 --cidr 0.0.0.0/0

aws ec2 authorize-security-group-ingress --group-id sg-xxxxyyyy --protocol tcp --port 9999 --source-group sg-xxxxxxxx

AutoScaling

列出AS组

aws autoscaling describe-auto-scaling-groups

列出AS实例

aws autoscaling describe-auto-scaling-instances --instance-ids [instance-id-1 instance-id-2 ...]

从组中分离实例

aws autoscaling detach-instances --auto-scaling-group-name myasgroup --instance-ids instanceid1 instanceid2 [--should-decrement-desired-capacity|--no-should-decrement-desired-capacity]

附加实例到组

aws autoscaling attach-instances --auto-scaling-group-name myasgroup --instance-ids instanceid1 instanceid2

挂起AS流程

aws autoscaling suspend-process --auto-scaling-group-name myasgroup --scaling-processes AZRebalance|AlarmNotification|...

删除AS组

aws autoscaling delete-auto-scaling-group --auto-scaling-group-name myasgroup

S3查看

aws s3 ls

aws s3 ls s3://bucket

aws s3 ls s3://bucket/prefix

拷贝

aws s3 cp /to/local/path s3://bucket/prefix

aws s3 cp s3://bucket/prefix /to/local/path

aws s3 cp s3://bucket1/prefix1 s3://bucket2/prefix2

同步

aws sync [--delete] /to/local/dir s3://bucket/prefixdir

aws sync [--delete] s3://bucket/prefixdir /to/local/dir

aws sync [--delete] s3://bucket1/prefixdir1 s3://bucket2/prefixdir2

手动分片上传

文件分片

split -b 40m myfile myfile-part-

创建分片上传任务

aws s3api create-multipart-upload --bucket bucketname --key prefix

记录返回值

{

"Bucket": "bucketname",

"UploadId": "uploadeid",

"Key": "prefix"

}

上传分片

aws s3api upload-part --bucket bucketname --key prefix --part-number [分片上传编号(e.g. 1,2,3...)] --body myfile-[x] --upload-id uploadid

列出已上传分片,创建分片结构文件

aws s3api list-parts --bucket bucketname --key prefix --upload-id uploadid

结束分片上传任务

aws s3api complete-multipart-upload --multipart-upload file://temp --bucket bucketname --key prefix --upload-id uploadid

获取规范用户ID

aws s3api list-buckets --query 'Owner.ID'

AWSCLI 访问阿里云 OSS

aws configure --p aliyun #设置key与secret,其他默认

aws configure set s3.addressing_style virtual --p aliyun

aws s3 ls --endpoint-url [url/(e.g. http://oss-cn-hangzhou.aliyuncs.com)] --p aliyun

IAM

Role 操作

aws iam create-role MY-ROLE-NAME --assum-role-policy-document file://path/to/trustpolicy.json

aws iam put-role-policy --role-name MY-ROLE-NAME --policy-name MY-PERM-POLICY --policy-document file://path/to/permissionpolicy.json

aws iam create-instance-profile --instance-profile-name MY-INSTANCE-PROFILE

aws iam add-role-to-instance-profile --instance-profile-name MY-INSTANCE-PROFILE --role-name MY-ROLE-NAME

AUTO-SCALING

查看信息

aws autoscaling describe-auto-scaling-groups

aws autoscaling describe-auto-scaling-instances

STS

代入ROLE的EC2实例的临时认证信息

curl http://169.254.169.254/latest/meta-data/iam/security-credentials/ROLE-NAME

kinesis

创建流

aws kinesis create-stream –stream-name mystream –shard-count

列出流

aws kinesis list-streams

获取指定流的分片迭代器

aws kinesis get-shard-iterator –stream-name mystream –shard-id shard-1 –shard-iterator-type TRIM_HORIZON

发送数据到流

aws kinesis put-record –stream-name mystream –partition-key mykey –data test

获取流数据

aws kinesis get-records –shard-iterator myiterator

1106

1106

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?