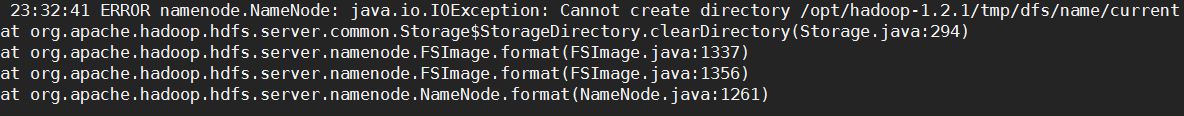

在终端输入命令:hadoop namenode -format进行格式化的时候会出现下面这种错误:

java.io.IOException: Cannot create directory /opt/hadoop-1.2.1/tmp/dfs/name/current

原因应该是权限不够无法再目录内新建文件。

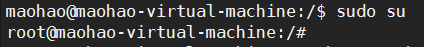

解决方案是:先输入命令:sudo su转为root身份

输入命令:sudo chmod -R a+w /opt/hadoop-1.2.1/ 注意修改自己的安装路径。

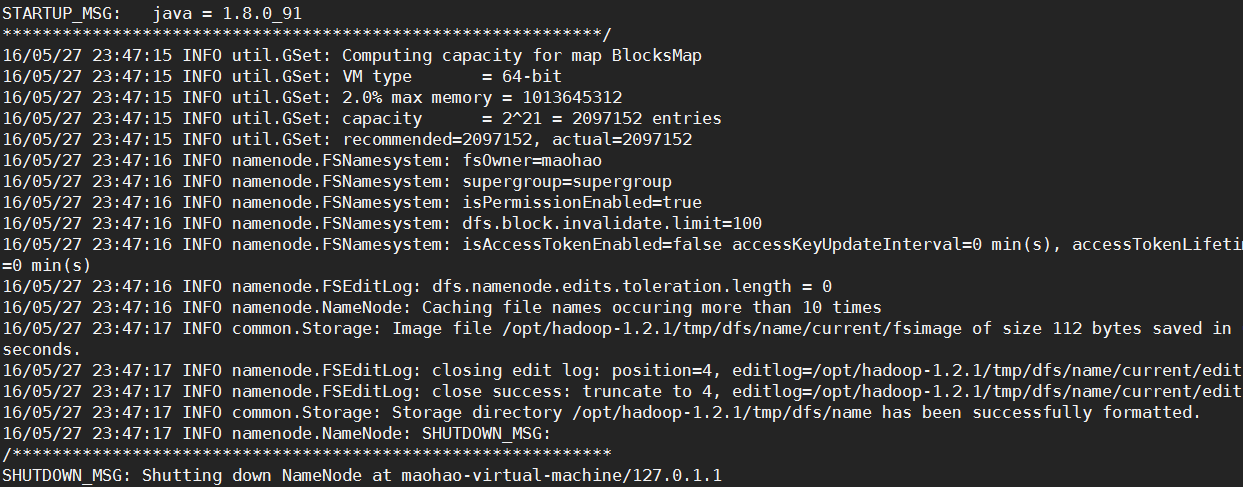

输入命令exit回到用户身份,再进入bin目录执行命令:hadoop namenode -format,显示成功!!!

Hadoop格式化namenode错误:java.io.IOException: Cannot create directory

最新推荐文章于 2024-08-28 11:50:12 发布

3998

3998

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?