http://blog.csdn.net/xllily_11/article/details/52145172前端

二、单层感知器

三、多层感知器参数初始化

激活函数

反向传播算法

梯度下降

成本函数

学习率

动量

Softmax

多层感知器:总结

四、深度学习概览

受限玻尔兹曼机和深度信念网络

Dropout

处理类不平衡的技术

SMOTE:合成少类过采样技术

神经网络中对成本敏感的学习

人脸识别

自然语言处理

人工神经网络有能力从被提供的数据中学习,这被称为自适应学习(adaptive learning)

神经网络创造其自己的组织或信息表征的能力则被称为自组织(self-organisation)。

感知器是最简单的神经网络,能将数据线性地分为两类

感知器无法表征很多重要的问题,比如异或函数(XOR)

反向传播(back-propagation)算法能够解决 XOR 这样的问题,并由此开启了第二代神经网络

单层感知器(SLP)

感知器的最简单形式是在输入和输出之间有一个单层的权重连接。这种形式可被看作是最简单的前馈网络(feed-forward network)。在一个前馈网络中,信息总是向一个方向移动,永不回头。

其偏置 bk 用作对加法器函数 uk 得到 vk 的输出的仿射变换

多层感知器(MLP)

一个多层感知器在输入和输出层之间有一个或多个隐藏层,其中每一层都包含多个通过权重链接彼此互连的神经元

参数的初始化:权重(weight)和偏置(bias)在确定最终模型的过程中发挥了重要的作用。

一个好的随机初始化策略可以避开局部极小值的困境。局部极小值(local minima)问题是指网络在训练过程中受困于错误的表面而不能深入,即使该网络还仍有学习的能力。

激活函数:

阈值函数

阈值函数

S 型函数(Sigmoid Function)

Maxout 函数Maxout 网络不仅能学习隐藏单元之间的关系,还能学习每个隐藏单元的激活函数

其中 W...ij 是通过获取矩阵中第二个坐标 i 和第三个坐标 j 的输入大小的平均向量。中间单元 k 的数量被称为 Maxout 网络所用的片(piece)的数量。

反向传播算法

通过改变网络中的权重和偏置来最小化成本函数(cost function)的方法。为了学习和做出更好的预测,会执行一些 epoch(训练周期);在这些 epoch 中,由成本函数所决定的误差会通过梯度下降被反向传播,直到达到足够小的误差

梯度下降:

表示参数θ与误差函数J(θ)第一步是给θ给一个初值将θ按照梯度下降的方向进行调整,就会使得J(θ)往更低的方向进行变化,如图所示,算法的结束将是在θ下降到无法继续下降为止.

成本函数:

----均方误差函数 yi 是预测的输出,oi 是真实的输出

yi 是预测的输出,oi 是真实的输出

学习率

学习率控制着权重从一次迭代到另一次迭代的变化。一般来说,更小的学习率被认为是稳定的,但学习速度也更慢。另一方面,更高的学习率可能不稳定,会引起振荡和数值误差,但会加速学习过程。

动量

动量为避免局部极小值提供了惯性;其思想简单来说就是为当前的权重更新增加特定比例的先前的权重更新,这有助于避免受困于局部极小值。

Softmax

Softmax 是一种神经传递函数,其是可将向量变成概率的输出层中实现的 logistic 函数的广义形式。这些概率的总和为 1 且限定于 1。

多层感知器(MLP)

对于分类任务,输出层可能会整合一个 softmax 函数用来给出每个发生类(occurring class)的概率。激活函数使用输入、权重和偏置在每个层中计算每个神经元的预测输出。

反向传播方法一种训练多层神经网络的方法,该方法通过修改层之间的突触连接权重以在纠错学习函数(需要是连续可微的)的基础上提升模型的性能

深度学习

有各种各样的训练深度监督前馈神经网络的失败尝试是由在不可见的数据上的性能的过拟合导致的;即在训练误差降低的同时验证误差却在增长。

受限玻尔兹曼机(RBM)和深度信念网络

玻尔兹曼机因为其连通性而非常难以训练。一个 RBM 限制了连通性从而使得学习变得简单。在组成二分图(bipartite graph)的单层中,隐

这些网络受到了一个能量函数的管控,它决定了隐藏/可见状态的概率。隐藏/可见单位的每个可能的连接结构( joi藏单元没有连接,如图 2。它的优势是隐藏单位可以独立更新,并且与给定的可见状态平行。nt configurations )都有一个由权重和偏差决定的 Hopfield 能量。连接结构的能量由吉布斯采样优化,它可通过最小化 RBM 的最低能量函数学习参数。

在深度信念网络(DBN)中,RBM 是通过带有重要特征的输入数据进行训练的,这些输入数据是由隐藏层中的随机神经元获取的。在第二层,训练特征的激活(activation)被当作输入数据处理。第二层 RBM 层中的学习过程可被看作是学习特征的特征,每次当一个新的层被添加到深度信念网络中时,原始训练数据的对数概率上的可变的更低的界限就会获得提升

DROPOUT

近期的一些进展已经引入了强大的正则化矩阵(regularizers)来减少神经网络的过拟合。在机器学习中,正则化是附加信息,通常作为一种惩罚机制被引入——惩罚导致过拟合的模型的复杂性。

Dropout 是 Hinton 引入的一种深度神经网络的正则化技术,通过在每一个训练迭代上随机关掉一部分神经元,而是在测试时间使用整个网络(权重按比例缩小),从而防止特征检测器的共适应。

Dropout 通过等同于训练一个共享权重的指数模型减少过拟合。对于给定的训练迭代,存在不同 dropout 配置的不同指数,所以几乎可以肯定每次训练出的模型都不一样。在测试阶段,使用了所有模型的平均值,作为强大的总体方法。

在很多机器学习竞赛中,平均众多模型(Averaging many model)总是获胜的关键。很多不同类型的模型被使用,然后结合起来在测试阶段做预测。

随机森林是一个非常强大的 bagging 算法,它是通过平均很多决策树,给它们不同的带有重置的训练样本集创造的。众所周知,决策树非常容易拟合数据,而且在测试时间进行得非常快,所以通过给它们不同的训练集来平均不同的决策树是负担得起的。

http://mp.weixin.qq.com/s?timestamp=1470558065&src=3&ver=1&signature=Qi9ZhAM2PGSbgDr-Lvy6sMW3MgB-id5oUmo6hZrjIhmCGHJZklAR01a5wWW18-Ll6t*8-o6e82i1HmO2sMmUCH2zYgvcj4DXpl-rWjwFBrAwJMsw5LLOfkOJKNFUMHVnzpm945m4eVQicsPyWsg-cRhbUmgJqYKBHx4sAVX6ErA=

机器学习:

统计学习的核心步骤:模型、策略、算法,

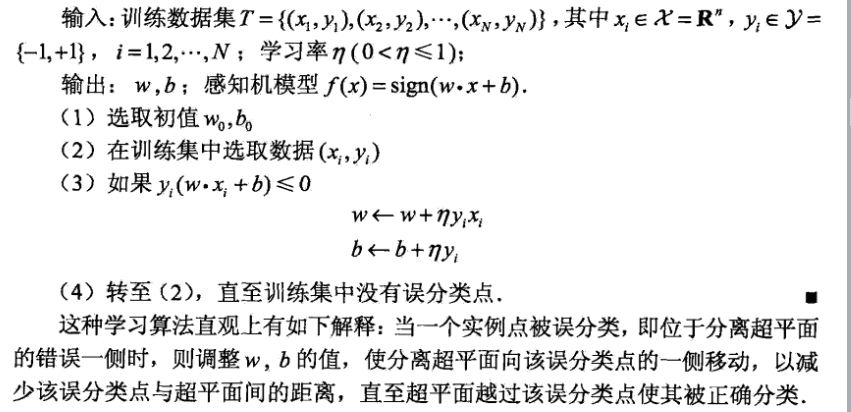

一.感知器 -----模型:

-----------策略:

在假设空间中选取使损失函数式最小的模型参数w,b

-----------算法:

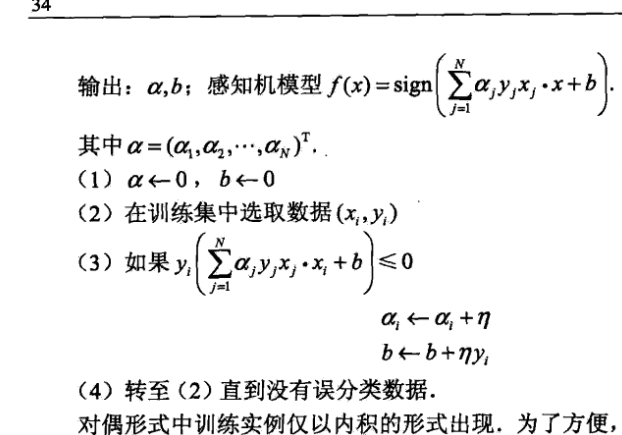

-----------对偶问题:

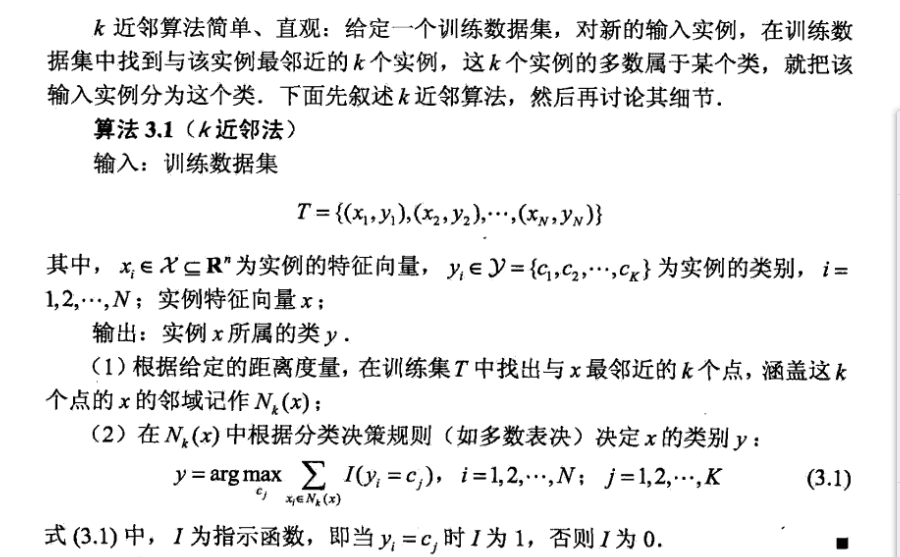

-------模型:

特征空间的划分,

由距离度量.k值选择,分类决策规则决定

距离·

欧式距离

欧式距离 欧式向量表示

欧式向量表示

曼哈顿距离

曼哈顿距离

闵氏距离的定义

加权欧氏距离 标准差(standard deviation)为s

标准差(standard deviation)为s

马氏距离

杰卡德相似系数

信息熵:

K选择小:整体的模型的变的复杂,容易过拟合

k选择大:模型简单预测效果不好

多数表决分类决策规则

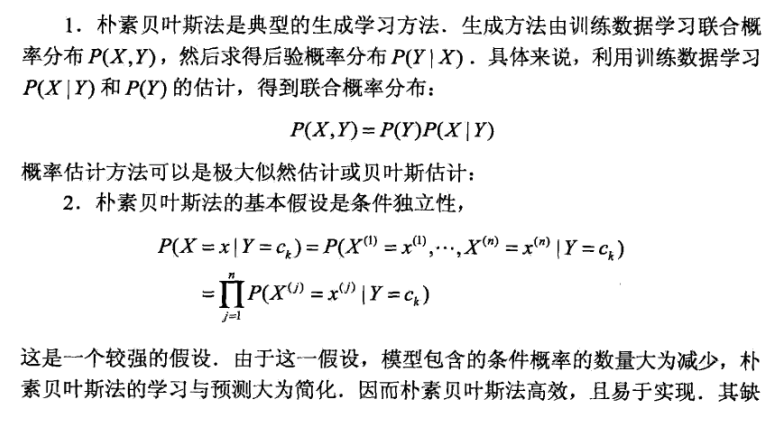

三.朴素贝叶斯网络:

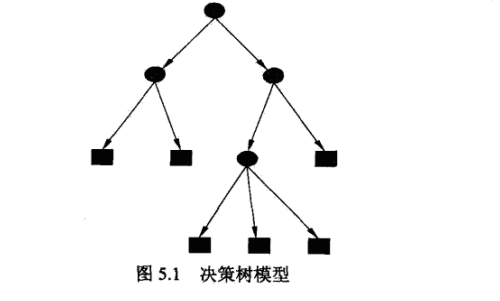

四.决策树:

--------模型:

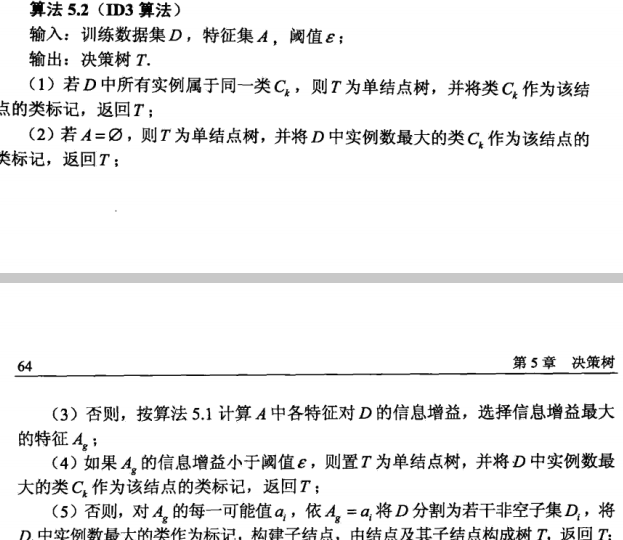

--------算法:

ID3 信息增益

C4.5 信息增益率

CART

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?