1. 软件版本:

IDE:Intellij IDEA 14,

Java:1.7,Scala:2.10.6;Tomcat:7,CDH:5.8.0;

Spark:1.6.0-cdh5.8.0-hadoop2.6.0-cdh5.8.0 ;

Hadoop:hadoop2.6.0-cdh5.8.0;(使用的是CDH提供的虚拟机)

2. 工程下载及部署:

Scala封装Spark算法工程:https://github.com/fansy1990/Spark_MLlib_Algorithm_1.6.0.git ;

调用Spark算法工程:https://github.com/fansy1990/Spark_MLlib_1.6.0_.git ;

部署(主要针对Spark_MLlib_1.6.0工程):

1)配置好db.properties中相应用户名密码/数据库等参数; 2)第一次启动tomcat,修改hibernate.cfg.xml文件中的hibernate.hbm2ddl.auto值为create,第二次启动修改为update; 3) 打开集群参数页面,点击初始化,初始化集群参数,如果集群参数和当前集群不匹配,那么需要做相应修改; 暂时考虑使用配置文件的方式来配置集群参数,如果要调整为数据库配置,那么修改Utisl.dbOrFile参数即可;即,暂时只需修改utisl.properties文件; 4)拷贝Spark_MLlib_Algorithm_1.6.0工程生成的算法到到3)中spark.jar所在路径; 5)拷贝集群中的yarn-site.xml到3)中spark.files所在路径; 6)拷贝spark-assembly-1.6.0-cdh5.8.0-hadoop2.6.0-cdh5.8.0.jar到3)中spark.yarn.jar所在路径;

3. 工程实现原理:

3.1 Scala封装Spark算法工程:

3.1.1 工程目录

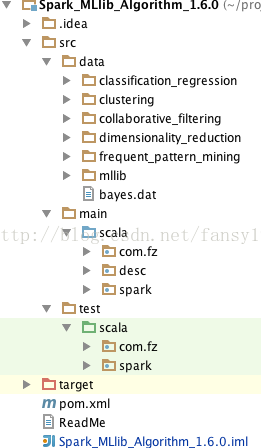

1. 工程目录如下所示:

其中,data目录为所有的测试数据所在目录,这里针对不同的算法建立了不同的目录,主要有5类:分类与回归/聚类/协同过滤/降维/频繁项集挖掘;

main/scala里面就是所有封装Spark源码中的代码;

test/scala里面对应每个封装代码的测试;

2. 工程采用Maven构建,直接根据pom文件加载对应依赖;

3. 该工程需要经过maven打包,把打包好的jar包放到CDH的虚拟机中的HDFS上某一固定目录,方便Spark算法调用工程调用(具体目录下文有说);

3.1.2 单个算法实现(封装/测试),比如针对逻辑回归

1. 针对逻辑回归,其封装代码如下所示:

代码清单3-1 逻辑回归算法封装(Scala)

package com.fz.classification

import com.fz.util.Utils

import org.apache.spark.mllib.classification.{LogisticRegressionWithSGD, LogisticRegressionWithLBFGS}

import org.apache.spark.mllib.linalg.Vectors

import org.apache.spark.mllib.regression.LabeledPoint

import org.apache.spark.{SparkConf, SparkContext}

/**

* 逻辑回归封装算法

* Labels used in Logistic Regression should be {0, 1, ..., k - 1} for k classes multi-label classification problem

* 输入参数:

* testOrNot : 是否是测试,正常情况设置为false

* input:输出数据;

* minPartitions : 输入数据最小partition个数

* output:输出路径

* targetIndex:目标列所在下标,从1开始

* splitter:数据分隔符;

* method:使用逻辑回归算法:"SGD" or "LBFGS"

* hasIntercept : 是否具有截距

* numClasses: 目标列类别个数;

* Created by fanzhe on 2016/12/19.

*/

object LogisticRegression {

def main (args: Array[String]) {

if(args.length != 9){

println("Usage: com.fz.classification.LogisticRegression testOrNot input minPartitions output targetIndex " +

"splitter method hasIntercept numClasses")

System.exit(-1)

}

val testOrNot = args(0).toBoolean // 是否是测试,sparkContext获取方式不一样, true 为test

val input = args(1)

val minPartitions = args(2).toInt

val output = arg

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

999

999

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?