近日,通义千问发布了 Qwen1.5-110B 模型,这是 Qwen1.5 系列中的新成员,也是该系列中首个参数超过 1000 亿的模型。

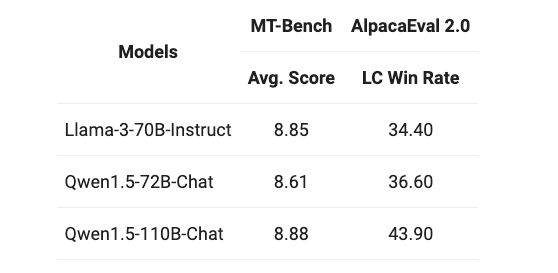

该模型在基础模型评估中表现出色,可与 Meta-Llama3-70B 相媲美。在聊天模型评估(包括 MT-Bench 和 AlpacaEval 2.0)中也展现出了优异的性能。

Qwen1.5-110B 模型支持多语言,包括英语、中文、法语、西班牙语等,其上下文长度可达 32K 令牌。

该模型具有以下特性:

- 架构

- :采用 Transformer 解码器架构,具有分组查询注意力(GQA)。

- 性能

- :在标准评估和聊天模型评估中均表现卓越。

- 多语言支持

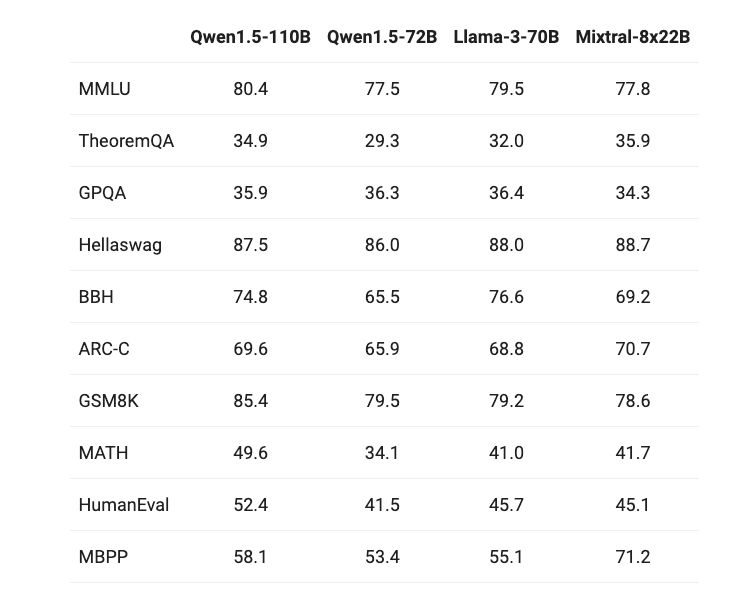

- :支持多种语言,上下文长度可达 32K 令牌。 根据官方公布的评测结果,Qwen1.5-110B 模型的评测结果略略超过 Llama-3-70B 和 Mixtral-8×22B。在综合理解(MMLU)、数学推理(GSM8K 和 MATH)方面,Qwen1.5-110B 模型的得分比 Llama-3-70B 略高一点点,是几个模型中最强的。而在复杂推理任务 ARC-C 上则略低于 Mixtral-8×22B 模型。在编程测试 HumanEval 得分上,Qwen1.5-110B 模型远超另几个模型,但在 MBPP 编程测试上则低于 Mixtral-8×22B 模型。

可以看出,Qwen1.5-110B 模型在性能和多语言支持方面都具有显著优势,为人工智能领域的发展带来了新的突破。这也让我们对未来的人工智能应用充满期待。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?