更多Python学习内容:ipengtao.com

HTML是网页的基本构建语言,而Python提供了强大的工具和库来解析HTML内容,从而实现网页数据的提取和分析。本文将详细介绍如何使用Python解析HTML,包括安装、特性、基本功能、高级功能、实际应用场景和总结,帮助掌握HTML解析的技巧和应用。

安装

Python中常用的HTML解析库有Beautiful Soup和lxml等,可以通过pip工具进行安装:

pip install beautifulsoup4 lxml特性

解析HTML结构:能够解析HTML文档的各个部分,包括标签、属性、文本内容等。

提取数据:可以从HTML文档中提取所需的数据,如链接、文本、图片等。

灵活定位元素:支持灵活的元素定位方式,如CSS选择器、XPath等。

处理异常情况:能够处理HTML文档中的异常结构和错误,提高解析的稳定性。

基本功能详解

1. 解析HTML结构

HTML文档由标签、属性和文本内容组成,解析HTML结构是解析HTML文档的第一步。

使用Beautiful Soup库可以轻松实现HTML结构的解析,具体示例代码如下:

from bs4 import BeautifulSoup

# HTML文档示例

html_doc = """

<html>

<head>

<title>示例网页</title>

</head>

<body>

<p>这是一个示例网页</p>

<a href="https://example.com">示例链接</a>

</body>

</html>

"""

# 创建Beautiful Soup对象并解析HTML文档

soup = BeautifulSoup(html_doc, 'html.parser')

# 打印解析后的HTML结构

print(soup.prettify())上述代码中,prettify()方法可以美化输出HTML文档,更加清晰地显示HTML结构。

2. 提取数据

解析HTML不仅可以获取HTML结构,还可以从HTML文档中提取所需的数据,如链接、文本内容、图片等。

以下是一个简单的示例代码,演示如何提取链接和文本内容:

from bs4 import BeautifulSoup

# HTML文档示例

html_doc = """

<html>

<body>

<a href="https://example.com">示例链接</a>

<p>这是一个示例网页</p>

</body>

</html>

"""

# 创建Beautiful Soup对象并解析HTML文档

soup = BeautifulSoup(html_doc, 'html.parser')

# 提取链接和文本内容

link = soup.a['href']

text = soup.p.text

print('链接:', link)

print('文本内容:', text)在上述代码中,使用了Beautiful Soup提供的方法来提取链接和文本内容,非常方便和直观。

3. 遍历元素

解析HTML文档时,经常需要遍历各个元素进行处理。Beautiful Soup提供了多种方法来遍历HTML元素,如find_all()、find()等。

以下是一个示例代码,演示如何遍历所有的段落元素:

from bs4 import BeautifulSoup

# HTML文档示例

html_doc = """

<html>

<body>

<p>第一段</p>

<p>第二段</p>

<p>第三段</p>

</body>

</html>

"""

# 创建Beautiful Soup对象并解析HTML文档

soup = BeautifulSoup(html_doc, 'html.parser')

# 遍历所有的段落元素并打印内容

paragraphs = soup.find_all('p')

for p in paragraphs:

print(p.text)以上代码中,通过find_all('p')方法找到所有的段落元素,并使用循环遍历打印每个段落的内容。

高级功能详解

除了基本功能外,HTML解析库还提供了一些高级功能,可以帮助用户更灵活地处理HTML文档和元素。

1. CSS选择器定位元素

使用CSS选择器可以更灵活地定位HTML元素,这在处理复杂HTML结构时非常有用。

Beautiful Soup库支持使用CSS选择器来定位元素,示例代码如下:

from bs4 import BeautifulSoup

# HTML文档示例

html_doc = """

<html>

<body>

<div id="content">

<p class="paragraph">第一段</p>

<p class="paragraph">第二段</p>

<p class="paragraph">第三段</p>

</div>

</body>

</html>

"""

# 创建Beautiful Soup对象并解析HTML文档

soup = BeautifulSoup(html_doc, 'html.parser')

# 使用CSS选择器定位元素并打印内容

paragraph = soup.select_one('#content .paragraph')

print(paragraph.text)上述代码中,通过CSS选择器#content .paragraph定位到<div>元素下的class为paragraph的段落元素,并打印其文本内容。

2. 处理异常情况

在实际应用中,HTML文档可能存在异常结构或错误,这时候需要处理这些异常情况以保证解析的稳定性。

Beautiful Soup提供了一些方法来处理异常情况,示例代码如下:

from bs4 import BeautifulSoup

# HTML文档示例

html_doc = """

<html>

<body>

<p>第一段</p>

<p>第二段</p>

<p>第三段</div>

</body>

</html>

"""

# 创建Beautiful Soup对象并解析HTML文档

soup = BeautifulSoup(html_doc, 'html.parser')

# 处理异常结构

paragraphs = soup.find_all('p')

for p in paragraphs:

try:

print(p.text)

except Exception as e:

print('出现异常:', e)上述代码中,通过try...except...语句捕获异常情况,保证即使HTML文档中存在异常结构也能够正常处理。

3. 处理动态加载内容

有些网页的内容是通过JavaScript动态加载的,这时候需要使用Selenium等工具来模拟浏览器行为,然后再将加载后的HTML内容交给Beautiful Soup来解析。

示例代码如下:

from selenium import webdriver

from bs4 import BeautifulSoup

# 使用Selenium模拟浏览器获取动态加载内容

driver = webdriver.Chrome()

driver.get('https://example.com')

# 获取动态加载后的HTML内容

html_content = driver.page_source

# 创建Beautiful Soup对象并解析HTML内容

soup = BeautifulSoup(html_content, 'html.parser')

# 处理解析后的内容

# ...

# 关闭浏览器

driver.quit()以上代码中,通过Selenium模拟浏览器行为获取动态加载后的HTML内容,然后再交给Beautiful Soup来处理解析。这种方式适用于需要处理动态加载内容的情况。

实际应用场景

1. 网页数据提取

解析HTML可以用于从网页中提取数据,如新闻标题、商品信息等:

from bs4 import BeautifulSoup

import requests

url = 'https://example.com/news'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 提取新闻标题

headlines = soup.find_all('h2', class_='headline')

for headline in headlines:

print(headline.text)2. 网页爬虫

利用HTML解析库可以编写简单的网页爬虫,自动获取网页信息:

from bs4 import BeautifulSoup

import requests

url = 'https://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 获取所有链接

links = soup.find_all('a')

for link in links:

print(link['href'])总结

使用Python解析HTML是获取网页数据和进行网页分析的重要手段之一。本文介绍了HTML解析库的安装、特性、基本功能、高级功能和实际应用场景,并提供了详细的示例代码。希望大家通过本文的学习,能够熟练运用Python解析HTML,实现各种实际应用。

如果你觉得文章还不错,请大家 点赞、分享、留言 ,因为这将是我持续输出更多优质文章的最强动力!

更多Python学习内容:ipengtao.com

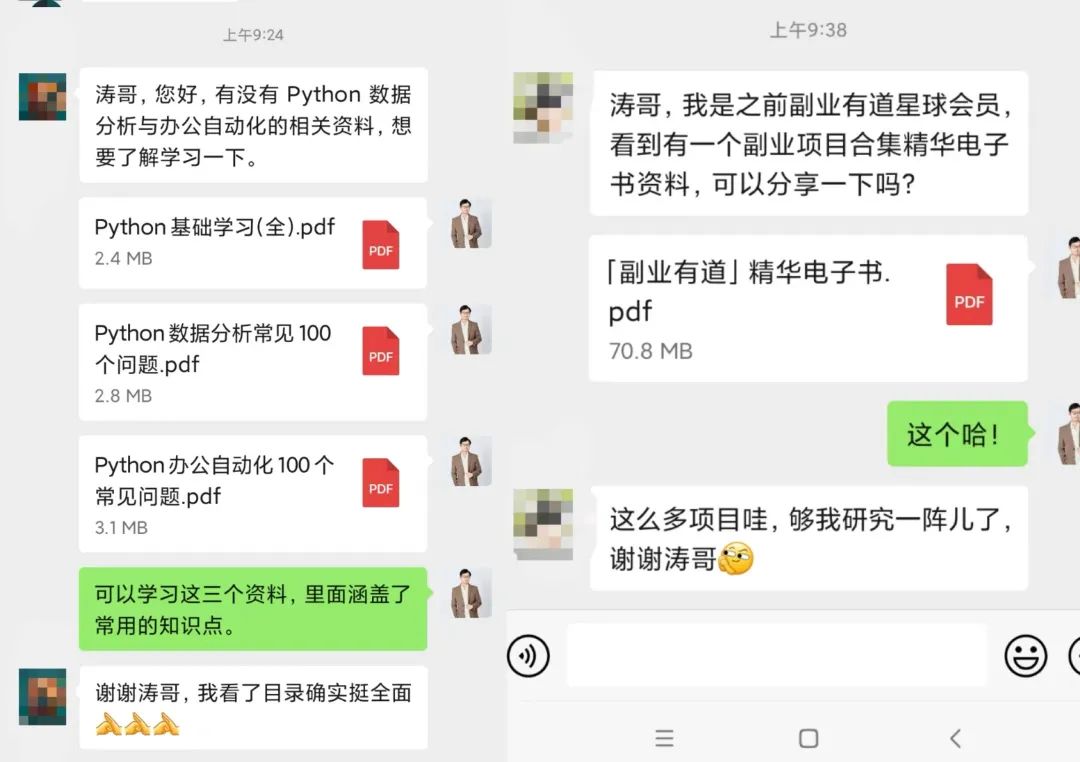

如果想要系统学习Python、Python问题咨询,或者考虑做一些工作以外的副业,都可以扫描二维码添加微信,围观朋友圈一起交流学习。

我们还为大家准备了Python资料和副业项目合集,感兴趣的小伙伴快来找我领取一起交流学习哦!

往期推荐

Python 中的 isinstance() 函数:类型检查的利器

点击下方“阅读原文”查看更多

3140

3140

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?