原文地址: https://blog.csdn.net/github_38647413/article/details/124365490

文章目录

- 一、初识 Redis

- 二、API 的理解和使用

- 三、小功能大用处

- 四、客户端

- 五、持久化

- 六、复制

- 七、Redis 的噩梦:阻塞

- 八、理解内存

- 九、哨兵

- 1、Redis Sentinel 相关名词解释

- 2、主从复制的问题

- 3、Redis Sentinel 的高可用性

- 4、部署 Redis 数据节点

- 5、部署 Sentinel 节点

- 6、配置优化

- 7、部署技巧

- 8、API

- 9、Redis Sentinel 的客户端

- 10、Redis Sentinel 客户端基本实现原理

- 12、Redis Sentinel 的基本实现原理之一——Redis Sentinel 的三个定时任务

- 13、Redis Sentinel 的基本实现原理之二——主观下线和客观下线

- 14、Redis Sentinel 的基本实现原理之三——领导者 Sentinel 节点选举

- 15、故障转移

- 16、故障转移日志分析

- 17、节点运维

- 18、Redis Sentinel 读写分离设计思路

- 19、汇总

- 十、集群

- 1、概述

- 2、数据分布理论

- 3、Redis 数据分区

- 4、集群功能限制

- 5、搭建集群

- 6、搭建集群步骤一:准备节点

- 7、搭建集群步骤二:节点握手

- 8、搭建集群步骤三:分配槽

- 9、用 redis-trib.rb 搭建集群

- 10、节点通信流程

- 11、Gossip 消息

- 12、节点选择

- 13、集群伸缩原理

- 14、扩容集群

- 15、收缩集群

- 17、请求路由——Smart 客户端

- 18、请求路由——ASK 重定向

- 19、故障转移之故障发现

- 20、故障转移之故障恢复

- 21、故障转移之故障转移时间

- 22、集群运维——集群完整性

- 23、集群运维——带宽消耗

- 24、集群运维——Pub/Sub 广播问题

- 25、集群运维——集群倾斜

- 26、集群运维——集群读写分离

- 27、集群运维——手动故障转移

- 28、集群运维——数据迁移

- 十一、缓存设计

- 十二、开发运维的 “陷阱”

- 1、Linux 配置优化之内存分配控制

- 2、Linux 配置优化之 swappiness

- 3、Linux 配置优化之 THP

- 4、Linux 配置优化之 OOM killer

- 5、Linux 配置优化之使用 NTP

- 6、Linux 配置优化之 ulimit

- 7、Linux 配置优化之 TCP backlog

- 8、flushall/flushdb 误操作之缓存与存储

- 9、flushall/flushdb 误操作之借助 AOF 机制恢复

- 10、flushall/flushdb 误操作之 RDB 变化

- 11、flushall/flushdb 误操作之从节点变化

- 12、flushall/flushdb 误操作之快速恢复数据

- 13、安全的 Redis 概述

- 14、安全的 Redis 之 Redis 密码机制

- 15、安全的 Redis 之伪装危险命令

- 16、安全的 Redis 之防火墙

- 17、安全的 Redis 之 bind

- 18、安全的 Redis 之定期备份数据

- 19、安全的 Redis 之不使用默认端口

- 20、安全的 Redis 之使用非 root 用户启动

- 21、处理 bigkey

- 22、bigkey 的危害

- 23、如何发现 bigkey

- 24、如何删除 bigkey

- 25、bigkey 最佳实践思路

- 26、寻找热点 key

- 27、汇总

- 十三、Redis 配置统计字典

一、初识 Redis

1、在 Centos7 下安装 Redis

1)安装

一般推荐使用的安装方式:源码的方式进行安装。下面以 3.0.7 版本为例 (只需 6 步):

# 如果没有安装则通过以下命令安装:

$ yum install -y gcc

$ wget http://download.redis.io/releases/redis-3.0.7.tar.gz

$ tar xzf redis-3.0.7.tar.gz

$ ln -s redis-3.0.7 redis # 建立一个redis目录的软连接,指向redis-3.0.7。

$ cd redis

$ make # 编译(编译前确保操作系统已经安装gcc)

$ make install # 指定安装目录并进行安装: make install PREFIX=/usr/local/redis

$ redis-cli -v # 查看Redis的版本

2)通过守护进程方式启动

# 第一步:从 redis 的源码目录中复制 redis.conf 到 redis 的安装目录

cp /root/redis-6.2.6/redis.conf /usr/local/redis/bin/

# 第二步:修改redis.conf配置文件

cd /usr/local/redis/bin/

vi redis.conf

# 修改内容如下:

#daemonize 的值从 no 修改成 yes

# 第三步:启动服务

./redis-server redis.conf

# 第四步:查看进程来确定redis是否启动成功,非必须

ps -ef |grep redis

3)设置开机自动启动

切换到 / lib/systemd/system / 目录,创建 redis.service 文件。命令如下:

cd /lib/systemd/system/

vim redis.service

文件内容如下:

[Unit]

Description=redis-server

After=network.target

[Service]

Type=forking

# ExecStart需要按照实际情况修改成自己的地址

ExecStart=/usr/local/redis/bin/redis-server /usr/local/redis/bin/redis.conf

ExecReload=/bin/kill -s HUP $MAINPID

ExecStop=/usr/local/redis/bin/redis-cli -p 6379 shutdown

PrivateTmp=true

[Install]

WantedBy=multi-user.target

设置开启自动启动

# 开机自动启动

systemctl enable redis.service

# 启动redis服务

systemctl start redis.service

# 查看服务状态

systemctl status redis.service

# 停止服务

systemctl stop redis.service

# 取消开机自动启动(卸载服务)

systemctl disabled redis.service

4)客户端连接

# 本地连接:进入bin目录执行客户端连接操作

./redis-cli -h localhost –p 6379

127.0.0.1:6379> set hello world

OK

127.0.0.1:6379> get hello

"world"

# 通过 redis-cli -h {host} -p {port} {command} 就可以直接得到命令的返回结果。

redis-cli -h 127.0.0.1 -p 6379 get hello

"world"

# redis客户端显示中文

redis-cli -p 7000 --raw

# 远程连接

# 注意:默认redis服务器是没有开启远程连接

# 1、修改配置开启远程连接

vim redis.conf 修改如下配置

bind 0.0.0.0 # 允许一切客户端连接

# 2、重启服务

2、Redis 可执行文件说明

| 可执行文件 | 作用 |

|---|---|

| redis-server | 启动 Redis |

| redis-cli | Redis 命令行客户端 |

| redis-benchmark | Redis 基准测试工具 |

| redis-check-aof | Redis AOF 持久化文件检测和修复工具 |

| redis-check-dump | Redis RDB 持久化文件检测和修复工具 |

| redis-sentinel | 启动 Redis Sentinel |

redis-cli 详解

要了解 redis-cli 的全部参数,可以执行 redis-cli --help 命令来进行查看。

1)-r (repeat) 选项代表将命令执行多次

$ redis-cli -r 3 ping # 执行三次ping命令

pong

pong

pong

2)-i (interval) 选项代表每隔几秒执行一次命令,但是 - i 选项必须和 - r 选项一起使用。

# 注意 - i 的单位是秒,不支持毫秒为单位,但是如果想以每隔 10 毫秒执行一次,可以用 - i0.0。

$ redis-cli -r 5 -i 1 ping # 每隔1秒执行一次ping命令,一共执行5次

PONG

PONG

PONG

PONG

PONG

$ redis-cli -r 100 -i 1 info | grep used_memory_human # 每隔1秒输出内存的使用量,一共输出 100次

used_memory_human:2.95G

used_memory_human:2.95G

. . . . . . . . . . . . . . . . . . . . . .

used_memory_human:2.94G

3)-x 选项代表从标准输入 (stdin) 读取数据作为 redis-cli 的最后一个参数。

$ echo "world" | redis-cli -x set hello

OK

4)-c (cluster) 选项是连接 Redis Cluster 节点时需要使用的,-c 选项可以防止 moved 和 ask 异常。

5)-a 如果 Redis 配置了密码,可以用 - a(auth) 选项,有了这个选项就不需要手动输入 auth 命令。

6)–scan 和–pattern 用于扫描指定模式的键,相当于使用 scan 命令。

7)–slave 选项是把当前客户端模拟成当前 Redis 节点的从节点,可以用来获取当前 Redis 节点的更新操作。合理的利用这个选项可以记录当前连接 Redis 节点的一些更新操作,这些更新操作很可能是实际开发业务时需要的数据。

# ①下面开启第一个客户端,使用--slave选项,看到同步已完成:

$ redis-cli --slave

SYNC with master, discarding 72 bytes of bulk transfer . . .

SYNC done . Logging commands from master .

# ②再开启另一个客户端做一些更新操作:

redis-cli

127.0.0.1:6379> set hello world

OK

127.0.0.1:6379> set a b

OK

127.0.0.1:6379> incr count

1

127.0.0.1:6379> get hello

"world"

# ③第一个客户端会收到Redis节点的更新操作:(PING命令是由于主从复制产生的)

redis-cli --slave

SYNC with master, discarding 72 bytes of bulk transfer . . .

SYNC done . Logging commands from master .

"PING"

"PING"

"PING"

"PING"

"PING"

"SELECT","0"

"set","hello","world"

"set","a","b"

"PING"

"incr","count"

8)–rdb 选项会请求 Redis 实例生成并发送 RDB 持久化文件,保存在本地。可使用它做持久化文件的定期备份。

9)–pipe 选项用于将命令封装成 Redis 通信协议定义的数据格式,批量发送给 Redis 执行。

# 下面操作同时执行了set hello world和incr counter两条命令:

echo -en '*3\r\n$3\r\nSET\r\n$5\r\nhello\r\n$5\r\nworld\r\n*2\r\n$4\r\nincr\r\ n$7\r\ncounter\r\n ' | redis-cli --pipe

10)–bigkeys 选项使用 scan 命令对 Redis 的键进行采样,从中找到内存占用比较大的键值,这些键可能是系统的瓶颈。

11)–eval 选项用于执行指定 Lua 脚本。

12)–latency 有三个选项,分别是–latency、–latency-history、–latency-dist。它们都可以检测网络延迟。 1. –latency:该选项可以测试客户端到目标 Redis 的网络延迟。 2. –latency-history:–latency 的执行结果只有一条,而–latency-history 可以以分时段的形式了解延迟信息。 3. –latency-dist:该选项会使用统计图表的形式从控制台输出延迟统计信息。

redis-cli -h {machineB} --latency

min: 0, max: 1, avg: 0.07 (4211 samples)

# 延时信息每15秒输出一次,可以通过-i参数控制间隔时间

redis-cli -h 10.10.xx.xx --latency-history

min: 0, max: 1, avg: 0.28 (1330 samples) -- 15.01 seconds range…

min: 0, max: 1, avg: 0.05 (1364 samples) 15.01 seconds range

13)–stat 选项可以实时获取 Redis 的重要统计信息,虽然 info 命令中的统计信息更全,但是能实时看到一些增量的数据 (例如 requests) 对于 Redis 的运维还是有一定帮助的。

14)–raw 和–no-raw :no-raw 选项是要求命令的返回结果必须是原始的格式,raw 恰恰相反,返回格式化后的结果。

# ①在Redis中设置一个中文的value:

$redis-cli set hello "你好"

OK

# ②如果正常执行get或者使用--no-raw选项,那么返回的结果是二进制格式;如果使用了--raw选项,将会返回中文。

$redis-cli get hello

"\xe4\xbd\xa0\xe5\xa5\xbd"

$redis-cli --no-raw get hello

"\xe4\xbd\xa0\xe5\xa5\xbd"

$redis-cli --raw get hello

你好

redis-server 详解

redis-server 除了启动 Redis 外,还有一个 -–test-memory 选项。redis-server -–test-memory 可以用来检测当前操作系统能否稳定地分配指定容量的内存给 Redis,通过这种检测可以有效避免因为内存问题造成 Redis 崩溃。

下面操作检测当前操作系统能否提供1G的内存给Redis:

redis-server --test-memory 1024

- 整个内存检测的时间比较长。当输出 passed this test 时说明内存检测完毕,最后会提示–test-memory 只是简单检测,如果有质疑可以使用更加专业的内存检测工具。

- 通常无需每次开启 Redis 实例时都执行–test-memory 选项,该功能更偏向于调试和测试。

redis-benchmark 详解

redis-benchmark 可以为 Redis 做基准性能测试。

1)-c(clients) 选项代表客户端的并发数量 (默认是 50)。

2)-n<requests> (num) 选项代表客户端请求总量 (默认是 100000)。

# redis-benchmark -c 100 -n 20000代表100个客户端同时请求Redis,一共执行20000次。

# redis-benchmark会对各类数据结构的命令进行测试,并给出性能指标.

====== GET ======

20000 requests completed in 0.27 seconds

100 parallel clients

3 bytes payload keep alive: 1

99.11% <= 1 milliseconds

100.00% <= 1 milliseconds

73529.41 requests per second

3)-q 选项仅仅显示 redis-benchmark 的 requests per second 信息

$redis-benchmark -c 100 -n 20000 -q

PING_INLINE: 74349.45 requests per second

PING_BULK: 68728.52 requests per second

SET : 71174.38 requests per second…

LRANGE_500 (first 450 elements) : 11299.44 requests per second

LRANGE_600 (first 600 elements) : 9319.67 requests per second

MSET (10 keys) : 70671.38 requests per second

4)-r 选项会在 key、counter 键上加一个 12 位的后缀,-r 10000 代表只对后四位做随机处理 (-r 不是随机数的个数)。

# 如果想向 Redis 插入更多的键,可以执行使用 - r(random) 选项,可以向 Redis 插入更多随机的键。

# 在一个空的Redis上执行了redis-benchmark会发现只有3个键:

127.0.0.1:6379> dbsize

(integer) 3

127.0.0.1:6379> keys *

1) "counter:__rand_int__"

2) "mylist"

3) "key:__rand_int__"

$redis-benchmark -c 100 -n 20000 -r 10000

5)-P 选项代表每个请求 pipeline 的数据量 (默认为 1)。

6)-k<boolean> 选项代表客户端是否使用 keepalive,1 为使用,0 为不使用,默认值为 1。

7)-t 选项可以对指定命令进行基准测试。

redis-benchmark -t get,set -q

SET: 98619.32 requests per

GET: 97560.98 requests per

8)–csv 选项会将结果按照 csv 格式输出,便于后续处理,如导出到 Excel 等。

redis-benchmark -t get,set --csv

"SET","81300.81"

"GET","79051.38"

3、 停止 Redis 服务

Redis 提供了 shutdown 命令来停止 Redis 服务。

$ redis-cli shutdown # 停掉127.0.0.1上6379端口上的Redis服务

-

Redis 关闭的过程:断开与客户端的连接、持久化文件生成,是一种相对优雅的关闭方式。

-

除了可以通过 shutdown 命令关闭 Redis 服务以外,还可以通过 kill 进程号的方式关闭掉 Redis,但是不要粗暴地使用 kill -9 强制杀死 Redis 服务,不但不会做持久化操作,还会造成缓冲区等资源不能被优雅关闭,极端情况会造成 AOF 和复制丢失数据的情况。

-

shutdown 还有一个参数,代表是否在关闭 Redis 前,生成持久化文件。

$ redis-cli shutdown nosave|save

二、API 的理解和使用

1、单线程架构

- Redis 将所有数据放在内存中,内存的响应时长大约为 100ns。

- Redis 使用 epoll 作为 I/O 多路复用技术的实现,再加上 Redis 自身的事件处理模型将 epoll 中的连接、读写、关闭都转换为事件,不在网络 I/O 上浪费过多的时间。

- 单线程避免了线程切换和竞态产生的消耗。

2、数据库管理

1)数库操作指令

Redis 提供了几个面向 Redis 数据库的操作,它们分别是 dbsize、select、flushdb/flushall 命令

# 1、切换数据库

# 使用redis的默认配置器动redis服务后,默认会存在16个库,编号从0-15

# 可以使用select 库的编号 来选择一个redis的库

select dbIndex

127.0.0.1:6379> set hello world # 默认进到0号数据库

OK

127.0.0.1:6379> get hello

"world"

127.0.0.1:6379> select 15 # 切换到15号数据库

OK

127.0.0.1:6379 [15]> get hello # 因为15号数据库和0号数据库是隔离的,所以get hello为空

(nil)

# 2、flushdb/flushall

# 清空当前的库 FLUSHDB

# 清空全部的库 FLUSHALL

127.0.0.1:6379> dbsize

(integer) 4 # 当前0号数据库有四个键值对

127.0.0.1:6379> select 1

OK

127.0.0.1:6379 [1]> dbsize

(integer) 3

127.0.0.1:6379> flushdb

OK

127.0.0.1:6379> dbsize

(integer) 0

127.0.0.1:6379> select 1

OK

127.0.0.1:6379 [1]> dbsize

(integer) 3

127.0.0.1:6379> flushall # 在任意数据库执行flushall会将所有数据库清除.

OK

127.0.0.1:6379> select 1

OK

127.0.0.1:6379 [1]> dbsize

(integer) 0

- Redis Cluster 只允许使用 0 号数据库。

2)全局命令

-

DEL 指令

- 语法 : DEL key [key …]

- 作用 : 删除给定的一个或多个 key 。不存在的 key 会被忽略。

- 返回值: 被删除 key 的数量。

-

EXISTS 指令

- 语法: EXISTS key

- 作用: 检查给定 key 是否存在。

- 返回值: 若 key 存在,返回 1 ,否则返回 0。

-

EXPIRE

- 语法: EXPIRE key seconds

- 作用: 为给定 key 设置生存时间,当 key 过期时(生存时间为 0 ),它会被自动删除。

- 时间复杂度: O(1)

- 返回值:设置成功返回 1 。

-

KEYS

- 作用 : 查找所有符合给定模式 pattern 的 key 。keys 命令会遍历所有键,所以它的时间复杂度是 O(n),当 Redis 保存了大量键时,线上环境禁止使用。

- 语法 : KEYS pattern

KEYS * 查找数据库中所有 key 。

KEYS h?llo 匹配 hello ,hallo 和 hxllo 等。

KEYS h*llo 匹配 hllo 和 heeeeello 等。

KEYS h[ae]llo 匹配 hello 和 hallo ,但不匹配 hillo 。特殊符号用 “” 隔开 - 返回值: 符合给定模式的 key 列表。

-

MOVE

- 语法 : MOVE key db

- 作用 : 将当前数据库的 key 移动到给定的数据库 db 当中。

- 返回值: 移动成功返回 1 ,失败则返回 0 。

-

PEXPIRE

- 语法 : PEXPIRE key milliseconds

- 作用 : 这个命令和 EXPIRE 命令的作用类似,但是它以毫秒为单位设置 key 的生存时间,而不像 EXPIRE 命令那样,以秒为单位。

- 时间复杂度: O(1)

- 返回值:设置成功,返回 1 key 不存在或设置失败,返回 0

-

PEXPIREAT

- 语法 : PEXPIREAT key milliseconds-timestamp

- 作用 : 这个命令和 EXPIREAT 命令类似,但它以毫秒为单位设置 key 的过期 unix 时间戳,而不是像 EXPIREAT 那样,以秒为单位。

- 返回值:如果生存时间设置成功,返回 1 。当 key 不存在或没办法设置生存时间时,返回 0 。(查看 EXPIRE 命令获取更多信息)

-

TTL

- 语法 : TTL key

- 作用 : 以秒为单位,返回给定 key 的剩余生存时间(TTL, time to live)。

- 返回值:

当 key 不存在时,返回-2 。

当 key 存在但没有设置剩余生存时间时,返回-1 。

否则,以秒为单位,返回 key 的剩余生存时间。

-

PTTL

- 语法 : PTTL key

- 作用 : 这个命令类似于 TTL 命令,但它以毫秒为单位返回 key 的剩余生存时间,而不是像 TTL 命令那样,以秒为单位。

- 返回值:

当 key 不存在时,返回-2 。

当 key 存在但没有设置剩余生存时间时,返回-1 。

否则,以毫秒为单位,返回 key 的剩余生存时间。 - 注意 : 在 Redis 2.8 以前,当 key 不存在,或者 key 没有设置剩余生存时间时,命令都返回-1 。

-

RANDOMKEY

- 语法 : RANDOMKEY

- 作用 : 从当前数据库中随机返回(不删除) 一个 key。当数据库为空时,返回 nil 。

-

RENAME

- 语法 : RENAME key newkey

- 作用 : 将 key 改名为 newkey 。当 key 和 newkey 相同,或者 key 不存在时,返回一个错误。当 newkey 已经存在时,RENAME 命令将覆盖旧值。

- 返回值: 改名成功时提示 OK ,失败时候返回一个错误。

# rename key newkey

# 由于重命名键期间会执行 del 命令删除旧的键,如果键对应的值比较大,会存在阻塞 Redis 的可能性。

127.0.0.1:6379> get python

"jedis"

127.0.0.1:6379> set python jedis

OK

127.0.0.1:6379> rename python java # 如果在rename之前,键java 已经存在,那么它的值也将被覆盖

OK

127.0.0.1:6379> get python

(nil)

127.0.0.1:6379> get java

"jedis"

127.0.0.1:6379> set java jedis

OK

127.0.0.1:6379> set python redis-py

OK

# 为了防止被强行 rename,Redis 提供了 renamenx 命令,确保只有 newKey 不存在时候才被覆盖。

127.0.0.1:6379> renamenx java python

(integer) 0 # 返回结果是0代表没有完成重命名

127.0.0.1:6379> get java

"jedis"

127.0.0.1:6379> get python

"redis-py"

-

TYPE

- 语法 : TYPE key

- 作用 : 返回 key 所储存的值的类型。

- 返回值:

none (key 不存在)

string (字符串)

list (列表)

set (集合)

zset (有序集)

hash (哈希表)

3、字符串 String

1)String 操作命令

- 字符串类型的值实际可以是字符串 (简单的字符串、复杂的字符串 (例如 JSON、XML))、数字 (整数、浮点数),甚至是二进制 (图片、音频、视频),但是值最大不能超过 512MB。

| 命令 | 说明 | 实例 |

|---|---|---|

| set | 设置一个 key/value。 set key value [ex seconds][px milliseconds] [nx|xx] - ex seconds:为键设置秒级过期时间 - px milliseconds:为键设置毫秒级过期时间。 - nx:键必须不存在,才可以设置成功,用于添加。 - xx:与 nx 相反,键必须存在,才可以设置成功,用于更新。 | xx]set hello world |

| get | 根据 key 获得对应的 value。键不存在,则返回 nil。 | get hello |

| mset | 一次设置多个 key value | mset a 1 b 2 c 3 d 4 |

| mget | 一次获得多个 key 的 value | mget a b c d |

| getset | 获得原始 key 的值,同时设置新值 | |

| strlen | 获得对应 key 存储 value 的长度 | |

| append | 为对应 key 的 value 追加内容 | |

| getrange | 索引 0 开始 截取 value 的内容 | |

| setex | 设置一个 key 存活的有效期(秒) | |

| psetex | 设置一个 key 存活的有效期(毫秒) | |

| setnx | key 存在时不做任何操作, key 不存在时添加 失败,返回结果为 0。成功,返回结果为 OK。 | setnx hello redis |

| msetnx | 同时设置多个 key,只要有一个存在都不保存(原子操作) | |

| decr | 进行数值类型的 - 1 操作 | |

| decrby | 根据提供的数据进行减法操作 | |

| Incr | 进行数值类型的 + 1 操作 | incr key |

| incrby | 根据提供的数据进行加法操作 | |

| Incrbyfloat | 根据提供的数据加入浮点数 |

2)字符串内部编码

字符串类型的内部编码有 3 种:

- int:8 个字节的长整型。

- embstr:小于等于 39 个字节的字符串。

- raw:大于 39 个字节的字符串。

3)字符串典型使用场景

(1)缓存

(2)计数器

long incrVideoCounter(long id){

key = "video:playCount:" + id;

return redis.incr(key);

}

(3)共享 Session

- 例如,一个分布式 Web 服务使用 Redis 将用户的 Session 进行集中管理。

(4)限速

- 例如,限制用户获取短信验证码频率、限制一个 IP 地址不能在一秒钟之内访问超过 n 次。

phoneNum = "138xxxxxxx";

key = "shortMsg:limit:" + phoneNum;

// SET key value EX 60 NX

isExists = redis.set(key, 1, "EX 60", "NX");

if(isExists != null || redis.incr(key) <= 5)

// 通过

else

// 限速

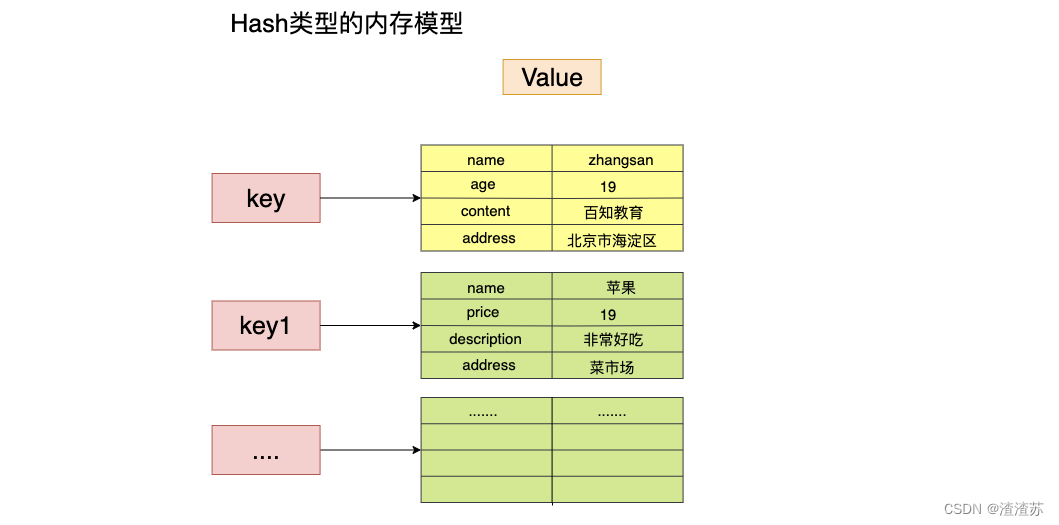

4、哈希 Hash

在 Redis 中,哈希类型是指键值本身又是一个键值对结构,形如 value={{field1, value1},…{fieldN, valueN}}。

1)Hash 命令

| 命令 | 说明 | 实例 |

|---|---|---|

| hset | 设置一个 key/value 对 | hset user:1 name tom |

| hget | 获得一个 key 对应的 value | hget user:1 name |

| hgetall | 获得所有的 key/value 对 | hgetall user:1 |

| hdel | 删除某一个 key/value 对 | hdel user:1 name |

| hexists | 判断一个 key 是否存在 | hexists user:1 name |

| hkeys | 获得所有的 key | hkeys user:1 |

| hvals | 获得所有的 value | hvals user:1 |

| hmset | 设置多个 key/value | hmset user:1 name mike age 12 |

| hmget | 获得多个 key 的 value | hmget user:1 name age |

| hsetnx | 设置一个不存在的 key 的值 | |

| hincrby | 为 value 进行加法运算 | |

| hincrbyfloat | 为 value 加入浮点值 | |

| hlen | 计算 field 个数 | hlen user:1 |

# ①设置值:hset key field value

# 成功会返回 1,反之会返回 0。

127.0.0.1:6379> hset user:1 name tom # 为user:1添加一对field-value

(integer) 1

# ②获取值:hget key field

127.0.0.1:6379> hget user:1 name # 获取user:1的name域(属性)对应的值

"tom"

127.0.0.1:6379> hget user:2 name # 如果键或filed不存在,会返回nil。

(nil)

127.0.0.1:6379> hget user:1 age

(nil)

# ③删除field:hdel key field [field ...]

# hdel 会删除一个或多个 field,返回结果为成功删除 field 的个数。

127.0.0.1:6379> hdel user:1 name

(integer) 1

127.0.0.1:6379> hdel user:1 age

(integer) 0

# ④计算field个数: hlen key

127.0.0.1:6379> hset user:1 name tom

(integer) 1

127.0.0.1:6379> hset user:1 age 23

(integer) 1

127.0.0.1:6379> hset user:1 city tianjin

(integer) 1

127.0.0.1:6379> hlen user:1

(integer) 3

# ⑤批量设置或获取field-value:

hmget key field [field ...]

hmset key field value [field value ...]

127.0.0.1:6379> hmset user:1 name mike age 12 city tianjin

OK

127.0.0.1:6379> hmget user:1 name city

1) "mike"

2) "tianjin"

# ⑥判断field是否存在:hexists key field

# 判断存在时返回结果为 1,不包含时返回 0。

127.0.0.1:6379> hexists user:1 name

(integer) 1

# ⑦获取所有field:hkeys key

# 返回指定哈希键所有的 field。

127.0.0.1:6379> hkeys user:1

1) "name"

2) "age"

3) "city"

# ⑧获取所有value:hvals key

127.0.0.1:6379> hvals user:1

1) "mike"

2) "12"

3) "tianjin"

# ⑨获取所有的field-value: hgetall key

# 在使用 hgetall 时,如果哈希元素个数比较多,会存在阻塞 Redis 的可能。如果开发人员只需要获取部分 field,可以使用 hmget,如果一定要获取全部 field-value,可以使用 hscan 命令,该命令会渐进式遍历哈希类型。

127.0.0.1:6379> hgetall user:1

1) "name"

2) "mike"

3) "age"

4) "12"

5) "city"

6) "tianjin"

# ⑩hincrby hincrbyfloat

hincrby key field

hincrbyfloat key field

# ⑪计算value的字符串长度(需要Redis3.2以上)

hstrlen key field

127.0.0.1:6379> hstrlen user:1 name

(integer) 3 # hget user:1 name的value是tom,所有hstrlen的返回结果是3.

2)哈希内部编码

哈希类型的内部编码有两种:

- ziplist(压缩列表):当哈希类型元素个数小于

hash-max-ziplist-entries配置 (默认 512 个)、同时所有值都小于hash-max-ziplist-value配置(默认 64 字节) 时,Redis 会使用 ziplist 作为哈希的内部实现,ziplist 使用更加紧凑的结构实现多个元素的连续存储,所以在节省内存方面比 hashtable 更加优秀。 - hashtable(哈希表):当哈希类型无法满足 ziplist 的条件时,Redis 会使用 hashtable 作为哈希的内部实现,因为此时 ziplist 的读写效率会下降,而 hashtable 的读写时间复杂度为 O(1)。

# 1、当field个数比较少且没有大的value时,内部编码为ziplist:

127.0.0.1:6379> hmset hashkey f1 v1 f2 v2

OK

127.0.0.1:6379> object encoding hashkey

"ziplist"

# 2、当有value大于64字节,内部编码会由ziplist变为hashtable:

127.0.0.1:6379> hset hashkey f3 "one string is bigger than 64 byte ...忽略..."

OK

127.0.0.1:6379> object encoding hashkey

"hashtable"

# 3、当field个数超过512,内部编码也会由ziplist变为hashtable:

127.0.0.1:6379> hset hashkey f1 v1 f2 v2 f3 v3 ...忽略... f513 v513

OK

127.0.0.1:6379> object encoding hashkey

"hashtable"

3)哈希使用场景

(1)用户信息缓存

相对于使用字符串序列化缓存用户信息,哈希类型变得更加直观,并且在更新操作上会更加便捷。可以将每个用户的 id 定义为键后缀,多对 field-value 对应每个用户的属性。

UserInfo getUserInfo(long id)

{

// 用户id作为key后缀

userRedisKey = "user:info:" + id;

// 使用hgetall获取所有用户信息映射关系

userInfoMap = redis.hgetAll(userRedisKey);

UserInfo userInfo;

if(userInfoMap != null) {

// 将映射关系转换为UserInfo

userInfo = transferMapToUserInfo(userInfoMap);

} else {

// 从MySQL中获取用户信息

userInfo = mysql.get(id);

// 将userInfo变为映射关系使用hmset保存到Redis中

redis.hmset(userRedisKey, transferUserInfoToMap(userInfo));

// 添加过期时间

redis.expire(userRedisKey, 3600);

}

return userInfo;

}

(2)三种缓存方案比较

1)原生字符串类型:每个属性一个键。

set user:1:name tom

set user:1:age 23

set user:1:city beijing

- 优点:简单直观,每个属性都支持更新操作。

- 缺点:占用过多的键,内存占用量较大,同时用户信息内聚性比较差,所以此种方案一般不会在生产环境使用。

2)序列化字符串类型:将用户信息序列化后用一个键保存。

set user:1 serialize(userInfo)

- 优点:简化编程,如果合理的使用序列化可以提高内存的使用效率。

- 缺点:序列化和反序列化有一定的开销,同时每次更新属性都需要把全部数据去除进行反序列化,更新后再序列化到 Redis 中。

3)哈希类型:每个用户属性使用一对 field-value,但是只用一个键保存。

hmset user:1 name tom age 23 city beijing

- 优点:简单直观,如果使用合理可以减少内存空间的使用。

- 缺点:要控制哈希在 ziplist 和 hashtable 两种内部编码的转换,hashtable 会消耗更多内存。

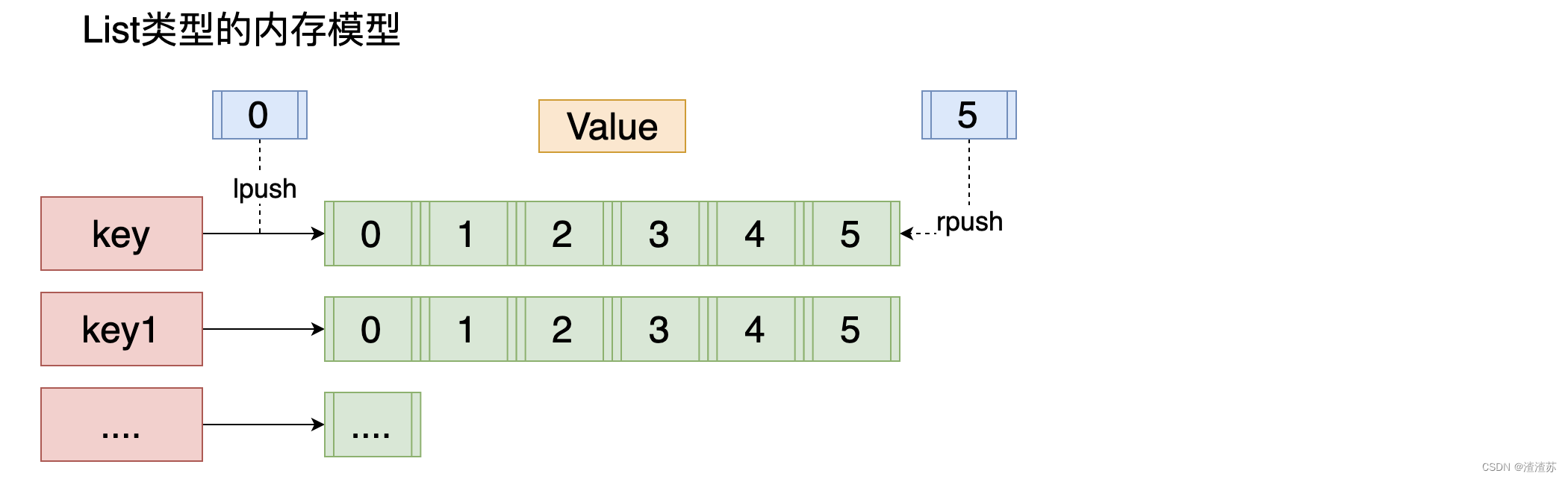

5、列表 List

1)列表概述

2)列表命令

| 命令 | 说明 |

|---|---|

| lpush | 将某个值加入到一个 key 列表头部 |

| lpushx | 同 lpush, 但是必须要保证这个 key 存在 |

| rpush | 将某个值加入到一个 key 列表末尾 |

| rpushx | 同 rpush, 但是必须要保证这个 key 存在 |

| lpop | 返回和移除列表左边的第一个元素 |

| rpop | 返回和移除列表右边的第一个元素 |

| lrange | 获取某一个下标区间内的元素 |

| llen | 获取列表元素个数 |

| lset | 设置某一个指定索引的值 (索引必须存在) |

| lindex | 获取某一个指定索引位置的元素 |

| lrem listname count value | 删除元素 (正数从左边开始删,负数从右边开始删除) |

| ltrim | 保留列表中特定区间内的元素 |

| linsert listname before/after pivot value | 在某一个元素之前,之后插入新元素 |

| blpop brpop | lpop 和 rpop 的阻塞版本 |

(1)添加操作

# ①从右边插入元素: rpush key value [value . . .]

127.0.0.1:6379> rpush listkey c b a # 从右向左插入元素c、b、a

(integer) 3

127.0.0.1:6379> lrange listkey 0 -1 # 从左到右获取列表的所有元素

1) "c"

2) "b"

3) "a"

# ②从左边插入元素: rpush key value [value . . .]

# ③向某个元素前或者后插入元素: linsert key before|after pivot value

# linsert 命令会从列表中找到等于 pivot 的元素,在其前 (before) 或者后 (after) 插入一个新的元素 value。

127.0.0.1:6379> linsert listkey before b java // 在列表的元素b前插入java。

(integer) 4 // 返回结果4,代表当前列表的长度。

127.0.0.1:6379> lrange listkey 0 -1

1) "c"

2) "java"

3) "b"

4) "a"

(2)查找

# ①获取指定范围内的元素列表: lrange key start end

# 第一,索引下标从左到右分别是 0 到 N-1 ,但是从右到左分别是 -1 到 -N;第二,lrange 中的 end 选项包含了自身

127.0.0.1:6379> lrange listkey 1 3 # 获取列表的第2到第4个元素。

1) "java"

2) "b"

3) "a"

# ②获取列表指定索引下标的元素: lindex key index

127.0.0.1:6379> lindex listkey -1 # 当前列表的最后一个元素为a

"a"

# ③获取列表长度: llen key

127.0.0.1:6379> llen listkey

(integer) 4

(3)删除

# ①从列表左侧弹出元素: lpop key

127.0.0.1:6379> lpop listkey

"c"

127.0.0.1:6379> lrange listkey 0 -1

1) "java"

2) "b"

3) "a"

# ②从列表右侧弹出:

rpop key

# ③删除指定元素:

lrem key count value

# ④按照索引范围修剪列表: ltrim key start end

127.0.0.1 :6379> lrange listkey 0 -1

1) "a"

2) "java"

3) "b"

4) "a"

127.0.0.1 :6379> ltrim listkey 1 3 # 只保留列表listkey的第2个到第4个元素。

OK

127.0.0.1 :6379> lrange listkey 0 -1

1) "java"

2) "b"

3) "a"

- lrem 命令会从列表中找到等于 value 的元素进行删除,根据 count 的不同 分为三种情况:

- count>0 ,从左到右,删除最多 count 个元素。

- count<0 ,从右到左,删除最多 count 绝对值个元素。

- count=0 ,删除所有。

(4)修改

# ①修改指定索引下标的元素: lset key index newValue

127.0.0.1:6379> lset listkey 2 python # 将列表listkey中的第3个元素设置为python

OK

127.0.0.1:6379> lrange listkey 0 -1

1) "java"

2) "b"

3) "python"

(5)阻塞操作

blpop key [key . . .] timeout

brpop key [key . . .] timeout

- blpop 和 brpop 是 lpop 和 rpop 的阻塞版本,它们除了弹出方向不同,使用方法基本相同。

- blpop/brpop 命令包含两个参数:

- key[key…]:多个列表的键。

- timeout:阻塞时间(单位:秒)。

- 列表为空:如果 timeout=3,那么客户端要等到 3 秒后返回;如果 timeout=0,那么客户端一直阻塞等下去,如果此期间添加了数据 element1 ,客户端立即返回。

- 列表不为空:客户端会立即返回。

- 在使用 blpop/brpop 时,有两点需要注意:

- 第一点,如果是多个键,那么 brpop 会从左至右遍历键,一旦有一个键能弹出元素,客户端立即返回。

- 第二点,如果多个客户端对同一个键执行 brpop,那么最先执行 brpop 命令的客户端可以获取到弹出的值。

3)列表的内部编码

列表类型的内部编码有两种。

- ziplist(压缩列表):当列表的元素个数小于

list-max-ziplist-entries配置 (默认 512 个),同时列表中每个元素的值都小于list-max-ziplist-value配置时 (默认 64 字节),Redis 会选用 ziplist 来作为列表的内部实现来减少内存的使用。 - linkedlist(链表) :当列表类型无法满足 ziplist 的条件时,Redis 会使用 linkedlist 作为列表的内部实现。

# 1、当元素个数较少且没有大元素时,内部编码为ziplist:

127.0.0.1:6379> rpush listkey e1 e2 e3

(integer) 3

127.0.0.1:6379> object encoding listkey

"ziplist"

# 2、当元素个数超过512个,内部编码变为linkedlist:

127.0.0.1:6379> rpush listkey e4 e5 . . .忽略 . . . e512 e513

(integer) 513

127.0.0.1:6379> object encoding listkey

"linkedlist"

# 3、当某个元素超过64字节,内部编码也会变为linkedlist:

127.0.0.1:6379> rpush listkey "one string is bigger than 64 byte . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . "

(integer) 4

127.0.0.1:6379> object encoding listkey

"linkedlist"

- Redis3.2 版本提供了 quicklist 内部编码,简单地说它是以一个 ziplist 为节点的 linkedlist,它结合了 ziplist 和 linkedlist 两者的优势,为列表类型提供了一种更为优秀的内部编码实现。

4)List 使用场景

(1)消息队列

Redis 的 lpush+brpop 命令组合即可实现阻塞队列,生产者客户端使用 lrpush 从列表左侧插入元素,多个消费者客户端使用 brpop 命令阻塞式的 “抢” 列表尾部的元素,多个客户端保证了消费的负载均衡和高可用性。

(2)文章列表

每个用户有属于自己的文章列表,现需要分页展示文章列表。此时可以考虑使用列表,因为列表不但是有序的,同时支持按照索引范围获取元素。

使用列表类型保存和获取文章列表会存在两个问题。

- 第一,如果每次分页获取的文章个数较多,需要执行多次 hgetall 操作,此时可以考虑使用 Pipeline 批量获取,或者考虑将文章数据序列化为字符串类型,使用 mget 批量获取。

- 第二,分页获取文章列表时,lrange 命令在列表两端性能较好,但是如果列表较大,获取列表中间范围的元素性能会变差,此时可以考虑将列表做二级拆分,或者使用 Redis3.2 的 quicklist 内部编码实现,它结合 ziplist 和 linkedlist 的特点,获取列表中间范围的元素时也可以高效完成。

(3)实际上列表的使用场景很多,在选择时可以参考以下口诀:

- lpush+lpop=Stack(栈)

- lpush+rpop=Queue(队列)

- lpush+ltrim=Capped Collection(有限集合)

- lpush+brpop=Message Queue(消息队列)

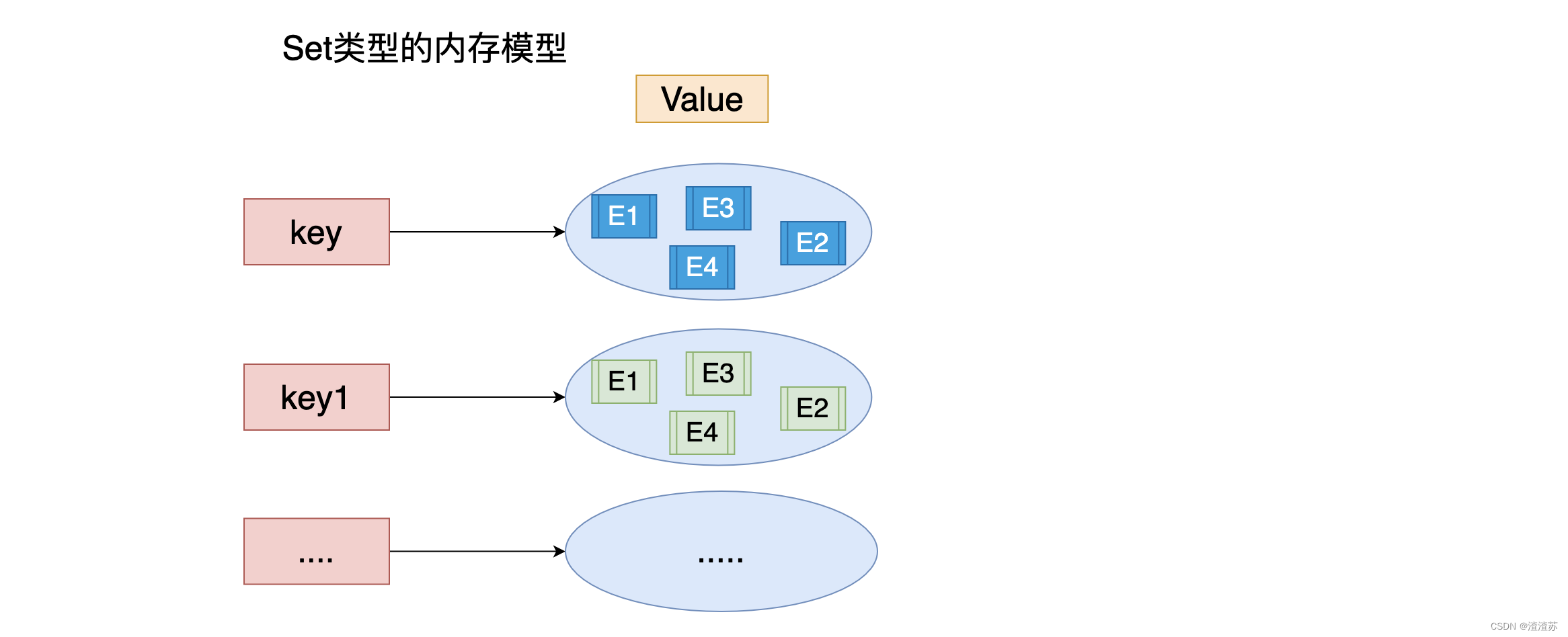

6、集合 Set

1)集合概述

- 集合 (set) 中不允许有重复元素,并且集合中的元素是无序的。

- 一个集合最多可以存储 2^32-1 个元素。

- Redis 除了支持集合内的增删改查,同时还支持多个集合取交集、并集、差集。

2)集合命令

| 命令 | 说明 |

|---|---|

| sadd | 为集合添加元素 |

| smembers | 显示集合中所有元素 无序 |

| scard | 返回集合中元素的个数 |

| spop | 随机返回一个元素 并将元素在集合中删除 |

| smove (formset toset value) | 从一个集合中向另一个集合移动元素 必须是同一种类型 |

| srem | 从集合中删除一个元素 |

| sismember | 判断一个集合中是否含有这个元素 |

| srandmember | 随机返回元素 |

| sdiff | 去掉第一个集合中其它集合含有的相同元素 (第一个集合的补集) |

| sinter | 求交集 |

| sunion | 求和集 |

(1)集合内操作

# ①添加元素: sadd key element [element . . .]

# sadd 返回结果为添加成功的元素个数。

127.0.0.1:6379> exists myset

(integer) 0

127.0.0.1:6379> sadd myset a b c

(integer) 3

127.0.0.1:6379> sadd myset a b

(integer) 0

# ②删除元素: srem key element [element . . .]

# srem 返回结果为成功删除元素个数。

127.0.0.1:6379> srem myset a b

(integer) 2

127.0.0.1:6379> srem myset hello

(integer) 0

# ③计算元素个数: scard key

# scard 的时间复杂度为 O(1),它不会遍历集合所有元素,而是直接用 Redis 内部的变量。

127.0.0.1:6379> scard myset

(integer) 1

# ④判断元素是否在集合中: sismember key element

127.0.0.1:6379> sismember myset c

(integer) 1

# ⑤随机从集合返回指定个数元素: srandmember key [count]

# srandmember 中的 [count] 是可选参数,如果不写默认为 1。

127.0.0.1:6379> srandmember myset 2

1) "a"

2) "c"

127.0.0.1:6379> srandmember myset

"d"

# ⑥从集合随机弹出元素: spop key

# spop 操作可以从集合中随机弹出一个元素。

# 注意 Redis 从 3.2 版本开始,spop 也支持 [count] 参数。

# srandmember 和 spop 都是随机从集合选出元素,两者不同的是 spop 命令执行后,元素会从集合中删除,而 srandmember 不会。

127.0.0.1:6379> spop myset

"c"

127.0.0.1:6379> smembers myset

1) "d"

2) "b"

3) "a"

# ⑦获取所有元素: smembers key

# smembers返回结果是无序的。

127.0.0.1:6379> smembers myset

1) "d"

2) "b"

3) "a"

- smembers 和 lrange、hgetall 都属于比较重的命令,如果元素过多存在阻塞 Redis 的可能性,这时候可以使用 sscan 来完成。

(2)集合间操作

# ①求多个集合的交集: sinter key [key . . .]

127.0.0.1:6379> sinter user:1:follow user:2:follow

1) "sports"

2) "it"

# ②求多个集合的并集: suinon key [key . . .]

127.0.0.1:6379> sunion user:1:follow user:2:follow

1) "sports"

2) "it"

3) "his"

4) "news"

5) "music"

6) "ent"

# ③求多个集合的差集: sdiff key [key . . .]

127.0.0.1:6379> sdiff user:1:follow user:2:follow

1) "music"

2) "his"

# ④将交集、并集、差集的结果保存

sinterstore destination key [key . . .]

suionstore destination key [key . . .]

sdiffstore destination key [key . . .]

127.0.0.1:6379> sinterstore user:1_2:inter user:1:follow user:2:follow

(integer) 2

127.0.0.1:6379> type user:1_2:inter

set

127.0.0.1:6379> smembers user:1_2:inter

1) "it"

2) "sports"

- 集合间的运算在元素较多的情况下会比较耗时,所以 Redis 提供了上面三个命令 (原命令 + store) 将集合间交集、并集、差集的结果保存在 destination key 中。

3)集合的内部编码

集合类型的内部编码有两种:

- intset(整数集合):当集合中的元素都是整数且元素个数小于 set-max-intset-entries 配置 (默认 512 个) 时,Redis 会选用 intset 来作为集合的内部实现,从而减少内存的使用。

- hashtable(哈希表):当集合类型无法满足 intset 的条件时,Redis 会使用 hashtable 作为集合的内部实现。

# 1、当元素个数较少且都为整数时,内部编码为intset:

127.0.0.1:6379> sadd setkey 1 2 3 4

(integer) 4

127.0.0.1:6379> object encoding setkey

"intset"

# 2、当元素个数超过512个,内部编码变为hashtable:

127.0.0.1:6379> sadd setkey 1 2 3 4 5 6 ... 512 513

(integer) 509

127.0.0.1:6379> scard setkey

(integer) 513

127.0.0.1:6379> object encoding

"hashtable"

# 3、当某个元素不为整数时,内部编码也会变为hashtable:

127.0.0.1 :6379> sadd setkey a

(integer) 1

127.0.0.1 :6379> object encoding setkey

"hashtable"

4)集合的使用场景

(1)集合类型比较典型的使用场景是标签 (tag)。 例如给用户打上喜好的标签 (音乐、体育等等)。

下面使用集合类型实现标签功能的若干功能。

# 1、给用户添加标签

sadd user:1:tags tag1 tag2 tag5

sadd user:2:tags tag2 tag3 tag5

. . .

sadd user:k:tags tag1 tag2 tag4

. . .

# 2、给标签添加用户

sadd tag1:users user:1 user:3

sadd tag2:users user:1 user:2 user:3

...

sadd tagk:users user:1 user:2

# 3、删除用户下的标签

srem user:1:tags tag1 tag5

. . .

# 4、删除标签下的用户

srem tag1:users user:1

srem tag5:users user:1

. . .

# 5、计算用户共同感兴趣的标签(可以使用sinter命令,来计算用户共同感兴趣的标签)

sinter user:1:tags user:2:tags

- 用户和标签的关系维护应该在一个事务内执行,防止部分命令失败造成的数据不一致。例如上面的 1 和 2。

(2)集合类型的应用场景通常为以下几种:

- sadd=Tagging(标签)

- spop/srandmember=Random item(生成随机数,比如抽奖)

- sadd+sinter=Social Graph(社交需求)

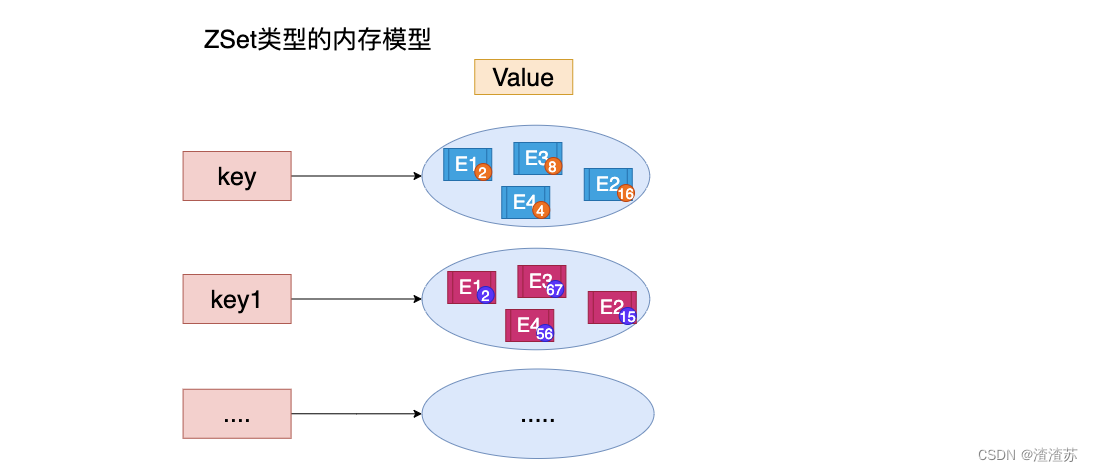

7、有序集合 ZSet

1)ZSet 概述

有序集合保留了集合不能有重复成员的特性,但不同的是,有序集合中的元素可以排序。但是它和列表使用索引下标作为排序依据不同的是,它给每个元素设置一个分数 (score) 作为排序的依据。

注意:有序集合中的元素不能重复,但是 score 可以重复,就和一个班里的同学学号不能重复,但是考试成绩可以相同。

下表为列表、集合、有序集合三者的异同点:

| 数据结构 | 是否允许重复元素 | 是否有序 | 有序实现方式 | 应用场景 |

|---|---|---|---|---|

| 列表 | 是 | 是 | 索引下标 | 时间轴、消息队列等 |

| 集合 | 否 | 否 | 无 | 标签、社交等 |

| 有序集合 | 否 | 是 | 分值 | 排行榜系统、社交等 |

2)有序结合命令

| 命令 | 说明 |

|---|---|

| zadd | 添加一个有序集合元素 |

| zcard | 返回集合的元素个数 |

| zrange 升序 | 返回一个范围内的元素 |

| zrevrange 降序 (reversal 反转) | 返回一个范围内的元素 |

| zrangebyscore | 按照分数查找一个范围内的元素 |

| zrank | 返回排名 |

| zrevrank | 倒序排名 |

| zscore | 显示某一个元素的分数 |

| zrem | 移除某一个元素 |

| zincrby | 给某个特定元素加分 |

(1)集合内

# ①添加成员: zadd key score member [score member . . .]

# zadd 返回结果代表成功添加成员的个数。

127.0.0.1:6379> zadd user:ranking 251 tom

(integer) 1

127.0.0.1:6379> zadd user:ranking 1 kris 91 mike 200 frank 220 tim 250 martin (integer) 5

# ②计算成员个数: zcard key

127.0.0.1:6379> zcard user:ranking

(integer) 5

# ③计算某个成员的分数: zscore key member

127.0.0.1:6379> zscore user:ranking tom

"251"

# zscore 如果成员不存在则返回 nil。

127.0.0.1:6379> zscore user:ranking test

(nil)

# ④计算成员的排名

zrank key member

zrevrank key member

# zrank 是从分数从低到高返回排名,zrevrank 反之。(排名从 0 开始计算)

127.0.0.1:6379> zrank user:ranking tom

(integer) 5

127.0.0.1:6379> zrevrank user:ranking tom

(integer) 0

# ⑤删除成员: zrem key member [member . . .]

# zrem 返回结果为成功删除的个数。

127.0.0.1:6379> zrem user:ranking mike

(integer) 1

# ⑥增加成员的分数: zincrby key increment member

# zincrby 返回增加后的分数。

127.0.0.1:6379> zincrby user:ranking 9 tom

"260"

# ⑦返回指定排名范围的成员

zrange key start end [withscores]

zrevrange key start end [withscores]

# 有序集合是按照分值排名的,zrange 是从低到高返回,zrevrange 反之。

127.0.0.1:6379> zrange user:ranking 0 2 withscores

1) "kris"

2) "1"

3) "frank"

4) "200"

5) "tim"

6) "220"

127.0.0.1:6379> zrevrange user:ranking 0 2 withscores

1) "tom"

2) "260"

3) "martin"

4) "250"

5) "tim"

6) "220"

# ⑧返回指定分数范围的成员

# zrangebyscore 按照分数从低到高返回,zrevrangebyscore 反之。

zrangebyscore key min max [withscores] [limit offset count]

zrevrangebyscore key max min [withscores] [limit offset count]

# 1. [limit offset count] 选项可以限制输出的起始位置和个数。

# 2. min 和 max 还支持开区间 (小括号) 和闭区间(中括号),-inf 和 + inf 分别代表无限小和无限大。

# withscores 选项会同时返回每个成员的分数。

127.0.0.1:6379> zrangebyscore user:ranking 200 221 withscores

1) "frank"

2) "200"

3) "tim"

4) "220"

127.0.0.1:6379> zrevrangebyscore user:ranking 221 200 withscores

1) "tim"

2) "220"

3) "frank"

4) "200"

127.0.0.1:6379> zrangebyscore user:ranking (200 +inf withscores

1) "tim"

2) "220"

3) "martin"

4) "250"

5) "tom"

6) "260"

# ⑨返回指定分数范围成员个数: zcount key min max

127.0.0.1:6379> zcount user:ranking 200 221 # 返回200到221分的成员的个数

(integer) 2

# ⑩删除指定排名内的升序元素: zremrangebyrank key start end

# zremrangebyrank 删除第 start 到第 end 名的成员,返回结果为成功删除的个数。

127.0.0.1:6379> zremrangebyrank user:ranking 0 2

(integer) 3

# ⑪删除指定分数范围的成员: zremrangebyscore key min max

127.0.0.1:6379> zremrangebyscore user:ranking (250 +inf # 将250分以上的成员全部删除

(integer) 2

- 有关 zadd 命令有两点需要注意:

- Redis3.2 为 zadd 命令添加了 nx、xx、ch、incr 四个选项:

- nx:member 必须不存在,才可以设置成功,用于添加。

- xx:member 必须存在,才可以设置成功,用于更新。

- ch:返回此次操作后,有序集合元素和分数发生变化的个数。

- incr:对 score 做增加,相当于后面介绍的 zincrby。

- 有序集合相比集合提供了排序字段,但是也产生了代价,zadd 的时间复杂度为 O(log (n)),sadd 的时间复杂度为 O(1)。

- Redis3.2 为 zadd 命令添加了 nx、xx、ch、incr 四个选项:

(2)集合外

# ①交集: zinterstore destination numkeys key [key . . .] [weights weight [weight . . .]] [aggregate sum|min|max]

# zinterstore 的命令参数:

# 1. destination:交集计算结果保存到这个键。

# 2. numkeys :需要做交集计算键的个数。

# 3. key[key…] :需要做交集计算的键。

# 4. weights weight[weight…]:每个键的权重,在做交集计算时,每个键中的每个 member 会将自己分数乘以这个权重,每个键的权重默认是 1。

# 5. aggregate sum|min|max:计算成员交集后,分值可以按照 sum(和) 、min(最小值) 、max(最大值) 做汇总,默认值是 sum。

127.0.0.1:6379> zinterstore user:ranking:1_inter_2 2 user:ranking:1 user:ranking:2

(integer) 3

127.0.0.1 :6379> zrange user:ranking:1_inter_2 0 -1 withscores

1) "mike"

2) "168"

3) "martin"

4) "875"

5) "tom"

6) "1139"

127.0.0.1:6379> zinterstore user:ranking:1_inter_2 2 user:ranking:1 user:ranking:2 weights 1 0.5 aggregate max # user:ranking:2的权重变为0.5,并且聚合效果使用max

(integer) 3

127.0.0.1 :6379> zrange user:ranking:1_inter_2 0 -1 withscores

1) "mike"

2) "91"

3) "martin"

4) "312.5"

5) "tom"

6) "444"

# ②并集

zunionstore destination numkeys key [key ...] [weights weight [weight ...] [aggregate sum|min|max]

127.0.0.1:6379> zunionstore user:ranking:1_union_2 2 user:ranking:1 user:ranking :2

(integer) 7

127.0.0.1:6379> zrange user:ranking:1_union_2 0 -1 withscores

1) "kris"

2) "1"

3) "james"

4) "8"

5) "mike"

6) "168"

7) "frank"

8) "200"

9) "tim"

10) "220"

11) "martin"

12) "875"

13) "tom"

14) "1139"

3)有序集合内部编码

有序集合类型的内部编码有两种:

- ziplist(压缩列表) :当有序集合的元素个数小于

zset-max-ziplist-entries配置 (默认 128 个),同时每个元素的值都小于zset-max-ziplist-value配置(默认 64 字节) 时,Redis 会用 ziplist 来作为有序集合的内部实现,ziplist 可以有效减少内存的使用。 - skiplist(跳跃表):当 ziplist 条件不满足时,有序集合会使用 skiplist 作为内部实现,因为此时 ziplist 的读写效率会下降。

# 1、当元素个数较少且每个元素较小时,内部编码为skiplist:

127.0.0.1:6379> zadd zsetkey 50 e1 60 e2 30 e3

(integer) 3

127.0.0.1:6379> object encoding zsetkey

"ziplist"

# 2、当元素个数超过128个,内部编码变为ziplist:

127.0.0.1:6379> zadd zsetkey 50 e1 60 e2 30 e3 12 e4 ...忽略... 84 e129

(integer) 129

127.0.0.1:6379> object encoding

"skiplist"

# 3、当某个元素大于64字节时,内部编码也会变为hashtable:

127.0.0.1:6379> zadd zsetkey 20 "one string is bigger than 64 byte . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . "

(integer) 1

127.0.0.1:6379> object encoding

"skiplist"

4)有序集合使用场景

有序集合比较典型的使用场景就是排行榜系统。

# 1、添加用户赞数

zadd user:ranking:2016_03_15 mike 3

# 2、取消用户赞数

zrem user:ranking:2016_03_15 mike

# 3、展示获取赞数最多的十个用户

zrevrangebyrank user:ranking:2016_03_15 0 9

# 4、展示用户信息以及用户分数

hgetall user:info:tom

zscore user:ranking:2016_03_15 mike // 用户分数

zrank user:ranking:2016_03_15 mike // 用户排名

8、单个键管理

3、键过期

127.0.0.1:6379> expireat hello 1469980800 # 将键hello在2016-08-01 00:00:00(秒级时间戳为1469980800)过期

(integer) 1

127.0.0.1:6379> expire not_exist_key 30

(integer) 0

127.0.0.1:6379> set hello world

OK

127.0.0.1:6379> expire hello -2

(integer) 1

127.0.0.1:6379> get hello

(nil)

127.0.0.1:6379> hset key f1 v1

(integer) 1

127.0.0.1:6379> expire key 50

(integer) 1

127.0.0.1:6379> ttl key

(integer) 46

127.0.0.1:6379> persist key

(integer) 1

127.0.0.1:6379> ttl key

(integer) -1

127.0.0.1:6379> expire hello 50

(integer) 1

127.0.0.1:6379> ttl hello

(integer) 46

127.0.0.1:6379> set hello world

OK

127.0.0.1:6379> ttl hello

(integer) -1

- 除了 expire、ttl 命令以外,Redis 还提供了 expireat、pexpire、pexpireat、pttl、persist 等一系列命令,下面分别进行说明:

- expire key seconds :键在 seconds 秒后过期。

- expireat key timestamp :键在秒级时间戳 timestamp 后过期。

- ttl 命令和 pttl 都可以查询键的剩余过期时间,但是 pttl 精度更高可以达到毫秒级别,有 3 种返回值:

- 大于等于 0 的整数:键剩余的过期时间(ttl 是秒,pttl 是毫秒)。

- -1:键没有设置过期时间。

- -2:键不存在。

- expireat 命令可以设置键的秒级过期时间戳。

- 除此之外,Redis2.6 版本后提供了毫秒级的过期方案:

- pexpire key milliseconds:键在 milliseconds 毫秒后过期。

- pexpireat key milliseconds-timestamp 键在毫秒级时间戳 timestamp 后过期。

- 注意:但无论是使用过期时间还是时间戳,秒级还是毫秒级,在 Redis 内部最终使用的都是 pexpireat。

- 在使用 Redis 相关过期命令时,需要注意以下几点:

- 如果 expire key 的键不存在,返回结果为 0。

- 如果过期时间为负值,键会立即被删除,犹如使用 del 命令一样。

- persist 命令可以将键的过期时间清除。

- 对于字符串类型键,执行 set 命令会去掉过期时间,这个问题很容易在开发中被忽视。

- Redis 不支持二级数据结构 (例如哈希、列表) 内部元素的过期功能,例如不能对列表类型的一个元素做过期时间设置。

- setex 命令作为 set+expire 的组合,不但是原子执行,同时减少了一次网络通讯的时间。

4、迁移键

# ①move key db

# ②dump key

restore key ttl value

# 第一步:在源Redis上执行dump:

redis-source> set hello world

OK

redis-source> dump hello "\x00\x05world\x06\x00\x8f<T\x04%\xfcNQ"

# 第二步:在目标Redis上执行restore:

redis-target> get hello

(nil)

redis-target> restore hello 0 "\x00\x05world\x06\x00\x8f<T\x04%\xfcNQ"

OK

redis-target> get hello

"world"

# 上面2步对应的伪代码如下:

Redis sourceRedis = new Redis ("sourceMachine", 6379);

Redis targetRedis = new Redis ("targetMachine", 6379);

targetRedis.restore("hello", 0, sourceRedis.dump(key));

# ③migrate

migrate host port key|"" destination-db timeout [copy] [replace] [keys key [key ...]]

127.0.0.1:6379> migrate 127.0.0.1 6379 hello 0 1000 replace

OK

127.0.0.1:6379> migrate 127.0.0.1 6380 "" 0 5000 keys key1 key2 key3

OK

- 迁移键功能非常重要,因为有时候我们只想把部分数据由一个 Redis 迁移到另一个 Redis(例如从生产环境迁移到测试环境),Redis 发展历程中提供了 move、dump+restore、migrate 三组迁移键的方法。

- move 命令用于在 Redis 内部进行数据迁移,Redis 内部可以有多个数据库,彼此在数据上是相互隔离的,move key db 就是把指定的键从源数据库移动到目标数据库中,但笔者认为多数据库功能不建议在生产环境使用。

- dump+restore 可以实现在不同的 Redis 实例之间进行数据迁移的功能,整个迁移的过程分为两步:

- 在源 Redis 上,dump 命令会将键值序列化,格式采用的是 RDB 格式。

- 在目标 Redis 上,restore 命令将上面序列化的值进行复原,其中 ttl 参数代表过期时间,如果 ttl=0 代表没有过期时间。

- 有关 dump+restore 有两点需要注意:第一,整个迁移过程并非原子性的,而是通过客户端分步完成的。第二,迁移过程是开启了两个客户端连接,所以 dump 的结果不是在源 Redis 和目标 Redis 之间进行传输。

- migrate 命令也是用于在 Redis 实例间进行数据迁移的,实际上 migrate 命令就是将 dump、restore、del 三个命令进行组合,从而简化了操作流程。migrate 命令具有原子性,而且从 Redis3.0.6 版本以后已经支持迁移多个键的功能,有效地提高了迁移效率,migrate 在水平扩容中起到重要作用。

- migrate 实现过程和 dump+restore 基本类似,但是有 3 点不太相同:第一,整个过程是原子执行的,不需要在多个 Redis 实例上开启客户端的,只需要在源 Redis 上执行 migrate 命令即可。第二,migrate 命令的数据传输直接在源 Redis 和目标 Redis 上完成的。第三,目标 Redis 完成 restore 后会发送 OK 给源 Redis,源 Redis 接收后会根据 migrate 对应的选项来决定是否在源 Redis 上删除对应的键。

- migrate 的参数进行的说明:

- host:目标 Redis 的 IP 地址。

- port:目标 Redis 的端口。

- key|“”:在 Redis3.0.6 版本之前,migrate 只支持迁移一个键,所以此处是要迁移的键,但 Redis3.0.6 版本之后支持迁移多个键,如果当前需要迁移多个键,此处为空字符串 “”。

- destination-db:目标 Redis 的数据库索引,例如要迁移到 0 号数据库,这里就写 0。

- timeout:迁移的超时时间 (单位为毫秒)。

- [copy]:如果添加此选项,迁移后并不删除源键。

- [replace]:如果添加此选项,migrate 不管目标 Redis 是否存在该键都会正常迁移进行数据覆盖。

- [keys key[key…]]:迁移多个键,例如要迁移 key1、key2、key3,此处填写 “keys key1 key2 key3”。

// 如下是Redis源码中,set命令的函数setKey,可以看到最后执行了removeExpire(db ,key)函数去掉了过期时间

void setKey (redisDb *db, robj *key, robj *val) {

if (lookupKeyWrite (db,key) == NULL) {

dbAdd (db,key,val);

} else {

dbOverwrite (db,key,val);

}

incrRefCount (val);

// 去掉过期时间

removeExpire (db,key);

signalModifiedKey (db,key);

}

笔者建议使用 migrate 命令进行键值迁移。

下表为 move、dump+restore、migrate 三种迁移方式的异同点:

| 命令 | 作用域 | 原子性 | 支持多个键 |

|---|---|---|---|

| move | Redis 实例内部 | 是 | 否 |

| dump+restore | Redis 实例之间 | 否 | 否 |

| migrate | Redis 实例之间 | 是 | 是 |

5、遍历键

Redis 提供了两个命令遍历所有的键,分别是 keys 和 scan。

1)全量遍历键

keys pattern

127.0.0.1:6379> dbsize

(integer) 0

127.0.0.1:6379> mset hello world redis best jedis best hill high

OK

127.0.0.1:6379> keys *

1) "hill"

2) "jedis"

3) "redis"

4) "hello"

127.0.0.1:6379> keys [j,r]edis # 匹配以j,r开头,紧跟edis字符串的所有键

1) "jedis"

2) "redis"

127.0.0.1:6379> keys hll*

1) "hill"

2) "hello"

redis-cli keys video* | xargs redis-cli del # 删除所有以video字符串开头的键

- 如果要获取所有的键,可以使用 keys pattern 命令。

- pattern 使用的是 glob 风格的通配符:

1.

* 代表匹配任意字符。

2. ? 代表匹配一个字符。

3. []代表匹配部分字符,例如 [1,3] 代表匹配 1,3 ,[1-10]代表匹配 1 到 10 的任意数字。

4. \x 用来做转义,例如要匹配星号、问号需要进行转义。 - 如果 Redis 包含了大量的键,执行 keys 命令很可能会造成 Redis 阻塞,所以一般建议不要生产环境下使用 keys 命令。但有时候确实有遍历键的需求该怎么办,可以在以下三种情况使用:

- 在一个不对外提供服务的 Redis 从节点上执行,这样不会阻塞到客户端的请求,但是会影响到主从复制。

- 如果确认键值总数确实比较少,可以执行该命令。

- 使用 scan 命令渐进式的遍历所有键,可以有效防止阻塞。

- Redis 从 2.8 版本后,提供了一个新的命令 scan,它能有效的解决 keys 命令存在的问题。和 keys 命令执行时会遍历所有键不同,scan 采用渐进式遍历的方式来解决 keys 命令可能带来的阻塞问题,每次 scan 命令的时间复杂度是 O(1),但是要真正实现 keys 的功能,需要执行多次 scan。Redis 存储键值对实际使用的是 hashtable 的数据结构。

2)渐进式遍历

scan cursor [match pattern] [count number]

# 第一次执行scan0,返回结果分为两个部分:第一个部分6就是下次scan需要的cursor,第二个部分是10个键:

127.0.0.1:6379> scan 0

1) "6"

2) 1) "w"

2) "i"

3) "e"

4) "x"

5) "j"

6) "q"

7) "y"

8) "u"

9) "b"

10) "o"

127.0.0.1:6379> scan 6

1) "11"

2) 1) "h"

2) "n"

3) "m"

4) "t"

5) "c"

6) "d"

7) "g"

8) "p"

9) "z"

10) "a"

127.0.0.1:6379> scan 11

1) "0"

2) 1) "s"

2) "f"

3) "r"

4) "v"

5) "k"

6) "l"

- scan 的参数进行的说明:

- cursor 是必需参数,实际上 cursor 是一个游标,第一次遍历从 0 开始,每次 scan 遍历完都会返回当前游标的值,直到游标值为 0,表示遍历结束。

- match pattern 是可选参数,它的作用的是做模式的匹配,这点和 keys 的模式匹配很像。

- count number 是可选参数,它的作用是表明每次要遍历的键个数,默认值是 10,此参数可以适当增大。

- 除了 scan 以外,Redis 提供了面向哈希类型、集合类型、有序集合的扫描遍历命令,解决诸如 hgetall、smembers、zrange 可能产生的阻塞问题,对应的命令分别是 hscan、sscan、zscan,它们的用法和 scan 基本类似。

- 渐进式遍历可以有效的解决 keys 命令可能产生的阻塞问题,但是 scan 并非完美无瑕,如果在 scan 的过程中如果有键的变化 (增加、删除、修改),那么遍历效果可能会碰到如下问题: 新增的键可能没有遍历到,遍历出了重复的键等情况,也就是说 scan 并不能保证完整的遍历出来所有的键,这些是我们在开发时需要考虑的。

// 以sscan为例子进行说明,当前集合有两种类型的元素,例如分别以old:user和new:user开头,先需要将old:user开头的元素全部删除:

String key = "myset";

// 定义pattern

String pattern = "old:user*";

// 游标每次从0开始

String cursor = "0";

while (true) {

// 获取扫描结果

ScanResult scanResult = redis.sscan (key, cursor, pattern);

List elements = scanResult.getResult ();

if (elements != null && elements.size () > 0) {

// 批量删除

redis.srem (key, elements);

}

// 获取新的游标

cursor = scanResult.getStringCursor ();

// 如果游标为0表示遍历结束

if ("0".equals (cursor)) {

break;

}

}

三、小功能大用处

1、慢查询

慢查询的两个配置参数

Redis 使用一个内存列表记录查询时间超过阀值的命令。

slowlog-log-slower-than

slowlog-log-slower-than超时阀值,它的单位是微秒 (1 秒 = 1000 毫秒 = 1000000 微秒),默认值是 10000 ,假如执行了一条“很慢” 的命令(例如keys*),如果它的执行时间超过了 10000 微秒,那么它将被记录在慢查询日志中。slowlog-log-slower-than配置建议: 默认值超过 10 毫秒判定为慢查询,需要根据 Redis 并发量调整该值。由于 Redis 采用单线程响应命令,对于高流量的场景,如果命令执行时间在 1 毫秒以上,那么 Redis 最多可支撑 OPS 不到 1000。因此对于高 OPS 场景的 Redis 建议设置为 1 毫秒。- 如果

slowlog-log-slower-than=0会记录所有的命令,slowlog-log-slower-than<0对于任何命令都不会进行记录。

slowlog-max-len

slowlog-max-len就是列表的最大长度。一个新的命令满足慢查询条件时被插入到这个列表中,当慢查询日志列表已处于其最大长度时,最早插入的一个命令将从列表中移出。slowlog-max-len配置建议: 线上建议调大慢查询列表,记录慢查询时 Redis 会对长命令做截断操作,并不会占用大量内存。增大慢查询列表可以减缓慢查询被剔除的可能,例如线上可设置为 1000 以上。

配置

在 Redis 中有两种修改配置的方法,一种是修改配置文件,另一种是使用 config set 命令动态修改。

# 将slowlog-log-slower-than设置为20000微秒,slowlog-max-len设置为1000:

config set slowlog-log-slower-than 20000

config set slowlog-max-len 1000

config rewrite # 将配置持久化到本地配置文件

慢查询使用

实现对慢查询日志的访问和管理的命令

# 1、获取慢查询日志

slowlog get [n] # 参数 n 指定条数

127.0.0.1:6379> slowlog get

1) 1) (integer) 666 # 慢查询日志的标识 id

2) (integer) 1456786500 # 发生时间戳

3) (integer) 11615 # 命令耗时

4) 1) "BGREWRITEAOF" # 执行命令和参数

2) 1) (integer) 665

2) (integer) 1456718400

3) (integer) 12006

4) 1) "SETEX"

2) "video_info_200"

3) "300"

4) "2"

...

# 2、获取慢查询日志列表当前的长度

slowlog len

127.0.0.1:6379> slowlog len

(integer) 45

# 3、慢查询日志重置(实际是对列表做清理操作)

slowlog reset

127.0.0.1:6379> slowlog len

(integer) 45

127.0.0.1:6379> slowlog reset

OK

127.0.0.1:6379> slowlog len

(integer) 0

慢查询注意事项

慢查询在实际使用过程中要注意以下几点:

- 慢查询只记录命令执行时间,并不包括命令排队和网络传输时间。因此客户端执行命令的时间会大于命令实际执行时间。因为命令执行排队机制,慢查询会导致其他命令级联阻塞,因此当客户端出现请求超时,需要检查该时间点是否有对应的慢查询,从而分析出是否为慢查询导致的命令级联阻塞。

- 由于慢查询日志是一个先进先出的队列,也就是说如果慢查询比较多的情况下,可能会丢失部分慢查询命令,为了防止这种情况发生,可以定期执行 slow get 命令将慢查询日志持久化到其他存储中 (例如 MySQL),然后可以制作可视化界面进行查询。

2、Pipeline

Pipeline 概念

Redis 客户端执行一条命令分为如下四个过程:

① 发送命令

② 命令排队

③ 命令执行

④ 返回结果

其中 ①+④ 称为 Round Trip Time (RTT, 往返时间)。

- Redis 提供了批量操作命令 (例如 mget、mset 等),有效地节约 RTT。大部分命令是不支持批量操作的,例如要执行 n 次 hgetall 命令,并没有 mhgetall 命令存在,需要消耗 n 次 RTT。

- Pipeline(流水线) 机制能改善上面这类问题,它能将一组 Redis 命令进行组装,通过一次 RTT 传输给 Redis,再将这组 Redis 命令的执行结果按顺序返回给客户端。

原生批量命令与 Pipeline 对比

- 原生批量命令是一个命令对应多个 key,它是原子的,Pipeline 是非原子的。

- 原生批量命令是 Redis 服务端支持实现的,而 Pipeline 需要服务端和客户端的共同实现。

Pipeline 最佳实践

- 每次 Pipeline 组装的命令个数不能没有节制,否则一次组装 Pipeline 数据量过大,一方面会增加客户端的等待时间,另一方面会造成一定的网络阻塞,可以将一次包含大量命令的 Pipeline 拆分成多次较小的 Pipeline 来完成。

- Pipeline 只能操作一个 Redis 实例,但是即使在分布式 Redis 场景中,也可以作为批量操作的重要优化手段。

3、事务

为了保证多条命令组合的原子性,Redis 提供了简单的事务功能以及集成 Lua 脚本来解决这个问题。

Redis 提供了简单的事务功能,将一组需要一起执行的命令放到 multi 和 exec 两个命令之间。multi 命令代表事务开始,exec 命令代表事务结束,它们之间的命令是原子顺序执行的。

// 用户关注的例子

127.0.0.1:6379> multi

OK

127.0.0.1:6379> sadd user:a:follow user:b

QUEUED

127.0.0.1:6379> sadd user:b:fans user:a

QUEUED

127.0.0.1:6379> sismember user:a:follow user:b

(integer) 0

127.0.0.1:6379> exec

1) (integer) 1

2) (integer) 1

127.0.0.1:6379> sismember user:a:follow user:b

(integer) 1

127.0.0.1:6379> discard

OK

127.0.0.1:6379> sismember user:a:follow user:b

(integer) 0

127.0.0.1:6379> multi

OK

127.0.0.1:6379> sadd user:a:follow user:b

QUEUED

127.0.0.1:6379> zadd user:b:fans 1 user:a

QUEUED

127.0.0.1:6379> exec

1) (integer) 1

2) (error) WRONGTYPE Operation against a key holding the wrong kind of value 127.0.0.1:6379> sismember user:a:follow user:b

(integer) 1

#T1:客户端1

127.0.0.1:6379> set key "java"

OK

#T2:客户端1

127.0.0.1:6379> watch key

OK

#T3:客户端1

127.0.0.1:6379> multi

OK

#T4:客户端2

127.0.0.1:6379> append key python

(integer) 11

#T5:客户端1

127.0.0.1:6379> append key jedis

QUEUED

#T6:客户端1

127.0.0.1:6379> exec

(nil)

#T7:客户端1

127.0.0.1:6379> get key

"javapython"

- sadd 命令此时的返回结果是 QUEUED,代表命令并没有真正执行,而是暂时保存在 Redis 中。只有当 exec 执行后,用户 A 关注用户 B 的行为才算完成。

- 如果要停止事务的执行,可以使用 discard 命令代替 exec 命令即可。

- 如果事务中的命令出现错误,Redis 的处理机制也不尽相同:

- 命令错误:

- 运行时错误:Redis 并不支持回滚功能,sadd user🅰️follow user:b 命令已经执行成功,开发人员需要自己修复这类问题。

- 有些应用场景需要在事务之前,确保事务中的 key 没有被其他客户端修改过,才执行事务,否则不执行 (类似乐观锁)。Redis 提供了 watch 命令来解决这类问题。

4、Lua

Lua 用法概述

Redis 将 Lua 作为脚本语言可帮助开发者定制自己的 Redis 命令,在这之前,必须修改源码。

1)数据类型及其逻辑处理

Lua 语言提供了如下几种数据类型: booleans(布尔)、numbers(数值)、strings(字符串)、tables(表格),和许多高级语言相比,相对简单。

1、字符串

-- local代表val是一个局部变量,如果没有local代表是全局变量。 print函数可以打印出变量的值

local strings val = "world";

-- 结果是"world"

print (hello)

2、数组

local tables myArray = {"redis", "jedis", true, 88.0}

-- true

print (myArray[3])

①for

local int sum = 0

for i = 1, 100

do

sum = sum + i

end

-- 输出结果为5050

print (sum)

for i = 1, #myArray

do

print (myArray [i])

end

for index,value in ipairs (myArray)

do

print (index)

print (value)

end

②while

local int sum = 0

local int i = 0

while i <= 100

do

sum = sum +i

i = i + 1

end

--输出结果为5050

print (sum)

③if else

local tables myArray = {"redis", "jedis", true, 88 .0}

for i = 1, #myArray

do

if myArray [i] == "jedis"

then

print ("true")

break

else

--do nothing

end

end

3、哈希

local tables user_1 = {age = 28, name = "tome"}

--user_1 age is 28

print ("user_1 age is " . . user_1 ["age"])

for key,value in pairs (user_1)

do print (key . . value)

end

- “–” 是 Lua 语言的注释。

- 在 Lua 中,如果要使用类似数组的功能,可以用 tables 类型。但和大多数编程语言不同的是,Lua 的数组下标从 1 开始计算。

- 关键字 for 以 end 作为结束符。

- 要遍历 myArray,首先需要知道 tables 的长度,只需要在变量前加一个 #号即可。

- 除此之外,Lua 还提供了内置函数 ipairs,使用 for index,value ipairs(tables) 可以遍历出所有的索引下标和值。

- while 循环同样以 end 作为结束符。

- if 以 end 结尾,if 后紧跟 then。

- 如果要使用类似哈希的功能,同样可以使用 tables 类型。

- strings 1…string2 是将两个字符串进行连接。

2)函数定义

在 Lua 中,函数以 function 开头,以 end 结尾,funcName 是函数名,中间部分是函数体。

function funcName ()

. . .

end

// contact函数将两个字符串拼接:

function contact (str1, str2)

return str1 . . str2

end

--"hello world"

print (contact ("hello ", "world"))

在 Redis 中使用 Lua

在 Redis 中执行 Lua 脚本有两种方法:eval 和 evalsha。

1)eval

# eval 脚本内容 key个数 key列表 参数列表

# 此时KEYS[1]="redis",ARGV[1]="world",所以最终的返回结果是"hello redisworld"。

127.0.0.1:6379> eval 'return "hello " . . KEYS [1] . . ARGV [1] ' 1 redis world

"hello redisworld"

2)evalsha

# ①加载脚本:script load命令可以将脚本内容加载到Redis内存中:

# 将lua_get.lua加载到Redis中,得到SHA1

# redis-cli script load "$ (cat lua_get.lua)"

"7413dc2440db1fea7c0a0bde841fa68eefaf149c"

# ②执行脚本:evalsha 的使用方法如下,参数使用SHA1值,执行逻辑和eval一致。

# evalsha 脚本SHA1值 key个数 key列表 参数列表

127.0.0.1 :6379> evalsha 7413dc2440db1fea7c0a0bde841fa68eefaf149c 1 redis world

"hello redisworld"

- 如果 Lua 脚本较长,还可以使用 redis-cli–eval 直接执行文件。

- eval 命令和–eval 参数本质是一样的,客户端如果想执行 Lua 脚本,首先在客户端编写好 Lua 脚本代码,然后把脚本作为字符串发送给服务端,服务端会将执行结果返回给客户端。

- evalsha 命令来执行 Lua 脚本:首先要将 Lua 脚本加载到 Redis 服务端,得到该脚本的 SHA1 校验和,evalsha 命令使用 SHA1 作为参数可以直接执行对应 Lua 脚本,避免每次发送 Lua 脚本的开销。这样客户端就不需要每次执行脚本内容,而脚本也会常驻在服务端,脚本功能得到了复用。

Lua 的 Redis API

Lua 可以使用 redis.call 函数实现对 Redis 的访问。

redis.call ("set", "hello", "world")

redis.call ("get", "hello")

# 放在Redis 的执行效果如下:

127.0.0.1 :6379> eval 'return redis.call ("get", KEYS [1]) ' 1 hello

"world"

- Lua 还可以使用 redis.pcall 函数实现对 Redis 的调用,redis.call 和 redis.pcall 的不同在于,如果 redis.call 执行失败,那么脚本执行结束会直接返回错误,而 redis.pcall 会忽略错误继续执行脚本。

- Lua 可以使用 redis.log 函数将 Lua 脚本的日志输出到 Redis 的日志文件中,但是一定要控制日志级别。

15、Lua 脚本功能为 Redis 开发和运维人员带来如下三个好处:

- Lua 脚本在 Redis 中是原子执行的,执行过程中间不会插入其他命令。

- Lua 脚本可以帮助开发和运维人员创造出自己定制的命令,并可以将这些命令常驻在 Redis 内存中,实现复用的效果。

- Lua 脚本可以将多条命令一次性打包,有效地减少网络开销。

Redis 如何管理 Lua 脚本

Redis 提供了 4 个命令实现对 Lua 脚本的管理:

# 1、script load 命令用于将 Lua 脚本加载到 Redis 内存中。

script load script

# 2、script exists 命令用于判断 sha1 是否已经加载到 Redis 内存中。

scripts exists sha1 [sha1 … ]

# 返回结果代表 sha1[sha 1 …] 被加载到 Redis 内存的个数。

127.0.0.1:6379> script exists a5260dd66ce02462c5b5231c727b3f7772c0bcc5

1) (integer) 1

# 3、script flush 命令用于清除 Redis 内存已经加载的所有 Lua 脚本。

127.0.0.1:6379> script exists a5260dd66ce02462c5b5231c727b3f7772c0bcc5

1) (integer) 1

127.0.0.1:6379> script flush

OK

127.0.0.1:6379> script exists a5260dd66ce02462c5b5231c727b3f7772c0bcc5

1) (integer) 0

# 4、script kill 命令用于杀掉正在执行的 Lua 脚本。如果 Lua 脚本比较耗时,甚至 Lua 脚本存在问题,那么此时 Lua 脚本的执行会阻塞 Redis,直到脚本执行完毕或者外部进行干预将其结束。

127.0.0.1:6379> eval 'while 1==1 do end ' 0 // 死循环,当前客户端会阻塞

127.0.0.1:6379> get hello

(error) BUSY Redis is busy running a script . You can only call SCRIPT KILL or

SHUTDOWN NOSAVE

127.0.0.1:6379> script kill

OK

127.0.0.1:6379> get hello

"world"

- Redis 提供了一个 lua-time-limit 参数,默认是 5 秒,它是 Lua 脚本的 “超时时间”,但这个超时时间仅仅是当 Lua 脚本时间超过 lua-time-limit 后,向其他命令调用发送 BUSY 的信号,但是并不会停止掉服务端和客户端的脚本执行,所以当达到 lua-time-limit 值之后,其他客户端在执行正常的命令时,将会收到“Busy Redis is busy running a script” 错误,并且提示使用 script kill 或者 shutdown nosave 命令来杀掉这个 busy 的脚本。

- 当 script kill 执行之后,客户端调用会恢复。

- 注意:如果当前 Lua 脚本正在执行写操作,那么 script kill 将不会生效。

5、Bitmaps

Bitmaps 数据结构模型

Bitmaps 本身不是一种数据结构,实际上它就是字符串,但是它可以对字符串的位进行操作。

Bitmaps 单独提供了一套命令,所以在 Redis 中使用 Bitmaps 和使用字符串的方法不太相同。可以把 Bitmaps 想象成一个以位为单位的数组,数组的每个单元只能存储 0 和 1,数组的下标在 Bitmaps 中叫做偏移量。

Bitmaps 命令

假设将每个独立用户是否访问过网站存放在 Bitmaps 中,将访问的用户记做 1,没有访问的用户记做 0,用偏移量作为用户的 id。

直接将用户 id 和 Bitmaps 的偏移量对应势必会造成一定的浪费,通常的做法是每次做 setbit 操作时将用户 id 减去这个指定数字。在第一次初始化 Bitmaps 时,假如偏移量非常大,那么整个初始化过程执行会比较慢,可能会造成 Redis 的阻塞 (由于要申请大量内存)。

# 1、设置值 : setbit key offset value

# 将第0、5、11位用户设置为1

127.0.0.1:6379> setbit unique:users:2016-04-05 0 1

(integer) 0

127.0.0.1:6379> setbit unique:users:2016-04-05 5 1

(integer) 0

127.0.0.1:6379> setbit unique:users:2016-04-05 11 1

(integer) 0

127.0.0.1:6379> setbit unique:users:2016-04-05 15 1

(integer) 0

127.0.0.1:6379> setbit unique:users:2016-04-05 19 1

(integer) 0

# 2、获取值 : getbit key offset

127.0.0.1:6379> getbit unique:users:2016-04-05 8

(integer) 0

127.0.0.1:6379> getbit unique:users:2016-04-05 5

(integer) 1

# 3、获取Bitmaps指定范围值为1的个数 : bitcount [start] [end]

# bitcount 的 [start] 和[end]代表起始和结束字节数。

127.0.0.1:6379> bitcount unique:users:2016-04-05

(integer) 5

# 计算用户id在第1个字节到第3个字节之间的独立访问用户数,对应的用户id是11,15,19

127.0.0.1:6379> bitcount unique:users:2016-04-05 1 3

(integer) 3

# 4、Bitmaps间的运算 : bitop op destkey key [key . . . .]

# bitop 是一个复合操作,它可以做多个 Bitmaps 的 and(交集)、or(并集)、not(非)、xor(异或) 操作并将结果保存在 destkey 中。

127.0.0.1:6379> bitop and unique:users:and:2016-04-04_03 unique:users:2016-04- unique:users:2016-04-03

(integer) 2

127.0.0.1:6379> bitcount unique:users:and:2016-04-04_03

(integer) 2

# 5、计算Bitmaps中第一个值为targetBit的偏移量 : bitpos key targetBit [start] [end]

# bitops 有两个选项 [start] 和[end],分别代表起始字节和结束字节。

# 计算2016-04-04当前访问网站的最小用户id:

127.0.0.1:6379> bitpos unique:users:2016-04-04 1

(integer) 1

# 计算第0个字节到第1个字节之间,第一个值为0的偏移量

127.0.0.1:6379> bitpos unique:users:2016-04-04 0 0 1

(integer) 0 # id=0的用户

Bitmaps 分析

当用户量很少的时候,对比用 set,用 Bitmaps 会占用更大的内存。因为 set 是随着用户量一个一个增长内存的,而 Bitmaps 是根据 id 的,因此一开始就是这么大的内存,此时使用 Bitmaps 也不太合适,因为大部分位都是 0。

6、HyperLogLog

- HyperLogLog 并不是一种新的数据结构 (实际类型为字符串类型),而是一种基数算法,通过 HyperLogLog 可以利用极小的内存空间完成独立总数的统计,数据集可以是 IP、Email、ID 等。

- HyperLogLog 内存占用量非常小,但是存在错误率,开发者在进行数据结构选型时只需要确认如下两条即可:

- 只为了计算独立总数,不需要获取单条数据。

- 可以容忍一定误差率,毕竟 HyperLogLog 在内存的占用量上有很大的优势。

- HyperLogLog 提供了 3 个命令:pfadd、pfcount、pfmerge。

# 1、添加 : pfadd key element [element … ]

# pfadd 用于向 HyperLogLog 添加元素,如果添加成功返回 1。

127.0.0.1:6379> pfadd 2016_03_06:unique:ids "uuid-1" "uuid-2" "uuid-3" "uuid-4"

(integer) 1

# 2、计算独立用户个数 : pfcount key [key … ]

# pfcount 用于计算一个或多个 HyperLogLog 的独立基数。

127.0.0.1:6379> pfcount 2016_03_06:unique:ids

(integer) 4

127.0.0.1:6379> pfadd 2016_03_06:unique:ids "uuid-1" "uuid-2" "uuid-3" "uuid-90"

(integer) 1

127.0.0.1:6379> pfcount 2016_03_06:unique:ids

(integer) 5 # 新增uuid-90

# HyperLogLog 内存占用量小得惊人,但是用如此小空间来估算如此巨大的数据,必然不是 100% 的正确,其中一定存在误差率。Redis 官方给出的数字是 0.81% 的失误率。

# 向HyperLogLog插入100万个id,插入前记录一下info memory:

127.0.0.1:6379> info memory

# Memory

used_memory:835144

used_memory_human:815.57K

# . . .向2016_05_01:unique:ids插入100万个用户,每次插入1000条:

elements=""

key="2016_05_01:unique:ids"

for i in `seq 1 1000000`

do

elements="${elements} uuid-"${i}

if [ [ $ ( (i%1000)) == 0 ]];

then

redis-cli pfadd ${key} ${elements}

elements=""

fi

done

127.0.0.1:6379> info memory

# Memory

used_memory :850616

used_memory_human :830.68K # 内存只增加了15K左右.

127.0.0.1:6379> pfcount 2016_05_01:unique:ids # pfcount的执行结果并不是100万

(integer) 1009838

# 如果使用集合,内存使用约84MB,但独立用户数为100万。

# 3、合并 : pfmerge destkey sourcekey [sourcekey . . .]

# pfmerge 可以求出多个 HyperLogLog 的并集并赋值给 destkey。

7、发布订阅

Redis 提供了基于 “发布 / 订阅” 模式的消息机制,此种模式下,消息发布者和订阅者不进行直接通信,发布者客户端向指定的频道(channel)发布消息,订阅该频道的每个客户端都可以收到该消息。

发布订阅的使用场景: 聊天室、公告牌、服务之间利用消息解耦都可以使用发布订阅模式。

Redis 主要提供了发布消息、订阅频道、取消订阅以及按照模式订阅和取消订阅等命令。

1、发布消息

publish channel message

# 向channel:sports频道发布一条消息“Tim won the championship”

# publish channel 返回结果为订阅者个数.

127.0.0.1:6379> publish channel:sports "Tim won the championship"

(integer) 0

2、订阅消息

- 订阅者可以订阅一个或多个频道.

- 有关订阅命令有两点需要注意:

- 客户端在执行订阅命令之后进入了订阅状态,只能接收 subscribe、psubscribe、unsubscribe、punsubscribe 的四个命令。

- 新开启的订阅客户端,无法收到该频道之前的消息,因为 Redis 不会对发布的消息进行持久化。

subscribe channel [channel . . .]

# (一客户端A)

127.0.0.1:6379> subscribe channel:sports

Reading messages . . . (press Ctrl-C to quit)

1) "subscribe"

2) "channel:sports"

3) (integer) 1

# (另一客户端B)

127.0.0.1:6379> publish channel:sports "James lost the championship"

(integer) 1

# (一客户端A)

127.0.0.1:6379> subscribe channel:sports

Reading messages . . . (press Ctrl-C to quit)

. . .

1) "message"

2) "channel:sports"

3) "James lost the championship"

3、取消订阅

客户端可以通过 unsubscribe 命令取消对指定频道的订阅,取消成功后,不会再收到该频道的发布消息。

unsubscribe [channel [channel . . .]]

127.0.0.1:6379> unsubscribe channel:sports

1) "unsubscribe"

2) "channel:sports"

3) (integer) 0

4、按照模式订阅和取消订阅

psubscribe pattern [pattern . . .]

punsubscribe [pattern [pattern . . .]]

127.0.0.1:6379> psubscribe it* // 订阅以it开头的所有频道

Reading messages . . . (press Ctrl-C to quit)

1) "psubscribe"

2) "it*"

3) (integer) 1

5、查询订阅

# ①查看活跃的频道

pubsub channels [pattern]

127.0.0.1:6379> pubsub channels

1) "channel:sports"

2) "channel:it"

3) "channel:travel"

127.0.0.1 :6379> pubsub channels channel:*r*

1) "channel:sports"

2) "channel:travel"

# ②查看频道订阅数

pubsub numsub [channel . . .]

127.0.0.1:6379> pubsub numsub channel:sports

1) "channel:sports"

2) (integer) 2

# ③查看模式订阅数

pubsub numpat

127.0.0.1:6379> pubsub numpat

(integer) 1 # 当前只有一个客户端通过模式来订阅

- 和很多专业的消息队列系统(例如 Kafka、RocketMQ)相比,Redis 的发布订阅略显粗糙,例如无法实现消息堆积和回溯。但胜在足够简单,如果当前场景可以容忍的这些缺点,也不失为一个不错的选择。

- 除了 subcribe 和 unsubscribe 命令,Redis 命令还支持 glob 风格的订阅命令 psubscribe 和取消订阅命令 punsubscribe。

- 所谓活跃的频道是指当前频道至少有一个订阅者,其中 [pattern] 是可以指定具体的模式。

8、GEO

Redis3.2 版本提供了 GEO(地理信息定位)功能,支持存储地理位置信息用来实现诸如附近位置、摇一摇这类依赖于地理位置信息的功能。

1、增加地理位置信息

# longitude、latitude、member 分别是该地理位置的经度、纬度、成员.

geoadd key longitude latitude member [longitude latitude member . . .]

127.0.0.1:6379> geoadd cities:locations 116.28 39.55 beijing

(integer) 1

# 如果需要更新地理位置信息,仍然可以使用 geoadd 命令,虽然返回结果为 0.

127.0.0.1:6379> geoadd cities:locations 116.28 39.55 beijing

(integer) 0

# geoadd 返回结果代表添加成功的个数,如果 cities:locations 没有包含 tianjin,那么返回结果为 1,如果已经存在则返回 0.

127.0.0.1:6379> geoadd cities:locations 117.12 39.08 tianjin 114.29 38.02 shijiazhuang 118.01 39.38 tangshan 115.29 38.51 baoding

(integer) 4

2、获取地理位置信息

geopos key member [member . . .]

127.0.0.1:6379> geopos cities:locations tianjin

1) 1) "117.12000042200088501"

2) "39.0800000535766543"

3、获取两个地理位置的距离

geodist 的参数 unit 代表返回结果的单位,包含以下四种:

- m(meters)代表米。

- km(kilometers)代表公里。

- mi(miles)代表英里。

- ft(feet)代表尺。

geodist key member1 member2 [unit]

127.0.0.1:6379> geodist cities:locations tianjin beijing km

"89.2061"

4、获取指定位置范围内的地理信息位置集合

- georadius 和 georadiusbymember 两个命令的作用是一样的,都是以一个地理位置为中心算出指定半径内的其他地理信息位置,不同的是 georadius 命令的中心位置给出了具体的经纬度,georadiusbymember 只需给出成员即可。

- georadius 的 radiusm|km|ft|mi 是必需参数,指定了半径(带单位),这两个命令有很多 可选参数,如下:

- withcoord:返回结果中包含经纬度。

- withdist:返回结果中包含离中心节点位置的距离。

- withhash:返回结果中包含 geohash。

- COUNT count:指定返回结果的数量。

- asc|desc:返回结果按照离中心节点的距离做升序或者降序。

- store key:将返回结果的地理位置信息保存到指定键。

- storedist key:将返回结果离中心节点的距离保存到指定键。

georadius key longitude latitude radiusm |km |ft |mi [withcoord] [withdist] [withhash] [COUNT count] [asc |desc] [store key] [storedist key]

georadiusbymember key member radiusm |km |ft |mi [withcoord] [withdist]

[withhash] [COUNT count] [asc |desc] [store key] [storedist key]

# 计算五座城市中,距离北京150公里以内的城市

127.0.0.1:6379> georadiusbymember cities:locations beijing 150 km

1) "beijing"

2) "tianjin"

3) "tangshan"

4) "baoding"

5、获取 geohash

- Redis 使用 geohash 将二维经纬度转换为一维字符串.

- geohash 有如下特点:

- GEO 的数据类型为 zset,Redis 将所有地理位置信息的 geohash 存放在 zset 中。

- 字符串越长,表示的位置更精确。下表给出了字符串长度对应的精度,例如 geohash 长度为 9 时,精度在 2 米左右。

- 两个字符串越相似,它们之间的距离越近,Redis 利用字符串前缀匹配算法实现相关的命令。

- geohash 编码和经纬度是可以相互转换的。、

- Redis 正是使用有序集合并结合 geohash 的特性实现了 GEO 的若干命令。

geohash key member [member . . .]

127.0.0.1:6379> geohash cities:locations beijing

1) "wx4ww02w070"

127.0.0.1:6379> type cities:locations

zset

geohash 长度与精度对应关系表

| geohash 长度 | 精确度 (km) |

|---|---|

| 1 | 2500 |

| 2 | 630 |

| 3 | 78 |

| 4 | 20 |

| 5 | 2.4 |

| 6 | 0.61 |

| 7 | 0.076 |

| 8 | 0.019 |

| 9 | 0.002 |

6、删除地理位置信息

GEO 没有提供删除成员的命令,但是因为 GEO 的底层实现是 zset,所以可以借用 zrem 命令实现对地理位置信息的删除。

zrem key member

四、客户端

1、客户端通信协议

- 客户端与服务端之间的通信协议是在 TCP 协议之上构建的。

- Redis 制定了 RESP(REdis Serialization Protocol,Redis 序列化协议)实现客户端与服务端的正常交互,这种协议简单高效,既能够被机器解析,又容易被人类识别。

// 客户端发送一条set hello world命令给服务端,按照RESP的标准,客户端需要将其封装为如下格式(每行用\r\n分隔) :

*3

$3

SET

$5

hello

$5

world

实际传输格式为如下代码:

*3\r\n$3\r\nSET\r\n$5\r\nhello\r\n$5\r\nworld\r\n

// 这样Redis服务端能够按照RESP将其解析为set hello world命令,执行后回复的格式如下:

+OK

下面对命令的一些格式进行说明:

1、发送命令格式

RESP的规定一条命令的格式如下,CRLF代表"\r\n"。

*<参数数量> CRLF

$<参数1的字节数量> CRLF

<参数1> CRLF

. . .

$<参数N的字节数量> CRLF

<参数N> CRLF

2、返回结果格式

Redis的返回结果类型分为以下五种:

· 状态回复: 在RESP中第一个字节为"+"。例如set。

· 错误回复: 在RESP中第一个字节为"-"。例如错误命令。

· 整数回复: 在RESP中第一个字节为":"。例如incr。

· 字符串回复: 在RESP中第一个字节为"$"。例如get。

· 多条字符串回复: 在RESP中第一个字节为"*"。例如mget。

redis-cli.c源码对命令结果的解析结构如下:

static sds cliFormatReplyTTY (redisReply *r, char *prefix) {

sds out = sdsempty ();

switch (r->type) {

case REDIS_REPLY_ERROR :

// 处理错误回复

case REDIS REPLY STATUS :

// 处理状态回复

case REDIS_REPLY_INTEGER :

// 处理整数回复

case REDIS_REPLY_STRING :

// 处理字符串回复

case REDIS_REPLY_NIL :

// 处理空

case REDIS_REPLY_ARRAY :

// 处理多条字符串回复

return out;

}

为了看到 Redis 服务端返回的 “真正” 结果,可以使用 nc 命令、telnet 命令、甚至写一个 socket 程序进行模拟。

以nc命令进行演示,首先使用 nc 127.0.0.1 6379连接到Redis:

nc 127.0.0.1 6379

状态回复:set hello world的返回结果为+OK:

set hello world

+OK

错误回复:由于sethx这条命令不存在,那么返回结果就是"-"号加上错误消息:

sethx

-ERR unknown command 'sethx '

整数回复:当命令的执行结果是整数时,返回结果就是整数回复:

incr counter

:1

字符串回复:当命令的执行结果是字符串时,返回结果就是字符串回复:

get hello

$5

world

多条字符串回复: 当命令的执行结果是多条字符串时,返回结果就是多条字符串回复:

mset java jedis python redis-py

+OK

mget java python

*2

$5

jedis

$8

redis-py

注意,无论是字符串回复还是多条字符串回复,如果有nil值,那么会返回$- 1。

get not_exist_key

$-1

如果批量操作中包含一条为nil值的结果,那么返回结果如下:

mget hello not_exist_key java

*3

$5

world

$-1

$5

jedis

有了 RESP 提供的发送命令和返回结果的协议格式,各种编程语言就可以利用其来实现相应的 Redis 客户端。

2、SpringBoot 整合 Redis

Spring Boot Data(数据) Redis 中提供了 RedisTemplate 和 StringRedisTemplate,其中 StringRedisTemplate 是 RedisTemplate 的子类,两个方法基本一致,不同之处主要体现在操作的数据类型不同,RedisTemplate 中的两个泛型都是 Object,意味着存储的 key 和 value 都可以是一个对象,而 StringRedisTemplate 的两个泛型都是 String,意味着 StringRedisTemplate 的 key 和 value 都只能是字符串。

1)环境准备

引入依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

配置 applicaiton.properties

spring.redis.host=localhost

spring.redis.port=6379

spring.redis.database=0

2)使用 Template

5 种数据结构的操作

(String)redisTemplate.opsForValue(); //操做字符串

(String)redisTemplate.opsForHash(); //操做hash

(String)redisTemplate.opsForList(); //操做list

(String)redisTemplate.opsForSet(); //操做set

(String)redisTemplate.opsForZSet(); //操做有序set

@Autowired

private StringRedisTemplate stringRedisTemplate; //对字符串支持比较友好,不能存储对象

@Autowired

private RedisTemplate redisTemplate; //存储对象

//key相关的操作

@Test

public void test(){

Set<String> keys = stringRedisTemplate.keys("*"); //查看所有key

Boolean name = stringRedisTemplate.hasKey("name"); //判断某个key是否存在

stringRedisTemplate.delete("age"); //根据指定key删除

stringRedisTemplate.rename("",""); //修改key的名称

stringRedisTemplate.expire("key",10, TimeUnit.HOURS);

//设置key超时时间 参数1:设置key名 参数2:时间 参数3:时间的单位

stringRedisTemplate.move("",1);//移动key

}

//String相关的操作 opsForValue

@Test

public void testString(){

stringRedisTemplate.opsForValue().set("name","小陈");

String s = stringRedisTemplate.opsForValue().get("name");

System.out.println(s);

stringRedisTemplate.opsForValue().set("code","235952", 60, TimeUnit.SECOUNDS);

stringRedisTemplate.opsForValue().append("name", "他是个好人");

Long size = stringRedisTemplate.opsForValue().size("name");

System.out.println(size);

}

//list相关的操作opsForList

@Test

public void testList(){

stringRedisTemplate.opsForList().leftPush("lists","张三");

stringRedisTemplate.opsForList().leftPushAll("lists","小陈","李四","王五");

List<String> lists = new ArrayList<>();

lists.add("小1");

lists.add("小2");

stringRedisTemplate.opsForList().leftPushAll("lists", lists);

List<String> lists = stringRedisTemplate.opsForList().range("lists", 0, -1);

lists.forEach(key -> System.out.println(key));

}

//set相关操作 opsForSet

@Test

public void testSet(){

stringRedisTemplate.opsForSet().add("sets","xiaosan","xiaosi","xiaowu");

Set<String> sets = stringRedisTemplate.opsForSet().members("sets");

sets.forEach(value-> System.out.println(value));

Long size = stringRedisTemplate.opsForSet().size("sets");

System.out.println("size="+size);

}

//zset相关操作 opsForZSet

@Test

public void testZSet(){

stringRedisTemplate.opsForZSet().add("zsets","小黑",10);

Set<String> zsets = stringRedisTemplate.opsForZSet().range("zsets", 0, -1);

zsets.forEach(value-> System.out.println(value));

Set<ZSetOperations.TypedTyple<String>> zsets1 = stringRedisTemplate.opsForZSet().rangeByScoreWithScores("zsets", 0, 1000); //获取指定元素以及分数

zsets1.forEach(typeTuple ->{

System.out.println(typedTuple.getValue());

System.out.println(typedTuple.getScore());

})

}

//hash相关操作 opsForHash

@Test

public void testHash(){

stringRedisTemplate.opsForHash().put("maps","name","小黑");

Object o = stringRedisTemplate.opsForHash().get("maps", "name");

System.out.println(o);

Map<String, String> map = new HashMap<String, String>();

map.put("age", "12");

map.put("bir", "2012-12-12");

stringRedisTemplate.opsForHash().putAll("maps", map);

List<Object> values = stringRedisTemplate.opsForHash().multiGet("maps", Arrays.asList("name", "age"));

values.forEach(value -> System.out.println(value));

String value = (String) stringRedisTemplate.opsForHash().get("maps", "name");

List<Object> vals = stringRedisTemplate.opsForHash().values("maps");

Set<Object> keys = stringRedisTemplate.opsForHash().keys("maps");

}

@Test

public void testRedisTemplate(){

// 修改key序列化方案

redisTemplate.setKeySerializer(new StringRedisSerializer());

// 修改hash key序列化方案

redisTemplate.setHashKeySerializer(new StringRedisSerializer());

User user = new User();

user.setId(UUID.randomUUID().toString().setName("xiaochen").setAge(23).setBir(new Date()));

redisTemplate.opsForValue().set("user",user);

User user1 = (User)redisTemplate.opsForValue().get("user");

System.out.println(user1);

redisTemplate.opsForList().leftPush("list", user);

redisTemplate.opsForSet().leftPush("set", user);

redisTemplate.opsForZSet().leftPush("zset", user, 10);

}

public class TestBoudAPI {

@Autowired

private RedisTemplate redisTemplate;

@Autowired

private StringRedisTemplate stringRedisTemplate;

public void testBound() {

redisTemplate.setKeySerializer(new StringRedisSerializer());

redisTemplate.setHashKeySerializer(new StringRedisSerializer());

// 对字符串类型key进行绑定,后续所有操作都是基于这个key进行的

BoundValueOperations<String, String> nameValueOperations = redisTemplate.boundValueOps(

"name"

);

nameValueOperations.set("zhagnsan");

nameValueOperations.append("是一个好人");

String name = nameValueOperations.get();

System.out.println(name);

// 对list set Zset hash等

BoundListOperations<String, String> listOperations = stringRedisTemplate.boundListOps(

"lists"

);

listOperations.leftPushAll("嗓散", "saw ", "we fww e");

List<String> lists = listOperations.range(0, -1);

lists.forEach(

list -> {

System.out.println(list);

}

);

}

}

3)小结

- 针对于日后处理 key value 都是 string 使用 stringRedisTemplate

- 针对于日后处理的 key value 存在对象,使用 RedisTemplate

- 针对于同一个 key 多次操作可以使用 boundxxxOps() Value List Set ZSet Hash 的 api

3、Python 客户端 redis-py

1)获取 redis-py。

redis-py 需要 Python2.7 以上版本。

如何获取安装 redis-py,方法有三种:

# 第一,使用pip进行安装:

pip install redis

# 第二,使用easy_install进行安装:

easy_install redis

# 第三,使用源码安装:

wget https://github.com/andymccurdy/redis-py/archive/2.10.5.zip

unzip redis-2.10.5.zip

cd redis-2.10.5

# 安装redis-py

python setup.py install

2)redis-py 的基本使用方法。

①导入依赖库:

import redis

②生成客户端连接:需要Redis的实例IP和端口两个参数:

client = redis.StrictRedis (host='127.0.0.1', port=6379)

③执行命令:redis-py的API保留了Redis API的原始风格:

# True

client.set (key, "python-redis")

# world

client.get (key)

import redis

client = redis.StrictRedis (host='127.0.0.1', port=6379)

key = "hello"

setResult = client.set (key, "python-redis")

print setResult

value = client.get (key)

print "key :" + key + ", value :" + value

3)redis-py 的 Pipeline 的使用。

①引入依赖,生成客户端连接:

import redis

client = redis.StrictRedis (host='127.0.0.1 ', port=6379)

②生成Pipeline:注意client.pipeline包含了一个参数,如果transaction=False代表不使用事务:

pipeline = client.pipeline (transaction=False)

③将命令封装到Pipeline中,此时命令并没有真正执行:

pipeline.set ("hello","world")

pipeline.incr ("counter")

④执行Pipeline:

# [True, 3]

result = pipeline.execute ()

4)redis-py 的 Lua 脚本使用。

redis-py 提供了三个重要的函数实现 Lua 脚本的执行:

eval (String script, int keyCount, String . . . params)

script_load (String script)

evalsha (String sha1, int keyCount, String . . . params)

import redis

client = redis.StrictRedis (host='127.0.0.1', port=6379)

script = "return redis.call ('get', KEYS [1])"

#输出结果为world

print client.eval (script,1,"hello")

script_load和evalsha 函数要一起使用,首先使用script_load将脚本加载到Redis中:

import redis

client = redis.StrictRedis (host='127.0.0.1', port=6379)

script = "return redis.call ('get ',KEYS [1])"

scriptSha = client.script_load (script)

print client.evalsha (scriptSha, 1, "hello");

- eval 函数有三个参数,分别是:

- script:Lua 脚本内容。

- keyCount:键的个数。

- params:相关参数 KEYS 和 ARGV。

- evalsha 函数用来执行脚本的哈希值,它需要三个参数:

- scriptSha:脚本的 SHA1。

- keyCount:键的个数。

- params:相关参数 KEYS 和 ARGV。

4、客户端 API

1)client list 命令能列出与 Redis 服务端相连的所有客户端连接信息。

// 在一个Redis实例上执行client list的结果:

127.0.0.1:6379> client list

id=254487 addr=10.2.xx.234:60240 fd=1311 name= age=8888581 idle=8888581 flags=N

db=0 sub=0 psub=0 multi=-1 qbuf=0 qbuf-free=0 obl=0 oll=0 omem=0 events=r cm

id=300210 addr=10.2.xx.215:61972 fd=3342 name= age=8054103 idle=8054103 flags=N

sub=0 psub=0 multi=-1 qbuf=0 qbuf-free=0 obl=0 oll=0 omem=0 events=r cm

...

127.0.0.1:6390> info memory

...

maxmemory_human:4.00G.

...

127.0.0.1:6390> info clients

···

connected clients:1414 // 当前Redis的连接数

client_longest_output_list:4869 // client_longest_output_list代表输出缓冲区列表最大对象数

client_biggest_input_buf:2097152

···

输出缓冲区对应的配置规则是:

client-output-buffer-limit <class> <hard limit> <soft limit> <soft seconds>

<class>:客户端类型,分为三种。a)normal:普通客户端;b)slave:slave客户端,用于复制;c)pubsub:发布订阅客户端。

<hard limit>:如果客户端使用的输出缓冲区大于<hard limit>,客户端会被立即关闭。

<soft limit>和<soft seconds>:如果客户端使用的输出缓冲区超过了<soft limit>并且持续了<soft limit>秒,客户端会被立即关闭。

Redis的默认配置是:

client-output-buffer-limit normal 0 0 0

client-output-buffer-limit slave 256mb 64mb 60

client-output-buffer-limit pubsub 32mb 8mb 60

通过过Redis源码中redis.h的redisClient结构体(Redis3.2版本变为Client)可以看到固定缓冲区和动态缓冲区的实现细节:

typedef struct redisClient {

// 动态缓冲区列表

list *reply;

// 动态缓冲区列表的长度 (对象个数)

unsigned long reply_bytes;

// 固定缓冲区已经使用的字节数

int bufpos;

// 字节数组作为固定缓冲区

char buf [REDIS_REPLY_CHUNK_BYTES];

} redisClient;

可以通过config set maxclients对最大客户端连接数进行动态设置:

127.0.0.1:6379> config get maxclients

1) "maxclients"

2) "10000"

127.0.0.1:6379> config set maxclients 50

OK

127.0.0.1:6379> config get maxclients

1) "maxclients"

2) "50"

#Redis默认的timeout是0,也就是不会检测客户端的空闲

127.0.0.1:6379> config set timeout 30

OK

- client list 输出结果的每一行代表一个客户端的信息,可以看到每行包含了十几个属性,它们是每个客户端的一些执行状态:

- 标识:id、addr、fd、name,这四个属性属于客户端的标识:

- id:客户端连接的唯一标识,这个 id 是随着 Redis 的连接自增的,重启 Redis 后会重置为 0。

- addr:客户端连接的 ip 和端口。

- fd:socket 的文件描述符,与 lsof 命令结果中的 fd 是同一个,如果 fd=-1 代表当前客户端不是外部客户端,而是 Redis 内部的伪装客户端。

- name:客户端的名字。

- 输入缓冲区:qbuf、qbuf-free

- Redis 为每个客户端分配了输入缓冲区,它的作用是将客户端发送的命令临时保存,同时 Redis 从会输入缓冲区拉取命令并执行,输入缓冲区为客户端发送命令到 Redis 执行命令提供了缓冲功能。client list 中 qbuf 和 qbuf-free 分别代表这个缓冲区的总容量和剩余容量。

- Redis 没有提供相应的配置来规定每个缓冲区的大小,输入缓冲区会根据输入内容大小的不同动态调整,只是要求每个客户端缓冲区的大小不能超过 1G,超过后客户端将被关闭。

- 输出缓冲区:obl、oll、omem

- Redis 为每个客户端分配了输出缓冲区,它的作用是保存命令执行的结果返回给客户端,为 Redis 和客户端交互返回结果提供缓冲。与输入缓冲区不同的是,输出缓冲区的容量可以通过参数 client-output-buffer-limit 来进行设置,并且输出缓冲区做得更加细致,按照客户端的不同分为三种:普通客户端、发布订阅客户端、slave 客户端。

- obl 代表固定缓冲区的长度,oll 代表动态缓冲区列表的长度,omem 代表使用的字节数。

- 客户端的存活状态:age 和 idle 分别代表当前客户端已经连接的时间和最近一次的空闲时间。当 age 等于 idle 时,说明连接一直处于空闲状态。

- 客户端的限制 maxclients 和 timeout

- Redis 提供了 maxclients 参数来限制最大客户端连接数,一旦连接数超过 maxclients,新的连接将被拒绝。maxclients 默认值是 10000,可以通过 info clients 来查询当前 Redis 的连接数。

- Redis 提供了 timeout(单位为秒)参数来限制连接的最大空闲时间,一旦客户端连接的 idle 时间超过了 timeout,连接将会被关闭。在实际开发和运维中,需要将 timeout 设置成大于 0,例如可以设置为 300 秒,同时在客户端使用上添加空闲检测和验证等等措施。

- flag 是用于标识当前客户端的类型,例如 flag=S 代表当前客户端是 slave 客户端、flag=N 代表当前是普通客户端,flag=O 代表当前客户端正在执行 monitor 命令。

- 其他参数

- db:当前客户端正在使用的数据库索引下标