Redis(基础+高级)(Docker下实现)

文章目录

01-Redis缓存入门

简介

背景

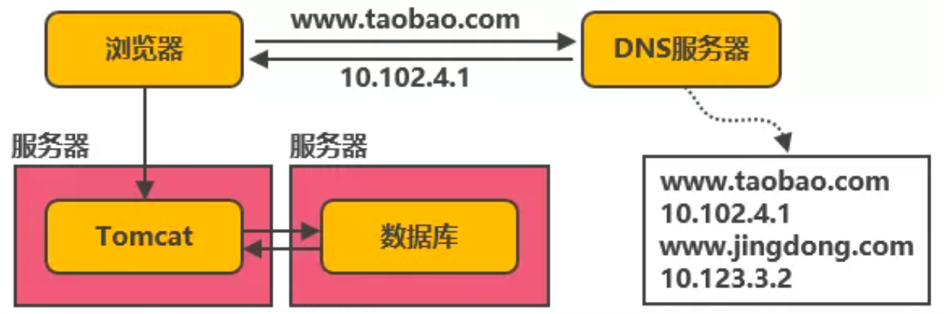

我们现在的项目架构中,基本上是Web服务器(Tomcat)和数据库独立部署,独占服务器资源,随着用户数的增长,并发读写数据库,会加大数据库访问压力,导致性能的下降,严重时直接导致系统宕机,例如:

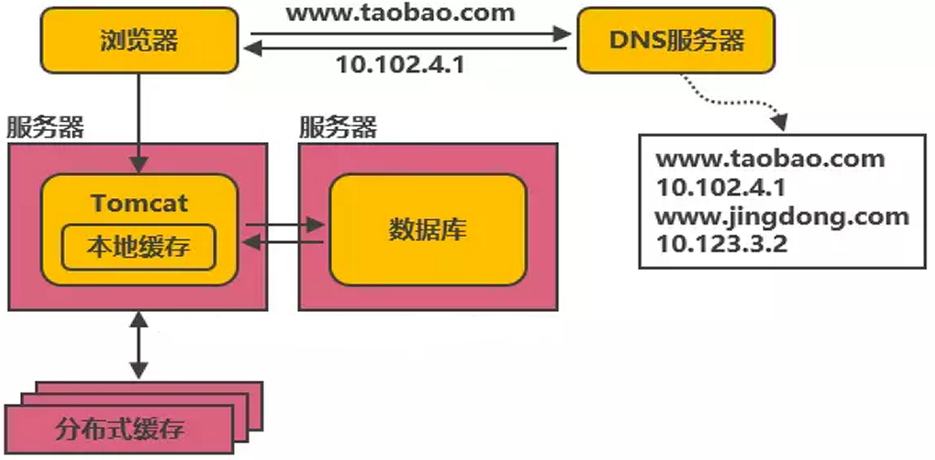

此时,我们可以在Tomcat同服务器上中增加本地缓存,并在外部增加分布式缓存,缓存热门数据。也就是通过缓存能把绝大多数请求在读写数据库前拦截掉,大大降低数据库压力。例如:

基于这样的一种架构设计,于是类似redis的一些分布式数据库就诞生了。

Redis 概述

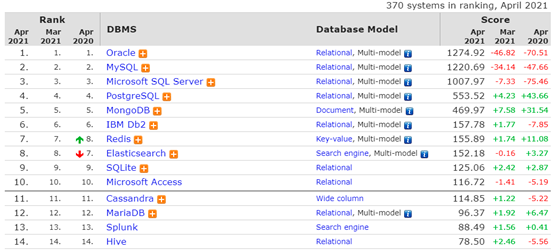

Redis(Remote Dictionary Server )即远程字典服务,是 C 语言开发的一个开源的key/value存储系统(官网:http://redis.io),是一个分布式缓存数据库。由于它是基于内存的所以它要比基于磁盘读写的数据库效率更快。在DB-Engines.com的数据库排行中, Redis上升排行第七,如图所示:

版本及参考说明

Redis的次版本号(第一个小数点后的数字)为偶数的版本是稳定版本(2.4、2.6等),奇数为非稳定版本(2.5、2.7),一般推荐在生产环境使用稳定版本。最新版本6.2.2,新增了stream的处理方式,性能更高。Redis官方是不支持windows平台的,windows版本是由微软自己建立的分支,基于官方的Redis源码上进行编译、发布、维护的,所以windows平台的Redis版本要略低于官方版本。

Redis 相关参考网址如下所示:

Bootnb 相关:https://www.runoob.com/redis/redis-tutorial.html

Redis 官网:https://redis.io/

源码地址:https://github.com/redis/redis

Redis 在线测试:http://try.redis.io/

Redis 命令参考:http://doc.redisfans.com/

Redis初始操作

安装步骤

第一步:下载镜像文件

docker pull redis

第二步:准备配置文件

创建redis配置文件目录

mkdir -p /usr/local/docker/redis01/conf

在配置文件录下创建redis.conf配置文件(这个文件一定要创建,否在我们进行目录挂载时默认生成的是一个目录)

touch /usr/local/docker/redis01/conf/redis.conf

第三步:创建redis实例并启动

sudo docker run -p 6379:6379 --name redis01 \

-v /usr/local/docker/redis01/data:/data \

-v /usr/local/docker/redis01/conf/redis.conf:/etc/redis/redis.conf \

-d redis redis-server /etc/redis/redis.conf

第四步:查看正在运行的进程

docker ps

访问redis服务器

第一步:控制台直接连接redis测试

docker exec -it redis01 bash

第二步:检测redis 版本

redis-server -v

或者

redis-cli -v

第三步:登录redis(默认不需要密码)

redis-cli

或者直接将上面的两个步骤合为一个步骤执行也可以,指令如下:

docker exec -it redis01 redis-cli

停止和启动redis服务

停止redis服务?

docker stop redis01

启动redis服务?

docker start redis01

重启 redis 服务?

docker restart redis01

启动redis服务

Docker 环境下的启动(docker环境启动多个需要运行多个容器):

docker start redis01 #底层也是通过redis-server启动,start单词后的redis01为容器名

docker 中查看redis 服务

docker ps

查看启动的redis进程信息

ps -ef|grep redis

root 3511 1 0 16:29 ? 00:00:01 redis-server *:6379

root 3515 1 0 16:29 ? 00:00:01 redis-server 127.0.0.1:6380

进入redis容器

docker exec -it redis01 bash #redis01 为容器名

登陆redis服务

登陆本地redis

redis-cli

或者

redis-cli -p 6379

或者

redis-cli -p 6379 -a password #-a后面为password,此操作需要开启redis.conf文件中的 requirepass选项

登陆远程redis

redis-cli -h ip -p 6379 -a password

查看redis信息

首先登陆redis,然后输入info指令,例如

127.0.0.1:6379> info #查看当前redis节点的详细配置信息

清空redis屏幕

清除redis屏幕内容

127.0.0.1:6379> clear

退出redis服务

退出redis服务,例如

127.0.0.1:6379> exit

关闭redis服务

关闭redis服务,例如:

127.0.0.1:6379> shutdown

系统帮助

可以基于help指令查看相关指令帮助,例如

127.0.0.1:6379> help

redis-cli 2.8.19

Type: "help @<group>" to get a list of commands in <group>

"help <command>" for help on <command>

"help <tab>" to get a list of possible help topics

"quit" to exit

127.0.0.1:6379> help type

TYPE key

summary: Determine the type stored at key

since: 1.0.0

group: generic

Redis数据存储操作

简易数据存取

基于查看redis中的key

127.0.0.1:6379> keys *

(empty list or set)

基于key/value形式存储数据

127.0.0.1:6379> set test1 123

OK

127.0.0.1:6379> set test2 ab

OK

127.0.0.1:6379> keys *

1) "test1"

2) "test2"

基于key获取redis中存储的数据

127.0.0.1:6379> get test1

"123"

127.0.0.1:6379> get test2

"ab"

127.0.0.1:6379> get test3

(nil)

127.0.0.1:6379>

清除redis中的数据

删除指定key对应的数据

127.0.0.1:6379> del test1 #test1为key的名字

OK

清除当前数据库数据

127.0.0.1:6379> flushdb

OK

清除所有数据库数据

127.0.0.1:6379> flushall

OK

Key有效时间设计

实际工作中我们经常要控制redis中key的有效时长,例如秒杀操作的计时,缓存数据的有效时长等。

Expire (设置生效时长-单位秒)

语法:EXPIRE key seconds

127.0.0.1:6379> set bomb tnt

OK

127.0.0.1:6379> expire bomb 10

(integer) 1

127.0.0.1:6379> ttl bomb

(integer) 5

127.0.0.1:6379> ttl bomb

(integer) 3

127.0.0.1:6379> ttl bomb

(integer) 3

127.0.0.1:6379> ttl bomb

(integer) 2

127.0.0.1:6379> ttl bomb

(integer) 1

127.0.0.1:6379> ttl bomb

(integer) -2

127.0.0.1:6379> ttl bomb

(integer) -2

127.0.0.1:6379>

其中,TTL查看key的剩余时间,当返回值为-2时,表示键被删除。

当 key 不存在时,返回 -2 。 当 key 存在但没有设置剩余生存时间时,返回 -1 。

Persist (取消时长设置)

通过persist让对特定key设置的生效时长失效。

语法:PERSIST key

127.0.0.1:6379> set bomb tnt

OK

127.0.0.1:6379> expire bomb 60

(integer) 1

127.0.0.1:6379> ttl bomb

(integer) 49

127.0.0.1:6379> persist bomb

(integer) 1

127.0.0.1:6379> ttl bomb

(integer) -1

127.0.0.1:6379>

其中,设置新的数据时需要重新设置该key的生存时间,重新设置值也会清除生存时间。

pexpire (单位毫秒)

pexpire 让key的生效时长以毫秒作为计量单位,这样可以做到更精确的时间控制。例如,可应用于秒杀场景。

语法:PEXPIRE key milliseconds

127.0.0.1:6379> set bomb tnt

OK

127.0.0.1:6379> pexpire bomb 10000

(integer) 1

127.0.0.1:6379> ttl bomb

(integer) 6

127.0.0.1:6379> ttl bomb

(integer) 3

127.0.0.1:6379> ttl bomb

(integer) -2

127.0.0.1:6379>

总结(Summary)

本章节主要是讲解了一下redis的一些入门操作,主要是一些需要记住的一些指令,强化练习即可。

02-Redis常用数据类型

简介

概述

Redis作为一种key/value结构的数据存储系统,为了便于对数据进行进行管理,提供了多种数据类型。然后,基于指定类型存储我们项目中产生的数据,例如用户的登陆信息,购物车信息,商品详情信息等等。

常用数据类型

Reids中基础数据结构包含字符串、散列,列表,集合,有序集合。工作中具体使用哪种类型要结合具体场景。

String类型操作实践

字符串类型是redis中最简单的数据类型,它存储的值可以是字符串,其最大字符串长度支持到512M。基于此类型,可以实现博客的字数统计,将日志不断追加到指定key,实现一个分布式自增iid,实现一个博客的的点赞操作等

incr/incrby

当存储的字符串是整数时,redis提供了一个实用的命令INCR,其作用是让当前键值递增,并返回递增后的值。

语法:INCR key

127.0.0.1:6379> set num 1

(integer) 1

127.0.0.1:6379> incr num

(integer) 2

127.0.0.1:6379> keys *

1) "num"

127.0.0.1:6379> incr num

127.0.0.1:6379>

说明,如果num不存在,则自动会创建,如果存在自动+1。

指定增长系数

语法:INCRBY key increment

127.0.0.1:6379> incrby num 2

(integer) 5

127.0.0.1:6379> incrby num 2

(integer) 7

127.0.0.1:6379> incrby num 2

(integer) 9

127.0.0.1:6379>

decr/decrby

减少指定的整数

DECR key 按照默认步长(默认为1)进行递减

DECRBY key decrement 按照指定步长进行递减

127.0.0.1:6379> incr num

(integer) 10

127.0.0.1:6379> decr num

(integer) 9

127.0.0.1:6379> decrby num 3

append

向尾部追加值。如果键不存在则创建该键,其值为写的value,即相当于SET key value。返回值是追加后字符串的总长度。

语法:APPEND key value

127.0.0.1:6379> keys *

1) "num"

2) "test1"

3) "test"

127.0.0.1:6379> get test

"123"

127.0.0.1:6379> append test "abc"

(integer) 6

127.0.0.1:6379> get test

"123abc"

127.0.0.1:6379>

strlen

字符串长度,返回数据的长度,如果键不存在则返回0。注意,如果键值为空串,返回也是0。

语法:STRLEN key

127.0.0.1:6379> get test

"123abc"

127.0.0.1:6379> strlen test

(integer) 6

127.0.0.1:6379> strlen tnt

(integer) 0

127.0.0.1:6379> set tnt ""

OK

127.0.0.1:6379> strlen tnt

(integer) 0

127.0.0.1:6379> exists tnt

(integer) 1

127.0.0.1:6379>

mset/mget

同时设置/获取多个键值

语法:MSET key value [key value …]

MGET key [key …]

127.0.0.1:6379> flushall

OK

127.0.0.1:6379> keys *

(empty list or set)

127.0.0.1:6379> mset a 1 b 2 c 3

OK

127.0.0.1:6379> mget a b c

1) "1"

2) "2"

3) "3"

127.0.0.1:6379>

小节面试分析

- 博客的字数统计如何实现?(strlen)

- 如何将审计日志不断追加到指定key?(append)

- 你如何实现一个分布式自增id?(incr-雪花算法)

- 如何实现一个博客的的点赞操作?(incr,decr)

Hash类型应用实践

Redis散列类型相当于Java中的HashMap,实现原理跟HashMap一致,一般用于存储对象信息,存储了字段(field)和字段值的映射,一个散列类型可以包含最多232-1个字段。

hset/hget/hgetall

语法结构

HSET key field value

HGET key field

HMSET key field value [field value…]

HMGET key field [field]

HGETALL key

HSET和HGET赋值和取值

127.0.0.1:6379> hset user username chenchen

(integer) 1

127.0.0.1:6379> hget user username

"chenchen"

127.0.0.1:6379> hset user username chen

(integer) 0

127.0.0.1:6379> keys user

1) "user"

127.0.0.1:6379> hgetall user

1) "username"

2) "chen"

127.0.0.1:6379>

127.0.0.1:6379> hset user age 18

(integer) 1

127.0.0.1:6379> hset user address "xi'an"

(integer) 1

127.0.0.1:6379> hgetall user

1) "username"

2) "chen"

3) "age"

4) "18"

3) "address"

4) "xi'an"

127.0.0.1:6379>

HSET命令不区分插入和更新操作,当执行插入操作时HSET命令返回1,当执行更新操作时返回0。

hincrby

127.0.0.1:6379> hdecrby article total 1 #执行会出错

127.0.0.1:6379> hincrby article total -1 #没有hdecrby自减命令

(integer) 1

127.0.0.1:6379> hget article total #获取值

hmset/hmget

HMSET和HMGET设置和获取对象属性

127.0.0.1:6379> hmset person username tony age 18

OK

127.0.0.1:6379> hmget person age username

1) "18"

2) "tony"

127.0.0.1:6379> hgetall person

1) "username"

2) "tony"

3) "age"

4) "18"

127.0.0.1:6379>

注意:上面HMGET字段顺序可以自行定义

hexists

属性是否存在

127.0.0.1:6379> hexists killer

(error) ERR wrong number of arguments for 'hexists' command

127.0.0.1:6379> hexists killer a

(integer) 0

127.0.0.1:6379> hexists user username

(integer) 1

127.0.0.1:6379> hexists person age

(integer) 1

127.0.0.1:6379>

hdel

删除属性

127.0.0.1:6379> hdel user age

(integer) 1

127.0.0.1:6379> hgetall user

1) "username"

2) "chen"

127.0.0.1:6379> hgetall person

1) "username"

2) "tony"

3) "age"

4) "18"

127.0.0.1:6379>

hkeys/hvals

只获取字段名HKEYS或字段值HVALS

127.0.0.1:6379> hkeys person

1) "username"

2) "age"

127.0.0.1:6379> hvals person

1) "tony"

2) "18"

2.3.8 hlen

元素个数

127.0.0.1:6379> hlen user

(integer) 1

127.0.0.1:6379> hlen person

(integer) 2

127.0.0.1:6379>

小节面试分析

- 发布一篇博客需要写内存吗?(需要,hmset)

- 浏览博客内容会怎么做?(hmget)

- 如何判定一篇博客是否存在?(hexists)

- 删除一篇博客如何实现?(hdel)

- 分布式系统中你登录成功以后是如何存储用户信息的?(hmset)

List类型应用实践

Redis的list类型相当于java中的LinkedList,其原理就就是一个双向链表。支持正向、反向查找和遍历等操作,插入删除速度比较快。经常用于实现热销榜,最新评论等的设计。

lpush

在key对应list的头部添加字符串元素

redis 127.0.0.1:6379> lpush mylist "world"

(integer) 1

redis 127.0.0.1:6379> lpush mylist "hello"

(integer) 2

redis 127.0.0.1:6379> lrange mylist 0 -1

1) "hello"

2) "world"

redis 127.0.0.1:6379>

其中,Redis Lrange 返回列表中指定区间内的元素,区间以偏移量 START 和 END 指定。 其中 0 表示列表的第一个元素, 1 表示列表的第二个元素,以此类推。 你也可以使用负数下标,以 -1 表示列表的最后一个元素, -2 表示列表的倒数第二个元素,以此类推

rpush

在key对应list的尾部添加字符串元素

redis 127.0.0.1:6379> rpush mylist2 "hello"

(integer) 1

redis 127.0.0.1:6379> rpush mylist2 "world"

(integer) 2

redis 127.0.0.1:6379> lrange mylist2 0 -1

1) "hello"

2) "world"

redis 127.0.0.1:6379>

del

清空集合元素,例如

redis 127.0.0.1:6379> del mylist

linsert

在key对应list的特定位置之前或之后添加字符串元素

redis 127.0.0.1:6379> rpush mylist3 "hello"

(integer) 1

redis 127.0.0.1:6379> rpush mylist3 "world"

(integer) 2

redis 127.0.0.1:6379> linsert mylist3 before "world" "there"

(integer) 3

redis 127.0.0.1:6379> lrange mylist3 0 -1

1) "hello"

2) "there"

3) "world"

redis 127.0.0.1:6379>

lset

设置list中指定下标的元素值(一般用于修改操作)

redis 127.0.0.1:6379> rpush mylist4 "one"

(integer) 1

redis 127.0.0.1:6379> rpush mylist4 "two"

(integer) 2

redis 127.0.0.1:6379> rpush mylist4 "three"

(integer) 3

redis 127.0.0.1:6379> lset mylist4 0 "four"

OK

redis 127.0.0.1:6379> lset mylist4 -2 "five"

OK

redis 127.0.0.1:6379> lrange mylist4 0 -1

1) "four"

2) "five"

3) "three"

redis 127.0.0.1:6379>

lrem

从key对应list中删除count个和value相同的元素,count>0时,按从头到尾的顺序删除

redis 127.0.0.1:6379> rpush mylist5 "hello"

(integer) 1

redis 127.0.0.1:6379> rpush mylist5 "hello"

(integer) 2

redis 127.0.0.1:6379> rpush mylist5 "foo"

(integer) 3

redis 127.0.0.1:6379> rpush mylist5 "hello"

(integer) 4

redis 127.0.0.1:6379> lrem mylist5 2 "hello"

(integer) 2

redis 127.0.0.1:6379> lrange mylist5 0 -1

1) "foo"

2) "hello"

redis 127.0.0.1:6379>

count<0时,按从尾到头的顺序删除

redis 127.0.0.1:6379> rpush mylist6 "hello"

(integer) 1

redis 127.0.0.1:6379> rpush mylist6 "hello"

(integer) 2

redis 127.0.0.1:6379> rpush mylist6 "foo"

(integer) 3

redis 127.0.0.1:6379> rpush mylist6 "hello"

(integer) 4

redis 127.0.0.1:6379> lrem mylist6 -2 "hello"

(integer) 2

redis 127.0.0.1:6379> lrange mylist6 0 -1

1) "hello"

2) "foo"

redis 127.0.0.1:6379>

count=0时,删除全部

redis 127.0.0.1:6379> rpush mylist7 "hello"

(integer) 1

redis 127.0.0.1:6379> rpush mylist7 "hello"

(integer) 2

redis 127.0.0.1:6379> rpush mylist7 "foo"

(integer) 3

redis 127.0.0.1:6379> rpush mylist7 "hello"

(integer) 4

redis 127.0.0.1:6379> lrem mylist7 0 "hello"

(integer) 3

redis 127.0.0.1:6379> lrange mylist7 0 -1

1) "foo"

redis 127.0.0.1:6379>

ltrim

保留指定key 的值范围内的数据

redis 127.0.0.1:6379> rpush mylist8 "one"

(integer) 1

redis 127.0.0.1:6379> rpush mylist8 "two"

(integer) 2

redis 127.0.0.1:6379> rpush mylist8 "three"

(integer) 3

redis 127.0.0.1:6379> rpush mylist8 "four"

(integer) 4

redis 127.0.0.1:6379> ltrim mylist8 1 -1

OK

redis 127.0.0.1:6379> lrange mylist8 0 -1

1) "two"

2) "three"

3) "four"

redis 127.0.0.1:6379>

lpop

从list的头部删除元素,并返回删除元素

redis 127.0.0.1:6379> lrange mylist 0 -1

1) "hello"

2) "world"

redis 127.0.0.1:6379> lpop mylist

"hello"

redis 127.0.0.1:6379> lrange mylist 0 -1

1) "world"

redis 127.0.0.1:6379>

rpop

从list的尾部删除元素,并返回删除元素:

redis 127.0.0.1:6379> lrange mylist2 0 -1

1) "hello"

2) "world"

redis 127.0.0.1:6379> rpop mylist2

"world"

redis 127.0.0.1:6379> lrange mylist2 0 -1

1) "hello"

redis 127.0.0.1:6379>

llen

返回key对应list的长度:

redis 127.0.0.1:6379> llen mylist5

(integer) 2

redis 127.0.0.1:6379>

lindex

返回名称为key的list中index位置的元素:

redis 127.0.0.1:6379> lrange mylist5 0 -1

1) "three"

2) "foo"

redis 127.0.0.1:6379> lindex mylist5 0

"three"

redis 127.0.0.1:6379> lindex mylist5 1

"foo"

redis 127.0.0.1:6379>

rpoplpush

从第一个list的尾部移除元素并添加到第二个list的头部,最后返回被移除的元素值,整个操作是原子的.如果第一个list是空或者不存在返回nil:

rpoplpush lst1 lst1

rpoplpush lst1 lst2

小节面试分析

- 如何基于redis实现一个队列结构?(lpush/rpop)

- 如何基于redis实现一个栈结构?(lpush/lpop)

- 如何基于redis实现一个阻塞式队列?(lpush/brpop)

- 如何实现秒杀活动的公平性?(先进先出-FIFO)

- 通过list结构实现一个消息队列(顺序)吗?(可以,FIFO->lpush,rpop)

- 用户注册时的邮件发送功能如何提高其效率?(邮件发送是要调用三方服务,底层通过队列优化其效率,队列一般是list结构)

- 如何动态更新商品的销量列表?(卖的好的排名靠前一些,linsert)

- 商家的粉丝列表使用什么结构实现呢?(list结构)

Set类型应用实践

Redis的Set类似Java中的HashSet,是string类型的无序集合。集合成员是唯一的,这就意味着集合中不能出现重复的数据。Redis中Set集合是通过哈希表实现的,所以添加,删除,查找的复杂度都是O(1)。

sadd

添加元素,重复元素添加失败,返回0

127.0.0.1:6379> sadd name tony

(integer) 1

127.0.0.1:6379> sadd name hellen

(integer) 1

127.0.0.1:6379> sadd name rose

(integer) 1

127.0.0.1:6379> sadd name rose

(integer) 0

smembers

获取集合中成员,例如

127.0.0.1:6379> smembers name

- “hellen”

- “rose”

- “tony”

spop

移除并返回集合中的一个随机元素

127.0.0.1:6379> smembers internet

1) "amoeba"

2) "redis"

3) "rabbitmq"

4) "nginx"

127.0.0.1:6379> spop internet

"rabbitmq"

127.0.0.1:6379> spop internet

"nginx"

127.0.0.1:6379> smembers internet

1) "amoeba"

2) "redis"

scard

获取集合中的成员个数

127.0.0.1:6379> scard name

(integer) 3

smove

移动一个元素到另外一个集合

127.0.0.1:6379> sadd internet amoeba nginx redis

(integer) 3

127.0.0.1:6379> sadd bigdata hadopp spark rabbitmq

(integer) 3

127.0.0.1:6379> smembers internet

1) "amoeba"

2) "redis"

3) "nginx"

127.0.0.1:6379> smembers bigdata

1) "hadopp"

2) "spark"

3) "rabbitmq"

127.0.0.1:6379> smove bigdata internet rabbitmq

(integer) 1

127.0.0.1:6379> smembers internet

1) "amoeba"

2) "redis"

3) "rabbitmq"

4) "nginx"

127.0.0.1:6379> smembers bigdata

1) "hadopp"

2) "spark"

127.0.0.1:6379>

sunion

实现集合的并集操作

127.0.0.1:6379> sunion internet bigdata

1) "redis"

2) "nginx"

3) "rabbitmq"

4) "amoeba"

5) "hadopp"

6) "spark"

小节面试分析

- 朋友圈的点赞功能你如何实现?(sadd,srem,smembers,scard)

- 如何实现一个网站投票统计程序?

- 你知道微博中的关注如何实现吗?

总结(Summary)

本章节主要是对redis中的常用数据类型存储结构,基本操作进行了分析和实践,结合指令特性理解其应用场景,

03-Java中操作redis实践

Redis 客户端

概述

Redis 是一种C/S 架构的分布式缓存数据库,它有自带的命令行客户端,也有对应的Java或其它语言客户端,可以在这些客户端中通过一些API对redis进行读写操作。

准备工作

第一步:创建工程。

创建maven父工程,例如03-redis,并在此工程下创建两个子工程,一个为redis-jedis,一个为redis-template,例如:

第二步:添加父工程依赖

修改父工程pom.xml文件,添加编译配置

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.8.1</version>

<configuration>

<source>8</source>

<target>8</target>

</configuration>

</plugin>

</plugins>

</build>

Jedis的基本应用

简介

Jedis是Java中操作redis的一个客户端,类似通过jdbc访问mysql数据库。

准备工作

在redis-jedis 工程添加如下依赖

<dependencies>

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

<version>3.5.2</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

<scope>test</scope>

</dependency>

<dependency>

<groupId>com.google.code.gson</groupId>

<artifactId>gson</artifactId>

<version>2.8.6</version>

</dependency>

</dependencies>

Jeids基本应用实践

在Jedis工程中的src/test/java目录创建单元测类,例如:

package com.jt;

import org.junit.Test;

import redis.clients.jedis.Jedis;

import java.util.concurrent.TimeUnit;

public class JedisTests {

/**

* 测试是否可以连通redis。

*/

@Test

public void testGetConnection(){

Jedis jedis=new Jedis("192.168.126.129",6379);

String result = jedis.ping();

System.out.println(result);

}

/**

* 测试字符串操作

*/

@Test

public void testStringOper01(){

//1.建立连接

Jedis jedis=new Jedis("192.168.126.129",6379);

//2.执行redis数据操作(增删改查)

//2.1新增数据

jedis.set("id", "100");

jedis.set("name", "tony");

//2.2修改数据

jedis.incr("id");

jedis.incrBy("id", 100);//201

jedis.set("name", "Mike");//Mike

//2.3查询数据

String id = jedis.get("id");

String name = jedis.get("name");

System.out.println("id="+id+";name="+name);

//2.4删除数据

jedis.del("name");

//3.释放资源

jedis.close();

}

/**

* 测试字符串操作

*/

@Test

public void testStringOper02(){

//1.建立连接

Jedis jedis=new Jedis("192.168.126.129",6379);

//2.数据操作(将一个map对象转换为json字符串,然后写入到redis)

//2.1构建map对象

Map<String,String> map=new HashMap<>();

map.put("id", "100");

map.put("name", "Mike");

//2.2将map转换为字符串

Gson gson=new Gson();

String jsonStr = gson.toJson(map);

//2.3将字符串写入到redis

String key= UUID.randomUUID().toString();

jedis.set(key, jsonStr);

//3.释放资源

jedis.close();

}

/**

* 课堂练习:

* 基于hash类型将testStringOper02中对象写入到redis,

* 并且尝试进行查询,修改,删除等操作。

*/

@Test

public void testHash01(){

//1.建立连接

Jedis jedis=new Jedis("192.168.126.129",6379);

//2.执行hash数据操作

//2.1新增数据

String key= UUID.randomUUID().toString();

jedis.hset(key, "id", "500");

jedis.hset(key, "name", "Jack");

//2.2修改数据数据

jedis.hset(key, "name", "Jim");

//2.3查询数据

Map<String, String> map = jedis.hgetAll(key);

System.out.println(map);

//2.4删除数据

//jedis.del(key);

jedis.expire(key, 10);

//3.释放资源

jedis.close();

}

/**

* 测试:redis中list结构的应用

* 基于FIFO(First In First Out)算法,借助redis实现一个队列

*/

@Test

public void testListOper01(){

//1.建立连接

Jedis jedis=new Jedis("192.168.126.130",6379);

//2.存储数据

jedis.lpush("lst1","A","B","C","C");

//3.更新数据

Long pos=jedis.lpos("lst1","A");//获取A元素的位置

jedis.lset("lst1",pos,"D");//将A元素位置的内容修改为D

//4.获取数据

int len=jedis.llen("lst1").intValue();//获取lst1列表中元素个数

List<String> rpop = jedis.rpop("lst1",len);//获取lst1列表中所有元素

System.out.println(rpop);

//5.释放资源

jedis.close();

}

//list类型练习:实现一个阻塞式队列

@Test

public void testListOper02(){

//1.连接redis

Jedis jedis=new Jedis("192.168.126.128",6379);

//2.向队列存数据

//jedis.lpush("list1","A","B","C");

//3.按先进先出的顺序从队列取数据

List<String> list= jedis.brpop(40,"list1");

System.out.println(list);

jedis.brpop(40,"list1");

jedis.brpop(40,"list1");

jedis.brpop(40,"list1");

//4.释放资源

jedis.close();

}

//set类型练习

@Test

public void testSetOper01() {

//1.连接redis

Jedis jedis = new Jedis("192.168.126.128", 6379);

//2.朋友圈点赞

jedis.sadd("count", "1", "1", "2");

//3.取出点赞数

Set<String> set = jedis.smembers("count");

System.out.println(set);

//4.释放资源

jedis.close();

}

}

连接池JedisPool连接池应用

我们直接基于Jedis访问redis时,每次获取连接,释放连接会带来很大的性能开销,可以借助Jedis连接池,重用创建好的连接,来提高其性能,简易应用方式如下:

package com.jt;

import org.junit.Test;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import redis.clients.jedis.JedisPoolConfig;

public class JedisPoolTests {

@Test

public void testJedisPool(){

//定义连接池的配置

JedisPoolConfig config=new JedisPoolConfig();

config.setMaxTotal(1000);//最大连接数

config.setMaxIdle(60);//最大空闲数

//创建连接池

JedisPool jedisPool=

new JedisPool(config,"192.168.126.130",6379);

//从池中获取一个连接

Jedis resource = jedisPool.getResource();

resource.auth("123456");

//通过jedis连接存取数据

resource.set("class","cgb2004");

String clazz=resource.get("class");

System.out.println(clazz);

//将链接返回池中

resource.close();

//关闭连接池

jedisPool.close();

}

}

我们可以基于池对象,设计一个数据源,将来在业务中通过一个数据源对象,从池中获取连接,不用每次获取连接都要创建池对象,例如:

package com.jt.redis;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import redis.clients.jedis.JedisPoolConfig;

public class JedisDataSource {

private static final String IP="192.168.126.128";

private static final int PORT=6379;//redis.conf 默认端口

/**

* volatile 关键通常用于修饰属性:

* 1)保证线程其可见性(一个线程改了,其它CPU线程立刻可见)

* 2)禁止指令重排序

* 3)不能保证其原子性(不保证线程安全)

*/

private static volatile JedisPool jedisPool;

//方案1:饿汉式池对象的创建

/*static{

JedisPoolConfig config=new JedisPoolConfig();

config.setMaxTotal(16);

config.setMaxIdle(8);

jedisPool=new JedisPool(config,IP,PORT);

}

public static Jedis getConnection(){

return jedisPool.getResource();

}*/

//方案2:懒汉式池对象的创建

public static Jedis getConnection(){

if(jedisPool==null) {

synchronized (JedisDataSource.class) {

if (jedisPool == null) {

JedisPoolConfig config = new JedisPoolConfig();

config.setMaxTotal(16);

config.setMaxIdle(8);

jedisPool = new JedisPool(config, IP, PORT);

//创建对象分析

//1.开辟内存空间

//2.执行属性的默认初始化

//3.执行构造方法

//4.将创建的对象的内存地址赋值给jedisPool变量

//假如使用了volatile修饰jedisPool变量,可以保证如上几个步骤是顺序执行的

}

}

}

return jedisPool.getResource();

}

public static void close(){

jedisPool.close();

}

}

RedisTemplate基本应用

简介

RedisTemplate为SpringBoot工程中操作redis数据库的一个Java对象,此对象封装了对redis的一些基本操作。

准备工作

第一步:添加在redis-template工程添加依赖

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>2.3.2.RELEASE</version>

<scope>import</scope>

<type>pom</type>

</dependency>

</dependencies>

</dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

第二步:创建工程配置文件application.yml,其内容如下:

spring:

redis:

host: 192.168.126.129 #写自己的ip

port: 6379

第三步:创建工程启动类,例如:

package com.jt;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

@SpringBootApplication

public class RedisApplication {

public static void main(String[] args) {

SpringApplication.run(RedisApplication.class,args);

}

}

RedisTemplate对象应用实践

RedisTemplate是一个专门用于实现对远端redis数据进行操作的对象,默认会采用JDK序列化方式存取数据,应用案例如下:

package com.jt.redis;

@SpringBootTest

public class RedisTemplateTests {

/**

* 此对象为操作redis的一个模板对象,基于此对象进行数据存储时,

* 数据会进行序列化,序列化方式默认为JDK自带的序列化机制。

*/

@Autowired

private RedisTemplate redisTemplate;

/**测试是否能够连通redis*/

@Test

void testGetConnection(){

RedisConnection connection =

redisTemplate.getConnectionFactory()

.getConnection();

String result = connection.ping();

System.out.println(result);

}

@Test

void testStringOper01(){

//1.获取字符串操作对象(ValueOperations)

ValueOperations vo = redisTemplate.opsForValue();

//2.操作redis数据

vo.set("x", 100);

Object x = vo.get("x");

System.out.println(x);

//vo.increment("x");//不可以

Long y = vo.increment("y");

y=vo.increment("y");

//Object y = vo.get("y");//不可以

System.out.println(y);

//存储key/value,设置key的有效期

vo.set("z", "100", Duration.ofSeconds(10));

}

@Test

void testStringOper02(){

//1.获取字符串操作对象(ValueOperations)

ValueOperations vo = redisTemplate.opsForValue();

//2.按默认序列化方式存储数据

String token= UUID.randomUUID().toString();

vo.set(token,"admin");

//3.指定序列方式进行数据存储

redisTemplate.setKeySerializer(RedisSerializer.string());

redisTemplate.setValueSerializer(RedisSerializer.string());

vo.set(token,"Mike");

//4.更新数据(假如有对应的key则直接进行覆盖)

vo.set(token, "Jack");

Object value = vo.get(token);

System.out.println(value);

//5.删除数据(存数据时给定有效期-生产环境必须设置)

vo.set("permissions", "sys:res:update",Duration.ofSeconds(5));

}

@Test

void testHashOper01(){

//1.获取Hash操作对象(ValueOperations)

HashOperations ho = redisTemplate.opsForHash();

//2.以hash类型存储数据

ho.put("blog","id",100);

ho.put("blog", "title", "redis....");

//3.获取数据

Object id = ho.get("blog", "id");

Object title = ho.get("blog", "title");

System.out.println("id="+id+";title="+title);

Map blog = ho.entries("blog");//取key对应的所有值。

System.out.println(blog);

}

/**

* 设计一个Blog类,然后通过redisTemplate将此类的对象写入到redis数据库

* 两种方案:

* 1)方案1:基于ValueOperations对象实现数据存取

* 2)方案2:基于HashOperations对象实现数据存储

*/

@Test

void testHashOper02() throws JsonProcessingException {

//1.获取数据操作对象(ValueOperations,HashOperations)

ValueOperations vo = redisTemplate.opsForValue();

HashOperations ho = redisTemplate.opsForHash();

//2.基于ValueOperations存取Blog对象

Blog blog=new Blog();

blog.setId(100L);

blog.setTitle("redis ...");

vo.set("blog-jack", blog);//序列化

Object o = vo.get("blog-jack");//反序列化

System.out.println(o);

//3.基于HashOperations存取Blog对象

ObjectMapper objectMapper=new ObjectMapper();//jackson

String jsonStr=objectMapper.writeValueAsString(blog);

Map map = objectMapper.readValue(jsonStr, Map.class);

ho.putAll("blog-mike", map);

ho.put("blog-mike","id","200");

map=ho.entries("blog-mike");

System.out.println(map);

}

@Test

void testListOper(){

//向list集合放数据

ListOperations listOperations = redisTemplate.opsForList();

listOperations.leftPush("lstKey1", "100"); //lpush

listOperations.leftPushAll("lstKey1", "200","300");

listOperations.leftPush("lstKey1", "100", "105");

listOperations.rightPush("lstKey1", "700");

Object value= listOperations.range("lstKey1", 0, -1);

System.out.println(value);

//从list集合取数据

Object v1=listOperations.leftPop("lstKey1");//lpop

System.out.println("left.pop.0="+v1);

value= listOperations.range("lstKey1", 0, -1);

System.out.println(value);

}

@Test

void testSetOper(){

SetOperations setOperations=redisTemplate.opsForSet();

setOperations.add("setKey1", "A","B","C","C");

Object members=setOperations.members("setKey1");

System.out.println("setKeys="+members);

//........

}

@Test

void testFlushdb(){

redisTemplate.execute(new RedisCallback() {

@Override

public Object doInRedis(RedisConnection redisConnection) throws DataAccessException {

//redisConnection.flushDb();

redisConnection.flushAll();

return "flush ok";

}

});

}

@Test

void testGetConnection(){

RedisConnection connection =

stringRedisTemplate.getConnectionFactory()

.getConnection();

String ping = connection.ping();

System.out.println(ping);

}

}

创建Blog对象,然后基于RedisTemplate进行序列化实践,Blog代码如下

package com.jt.redis.pojo;

import java.io.Serializable;

public class Blog implements Serializable {//{"id":10,"title":"redis"}

private static final long serialVersionUID = -6721670401642138021L;

private Integer id;

private String title;

public Blog(){

System.out.println("Blog()");

}

public Blog(Integer id,String title){

this.id=id;

this.title=title;

}

public Integer getId() {

return id;

}

public void setId(Integer id) {

this.id = id;

}

public String getTitle() {

return title;

}

public void setTitle(String title) {

this.title = title;

}

@Override

public String toString() {

return "Blog{" +

"id=" + id +

", title='" + title + '\'' +

'}';

}

}

在RedisTemplateTests类中添加如下单元测试方法,进行测试,例如:

@Test

void testJsonOper() throws JsonProcessingException {

ValueOperations valueOperations = redisTemplate.opsForValue();

Blog blog=new Blog(10,"study redis");

valueOperations.set("blog",blog);//序列化

blog=(Blog)valueOperations.get("blog");//反序列化

System.out.println("blog="+blog);

}

StringRedisTemplate 对象应用实践

StringRedisTemplate 是一个特殊的RedisTemplate对象,默认基于字符串序列化方式存取数据,其应用方式如下:

package com.jt.redis;

import com.fasterxml.jackson.core.JsonProcessingException;

import com.fasterxml.jackson.databind.ObjectMapper;

import org.junit.jupiter.api.Test;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import org.springframework.data.redis.connection.RedisConnection;

import org.springframework.data.redis.core.HashOperations;

import org.springframework.data.redis.core.StringRedisTemplate;

import org.springframework.data.redis.core.ValueOperations;

import java.util.HashMap;

import java.util.List;

import java.util.Map;

import java.util.concurrent.TimeUnit;

@SpringBootTest

public class StringRedisTemplateTests {

/**

* 此对象为操作redis的一个客户端对象,这个对象

* 对key/value采用了字符串的序列化(StringRedisSerializer)

* 方式进行,redis数据的读写操作.

*/

@Autowired

private StringRedisTemplate stringRedisTemplate;

@Test

void testHashOper01(){

//1.获取hash操作的对象

HashOperations<String, Object, Object> vo =stringRedisTemplate.opsForHash();

//2.读写redis数据

//2.1存储一个对象

vo.put("user", "id", "100");

vo.put("user", "username", "tony");

vo.put("user", "status", "1");

//2.2获取一个对象

//2.2.1获取对象某个属性值

Object status =vo.get("user","status");

System.out.println(status);

//2.2.2获取对象某个key对应的所有值

List<Object> user = vo.values("user");

System.out.println(user);

}

@Test

void testStringOper02() throws JsonProcessingException {

//1.获取字符串操作对象(ValueOperations)

ValueOperations<String, String> vo =

stringRedisTemplate.opsForValue();

//2.读写redis中的数据

Map<String,String> map=new HashMap<>();

map.put("id","100");

map.put("title","StringRedisTemplate");

//将map对象转换为json字符串写到redis数据库

String jsonStr=//jackson (spring-boot-starter-web依赖中自带)

new ObjectMapper().writeValueAsString(map);

vo.set("blog", jsonStr);

jsonStr=vo.get("blog");

System.out.println(jsonStr);

//将json字符串转换为map对象

map=

new ObjectMapper().readValue(jsonStr, Map.class);

System.out.println(map);

}

@Test

void testStringOper01(){

//1.获取字符串操作对象(ValueOperations)

ValueOperations<String, String> vo =

stringRedisTemplate.opsForValue();

//2.读写redis中的数据

vo.set("x", "100");

vo.increment("x");

vo.set("y", "200", 1, TimeUnit.SECONDS);

String x = vo.get("x");

String y = vo.get("y");

System.out.println("x="+x+",y="+y);

}

}

基于业务定制RedisTemplate对象(拓展)

我们知道系统中的RedisTemplate默认采用的是JDK的序列化机制,假如我们不希望使用默认的JDK方式序列化,可以对RedisTemplate对象进行定制,指定自己的序列化方式,例如:

package com.jt;

import com.fasterxml.jackson.annotation.JsonAutoDetect;

import com.fasterxml.jackson.annotation.JsonInclude;

import com.fasterxml.jackson.annotation.JsonTypeInfo;

import com.fasterxml.jackson.annotation.PropertyAccessor;

import com.fasterxml.jackson.databind.ObjectMapper;

import org.springframework.boot.autoconfigure.condition.ConditionalOnMissingBean;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.data.redis.connection.RedisConnectionFactory;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.data.redis.serializer.GenericJackson2JsonRedisSerializer;

import org.springframework.data.redis.serializer.Jackson2JsonRedisSerializer;

import org.springframework.data.redis.serializer.RedisSerializer;

import java.net.UnknownHostException;

@Configuration

public class RedisConfig {//RedisAutoConfiguration

//自定义json序列化

public RedisSerializer jsonSerializer(){

//1.定义Redis序列化,反序列化规范对象(此对象底层通过ObjectMapper完成对象序列化和反序列化)

Jackson2JsonRedisSerializer serializer=

new Jackson2JsonRedisSerializer(Object.class);

//2.创建ObjectMapper(有jackson api库提供)对象,基于此对象进行序列化和反序列化

//2.1创建ObjectMapper对象

ObjectMapper objectMapper=new ObjectMapper();

//2.2设置按哪些方法规则进行序列化

objectMapper.setVisibility(PropertyAccessor.GETTER,//get方法

JsonAutoDetect.Visibility.ANY);//Any 表示任意方法访问修饰符

//对象属性值为null时,不进行序列化存储

objectMapper.setSerializationInclusion(JsonInclude.Include.NON_NULL);

//2.2激活序列化类型存储,对象序列化时还会将对象的类型存储到redis数据库

//假如没有这个配置,redis存储数据时不存储类型,反序列化时会默认将其数据存储到map

objectMapper.activateDefaultTyping(

objectMapper.getPolymorphicTypeValidator(),//多态校验分析

ObjectMapper.DefaultTyping.NON_FINAL,//激活序列化类型存储,类不能使用final修饰

JsonTypeInfo.As.PROPERTY);//PROPERTY 表示类型会以json对象属性形式存储

serializer.setObjectMapper(objectMapper);

return serializer;

}

//高级定制

@Bean

public RedisTemplate<Object, Object> redisTemplate(

RedisConnectionFactory redisConnectionFactory) throws UnknownHostException {

RedisTemplate<Object, Object> template = new RedisTemplate();

template.setConnectionFactory(redisConnectionFactory);

//设置key的序列化方式

template.setKeySerializer(RedisSerializer.string());

template.setHashKeySerializer(RedisSerializer.string());

//设置值的序列化方式

template.setValueSerializer(jsonSerializer());

template.setHashValueSerializer(jsonSerializer());

//更新一下RedisTemplate对象的默认配置

template.afterPropertiesSet();

return template;

}

//简单定制

// @Bean

// public RedisTemplate<Object, Object> redisTemplate(

// RedisConnectionFactory redisConnectionFactory) throws UnknownHostException {

// RedisTemplate<Object, Object> template = new RedisTemplate();

// template.setConnectionFactory(redisConnectionFactory);

// //设置key的序列化方式

// template.setKeySerializer(RedisSerializer.string());

// template.setHashKeySerializer(RedisSerializer.string());

// //设置值的序列化方式

// template.setValueSerializer(RedisSerializer.json());

// template.setHashValueSerializer(RedisSerializer.json());

// return template;

// }

}

基于Redis的项目业务分析及实践

分布式id

业务描述

在分布式系统中,数据量将越来越大时,就需要对数据进行分表操作,但是,分表后,每个表中的数据都会按自己的节奏进行自增,很有可能出现ID冲突。这时就需要一个单独的机制来负责生成唯一ID,生成出来的ID也可以叫做 分布式ID,这里我们借助redis实现一个简易的分布式id进行实现,当然还有一些第三方的系统,可以帮你生成这样的id,可以自己进行拓展学习.

关键代码实现

package com.jt.demos;

import redis.clients.jedis.Jedis;

/**

* 需求:生成一个分布递增的id

* 多张表基于这个方法中生成的id作为主键id值(分布式环境不会采用数据库

* 表中自带的自增策略-auto_increment)

*/

public class IdGeneratorDemo01 {

public static Long getId(){

Jedis jedis=new Jedis("192.168.126.130",6379);

//jedis.auth("123456");//假如redis设置了密码,连接redis时需要指定密码

Long id = jedis.incr("id");

jedis.close();

return id;

}

//自己创建线程执行任务

static void execute01(){

for(int i=0;i<10;i++) {

new Thread(){

@Override

public void run() {

String tName=Thread.currentThread().getName();

System.out.println(tName+"->"+

IdGeneratorDemo01.getId());

}

}.start();

}

}

//基于线程池执行任务

static void execute02(){

//构建一个最多只有3个线程的线程池

ExecutorService es=

Executors.newFixedThreadPool(3);

for(int i=1;i<=10;i++){

//从池中取线程执行任务

es.execute(new Runnable() {//这个任务会存储到阻塞式任务队列中

@Override

public void run() {

System.out.println(Thread.currentThread().getName()

+"->"+getId());

}

});

}

}

public static void main(String[] args) {

//execute01();

execute02();

}

}

单点登陆(SSO)

业务描述

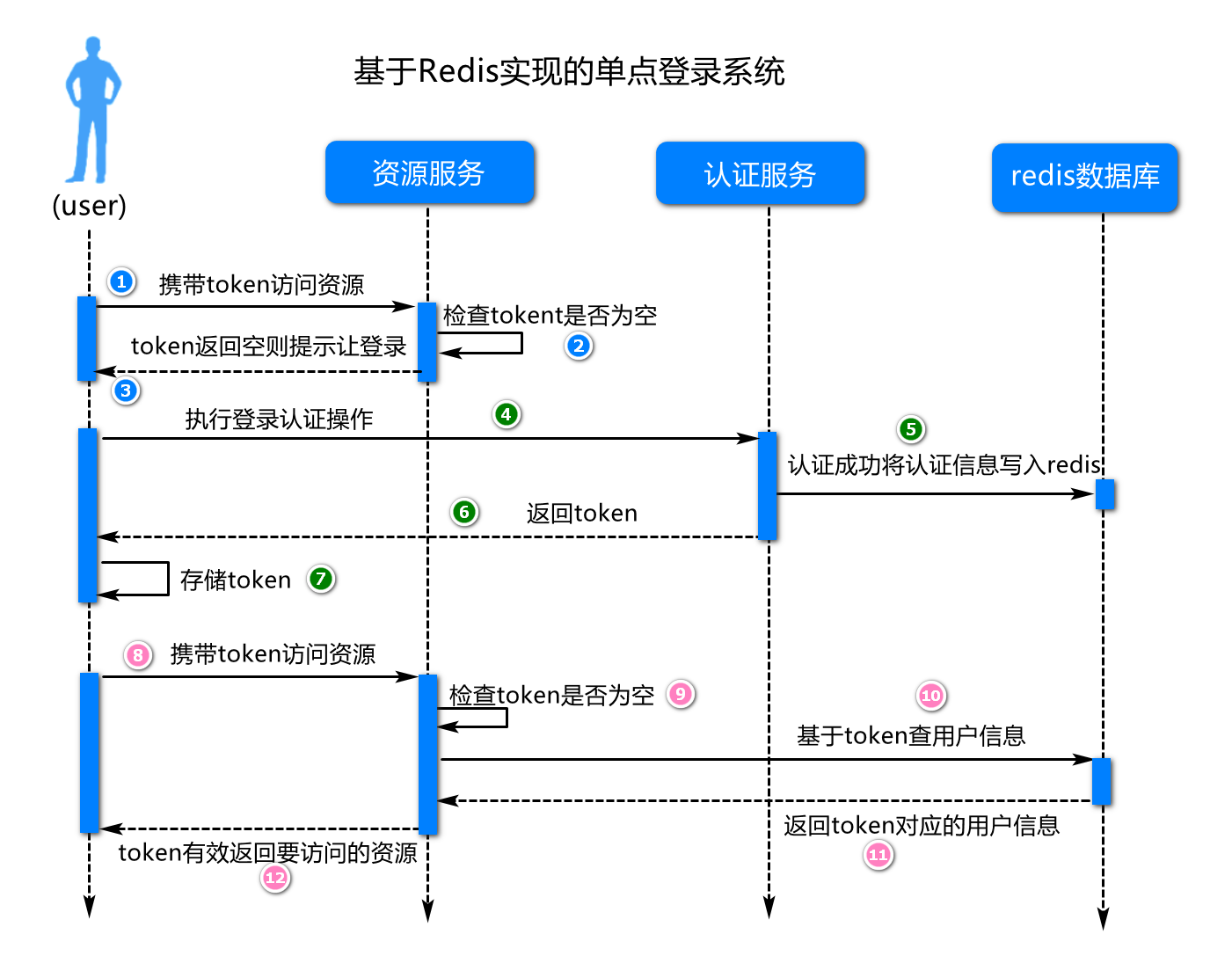

在分布式系统中,通过会有多个服务,我们登录了一个服务以后,再访问其它服务时,不想再登录,就需要有一套单独的认证系统,我们通常会称之为单点登录系统,在这套系统中提供一个认证服务器,服务完成用户身份认证,在一些中小型分布式系统中中,我们通常会借助redis存储用户的认证信息,例如:

关键代码实现

package com.jt.redis;

import redis.clients.jedis.Jedis;

import java.util.UUID;

/**

* 基于redis的单点登录设计及实现

* 1)用户登录成功以后将登录状态等信息存储到redis

* 2)用户携带token去访问资源,资源服务器要基于token从redis查询用户信息

*/

public class SSODemo01 {

/**

* 执行登录认证,将来这样的业务要写到认证服务器

* @param username

* @param password

*/

static String doLogin(String username,String password){

//1.检验数据的合法性(判定用户名,密码是否为空,密码的长度,是否有数字字母特殊符号构成)

if(username==null||"".equals(username))

throw new IllegalArgumentException("用户不能为空");

//2.基于用户名查询用户信息,并判定密码是否正确

if(!"jack".equals(username))

throw new RuntimeException("此用户不存在");

if(!"123456".equals(password))

throw new RuntimeException("密码不正确");

//3.用户存在且密码正确,将用户信息写入到redis

Jedis jedis=new Jedis("192.168.126.128", 6379);

String token= UUID.randomUUID().toString();

jedis.hset(token, "username", username);

jedis.hset(token, "permission", "sys:resource:create");

jedis.expire(token, 10);//设置key的有效时间

jedis.close();

//4.将token返回给客户端(将来使用response对象响应到客户端).

return token;

}

static String token;

/**

* 演示资源访问过程

* 1)允许匿名访问(无需登录)

* 2)登录后访问(认证通过了)

* 3)登录后必须有权限才可以访问

*/

static Object doGetResource(String token){

//1.校验token是否为空

if(token==null)

throw new IllegalArgumentException("请先登录");

//2.基于token查询redis数据,假如有对应数据说明用户登录了

Jedis jedis=new Jedis("192.168.126.128", 6379);

String username=jedis.hget(token, "username");

if(username==null)

throw new RuntimeException("登录超时,请重新登录");

String permission=jedis.hget(token, "permission");

jedis.close();

//3.检查用户是否有访问资源的权限,假如有则允许访问

if(!"sys:resource:create".equals(permission))

throw new RuntimeException("你没有权限访问这个资源");

//4.返回要访问的资源.

return "your resource";

}

public static void main(String[] args) {

//1.登录操作(用户身份认证)

token=doLogin("jack", "123456");

System.out.println(token);

//2.携带token访问资源服务器

Object result=doGetResource(token);

System.out.println(result);

}

}

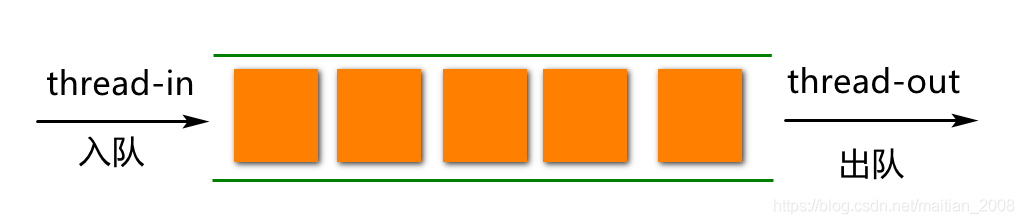

简易秒杀队列

业务描述

在设计一个秒杀或抢购系统时,为了提高系统的响应速度,通常会将用户的秒杀或抢购请求先存储到一个redis队列,这里我们就基于redis实现一个先进先出队列,例如:

关键代码实现

package com.jt.demos;

import redis.clients.jedis.Jedis;

//秒杀队列演示

//描述逻辑中会将商品抢购信息先写到redis(以队列形式进行存储),

//因为写redis内存数据库要比写你的mysql数据库快很多倍

//算法:先进先出(FIFO)-体现公平性

public class SecondKillDemo01 {

//商品抢购首先是入队

static void enque(String msg){//入队

Jedis jedis=new Jedis("192.168.126.130",6379);

jedis.auth("123456");//没有认证不需要写这个语句

jedis.lpush("queue",msg);

jedis.close();

}

//底层异步出队(基于这个消息,生成订单,扣减库存,...)

static String deque(){//出队

Jedis jedis=new Jedis("192.168.126.130",6379);

jedis.auth("123456");//没有认证不需要写这个语句

String result=jedis.rpop("queue");

jedis.close();

return result;

}

public static void main(String[] args){

//1.多次抢购(模拟在界面上多次点击操作)

new Thread(){

@Override

public void run() {

for(int i=1;i<=10;i++){//模拟页面上按钮点击

enque(String.valueOf(i));

try{Thread.sleep(100);}catch(Exception e){}

}

}

}.start();

//2.从队列取内容(模拟后台从队列取数据)

new Thread(){

@Override

public void run() {

for(;;){

String msg=deque();

if(msg==null)continue;

System.out.print(msg);

}

}

}.start();

}

}

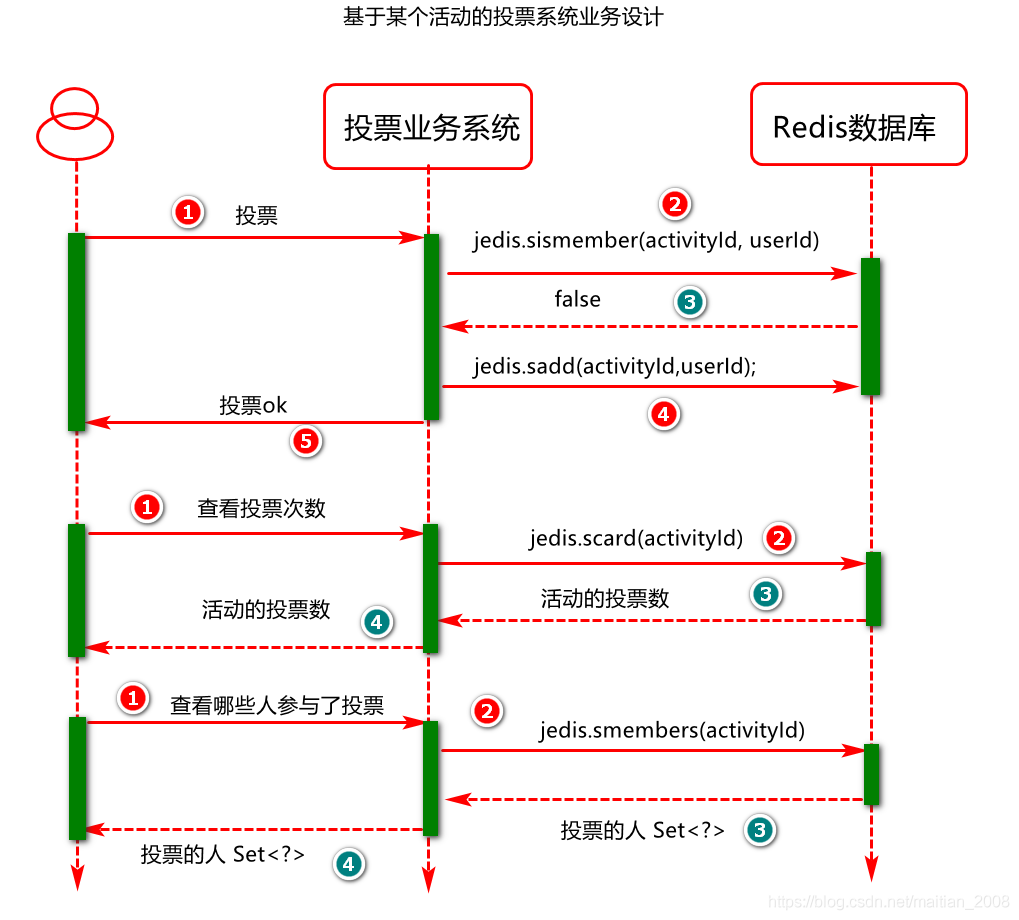

简易投票系统

业务描述

在很多系统中设计中,都会有一个活动设计,开启一个活动之前,可以对这个活动的支持力度先进行一个调查,例如基于这个活动设计一个投票系统,例如:

关键代码实现

package com.jt.redis;

import redis.clients.jedis.Jedis;

import java.util.Set;

/**

* 基于某个活动的简易投票系统设计

* 1)投票数据存储到redis (key为活动id,多个用户id的集合)

* 2)同一个用户不能执行多次投票

* 3)具体业务操作(投票,获取总票数,获取哪些人参与了投票)

*/

public class VoteDemo01 {

/**

* 获取哪些人执行了这个活动的投票

* @param activityId

* @return

*/

static Set<String> doGetMembers(String activityId){

//1.建立连接

Jedis jedis=new Jedis("192.168.126.128", 6379);

//2.获取当前活动的总票数

Set<String> smembers = jedis.smembers(activityId);

//3.释放资源

jedis.close();

return smembers;

}

/**

* 获取指定活动的投票总数

* @param activityId

* @return

*/

static Long doCount(String activityId){

//1.建立连接

Jedis jedis=new Jedis("192.168.126.128", 6379);

//2.获取当前活动的总票数

Long count=jedis.scard(activityId);

//3.释放资源

jedis.close();

return count;

}

/**

* 执行投票操作

* @param activityId

* @param userId

*/

static void doVote(String activityId,String userId){

//1.建立连接

Jedis jedis=new Jedis("192.168.126.128", 6379);

//2.执行投票

//2.1检查是否投过票

Boolean flag = jedis.sismember(activityId, userId);

//2.2执行投票或取消投票

if(flag){

//假如已经投过票,再投票就取消投票

jedis.srem(activityId, userId);

}else{

//没有投过票则执行投票

jedis.sadd(activityId, userId);

}

//3.释放资源

jedis.close();

}

public static void main(String[] args) {

String activityId="101";

String userId1="1";

String userId2="2";

String userId3="3";

//执行投票动作

doVote(activityId, userId1);

doVote(activityId, userId2);

doVote(activityId, userId3);

//获取投票的总票数

Long aLong = doCount(activityId);

System.out.println(aLong);

//获取参与投票的成员

Set<String> members= doGetMembers(activityId);

System.out.println(members);

}

}

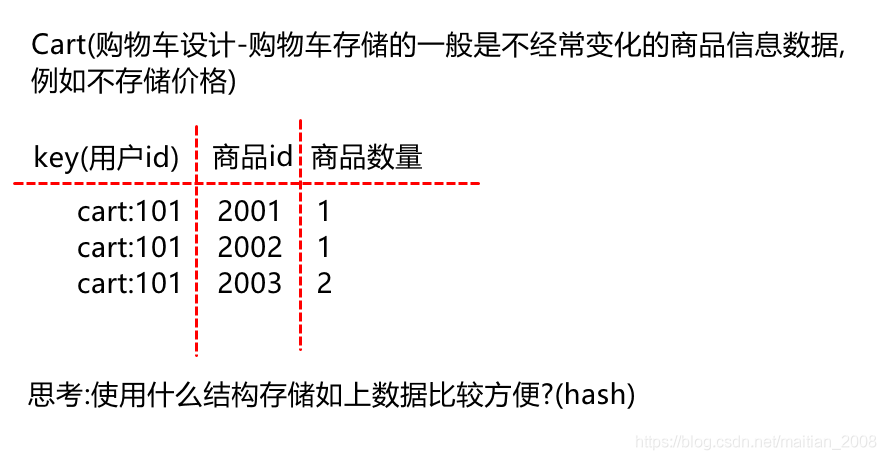

简易购物车系统

业务描述

简易购物车业务设计如图所示:

基础指令操作,例如:

1)向购物车添加商品

hset cart:101 2001 1

hset cart:101 2002 1

hset cart:101 2003 2

2)查看购物车商品

hgetall cart:101

3)删除购物车商品

hdel cart:101 2003

4)改变购物车某个商品的购买数量

hincrby cart:101 2002 2

关键代码实现

package com.jt.demos;

import redis.clients.jedis.Jedis;

import java.util.Map;

/**

* 作业:基于redis存储商品购物车信息

*/

public class CartDemo01 {

public static void addCart(Long userId,Long productId,int num){

//1.建立redis链接

Jedis jedis=new Jedis("192.168.126.130",6379);

jedis.auth("123456");

//2.向购物车添加商品

//hincrBy这个函数在key不存在时会自动创建key

jedis.hincrBy("cart:" + userId, String.valueOf(productId),num);

//3.释放redis链接

jedis.close();

}

//查看我的购物车

public static Map<String, String> listCart(Long userId){

//1.建立redis链接

Jedis jedis=new Jedis("192.168.126.130",6379);

jedis.auth("123456");

//2.查看购物车商品

Map<String, String> map = jedis.hgetAll("cart:" + userId);

//3.释放redis链接

jedis.close();

return map;

}

public static void main(String[] args) {

//1.向购物车添加商品

addCart(101L,201L,1);

addCart(101L,202L,1);

addCart(101L,203L,2);

//2.查看购物车商品

Map<String, String> map = listCart(101L);

System.out.println(map);

}

}

SpringBoot工程中Redis与Aop技术的整合

业务描述

基于AOP与Redis技术实现mysql,redis数据库中数据操作.

项目准备工作

第一步:打开redis-template工程,添加访问MySql数据库的依赖(两个)

<!--mysql依赖-->

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

</dependency>

<!--mybatis plus (简化mybatis操作)-->

<dependency>

<groupId>com.baomidou</groupId>

<artifactId>mybatis-plus-boot-starter</artifactId>

<version>3.4.2</version>

</dependency>

第二步:修改sca-template工程的配置文件,添加连接mysql数据库的配置

spring:

datasource:

url: jdbc:mysql:///jt-sso?serverTimezone=Asia/Shanghai&characterEncoding=utf8

username: root

password: root

12345

Pojo逻辑对象定义

定义一个Menu对象,用户封装tb_menus表中的数据,例如:

package com.jt.pojo;

import com.baomidou.mybatisplus.annotation.IdType;

import com.baomidou.mybatisplus.annotation.TableId;

import com.baomidou.mybatisplus.annotation.TableName;

import org.springframework.data.annotation.Id;

import java.io.Serializable;

@TableName(value = "tb_menus")

public class Menu implements Serializable {

private static final long serialVersionUID = -577747732166248365L;

@TableId(type = IdType.AUTO)

private Long id;

private String name;

private String permission;

public Long getId() {

return id;

}

public void setId(Long id) {

this.id = id;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public String getPermission() {

return permission;

}

public void setPermission(String permission) {

this.permission = permission;

}

@Override

public String toString() {

return "Menu{" +

"id=" + id +

", name='" + name + '\'' +

", permission='" + permission + '\'' +

'}';

}

}

Dao逻辑对象设计及实现

创建用于操作数据库中tb_menus表中数据的Mapper对象,例如:

package com.jt.dao;

import com.baomidou.mybatisplus.core.mapper.BaseMapper;

import com.jt.pojo.Menu;

import org.apache.ibatis.annotations.Mapper;

@Mapper

public interface MenuMapper extends BaseMapper<Menu> {

}

123456789

Service逻辑对象设计及实现

第一步:定义用于处理菜单业务的业务接口,例如:

package com.jt.service;

import com.jt.pojo.Menu;

import java.io.Serializable;

public interface MenuService {

/**

* 基于id查找菜单对象,先查redis,redis没有再查数据库

* @param id

* @return

*/

Menu selectById(Long id);

/**

* 向表中写入一条菜单信息,与此同时也要向redis写入一样的数据

* @param menu

* @return

*/

Menu insertMenu(Menu menu);

/**

* 更新表中数据,与此同时也要更新redis中的数据

* @param menu

* @return

*/

Menu updateMenu(Menu menu);

//.....

}

第二步:定义用于处理菜单业务的业务接口实现类,

在这个实现类中自己基于RedisTemplate对象操作Redis缓存,例如:

package com.jt.service;

import com.jt.dao.MenuMapper;

import com.jt.pojo.Menu;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.data.redis.core.ValueOperations;

import org.springframework.stereotype.Service;

import javax.annotation.Resource;

import java.time.Duration;

@Service

public class MenuServiceImpl implements MenuService{

//注入方案1

//@Autowired

//private RedisTemplate redisTemplate;

//@Autowired

//private MenuMapper menuMapper;

private static final Logger log=

LoggerFactory.getLogger(MenuServiceImpl.class);

//注入方案2

private MenuMapper menuMapper;

private ValueOperations valueOperations;

public MenuServiceImpl(MenuMapper menuMapper,

RedisTemplate redisTemplate) {

this.menuMapper = menuMapper;

this.valueOperations = redisTemplate.opsForValue();

}

private static final String KEY_PREFIX="menu:";

@Override

public Menu selectById(Long id) {

//1.从redis获取菜单信息,有则直接返回

//ValueOperations valueOperations = redisTemplate.opsForValue();

Object obj = valueOperations.get(KEY_PREFIX + id);

if(obj!=null){

log.info("Data from Redis Cache");

return (Menu)obj;

}

log.info("Data from MySQL");

//2.从mysql数据库中查询菜单信息

Menu menu=menuMapper.selectById(id);

//3.将数据中查询到的菜单信息存储到redis

valueOperations.set(KEY_PREFIX+id,

menu,

Duration.ofSeconds(60*60));

//4.返回菜单对象

return menu;

}

@Override

public Menu insertMenu(Menu menu) {

//1.保存到关系数据

log.info("insert.before.menu={}",menu);

menuMapper.insert(menu);

log.info("insert.after.menu={}",menu);

//2.将数据保存到缓存

//ValueOperations valueOperations = redisTemplate.opsForValue();

valueOperations.set(KEY_PREFIX+menu.getId(),

menu, Duration.ofSeconds(60*60));

return menu;

}

@Override

public Menu updateMenu(Menu menu) {

//1.更新mysql数据

menuMapper.updateById(menu);

//2.更新缓存数据

//ValueOperations valueOperations = redisTemplate.opsForValue();

valueOperations.set(KEY_PREFIX+menu.getId(),

menu, Duration.ofSeconds(60*60));

return menu;

}

}

第三步:定义用于处理菜单业务的业务接口实现类,基于AOP方式操作redis缓存,比较

与第二步写的Redis操作方式的不同,例如:

package com.jt.service;

import com.jt.dao.MenuMapper;

import com.jt.pojo.Menu;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.cache.annotation.CachePut;

import org.springframework.cache.annotation.Cacheable;

import org.springframework.stereotype.Service;

@Service

public class DefaultMenuService implements MenuService{

@Autowired

private MenuMapper menuMapper;

/**

* 由此注解描述的方法为切入点方法,此方法执行时,底层会通过AOP机制

* 先从缓存取数据,缓存有则直接返回,缓存没有则查数据,最后将查询的数据

* 还会向redis存储一份

* @param id

* @return

*/

@Cacheable(value = "menuCache",key="#id")

@Override

public Menu selectById(Long id) {

return menuMapper.selectById(id);

}

/**

* CachePut注解的意思是更新缓存

* @param menu

* @return

*/

@CachePut(value = "menuCache",key="#menu.id")

@Override

public Menu insertMenu(Menu menu) {

menuMapper.insert(menu);

return menu;

}

@CachePut(value = "menuCache",key="#menu.id")

@Override

public Menu updateMenu(Menu menu) {

menuMapper.updateById(menu);

return menu;

}

}

说明,启动AOP方式的缓存应用,需要在启动类上添加@EnableCaching注解:

第四步:定义单元测试类,基于单元测试类测试缓存应用.例如:

package com.jt;

import com.jt.pojo.Menu;

import com.jt.service.MenuService;

import org.junit.jupiter.api.Test;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.beans.factory.annotation.Qualifier;

import org.springframework.boot.test.context.SpringBootTest;

import javax.annotation.Resource;

@SpringBootTest

public class MenuServiceTests {

@Autowired

@Qualifier("defaultMenuService")

//@Resource(name="defaultMenuService")

private MenuService menuService;

@Test

void testSelectById(){

Menu menu = menuService.selectById(1L);

System.out.println(menu);

}

@Test

void testUpdateMenu(){

Menu menu = menuService.selectById(1L);

menu.setName("select res");

menuService.updateMenu(menu);

}

@Test

void testInertMenu(){

Menu menu = new Menu();

menu.setName("insert res");

menu.setPermission("sys:res:insert");

menuService.insertMenu(menu);

}

}

第五步:改变AOP方式中redis数据存储时的序列化方式(假如业务上需要).其实现上要借助

CacheManager对象,例如:

package com.jt;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.cache.CacheManager;

import org.springframework.cache.annotation.CachingConfigurerSupport;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.context.annotation.Primary;

import org.springframework.data.redis.cache.RedisCacheConfiguration;

import org.springframework.data.redis.cache.RedisCacheManager;

import org.springframework.data.redis.connection.RedisConnectionFactory;

import org.springframework.data.redis.serializer.Jackson2JsonRedisSerializer;

import org.springframework.data.redis.serializer.RedisSerializationContext;

import org.springframework.data.redis.serializer.RedisSerializer;

/**

* 重构CacheManager对象,其目的是改变AOP方式应用redis的序列化和反序列化的方式.

*/

@Configuration

public class CacheManagerConfig {

/**

* 重构CacheManager对象

* @return

*/

@Bean

public CacheManager cacheManager(RedisConnectionFactory redisConnectionFactory) {

//定义RedisCache配置

RedisCacheConfiguration cacheConfig=

RedisCacheConfiguration.defaultCacheConfig()

//定义key的序列化方式

.serializeKeysWith(

RedisSerializationContext.

SerializationPair.fromSerializer(RedisSerializer.string()))

//定义value的序列化方式

.serializeValuesWith(

RedisSerializationContext.SerializationPair

.fromSerializer(RedisSerializer.json()));

return RedisCacheManager.builder(redisConnectionFactory)

.cacheDefaults(cacheConfig)

.build();//建造者模式(复杂对象的创建,建议使用这种方式,封装了对象的创建细节)

}

}

写好这个对象后,可以再次基于MenuService中的方法进行单元测试,检测redis数据的存储.

Controller逻辑对象设计及实现

第一步:定义Controller处理,处理客户端对菜单数据的请求操作,例如:

package com.jt.controller;

import com.jt.pojo.Menu;

import com.jt.service.MenuService;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.beans.factory.annotation.Qualifier;

import org.springframework.web.bind.annotation.*;

@RestController

@RequestMapping("/menu")

public class MenuController{

@Autowired

@Qualifier("defaultMenuService")

private MenuService menuService;

@GetMapping("/{id}")

public Menu doSelectById(@PathVariable("id") Long id){

return menuService.selectById(id);

}

@PutMapping

public String doUpdate(@RequestBody Menu menu){

menuService.updateMenu(menu);

return "update ok";

}

@PostMapping

public String doInsert(@RequestBody Menu menu){

menuService.insertMenu(menu);

return "insert ok";

}

}

第二步:打开postman或基于idea中的http client工具进行访问测试.检测redis数据存储与更新

总结(Summary)

本章节主要对Java中操作redis数据库的方式及API应用进行了分析和实践,具体方法的理解可以在实践中基于结果进行分析,逐步进行强化记忆。

04-Redis 数据持久化实践

简介

背景

Redis是一种内存数据库,在断电时数据可能会丢失。比如你redis整个挂了,然后redis不可用了,如果没有持久化的话,redis就会丢失所有的数据,如果通过持久化将数据搞一份儿到磁盘上去,然后再定期同步到一些云存储服务上去,那么就可以保证一些数据不丢失,保证数据的可靠性。

持久化方式

Redis中为了保证在系统宕机(类似进程被杀死)情况下,能更快的进行故障恢复,设计了两种数据持久化方案,分别为rdb和aof方式。

配置准备工作

第一步:从redis.io官方下载对应版本的redis.conf文件,地址如下(假如下载不下来从code上去取或者从同学那拿):

https://redis.io/topics/config/

1

第二步:停止redis并删除挂载目录下(/usr/local/docker/redis01/conf)的redis.conf配置文件.

第三步:将下载的redis.conf文件拷贝到redis挂载目录(/usr/local/docker/redis01/conf)

第四步:基于vim打开redis.conf文件,然后注释 bind 127.0.0.1这一行,并修改protected-mode的值修改为no.(java连接redis需要改这两项目)

第五步:重启redis服务,并检查启动日志(docker logs 容器id)

Rdb方式持久化

概述

Rdb方式是通过手动(save-阻塞式,bgsave-异步)或周期性方式保存redis中key/value的一种机制,Rdb方式一般为redis的默认数据持久化方式.系统启动时会自动开启这种方式的持久化机制。

RDB方式配置

RDB方式的持久化是默认开启的,也可按规则自己配置,例如,打开redis.conf文件,例如

# 这里表示每隔60s,如果有超过1000个key发生了变更,那么就生成一个新的dump.rdb文件,就是当前redis内存中完整的数据快照,这个操作也被称之为snapshotting(快照)。

save 60 1000

# 持久化 rdb文件遇到问题时,主进程是否接受写入,yes 表示停止写入,如果是no 表示redis继续提供服务。

stop-writes-on-bgsave-error yes

# 在进行快照镜像时,是否进行压缩。yes:压缩,但是需要一些cpu的消耗。no:不压缩,需要更多的磁盘空间。

rdbcompression yes

# 一个CRC64的校验就被放在了文件末尾,当存储或者加载rbd文件的时候会有一个10%左右的性能下降,为了达到性能的最大化,你可以关掉这个配置项。

rdbchecksum yes

# 快照的文件名

dbfilename dump.rdb

# 存放快照的目录

dir /var/lib/redis

Rdb方式持久化实践

试验一

在redis中保存几条数据,然后执行shutdown关闭redis,然后再重启redis,看看刚才插入的数据是否还在?假如数据还在,为什么?

因为,通过redis-cli shutdown这种方式去停掉redis,其实是一种安全退出的模式,redis在退出的时候会将内存中的数据立即生成一份完整的rdb快照,例如

127.0.0.1:6379> set phone 11111111

OK

127.0.0.1:6379> shutdown #默认也会进行持久化

[root@centos7964 ~]# docker start redis01

[root@centos7964 ~]# docker exec -it redis01 redis-cli

127.0.0.1:6379> keys *

1) "pone"

试验二

在redis中再保存几条新的数据,用kill -9粗暴杀死redis进程,模拟redis故障异常退出,导致内存数据丢失的场景?

这次就发现,redis进程异常被杀掉,几条最新的数据就丢失了。例如:

首先,打开第一个客户端,先清除redis内存和磁盘对应的数据

[root@centos7964 data]# docker exec -it redis01 redis-cli

127.0.0.1:6379> flushall

OK

127.0.0.1:6379> exit

[root@centos7964 data]# ls

dump.rdb

[root@centos7964 data]# rm –f dump.rdb

[root@centos7964 data]# ls

然后,打开并登录第二个客户端,并向redis存储一些数据,例如

[root@centos7964 ~]# docker exec -it redis01 redis-cli

127.0.0.1:6379> set one mybatis

OK

127.0.0.1:6379> set two spring

OK

127.0.0.1:6379> keys *

1) "one"

2) "two"

接下来,再次回到第一个客户端,杀掉redis进程,例如

[root@centos7964 data]# ps -ef | grep redis

polkitd 6995 6974 0 14:44 ? 00:00:00 redis-server *:6379

root 7064 6974 0 14:44 pts/0 00:00:00 redis-cli

root 7111 6467 0 14:47 pts/1 00:00:00 docker exec -it redis01 redis-cli

root 7130 6974 0 14:47 pts/1 00:00:00 redis-cli

root 7278 7180 0 14:51 pts/0 00:00:00 grep --color=auto redis

[root@centos7964 data]# kill -9 6995

[root@centos7964 data]# docker start redis01

最后,打开第一个客户端,登录redis,检查key是否还存在.

[root@centos7964 ~]# docker exec -it redis01 redis-cli

127.0.0.1:6379> keys *

(empty array)

127.0.0.1:6379>

[root@centos7964 ~]#

试验三

手动调用save(同步保存)或者bgsave(异步保存)执行rdb快照生成.然后杀掉redis进程,再重启检测是否还有刚刚保存的数据.

127.0.0.1:6379> set id 100

OK

127.0.0.1:6379> set name jack

OK

127.0.0.1:6379> save #阻塞式持久化

OK

127.0.0.1:6379> set address beijing

OK

127.0.0.1:6379> bgsave #异步方式持久化

Background saving started

小节面试分析

触发redis中rdb方式持久化的时机?

1)基于配置文件中的save规则周期性的执行持久化。

2)手动执行了shutdown操作会自动执行rdb方式的持久化。

3)手动调用了save或bgsave指令执行数据持久化。

4)在Master/Slave架构下,当有新的Slave连接Master时,Master会对数据进行rdb方式持久化.

Redis中的save和bgsave有什么不同?

- Save 命令执行一个同步保存操作,将当前 Redis 实例的所有数据快照(snapshot)以 RDB 文件的形式保存到硬盘。

- BGSAVE 命令执行之后立即返回 OK ,然后 Redis fork 出一个新子进程,原来的 Redis 进程(父进程)继续处理客户端请求,而子进程则负责将数据保存到磁盘,然后退出。

RDB持久化机制有哪些优点?

- RDB 文件是经过压缩的二进制文件,占用空间很小,它保存了 Redis 某个时间点的数据集,很适合做冷备.

- RDB 非常适用于灾难恢复,它只有一个文件,并且内容都非常紧凑,可以(在加密后)将它传送到别的数据中心。

- RDB 方式持久化性能较好,执行持久化时可以fork 一个子进程,由子进程处理保存工作,父进程无须执行任何磁盘 I/O 操作。

RDB持久化机制有哪些缺点?

- RDB方式在服务器故障时容易造成数据的丢失。实际项目中,我们可通过配置来控制持久化的频率。但是,如果频率太频繁,可能会对 Redis 性能产生影响。所以通常可能设置至少5分钟才保存一次快照,这时如果 Redis 出现宕机等情况,则意味着最多可能丢失5分钟数据。

- RDB 方式使用 fork 子进程进行数据的持久化,子进程的内存是在fork操作时父进程中数据快照的大小,如果数据快照比较大的话,fork 时开辟内存会比较耗时,同时这个fork是同步操作,所以,这个过程会导致父进程无法对外提供服务。

3)RDB持久化过程中的fork操作,可能会导致内存占用加倍,Linux系统fork 子进程采用的是 copy-on-write 的方式(写时复制,修改前先复制),在 Redis 执行 RDB 持久化期间,如果 client 写入数据很频繁,那么将增加 Redis 占用的内存,最坏情况下,内存的占用将达到原先的2倍。

Aof方式数据持久化

概述

Aof方式是通过记录写操作日志的方式,实现redis数据持久化的一种机制,这个机制默认是关闭的。

AOF方式配置

# 是否开启AOF,默认关闭

appendonly yes

# 指定 AOF 文件名

appendfilename appendonly.aof

# Redis支持三种刷写模式:

# appendfsync always #每次收到写命令就立即强制写入磁盘,类似MySQL的sync_binlog=1,是最安全的。但该模式下速度也是最慢的,一般不推荐使用。

appendfsync everysec #每秒钟强制写入磁盘一次,在性能和持久化方面做平衡,推荐该方式。

# appendfsync no #完全依赖OS的写入,一般为30秒左右一次,性能最好但是持久化最没有保证,不推荐。

#在日志重写时,不进行命令追加操作,而只是将其放在缓冲区里,避免与命令的追加造成DISK IO上的冲突。

#设置为yes表示rewrite期间对新写操作不fsync,暂时存在内存中,等rewrite完成后再写入,默认为no,建议yes

no-appendfsync-on-rewrite yes

#当前AOF文件大小是上次日志重写得到AOF文件大小的二倍时,自动启动新的日志重写过程。

auto-aof-rewrite-percentage 100

#当前AOF文件启动新的日志重写过程的最小值,避免刚刚启动Reids时由于文件尺寸较小导致频繁的重写。

auto-aof-rewrite-min-size 64mb

AOF方式持久化实践

第一:打开AOF的开关,启用AOF持久化

第二:写入一些数据,观察AOF文件(appendonly.aof)中的日志内容

第三:kill -9杀掉redis进程,重新启动redis进程,发现数据被恢复回来了,就是从AOF文件中恢复回来的,redis进程启动的时候,直接就会从appendonly.aof中加载所有的日志,把内存中的数据恢复回来。

小节面试分析

如何理解AOF方式中的rewrite操作?

redis中的可以存储的数据是有限的,很多数据可能会自动过期,也可能会被用户删除或被redis用缓存清除的算法清理掉。也就是说redis中的数据会不断淘汰掉旧的,只有一部分常用的数据会被自动保留在redis内存中,所以可能很多之前的已经被清理掉的数据,对应的写日志还停留在AOF中,AOF日志文件就一个,会不断的膨胀,最后导致文件很大。

所以,AOF会自动在后台每隔一定时间做rewrite操作,比如日志里已经存放了针对100w数据的写日志了,但redis内存现在10万数据; 于是,基于内存中当前的10万数据构建一套最新的日志,然后到AOF文件中; 覆盖之前的老日志,从而,确保AOF日志文件不会过大,保持跟redis内存数据量一致。

AOF持久化机制有哪些优点?

AOF 比 RDB更加可靠。你可以设置不同的 fsync 策略(no、everysec 和 always)。默认是 everysec,在这种配置下,redis 仍然可以保持良好的性能,并且就算发生故障停机,也最多只会丢失一秒钟的数据。

AOF文件是一个基于纯追加模式的日志文件。即使日志因为某些原因而包含了未写入完整的命令(比如写入时磁盘已满,写入中途停机等等), 我们也可以使用 redis-check-aof 工具也可以轻易地修复这种问题。

当 AOF文件太大时,Redis 会自动在后台进行重写。重写后的新 AOF 文件包含了恢复当前数据集所需的最小命令集合。整个重写是绝对安全,因为重写是在一个新的文件上进行,同时 Redis 会继续往旧的文件追加数据。当新文件重写完毕,Redis 会把新旧文件进行切换,然后开始把数据写到新文件上。

AOF 文件有序地保存了对数据库执行的所有写入操作,以 Redis 协议的格式保存, 因此 AOF 文件的内容非常容易被人读懂, 对文件进行分析也很轻松。如果你不小心执行了 FLUSHALL 命令把所有数据刷掉了,但只要 AOF 文件没有被重写,那么只要停止服务器, 移除 AOF 文件末尾的 FLUSHALL 命令, 并重启 Redis , 就可以将数据集恢复到 FLUSHALL 执行之前的状态。

AOF持久化机制有哪些缺点?

对于相同的数据集,AOF 文件的大小一般会比 RDB 文件大。根据所使用的 fsync 策略,AOF 的速度可能会比 RDB 慢。通常 fsync 设置为每秒一次就能获得比较高的性能,而关闭 fsync 可以让 AOF 的速度和 RDB 一样快。AOF 可能会因为个别命令的原因,导致 AOF 文件在重新载入时,无法将数据集恢复成保存时的原样。

如何选择redis的持久化方式?

第一:不要仅仅使用RDB,因为那样会导致你丢失很多数据。

第二:也不要仅仅使用AOF,因为AOF做冷备没有RDB做冷备进行数据恢复的速度快,并且RDB简单粗暴的数据快照方式更加健壮。

第三:综合使用AOF和RDB两种持久化机制,用AOF来保证数据不丢失,作为数据恢复的第一选择; 用RDB来做不同程度的冷备。

总结(Summary)

本章主要是对redis中的持久化方式,持久化机制,应用实践进行基本分析与讲解。重点是如何在生产环境下应用。

05-Redis 事务处理实践

Redis事务简介

概述

事务是一个业务,也可以看成是一个逻辑工作单元,是为了保证业务的完整,数据的正确而推出的一种控制机制,原则上来讲,事务必须要满足ACID四个特性(原子性,一致性,隔离性,持久性),在多个事务

在并发执行,为更好保证事务的四个特性的实现,通常会对事务加锁,Redis为了性能,采用了乐观锁方式进行事务控制,它使用watch命令监视给定的key,当exec(提交事务)的时候,如果监视的key从调用watch后发生过变化,则整个事务会失败。也可以调用watch多次监视多个key。注意watch的key是对整个连接有效的,如果连接断开,监视和事务都会被自动清除。当然exec,discard,unwatch命令都会清除连接中的所有监视。

基本指令

redis进行事务控制时,通常是基于如下指令进行实现,例如:

- multi 开启事务

- exec 提交事务

- discard 取消事务

- watch 监控,如果监控的值发生变化,则提交事务时会失败

- unwatch 去掉监控

Redis保证一个事务中的所有命令要么都执行,要么都不执行(原子性)。如果在发送EXEC命令前客户端断线了,则Redis会清空事务队列,事务中的所有命令都不会执行。而一旦客户端发送了EXEC命令,所有的命令就都会被执行,即使此后客户端断线也没关系,因为Redis中已经记录了所有要执行的命令。

Redis事务控制实践

exec提交事务

例如:模拟转账,tony 500,jack 200,tony转给jack100。过程如下:

127.0.0.1:6379> set tony 500

OK

127.0.0.1:6379> set jack 200

OK

127.0.0.1:6379> mget tony jack

1) "500"

2) "200"

127.0.0.1:6379> multi #开启事务

OK

127.0.0.1:6379(TX)> decrby tony 100 #所有指令操作会进入到队列

QUEUED

127.0.0.1:6379(TX)> incrby jack 100

QUEUED

127.0.0.1:6379(TX)> mget tony jack

QUEUED

127.0.0.1:6379(TX)> exec #提交事务

1) (integer) 400

2) (integer) 300

3) 1) "400"

2) "300"

127.0.0.1:6379> mget tony jack

1) "400"

2) "300"

127.0.0.1:6379>

123456789101112131415161718192021222324

discard取消事务

注意redis事务太简单,没有回滚,而只有取消。

127.0.0.1:6379> mget tony jack

1) "400"

2) "300"

127.0.0.1:6379> multi

OK

127.0.0.1:6379> incrby jack 100

QUEUED

127.0.0.1:6379> discard

OK

127.0.0.1:6379> get jack

"300"

127.0.0.1:6379> exec

(error) ERR EXEC without MULTI

12345678910111213

当出现错误指令时,事务也会自动取消。

127.0.0.1:6379> mget tony jack

1) "400"

2) "300"

127.0.0.1:6379> multi

OK

127.0.0.1:6379(TX)> incrby jack 100

QUEUED

127.0.0.1:6379(TX)> abcd

(error) ERR unknown command `abcd`, with args beginning with:

127.0.0.1:6379(TX)> get jack

QUEUED

127.0.0.1:6379(TX)> exec

(error) EXECABORT Transaction discarded because of previous errors.

127.0.0.1:6379> get jack

"300"

127.0.0.1:6379>

12345678910111213141516

秒杀抢票事务处理

基于一个秒杀,抢购案例,演示redis乐观锁方式,例如

第一步:打开客户端1,执行如下操作

127.0.0.1:6379> set ticket 1

OK

127.0.0.1:6379> set money 0

OK

127.0.0.1:6379> watch ticket #乐观锁,对值进行观察,改变则事务失败

OK

127.0.0.1:6379> multi #开启事务

OK

127.0.0.1:6379> decr ticket

QUEUED

127.0.0.1:6379> incrby money 100

QUEUED

123456789101112

第二步:打开客户端2,执行如下操作,演示还没等客户端1提交事务,此时客户端2把票买到了。

127.0.0.1:6379> get ticket

"1"

127.0.0.1:6379> decr ticket

(integer) 0

1234

第三步,回到客户端1:提交事务,检查ticket的值

127.0.0.1:6379> exec

(nil) #执行事务,失败

127.0.0.1:6379> get ticket

“0”

127.0.0.1:6379> unwatch #取消监控

Jedis 客户端事务操作

基于Jedis进行事务测试,代码如下:

package com.jt;

import org.junit.Test;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.Transaction;

public class JedisTransactionTests {

@Test

public void testTransaction(){

Jedis jedis=new Jedis("192.168.126.130",6379);

jedis.auth("123456");

jedis.set("tony","300");

jedis.set("jack","500");

//实现操作,tony转账100给jack

//开启事务

Transaction multi = jedis.multi();

//执行业务操作

try {

multi.decrBy("tony", 100);

multi.incrBy("jack", 100);

int n=100/0;//模拟异常

//提交事务

multi.exec();

}catch(Exception e) {

//出现异常取消事务

multi.discard();

}

String tonyMoney=jedis.get("tony");

String jackMoney=jedis.get("jack");

System.out.println("tonyMoney="+tonyMoney);

System.out.println("jackMoney="+jackMoney);

jedis.close();

}

}

12345678910111213141516171819202122232425262728293031323334

Jedis 客户端秒杀操作实践

package com.jt.demos;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.Response;

import redis.clients.jedis.Transaction;

import java.util.List;

/**

* redis秒杀练习:

* 模拟两个线程都去抢购同一张票(考虑乐关锁)

*/

public class SecondKillDemo02 {

public static void secKill(){

Jedis jedis=new Jedis("192.168.126.130",6379);

jedis.auth("123456");

jedis.watch("ticket","money");

String ticket = jedis.get("ticket");

if(ticket==null||Integer.valueOf(ticket)==0)

throw new RuntimeException("已无库存");

Transaction multi = jedis.multi();

try {

multi.decr("ticket");

multi.incrBy("money", 100);

List<Object> exec = multi.exec();

System.out.println(exec);

}catch (Exception e){

e.printStackTrace();

multi.discard();

}finally {

jedis.unwatch();

jedis.close();

}

}

public static void main(String[] args) {

Jedis jedis=new Jedis("192.168.126.130",6379);

jedis.auth("123456");

jedis.set("ticket","1");

jedis.set("money","0");

Thread t1=new Thread(()->{

secKill();

});

Thread t2=new Thread(()->{

secKill();

});

t1.start();

t2.start();

}

}

总结(Summary)

本小节重点讲解了redis中的事务,以及事务控制指令,控制机制,乐观锁实现。

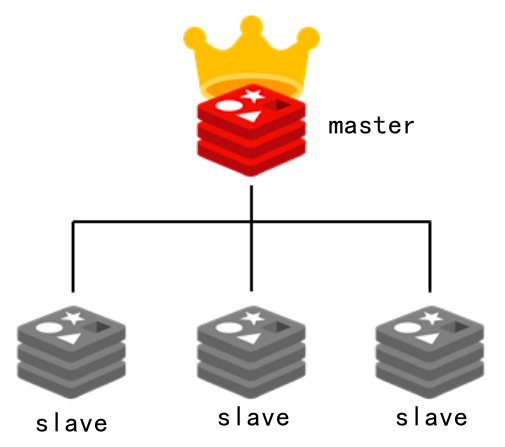

06-Redis架构设计应用实践

Redis主从复制

简介

单个Redis支持的读写能力还是有限的,此时我们可以使用多个redis来提高redis的[并发]处理能力,这些redis如何协同,就需要有一定的架构设计,这里我们首先从主从(Master/Slave)架构进行分析和实现.

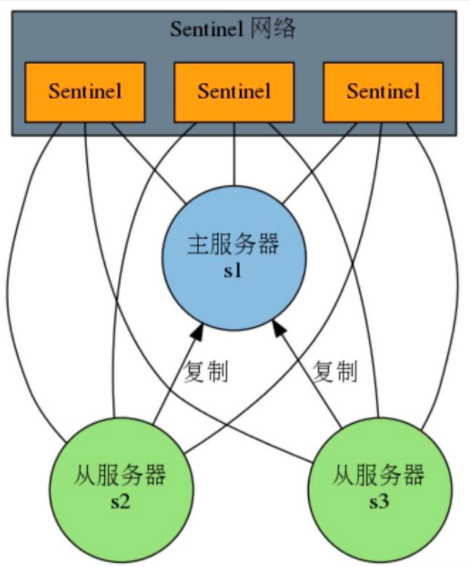

基本架构

redis主从架构如图所示:

其中,master负责读写,并将数据同步到salve,从节点负责读操作.

快速入门实践

基于redis,设计一主从架构,一个Master,两个Slave,其中Master负责Redis读写操作,并将数据同步到Slave,Slave只负责读.,其步骤如下:

第一步:删除所有原有的redis容器(为了避免内存不足,宿主机端口冲突),例如:

docker rm -f redis容器名

第二步:进入你的宿主机docker目录,然后将redis01拷贝两份,例如:

cp -r redis01/ redis02

cp -r redis01/ redis03

第三步:启动三个新的redis容器,例如:

docker run -p 6379:6379 --name redis6379 \

-v /usr/local/docker/redis01/data:/data \

-v /usr/local/docker/redis01/conf/redis.conf:/etc/redis/redis.conf \

-d redis redis-server /etc/redis/redis.conf \

--appendonly yes

docker run -p 6380:6379 --name redis6380 \

-v /usr/local/docker/redis02/data:/data \

-v /usr/local/docker/redis02/conf/redis.conf:/etc/redis/redis.conf \

-d redis redis-server /etc/redis/redis.conf \

--appendonly yes

docker run -p 6381:6379 --name redis6381 \

-v /usr/local/docker/redis03/data:/data \

-v /usr/local/docker/redis03/conf/redis.conf:/etc/redis/redis.conf \

-d redis redis-server /etc/redis/redis.conf \

--appendonly yes

第四步 检测redis服务角色

启动三个客户端,分别登陆三台redis容器服务,通过info指令进行角色查看,默认新启动的三个redis服务角色都为master.

127.0.0.1:6379> info replication

1

\# Replication

role:master

connected_slaves:0

master_repl_offset:3860

repl_backlog_active:1

repl_backlog_size:1048576

repl_backlog_first_byte_offset:2

repl_backlog_histlen:3859

第五步:检测redis6379的ip设置

docker inspect redis6379

1

……

"Networks": {

"bridge": {

"IPAMConfig": null,

"Links": null,

"Aliases": null,

"NetworkID": "c33071765cb48acb1efed6611615c767b04b98e6e298caa0dc845420e6112b73",

"EndpointID": "4c77e3f458ea64b7fc45062c5b2b3481fa32005153b7afc211117d0f7603e154",

"Gateway": "172.17.0.1",

"IPAddress": "172.17.0.2",

"IPPrefixLen": 16,

"IPv6Gateway": "",

"GlobalIPv6Address": "",

"GlobalIPv6PrefixLen": 0,

"MacAddress": "02:42:ac:11:00:02",

"DriverOpts": null

}

}

第六步:设置Master/Slave架构

分别登陆redis6380/redis6381,然后执行如下语句

slaveof 172.17.0.2 6379

说明,假如master有密码,需要在slave的redis.conf配置文件中添加"masterauth 你的密码"这条语句,然后重启redis再执行slaveof 指令操作.

第七步:再次登陆redis6379,然后检测info

[root@centos7964 ~]# docker exec -it redis6379 redis-cli

127.0.0.1:6379> info replication

12

\# Replication

role:master

connected_slaves:2

slave0:ip=172.17.0.3,port=6379,state=online,offset=2004,lag=1

slave1:ip=172.17.0.4,port=6379,state=online,offset=2004,lag=1

master_failover_state:no-failover

master_replid:5baf174fd40e97663998abf5d8e89a51f7458488

master_replid2:0000000000000000000000000000000000000000

master_repl_offset:2004

second_repl_offset:-1

repl_backlog_active:1

repl_backlog_size:1048576

repl_backlog_first_byte_offset:1

repl_backlog_histlen:2004

第八步: 登陆redis6379测试,master读写都可以

[root@centos7964 ~]# docker exec -it redis6379 redis-cli

127.0.0.1:6379> set role master6379

OK

127.0.0.1:6379> get role

"master6379"

127.0.0.1:6379>

第九步: 登陆redis6380测试,slave只能读。

[root@centos7964 ~]# docker exec -it redis6380 redis-cli

127.0.0.1:6379> get role

"master6379"

127.0.0.1:6379> set role slave6380

(error) READONLY You can't write against a read only replica.

127.0.0.1:6379>

Java中的读写测试分析,代码如下:

@SpringBootTest

public class MasterSlaveTests {

@Autowired

private RedisTemplate redisTemplate;

@Test

void testMasterReadWrite(){//配置文件端口为6379

ValueOperations valueOperations = redisTemplate.opsForValue();

valueOperations.set("role", "master6379");

Object role = valueOperations.get("role");

System.out.println(role);

}

@Test

void testSlaveRead(){//配置文件端口为6380

ValueOperations valueOperations = redisTemplate.opsForValue();

Object role = valueOperations.get("role");

System.out.println(role);

}

}

主从同步原理分析

Redis的主从架构可以采用一主多从结构,Redis主从复制可以根据是否是全量分为全量同步和增量同步。

- Redis全量同步:

Redis全量复制一般发生在Slave初始化阶段,这时Slave需要将Master上的所有数据都复制一份。具体步骤如下:

1)从服务器连接主服务器,发送SYNC命令;

2)主服务器接收到SYNC命名后,开始执行BGSAVE命令生成RDB文件并使用缓冲区记录此后执行的所有写命令;

3)主服务器BGSAVE执行完后,向所有从服务器发送快照文件,并在发送期间继续记录被执行的写命令;

4)从服务器收到快照文件后丢弃所有旧数据,载入收到的快照;

5)主服务器快照发送完毕后开始向从服务器发送缓冲区中的写命令;

6)从服务器完成对快照的载入,开始接收命令请求,并执行来自主服务器缓冲区的写命令;

- Redis增量同步

Redis增量复制是指Slave初始化后,开始正常工作时主服务器发生的写操作同步到从服务器的过程。 增量复制的过程主要是主服务器每执行一个写命令就会向从服务器发送相同的写命令,从服务器接收并执行收到的写命令。

小节面试分析

- redis如何支持10万+的并发?

单机的redis几乎不太可能说QPS超过10万+,除非一些特殊情况,比如你的机器性能特别好,配置特别高,物理机,维护做的特别好,而且你的整体的操作不是太复杂,一般的单机也就在几万。真正实现redis的高并发,需要读写分离。对缓存而言,一般都是用来支撑读高并发的,写的请求是比较少的,可能写请求也就一秒钟几千。读的请求相对就会比较多,例如,一秒钟二十万次读。所以redis的高并发可以基于主从架构与读写分离机制进行实现。

- Redis的replication机制是怎样的?

(1)redis采用异步方式复制数据到slave节点。

(2)一个master 节点是可以配置多个slave节点的。

(3)slave 节点做复制的时候,是不会阻塞 master 节点的正常工作的。

(4)slave 节点在做复制的时候,也不会阻塞对自己的查询操作,它会用旧的数据集来提供服务; 但是复制完成的时候,需要删除旧数据集,加载新数据集,这个时候就会暂停对外服务了。

(5)slave 节点主要用来进行横向扩容,做读写分离,扩容的slave节点可以提高读的吞吐量。

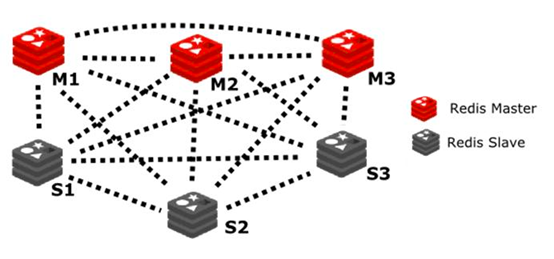

Redis哨兵模式

简介

哨兵(Sentinel)是Redis主从架构模式下,实现高可用性(high availability)的一种机制。由一个或多个Sentinel实例组成的Sentinel系统可以监视任意多个主服务器,以及这些主服务器属下的所有从服务器,并在被监视的主服务器进入下线状态时,自动将下线主服务器属下的某个从服务器升级为新的主服务器,然后由新的主服务器代替已下线的主服务器继续处理命令请求。

基本架构

哨兵快速入门

第一步:打开三个redis客户端窗口,分别进入3台redis容器内部,在容器(Container)指定目录/etc/redis中执行如下语句:

cat <<EOF > /etc/redis/sentinel.conf

sentinel monitor redis6379 172.17.0.2 6379 1

EOF

其中, 如上指令表示要的监控的master, redis6379为服务名, 172.17.0.2和6379为master的ip和端口,1表示多少个sentinel认为一个master失效时,master才算真正失效.

第二步:在每个redis容器内部的/etc/redis目录下执行如下指令,启动哨兵服务

redis-sentinel sentinel.conf

第三步:打开一个新的客户端连接窗口,关闭redis6379服务(这个服务是master服务)

docker stop redis6379

在其它客户端窗口,检测日志输出,例如

410:X 11 Jul 2021 09:54:27.383 # +switch-master redis6379 172.17.0.2 6379 172.17.0.4 6379

410:X 11 Jul 2021 09:54:27.383 * +slave slave 172.17.0.3:6379 172.17.0.3 6379 @ redis6379 172.17.0.4 6379

410:X 11 Jul 2021 09:54:27.383 * +slave slave 172.17.0.2:6379 172.17.0.2 6379 @ redis6379 172.17.0.4 6379

第四步:登陆ip为172.17.0.4对应的服务进行info检测,例如:

127.0.0.1:6379> info replication

1

\# Replication

role:master

connected_slaves:1

slave0:ip=172.17.0.3,port=6379,state=online,offset=222807,lag=0

master_failover_state:no-failover

master_replid:3d63e8474dd7bcb282ff38027d4a78c413cede53

master_replid2:5baf174fd40e97663998abf5d8e89a51f7458488

master_repl_offset:222807

second_repl_offset:110197

repl_backlog_active:1

repl_backlog_size:1048576

repl_backlog_first_byte_offset:29

repl_backlog_histlen:222779

127.0.0.1:6379>

从上面的信息输出发现,redis6381服务现在已经变为master。

Sentinel 配置进阶

对于sentinel.conf文件中的内容,我们还可以基于实际需求,进行增强配置,例如:

sentinel monitor redis6379 172.17.0.2 6379 1

daemonize yes #后台运行

logfile "/var/log/sentinel_log.log" #运行日志

sentinel down-after-milliseconds redis6379 30000 #默认30秒

其中:

1)daemonize yes表示后台运行(默认为no)

2)logfile 用于指定日志文件位置以及名字

3)sentinel down-after-milliseconds 表示master失效了多长时间才认为失效

例如: 基于cat指令创建sentinel.conf文件,并添加相关内容.

cat <<EOF > /etc/redis/sentinel.conf

sentinel monitor redis6379 172.17.0.2 6379 1

daemonize yes

logfile "/var/log/sentinel_log.log"

sentinel down-after-milliseconds redis6379 30000

EOF

哨兵工作原理分析

1)每个Sentinel以每秒一次的频率向它所知的Master,Slave以及其他 Sentinel 实例发送一个 PING 命令。

2)如果一个Redis服务距离最后一次有效回复 PING 命令的时间超过 down-after-milliseconds 选项所指定的值(这个配置项指定了需要多少失效时间,一个master才会被这个sentinel主观地认为是不可用的。 单位是毫秒,默认为30秒), 则这个Redis服务会被 Sentinel 标记为主观下线。

3)如果一个Master被标记为主观下线,则正在监视这个Master的所有 Sentinel 要以每秒一次的频率确认Master的确进入了主观下线状态。

4)当有足够数量的 Sentinel(大于等于配置文件指定的值)在指定的时间范围内确认Master的确进入了主观下线状态, 则Master会被标记为客观下线 。