Windows下安装Hadoop(引导版)

本环境只作为测试环境的搭建和学习使用

参考文档

环境:

首先确定环境为java1.8 或者hadoop适配的版本

cmd java -version查看

hadoop环境变量可以不用设置

关于hdfs的配置可以自行修改目录

具体的安装方式参考下面的两个文档

下载软件包

Hadoop3.1.0版本的安装包:https://archive.apache.org/dist/hadoop/common/hadoop-3.1.0/hadoop-3.1.0.tar.gz

Windows环境安装所需的bin文件包(我们这里选择3.1.0):

1、可以打开地址:https://gitee.com/nkuhyx/winutils ,里面选 3.1.0。

2、或者直接下载:https://gitee.com/tttzzzqqq/apache-hadoop-3.1.0-winutils

原文链接:https://blog.csdn.net/tttzzzqqq2018/article/details/131928028

注意在替换bin文件时 选择重复的文件跳过

hadoop软件包的解压方式

start winrar x -y hadoop-3.3.2.tar.gz ./

参考链接:

https://blog.csdn.net/Helen_1997_1997/article/details/136627713

配置文件

文件目录在hadoop etc下

core-site.xml

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

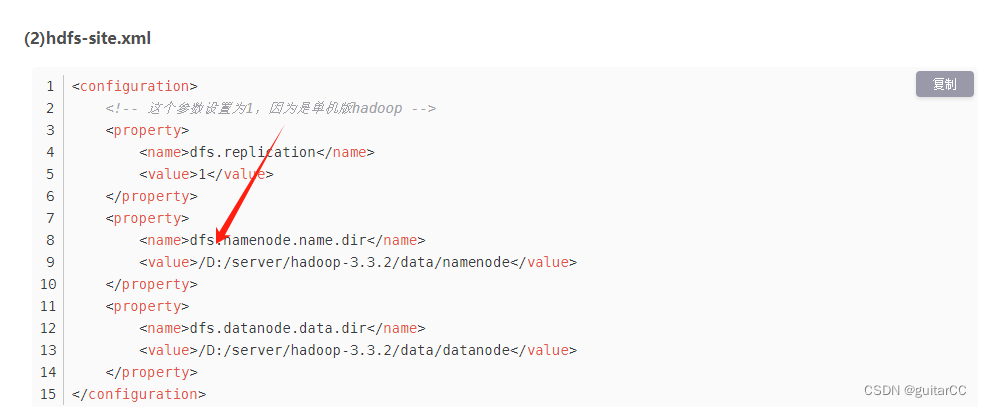

hdfs-site.xml

<configuration>

<!-- 这个参数设置为1,因为是单机版hadoop -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/D:/develop/hadoop/hadoop-3.1.0/data/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>D:/develop/hadoop/hadoop-3.1.0/data/datanode</value>

</property>

</configuration>

yarn-site.xml

注意:yarn的资源可以小一点 发现过大的资源分配启动的话 yarn页面访问不到

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hahoop.mapred.ShuffleHandler</value>

</property>

<!-- 指定ResourceManager的地址-->

<!--property>

<name>yarn.resourcemanager.hostname</name>

<value>localhost</value>

</property-->

<!-- 环境变量的继承 -->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

<!-- yarn容器允许分配的最大最小内存 -->

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>512</value>

</property>

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>4096</value>

</property>

<!-- yarn容器允许管理的物理内存大小 标配12G-->

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>4096</value>

</property>

<!--启用自动检测cpu核数-->

<!--YARN可使用的虚拟CPU个数,默认是8 此参数配合自动检测-->

<property>

<name>yarn.nodemanager.resource.cpu-vcores</name>

<value>4</value>

</property>

<!--单个任务可申请的最小虚拟CPU个数,默认是1-->

<property>

<name>yarn.scheduler.minimum-allocation-vcores</name>

<value>1</value>

</property>

<!--资源设定参数对于开启动态资源分配的设定无效-->

<!--单个任务可申请的最多虚拟CPU个数,默认是4) 指定为8核心-->

<property>

<name>yarn.scheduler.maximum-allocation-vcores</name>

<value>4</value>

</property>

<!-- 关闭yarn对物理内存和虚拟内存的限制检查 -->

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置日志保留时间为7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>hdfs://localhost:9001</value>

</property>

</configuration>

workers

localhost

hadoop-env.cmd

@rem The java implementation to use. Required.

set JAVA_HOME=D:\develop\java\jdk1.8.0_202

hadoop-env.sh

export JAVA_HOME=D:\develop\java\jdk1.8.0_202

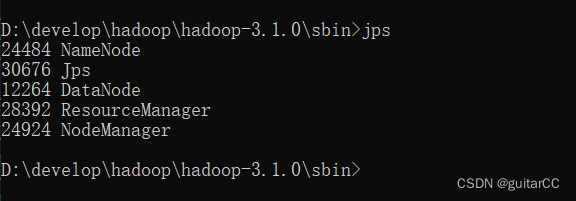

查看服务状态

使用jps

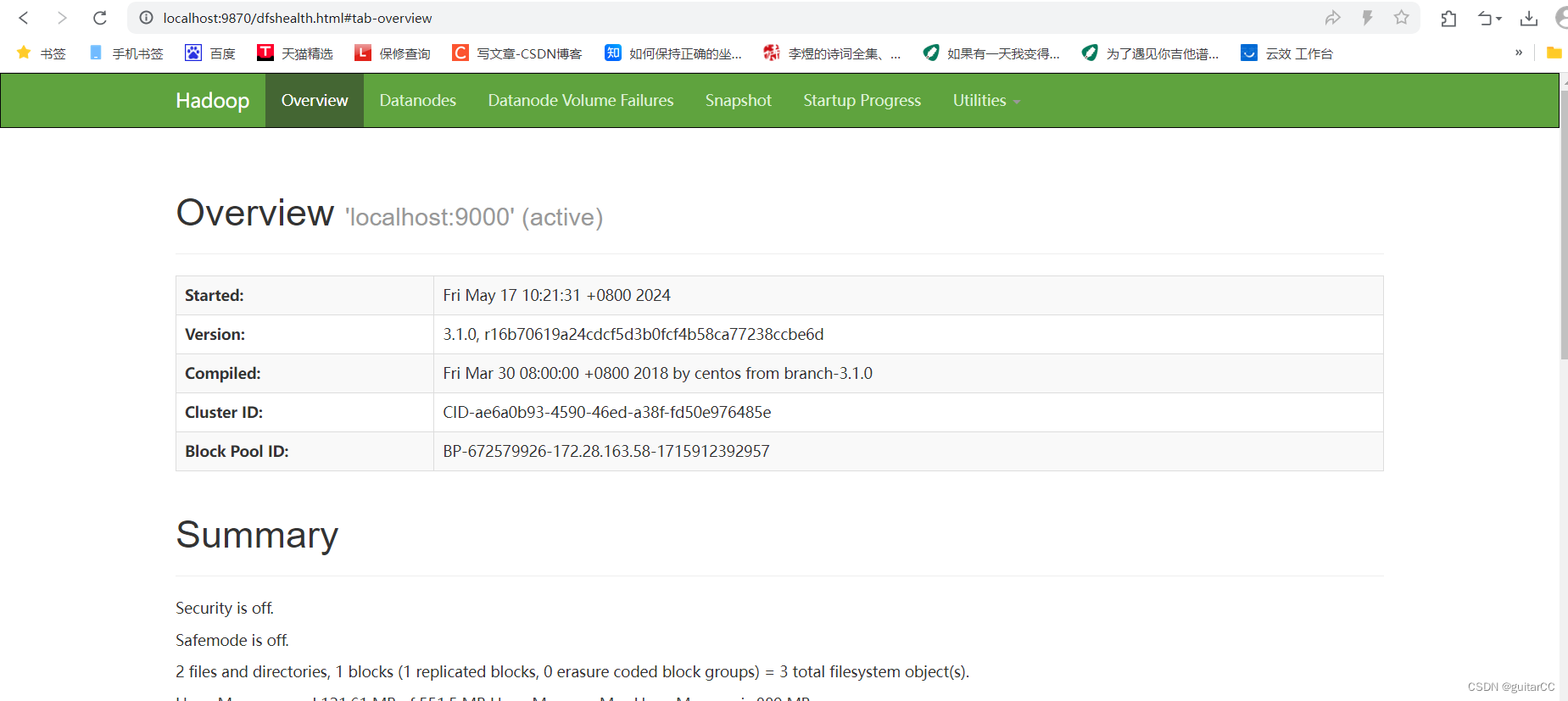

hdfs页面

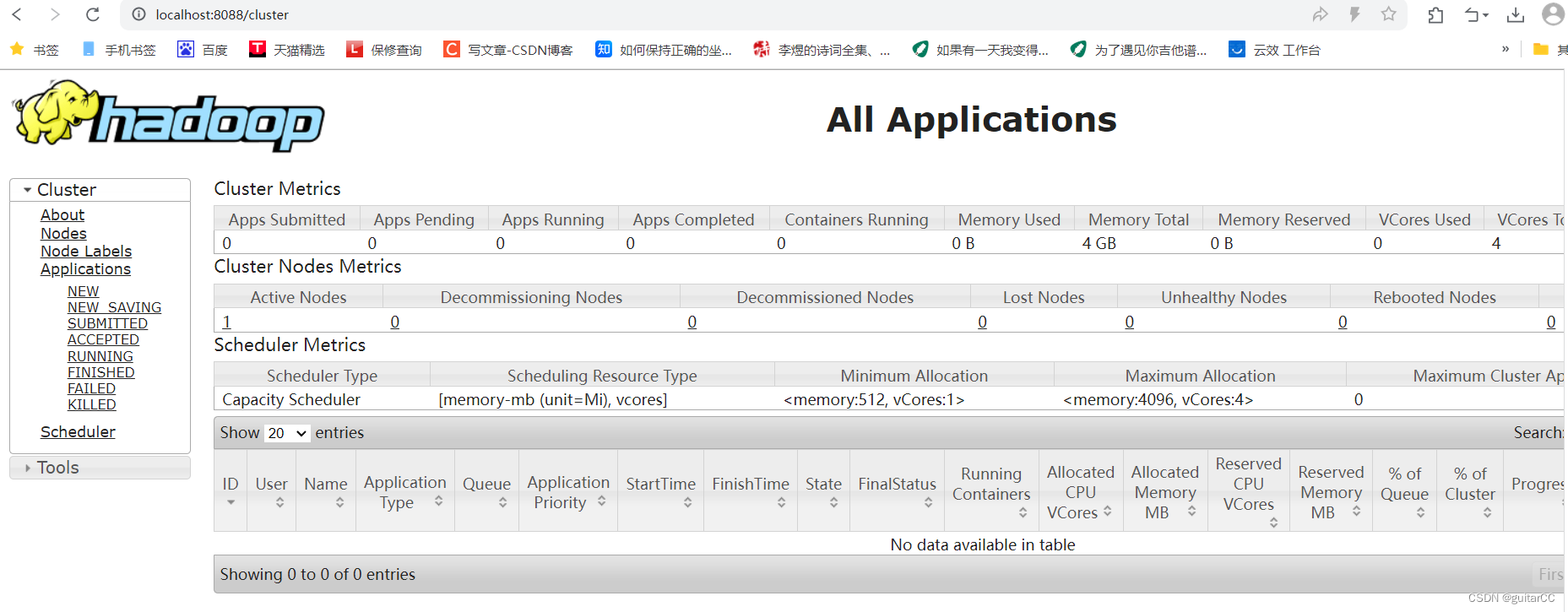

yarn页面

出现的报错和解决

Exception in thread “main” java.lang.IllegalArgumentException: Invalid URI for NameNode address (check fs.defaultFS): file:/// has no authority.

启动不了nameNode,解决方法:

在hadoop文件夹\hadoop-3.0.2\etc\hadoop\core-site.xml的标签下,添加如下内容

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

原文链接:https://blog.csdn.net/qq_37475168/article/details/90749924

有时候启动或者初始化元数据 会出现目录无法识别的状况

可以把D前面的/删除试一试

要查看报错内容

170

170

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?