爬虫功能

爬虫模块用于爬取网站的每个页面内容,并生成网站地图

在control界面中可以启动爬虫功能,查看爬虫状态

control

spider status爬虫状态

点击Spider is paused开启爬虫功能,在使用爬虫功能之前,需要先设置代理,并获取域名

想使用和控制spider的话先去target界面的site map那然后右击需要的节点选择spider this host/branch

查看爬虫状态,显示了

requests made已完成的请求数,表示已完成的请求数

bytes transferred字节传递数表示已传递的字节数

requests queued请求等待数,表示未完成的请求数

forms queued表单等待数,表示未完成的表单数

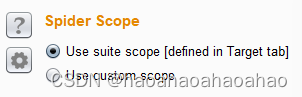

spider scope设置爬虫作用域,就是设置爬虫目标。use suite scope [defined in target tab]可以使用target模块的作用域,use custom scope还可以用自定义目标。

options

爬虫范围

crawier Settings 爬取设置

这些设置控制着spider为基本web内容爬的方式

check robots.txt:检查robots.txt文件,check robots.txt是一个标准的网络协议,用于指导搜索引擎爬虫哪些页面可以抓取,哪些页面应该避免。

detect custom “not found” responese:检测’not found’响应,检测自定义的404页面或其他未找到页面。

ignore links to non-text content:忽略非文本内容的连接,选这个那么spider不会请求非文本资源。(如图片、视频、PDF等)对于渗透测试和漏洞探测而言,关注文本内容因为文本内容可能包含敏感信息、漏洞点或其他重要信息。通过忽略非文本内容的链接,spider更好专注地爬取和分析文本内容。

request the root of all directories:请求所有的根目录。请求所有已确认的目标范围内的 web 目录,如果在这个目标站点存在目录遍历, 这选项将是非常的有用。

make a non-parameterized request to each dynamic page:对每个动态页面进行非参数化的请求。动态页面是指在用户请求时,服务器通过处理脚本或程序生成页面内容。那么相对的是静态页面,静态页面是在服务器上创建好的,用户请求时直接返回。非参数请求是指在请求中不包含特定的参数。用简单的方式来看看动态页面是否存在一些基本的配置问题。

passive spidering

被动扫描

被动爬虫功能通过burp proxy来更新站点地图,而无需重发新的请求

passively spider as you browse:浏览时被动爬虫

link depth to associate with proxy requests:链接深度与proxy请求关联,控制爬虫的深度以便关注特定链接控制所需要的任务。

form submission表单提交

这些设置控制spider是否如何提交HTML表单

individuate forms:个性化的格式。这个选项是配置(URL,方法,区域,值)。

don’t submit forms:开启后spider不提交任何表单。

prompt for guidance:提醒向导,控制是否显示提示信息,点击后add,edit,remove,up,down选项变灰不可选。

automatically submit:自动提交,通过proxy拦截请求,无需用户手动干预。

那么enabled启用 match type匹配种类(regex正则表达式匹配)field name字段名、filed value字段值确保爬重要信息

那么application login应用程序登录

这些设置控制蜘蛛提交登陆表单的方式

don’t submit login forms:不提交登录表单。开启后burp不提交登录表单。

prompt for guidance:提示向导。为你提示引导。默认设置项。

handle as ordinary forms:以一般格式处理。通过你配置的信息和自动填充规则,用处理其他表单的方式来处理登陆表单。

automatically submit these credentials:自动提交自定义的数据。开启后burp遇到登录表单会按照设定的值进行提交。

spider engine

蜘蛛引擎

这些设置控制用于在爬发出HTTP请求的引擎。

number of threads:设置请求线程,控制并发请求数。

number of retries on network failure: 如果出现了网络故障,重试的请求指定的次数。

pause before retry:网络故障重试失败的请求,重试前暂停的时间

Throttle between requests:请求之间的时间间隔。避免超载了应用程序。

request headers

请求头

这些控制用蜘蛛的HTTP请求头

3390

3390

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?