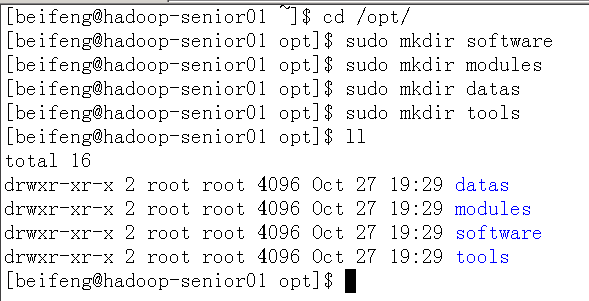

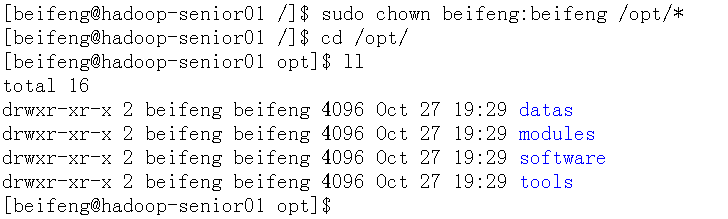

- 对于 Linux 系统的目录进行规划

a. 配置目录

b. 更改所属用户与用户组

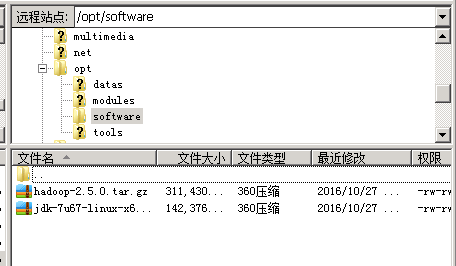

- 使用FileZilla上传所需要的安装包到software目录(hadoop-2.5.0 ,jdk7.67)

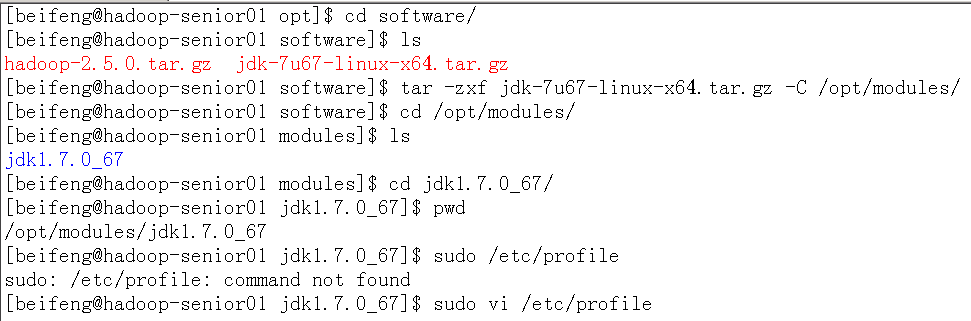

解压 JDK 配置环境变量

- 解压:

tar -zxf jdk-7u67-linux-x64.tar.gz -C /opt/modules/

写入 Java 环境变量:

sudo vi /etc/profile##JAVA_HOME export JAVA_HOME=/opt/modules/jdk1.7.0_67 export PATH=$PATH:$JAVA_HOME/bin让文件生效:

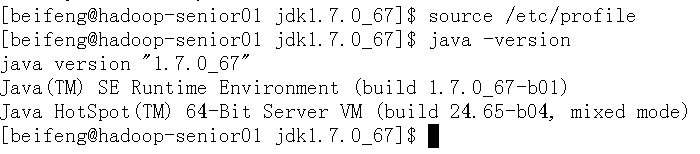

source /etc/profile- 验证:

java -version

- 解压:

解压安装 Hadoop-2.5.0

- 解压:

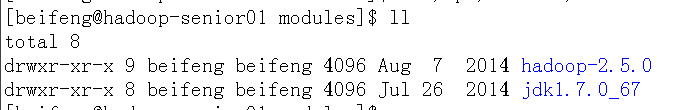

tar -zxf hadoop-2.5.0.tar.gz -C /opt/modules/

有时需要赋权限:sudo chown -R beifeng:beifeng /opt/modules/hadoop-2.5.0 - 如果磁盘空间较为紧张可以删除 share/doc 目录,存放的都是官方英文说明文档:

rm -rf ./doc/

- 解压:

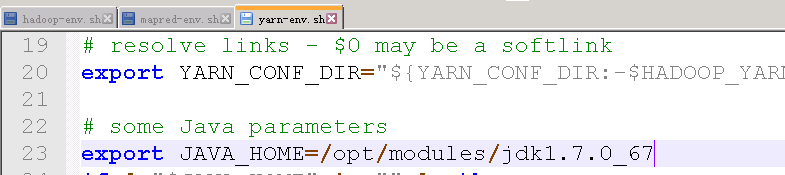

设置 Java 的安装目录

通过Notepad++设置配置文件: etc/hadoop/*-env.sh(三个文件都要设置)(hadoop-env.sh,mapred-env.sh,yarn-env.sh)

export JAVA_HOME=/opt/modules/jdk1.7.0_67

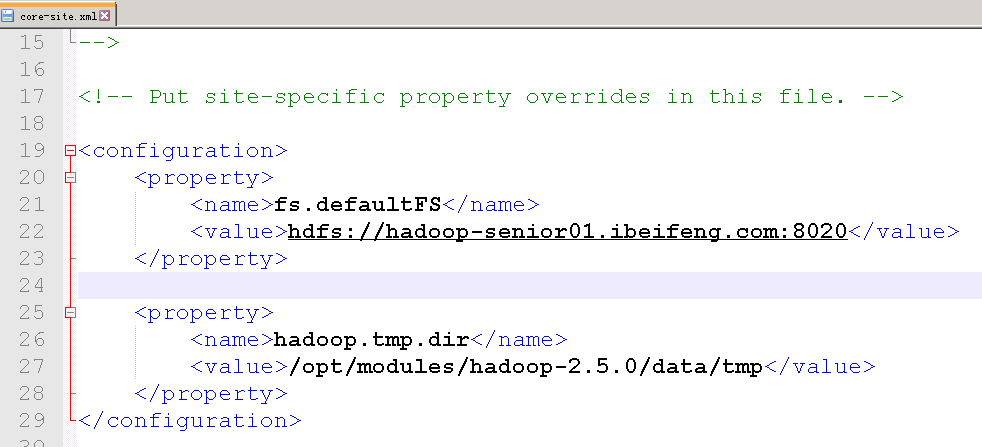

- 配置*-site.xml 自定义配置文件(core-site.xml)

- 指定 namenode 主节点所在的位置以及交互端口号

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop-senior01.ibeifeng.com:8020</value>

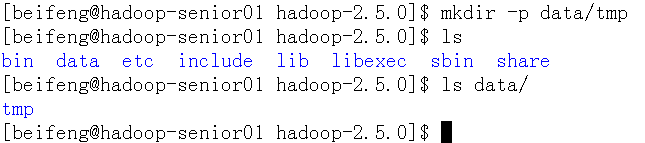

</property> - 更改 hadoop.tmp.dir 的默认临时目录路径,先创建一个存储数据的临时目录

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/modules/hadoop-2.5.0/data/tmp</value>

</property>

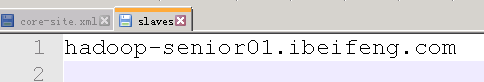

- 指定 datanode 从节点所在的位置,slaves 文件配置

hadoop-senior01.ibeifeng.com

注意 slaves 既代表 DataNode 又代表 NodeManager - 指定副本个数

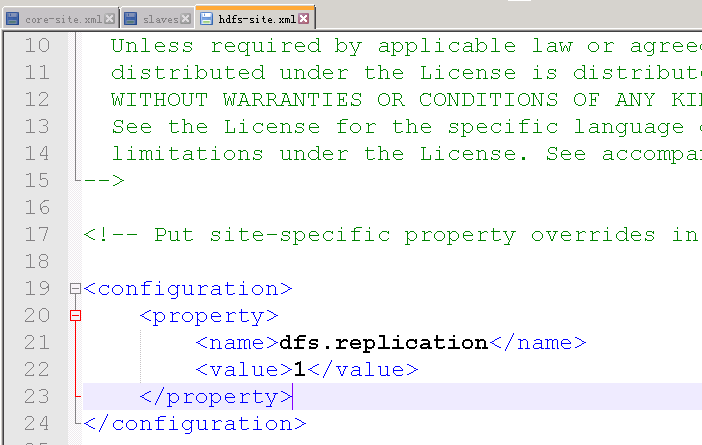

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

- 指定 namenode 主节点所在的位置以及交互端口号

- 对于 NameNode 进行格式化操作

$ bin/hdfs namenode -format

建议:只需要一次格式化,多次格式化会出错

如果出错需要删除 data/tmp 下的 dfs 目录 - 启动相关的服务进程

$ sbin/hadoop-daemon.sh start namenode

$ sbin/hadoop-daemon.sh start datanode

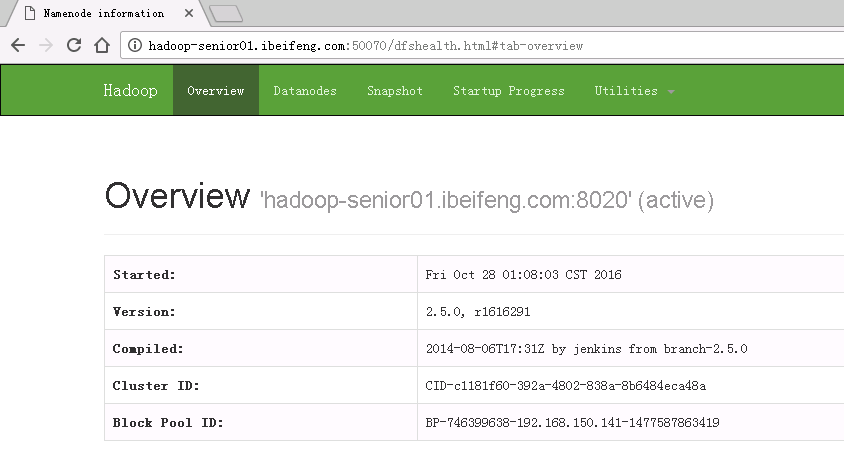

- 通过 web 浏览器加上 50070 端口号访问管理界面

50070端口 :http://hadoop-senior01.ibeifeng.com:50070

对于 HDFS 文件系统进行读写上传下载测试

在HDFS中创建目录:$ bin/hdfs dfs -mkdir -p tmp/conf --相对路径,用户主目录下上传本地文件文件到HDFS

$ bin/hdfs dfs -put etc/hadoop/core-site.xml /user/beifeng/tmp/conf打开HDFS中文件

$ bin/hdfs dfs -cat /user/beifeng/tmp/conf/core-site.xml下载HDFS文件到本地

$ bin/hdfs dfs -get /user/beifeng/tmp/conf/core-site.xml /home/beifeng/bf-site.xml指定SecondaryNameNode所在机器位置以及WEB浏览器交互端口号

配置文件:/opt/modules/hadoop-2.5.0/etc/hadoop/hdfs-site.xml

<property> <name>dfs.namenode.secondary.http-address</name> <value>hadoop-senior01.ibeifeng.com:50090</value> </property>启动:

sbin/hadoop-daemon.sh start secondarynamenode

- 等

HDFS 配置、启动命令、测试命令

最新推荐文章于 2024-10-11 10:14:45 发布

1324

1324

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?