XPath的使用点击跳转

使用Beautiful Soup4从HTML源代码中提取有用的信息

简介

BeautifulSoup4(BS4)是Python的一个第三方库,用来从HTML和XML中提取数据。

BeautifulSoup4在某些方面比XPath易懂,但是不如XPath简洁,而且由于它是使用Python开发的,因此速度比XPath慢。

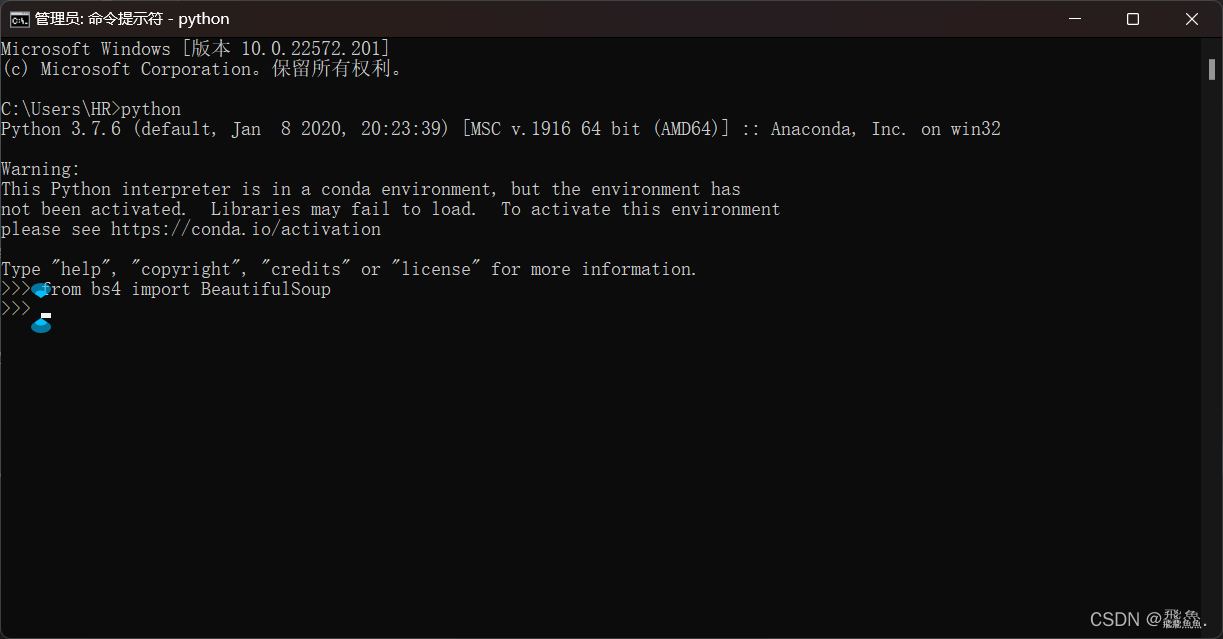

使用pip命令安装:pip install beautifulsoup4

安装后,切换到Python的交互窗口,输入from bs4 import BeautifulSoup,如果没有报错则说明安装成功

语法讲解

使用Beautiful Soup4提取HTML内容,一般要经过以下两步。

- 处理源代码生成

BeautifulSoup对象。 - 使用

find_all()或者find()来查找内容。

源代码解析

- 解析源代码生成

BeautifulSoup对象,使用以下的代码格式soup = BeautifulSoup(网页源代码,'解析器') - 这里的解析器可以写成

html.parser,如果你安装了lxml,还可以写成lxmlsoup = BeautifulSoup(source, 'lxml') soup = BeautifulSoup(source, 'html.parser')

find和find_all

find和find_all的区别就是前者会返回第一个满足条件的数据,后者返回全部满足条件的数据

查找内容

-

查找内容的基本流程和使用

XPath非常相似。首先要找到包含特殊属性值的标签,并使用这个标签来寻找内容。 -

假设需要获取“我需要的信息2”,由于这个信息所在

< li >标签的class属性的值为“test”,这个值本身就很特殊,因此可以直接通过这个值来进行定位.from bs4 import BeautifulSoup source = ''' <html> <head> <title>测试</title> </head> <body> <div class="useful"> <ul> <li class="info">我需要的信息1</li> <li class="test">我需要的信息2</li> <li class="iamstrange">我需要的信息3</li> </ul> </div> <div class="useless"> <ul> <li class="info">垃圾1</li> <li class="info">垃圾2</li> </ul> </div> </body> </html> ''' soup = BeautifulSoup(source, 'lxml') # soup = BeautifulSoup(source, 'html.parser') info = soup.find(class_

本文介绍了如何使用BeautifulSoup4从HTML中高效提取信息,包括find和find_all方法的应用,以及如何通过CSS选择器(select)进行更灵活的标签定位。同时,讨论了XPath和BeautifulSoup4之间的区别,以及如何处理class和id属性搜索。

本文介绍了如何使用BeautifulSoup4从HTML中高效提取信息,包括find和find_all方法的应用,以及如何通过CSS选择器(select)进行更灵活的标签定位。同时,讨论了XPath和BeautifulSoup4之间的区别,以及如何处理class和id属性搜索。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

56万+

56万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?