TinyNeuralNetwork:开启AI模型压缩新纪元

在人工智能快速发展的今天,深度学习模型的规模越来越大,计算复杂度也越来越高。如何将这些庞大的模型高效地部署到资源受限的终端设备上,成为了一个亟待解决的难题。为此,阿里巴巴开源了一个名为TinyNeuralNetwork的深度学习模型压缩框架,旨在帮助开发者更加便捷高效地实现模型压缩与部署。

什么是TinyNeuralNetwork?

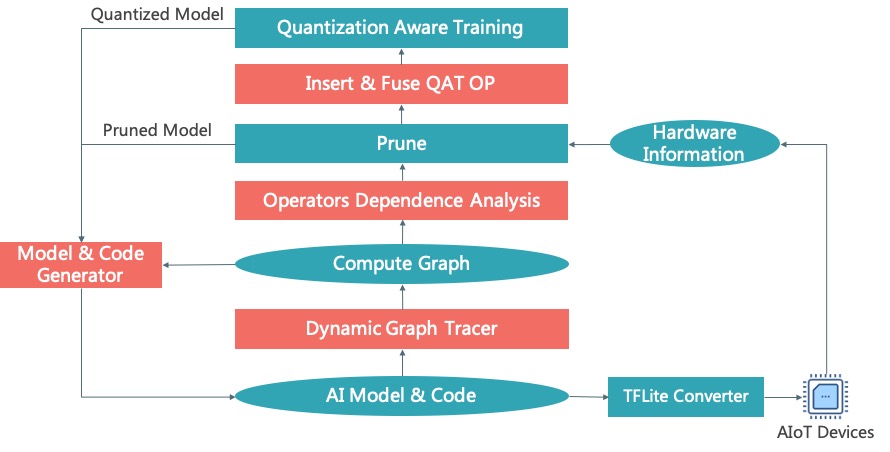

TinyNeuralNetwork是一个高效且易用的深度学习模型压缩框架,包含了神经网络架构搜索、剪枝、量化、模型转换等多种功能。该框架已经在天猫精灵、海尔电视、优酷视频、人脸识别打卡机等超过1000万台IoT设备上实现了AI能力的部署,充分验证了其在实际应用中的价值。

TinyNeuralNetwork的主要特性

-

计算图捕获: TinyNeuralNetwork中的Graph Tracer可以捕获PyTorch算子的连接关系,实现了剪枝和模型量化的自动化。它还支持从PyTorch模型生成等效的模型描述文件(如models.py)。

-

依赖关系解析: 修改一个算子通常会导致子图的不匹配,即与其他依赖算子的不匹配。TinyNeuralNetwork中的Graph Modifier可以自动处理子图内部和子图之间的不匹配,从而实现计算图的自动化修改。

-

剪枝器: TinyNeuralNetwork实现了多种剪枝算法,包括OneShot (L1, L2, FPGM)、ADMM、NetAdapt、Gradual、End2End等,这些算法将逐步开放。

-

量化感知训练: TinyNeuralNetwork使用PyTorch的QAT作为后端(同时支持模拟bfloat16训练),并通过自动化算子融合和计算图量化来优化其可用性。这大大减轻了用户的工作负担,因为官方实现需要用户手动实现,这是一项巨大的工作量。

-

模型转换: TinyNeuralNetwork支持将浮点和量化后的PyTorch模型转换为TFLite模型,实现端到端部署。

如何使用TinyNeuralNetwork?

要使用TinyNeuralNetwork,首先需要确保您的环境满足以下要求:

- Python >= 3.8

- PyTorch >= 1.4 (如果涉及量化感知训练,则需要PyTorch >= 1.6)

安装TinyNeuralNetwork非常简单,您可以通过以下命令进行安装:

git clone https://github.com/alibaba/TinyNeuralNetwork.git

cd TinyNeuralNetwork

python setup.py install

或者,您也可以使用pip一键安装:

pip install git+https://github.com/alibaba/TinyNeuralNetwork.git

此外,TinyNeuralNetwork还提供了Docker构建选项:

sudo docker build -t tinynn:pytorch1.9.0-cuda11.1 .

TinyNeuralNetwork的项目结构

TinyNeuralNetwork的项目结构清晰明了,主要包含以下几个部分:

- examples: 提供各个模块的使用示例

- models: 提供预训练模型,方便快速入门

- tests: 单元测试

- tinynn: 模型压缩的核心代码

- graph: 计算图捕获、解析、量化、代码生成、掩码管理等基础功能

- prune: 剪枝算法

- converter: 模型转换器

- util: 实用工具类

TinyNeuralNetwork的未来发展

TinyNeuralNetwork团队已经制定了明确的发展路线图:

- 2021年11月: 推出具有自适应稀疏性的新剪枝器

- 2021年12月: 实现Transformer模型的压缩

这些计划显示了TinyNeuralNetwork团队对持续改进和扩展框架功能的承诺。

为什么选择TinyNeuralNetwork?

-

高效易用: TinyNeuralNetwork提供了一套完整的模型压缩解决方案,从计算图捕获到模型转换,全流程自动化,大大提高了开发效率。

-

功能丰富: 框架集成了多种先进的剪枝算法和量化技术,满足不同场景下的模型压缩需求。

-

实践验证: TinyNeuralNetwork已在超过1000万台IoT设备上成功部署,其有效性和可靠性得到了充分验证。

-

持续更新: 开发团队持续推出新功能,如自适应稀疏剪枝器和Transformer模型压缩,保持框架的先进性。

-

开源社区支持: 作为开源项目,TinyNeuralNetwork欢迎社区贡献,这有助于框架的持续改进和发展。

如何参与贡献?

TinyNeuralNetwork是一个开源项目,欢迎社区成员参与贡献。如果您对改进框架感兴趣,可以查看贡献指南了解更多详情。

常见问题解答

考虑到PyTorch的高复杂性和频繁更新,TinyNeuralNetwork团队无法通过自动化测试覆盖所有情况。如果您在使用过程中遇到问题,可以查看FAQ文档或加入钉钉群进行咨询。

结语

TinyNeuralNetwork作为一个高效、易用的深度学习模型压缩框架,为解决AI模型在资源受限设备上的部署问题提供了一个强有力的工具。无论您是AI研究人员、工程师还是开发者,TinyNeuralNetwork都能帮助您更轻松地实现模型压缩和部署。随着AI技术的不断发展和IoT设备的普及,TinyNeuralNetwork必将在未来的AI生态系统中发挥越来越重要的作用。

如果您在研究中使用了TinyNeuralNetwork,欢迎引用以下信息:

@misc{tinynn,

title={TinyNeuralNetwork: An efficient deep learning model compression framework},

author={Ding, Huanghao and Pu, Jiachen and Hu, Conggang},

howpublished = {\url{https://github.com/alibaba/TinyNeuralNetwork}},

year={2021}

}

让我们共同期待TinyNeuralNetwork为AI模型压缩和部署带来的更多可能性,推动人工智能技术在更广泛领域的应用与发展。

文章链接:www.dongaigc.com/a/tiny-neural-network-alibaba-efficient-deep-learning

https://www.dongaigc.com/a/tiny-neural-network-alibaba-efficient-deep-learning

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?