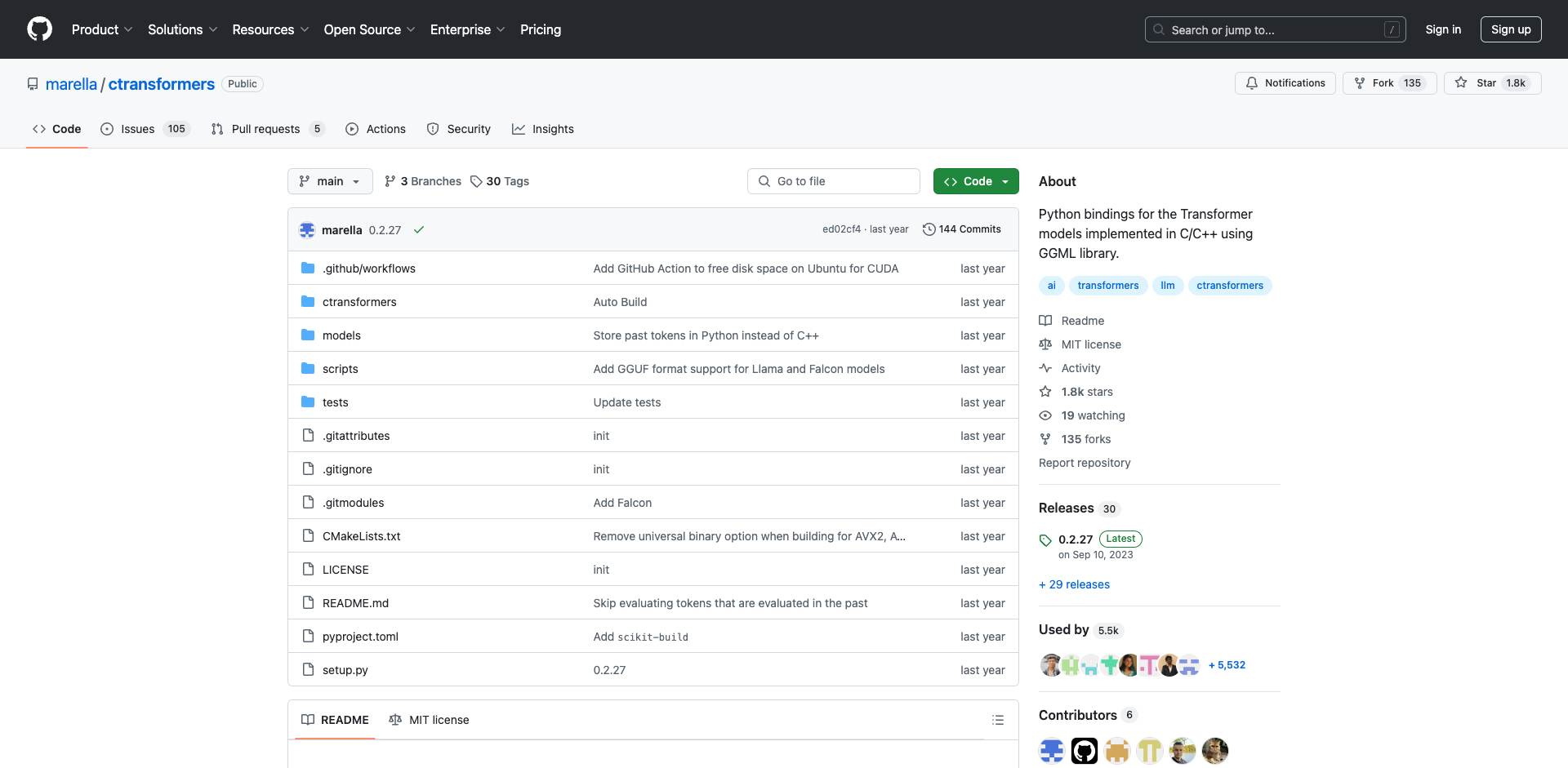

CTransformers简介

CTransformers是一个为C/C++实现的Transformer模型提供Python绑定的开源库。它基于GGML库构建,旨在为开发者提供一种高效且易用的方式来在Python中使用各种流行的语言模型。

这个库的主要特点包括:

- 支持多种流行的语言模型,如GPT-2、LLaMA、Falcon等

- 提供统一的简单API接口

- 支持GPU加速(CUDA和Metal)

- 与Hugging Face Transformers和LangChain集成

- 支持流式输出和嵌入计算

CTransformers的出现为NLP开发者提供了一个强大的工具,使他们能够更方便地在Python项目中利用高性能的语言模型。

支持的模型

CTransformers支持多种主流的语言模型,包括:

- GPT-2

- GPT-J / GPT4All-J

- GPT-NeoX / StableLM

- Falcon

- LLaMA / LLaMA 2

- MPT

- StarCoder / StarChat

- Dolly V2

- Replit

对于不同的模型,CTransformers提供了统一的接口,使开发者可以轻松切换和使用不同的模型。

值得注意的是,部分模型如Falcon、LLaMA、MPT等还支持CUDA加速,LLaMA还支持Metal加速,这为需要高性能计算的应用提供了选择。

安装和基本使用

安装CTransformers非常简单,只需要一行pip命令:

pip install ctransformers

安装完成后,就可以使用以下代码来加载和使用模型:

from ctransformers import AutoModelForCausalLM

# 从本地文件加载模型

llm = AutoModelForCausalLM.from_pretrained("/path/to/ggml-model.bin", model_type="gpt2")

# 生成文本

print(llm("AI is going to"))

# 流式输出

for text in ll

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?