一、以下是大家可能会遇到的常见问题:

1.是否遗漏了前置准备的相关操作配置?

2.是否遗的将文件夹(Hadoop安装文件夹,/data数据文件夹)chown授权到hadoop用户这个操作

3.是否遗忘了格式化hadoop这一步(hadoop namenode -format)

4.是否是以root用户格式化hadoop

5.是否以root启动hadoop,后续以hadoop用户启动会出错

6.是否确认workers文件内,配置了root1,root2,root3三个节点

7.是否在/etc/profile内配置了HADOOP_HOME环境变量,并将$HADOOP_HOME/bin和$HADOOP_HOME/sbin加入到PATH变量中

8.是否遗忘了软链接,但环境变量配置的HADOOP_HOME的确是:/export/server/hadoop

9.是否确认配置文件内容的准确(一个字符都不能错),并确保三台机器的配置文件都ok

kall清除进程

kall 123,清除进程编号为123的进程

1.1、权限问题Permission denied(权限被拒绝)

hadoop安装文件夹或/data文件夹,未授权给hadoop用户,所以无权限操作

所有的Permission denied提示,都是权限导致的

换用户启动之后需要删除之前的一些文件./data/nn/*,/data/dn/*

然后使用kall关闭进程

之后还要把文件权限换回来

1.2、环境变量Command not found

没有配置好环境变量,导致

/export/server/hadoop/bin/hadoop

/export/server/hadoop/sbin/start-dfs.sh & /export/server/hadoop/sbin/stop-dfs.sh

这些命令或脚本无法直接执行

1.3、workers文件,启动后仅root1有进程Root2,root3无反应

检查,是否workers文件内有没有正确配置

Start-all.sh脚本的执行流程会是

在当前机器启动Secondarynamenode,并且根据core-site.xml的记录启动namenode

根据workers文件的记录,启动各个datanode

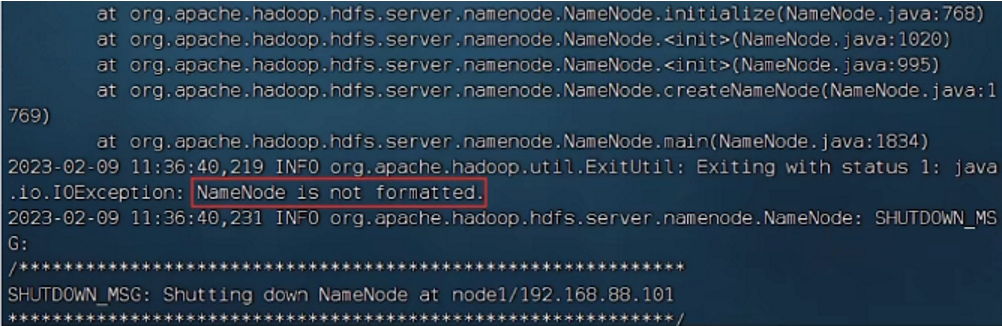

1.4、未格式化,启动后,root1无namenode,仅有datanode和secondarynamenode,Root2,root3无反应

start-all.sh脚本为报错

查看日志namenode日志(/export/server/hadoop/logs/hadoop-hadoop-namenode-node1.log)提示namenode未格式化

1.4、配置文件错误WstxEOFFxception,Unexpected EOF

配置文件有问题,仔细检查每一个字符

7035

7035

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?