平台信息

创建用户,并切换

useradd hadoop

su hadoop

cd ~下载镜像

镜像下载地址

https://mirrors.bfsu.edu.cn/apache/hadoop/core/hadoop-3.3.1/hadoop-3.3.1-aarch64.tar.gz

多线程下载指令

axel -n 800 https://mirrors.bfsu.edu.cn/apache/hadoop/core/hadoop-3.3.1/hadoop-3.3.1-aarch64.tar.gz解压

tar -xvf hadoop-3.3.1-aarch64.tar.gz

cd hadoop-3.3.1单机伪集群配置

vim etc/hadoop/core-site.xml<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>vim etc/hadoop/hdfs-site.xml<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/hadoop/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/hadoop/datanode</value>

</property>

</configuration>启动hdfs服务

声明环境变量

export JAVA_HOME=/usr/lib/jvm/java-1.8.0格式化namenode

# 格式化namenode

./bin/hdfs namenode -format注意观察/home/hadoop/namenode中已产生数据文件

配置ssh免密登录

ssh-keygen

ssh-copy-id hadoop@localhost

启动存储服务

./sbin/start-dfs.sh查看进程状态

jps -lv

netstat -lnetp | grep java

基准测试

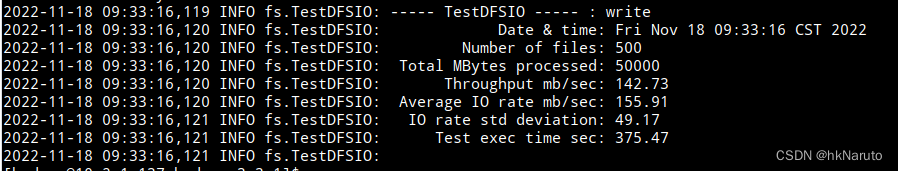

TestDFSIO 吞吐性能测试

./bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.3.1-tests.jar TestDFSIO -write -nrFiles 500 -size 100MB -bufferSize 8388608 -resFile /tmp/testDFSIOwrite.log期间简单监控指令

vmstat -w -t 1

默认情况下的测试结果

附:麒麟云主机8C4G测试结果

622

622

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?