使用python实现爬虫的方式很多,典型的有urllib配合BeatifulSoup,代码也很简单,不过威力有限只适合入门尝鲜,想要真正收集大量有用数据拿来做数据分析就略感力不从心,这时不得不提scrapy了,一个专业的爬虫框架。看了网上很多的入门教程,很多都难以跑通,毕竟链接变化很快,如果不系统了解其原理,很难更正回来。所以本篇还是从一个成功的案例记录下,方便爱学习的你我他。

(一)首先要确定安装好了相应环境

安装scrapy,建议命令安装,pip install scrapy

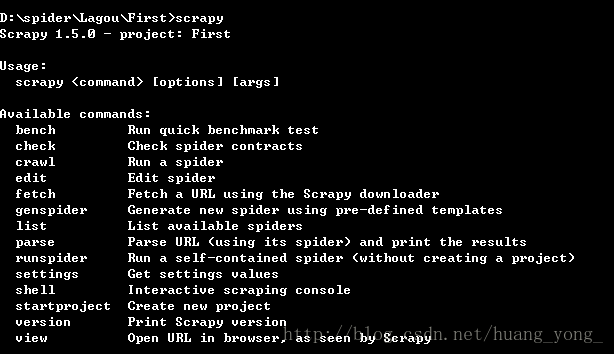

确定环境安装好了,随意新建一个文件夹,按shift和鼠标右键,在当前位置打开命令行,输入scrapy,如果有帮助提示,则说明环境安装成功,如图:

(二)环境安装好了之后,新建工程:

我在D盘下spider目录里新建了个文件夹作为我们的新工程,取名Lagou,当然名字随便起,然后进去,在当前位置打开命令行后,输入:

scrapy startproject First

这时会生成一堆文件,先不管都是干什么的,已创建了名为First的爬虫工程。

根据命令提示,cd进到First文件夹,继续输入:

scrapy genspider second lagou

这句命令会帮助我们生成需要的写代码的文件,也是爬虫文件,我们主要在这个里面写代码,这句命令生成了一个爬虫,名为second。后面的lagou是需要爬取的域名信息,可以暂时随意填,待会进入代码还要修改,不用纠结。

(三)打开IDE,我用的是pyCharm,不用多说,

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1640

1640

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?