目录

第一章 绪论

1.1信息论的形成和发展

通信系统的中心问题就是在噪声下如何有效而可靠地传送信息以及实现这一目标的方法是编码等-----《通信的数学理论》香农

信息率失真理论是数据压缩的数学基础。

按照信息论或控制论的观点,在通信和控制系统中传送的本质内容是信息,系统中实际传输的则是测量的信号,信息包含在信号之中,信号是信息的载体。信号到了接收端(信息论里称为信宿)经过处理变成文字、语声或图像,人们再从中得到有用的信息。在接收端将含有噪声的信号经过各种处理和变换,从而取得有用信息的过程就是信息提取,提取有用信息的过程或方法主要有检测和估计两类。载有信息的可观测、可传输、可存储及可处理的信号均称为数据。

1.2 通信系统的模型

信源编码器:把信源发出的消息变换成由二进制码元(多进制码元)组成的代码组,即基带信号。同时可以压缩信源的冗余度,以提高传输效率。(无失真信源编码和限失真编码)

信源译码器:是信源编码器的逆过程。

信道编码器:信源编码器输出的代码组上,增加具有检错或纠错能力的监督码元。(调制解调和纠错检错编译码)

信道译码器:信道编码器的逆过程。

第二章 信源及信息熵

2.1 信源的描述和分类

离散信源:时间和幅度都是离散分布的,例如,文字、数字、数据。

连续信源:时间和幅度都是连续分布的,例如,语言、图像、图形等。

离散信源进一步分为:

2.2 离散信源熵和互信息

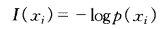

自信息量:

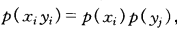

底数为2时,单位为bit;底数为e时,单位为nat;底数为10时,单位为det。

随机事件的不确定度(特性)在数值上等于它的自信息量(发生后给予观察者的信息量),两者单位相同,但是含义不同。

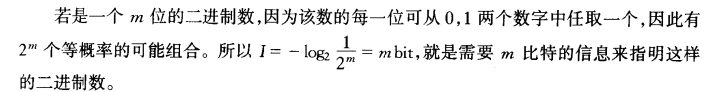

联合自信息量:

如果xy独立,则

因此,

如果xy不独立,可用条件自信息量:

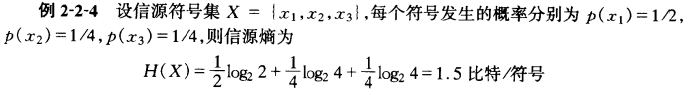

信息熵(平均自信息量(含义不同,数值相等)、信源的平均不确定度):单位为bit/符号

条件熵:

给定yi(已知yi后,X的不确定度):

给定Y(各个yi)(已知各个yi后,X的不确定度):

给定X(各个xi)(已知各个xi后,Y的不确定度):

联合熵(表示XY同时发生的不确定度):

关系:

互信息(定义为后验概率与先验概率的比值的对数):

X与yi间的互信息:

平均互信息(收到Y后能获得的X的信息):

关系:

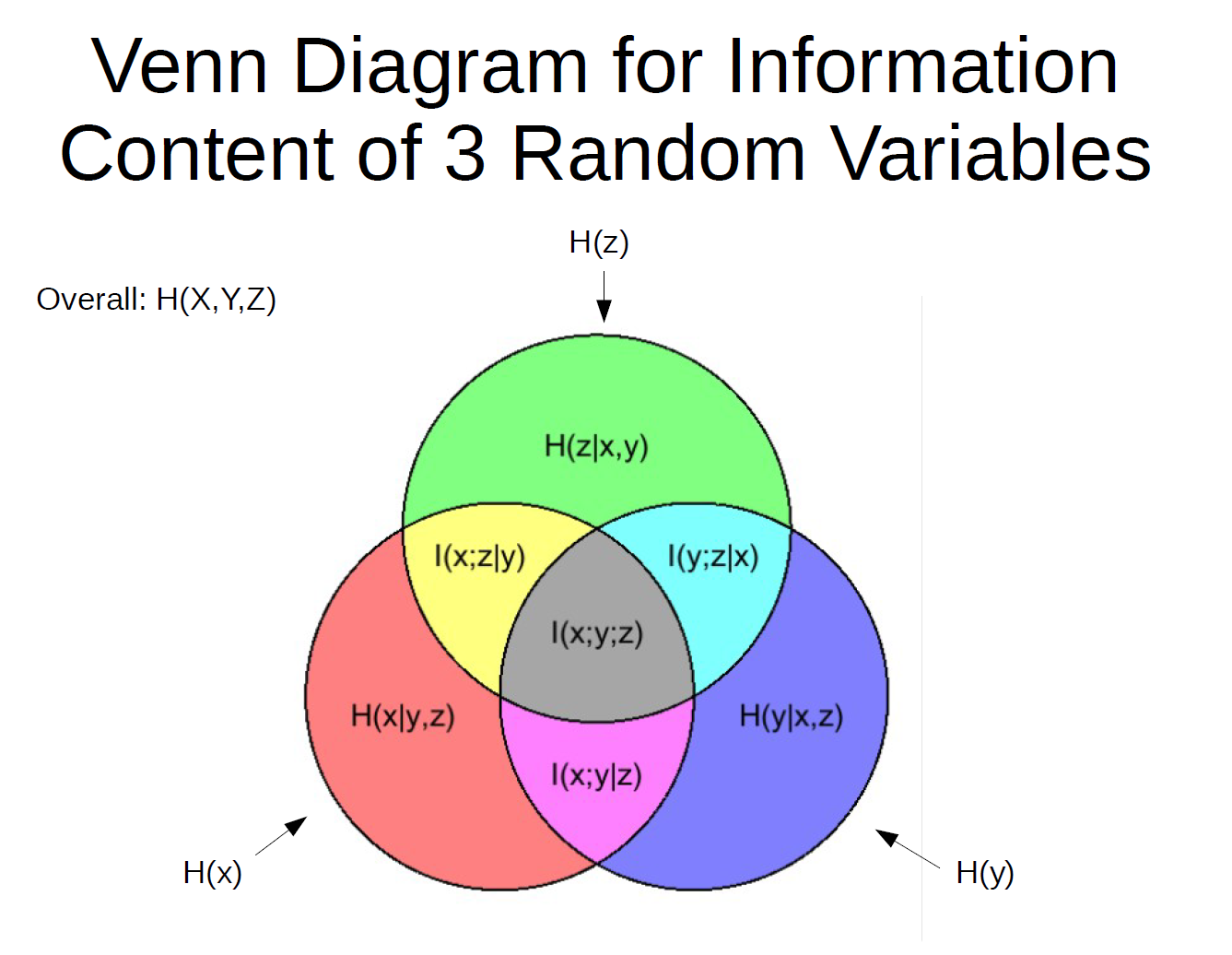

三个事件,xyz:

熵的性质:

1.非负性

2.对称性

3.确定性

4.香农辅助定理

对于两个概论分布pi和qi,如下等式成立:

即,对任意概论分布pi,它对其他概率分布qi的自信息量-logqi取数学期望时,一定不小于pi本身的熵。只有当P=Q时,等号成立。这可以利用差值来验证分布是否相同(相对熵/KL散度)。

5.最大熵定理

只有等概率时,熵最大。

6.条件熵<无条件熵

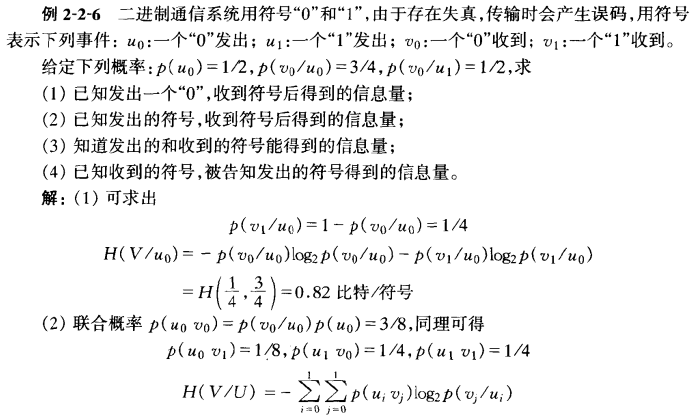

例题:

2.3 连续信源的熵和互信息

连续信源熵(有相对意义,而不是绝对值):

此外,

最大熵定理

对于连续信源的最大熵定理,必须加以限制:

限峰功率最大熵定理:(信源X的幅度限制在[a,b]内)对于定义域为有限的情况,同离散信源,当它是平均分布时,具有最大熵。

限平均功率最大熵定理:对于相关矩阵一定的X,当它是正态分布时具有最大熵。

(可以证明,在正态分布下,熵(相对熵)仅与方差有关。这也是为什么噪声设计为高斯白噪声的原因,因为这是最坏的条件。)

2.4 离散序列信源的熵

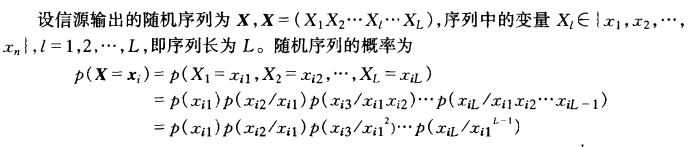

通常情况下消息不是单个符号,而是离散序列的形式:

当无记忆时,序列熵变为:

而平均每个符号熵为(即,每个符号的符号熵等于单个符号信源的符号熵H(X)):

当有记忆时,序列熵变为:

如果是平稳信源且满足m阶马尔科夫性质时,考虑状态转移概率,特别是一步状态转移概率:

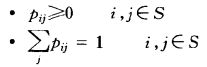

满足:

可写为矩阵形式(转移矩阵):

注意:只有每行和为1,对于列不成立。

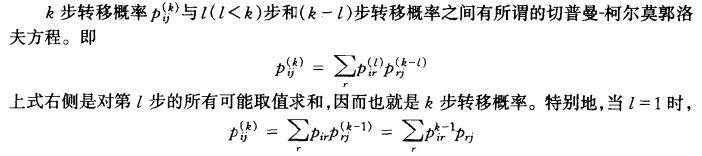

对于k步的转移概率为:

放到矩阵上(比较好理解):

但是求这种信源的熵(马氏链,平稳信源),需要求出稳定分布的概率:

这里的Wj就是经过无数步后达到 j 的稳等概率,可以列方程求解:

为了使马氏链最后达到稳定,成为遍历的马氏链,还必须有不可约性和非周期性。

不可约性:总有路径从任意状态转移到任意状态,下面是反例(非不可约即可约):

非周期性:对于所有状态i,状态i回到状态i需要n步,其中n的取值列中没有比1大的公因子,这样可以确保非周期性。

反例:

上图中的S1回到S1的步数为2,4,6,。。。,最大公因数为2,因此,周期为2。因为具有周期性,达不到稳定状态,在周期内的每一个步数都有一个稳态。

具有不可约性和非周期性的马氏链:

列方程即可求得,该稳定分布概率为{1/2,1/2},由此,该马氏链是遍历的(不论从哪一个状态出发,步数足够大时,转移概率为常数,即到达稳态)。

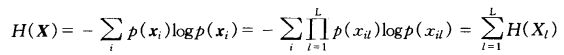

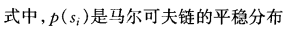

终于,这种信源的熵为(平稳的马尔科夫信源):

也就是上面提及的Wi。

也就是上面提及的Wi。

例题:

2.5 冗余度

冗余度(多余度/剩余度),这与信源符号间的相关性和信源符号分布的不均匀性有关。当信源输出符号间彼此不存在依赖关系且为等概率分布时,信源实际熵趋于最大熵H0(X)。

信息效率:(不肯定性的程度,需要传输的信息与真实传输信息的比值,真实传输的信息肯定有冗余,大于需要传输的信息)

冗余度(肯定性的程度):

第三章 无失真信源编码

无失真信源编码定理为第一极限定理;

信道编码定理(离散和连续信道)为第二极限定理;

限失真信源编码定理为第三极限定理。

信源编码的主要任务就是去除冗余,由此,基本途径有两种:一种是解除相关性,另一种是概率均匀化。

3.1 编码的定义

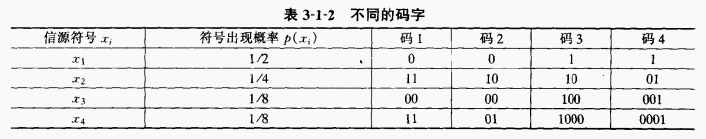

分组码(块码):每个符号序列Xi按照固定的码表映射一个码字Yi。例如:上表中码1,2,3,4

定长码与不定长码 :上表中的例子都为不定长

非奇异码:信源符号和码字是一一对应的。例如,码2,3,4;反之,为奇异码(我的理解为产生歧义)。例如,码1

唯一可译码:码元序列被唯一分割。例如{0,10,11},码3,4

显然,奇异码不是唯一可译码,非奇异码中有非唯一可译码(如码2),也有唯一可译码。

唯一可译码又分为:

非即时码、即时码(异前缀码):可以不可以即时译码。例如码3、4分别对应。

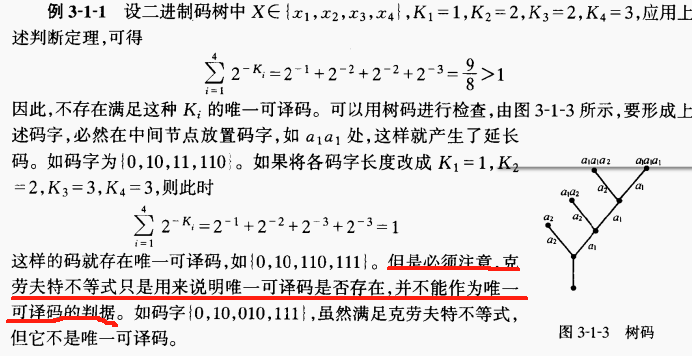

码树:用来表示码字的构成。

r进码树,n级节点有r^n个。

如果指定某个n级节点为终端节点,表示一个信源符号,即,满足从树根到每一个终端节点说走的路径均不相同,形成对前缀的限制,此为即时码。

满树,如图(a),构造出来的码为树码,是定长码。否则,非满树,如图(b),为非定长码。

对于唯一可译码的充分和必要条件,各个码字的长度Ki应该符合克劳夫特不等式(满足只能说明存在):

其中,m是进制数,n是信源符号数。

例子:

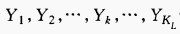

3.2 定长编码定理

定长编码定理:对于无记忆平稳信源符号序列 每个符号的熵为

每个符号的熵为 ,可用KL个符号进行定长编码,每个符号有m种可能值,理解为m进制,{0,1,2,…,m-1}。

,可用KL个符号进行定长编码,每个符号有m种可能值,理解为m进制,{0,1,2,…,m-1}。 只要:

只要:

当L足够大时,就可以使译码差错足够小,可以认定为几乎无失真。取等于的时候,恰好处于临界状态,有失真或者无失真都有可能。

若:

此为平均信息率,即当每个信源符号所必须输出的码长,平均码长。

译码差错为有限值,当L足够大时,译码几乎必定出错。

将上上个公式改写:

这里的理解就可以是:只要码字的信息量大于信源序列的信息量,就可以使传输几乎无失真条件是当L足够大。

编码效率:

那L多大呢?例子来说明:

而对于连续信源,只能进行限失真编码。

因此,一般来说,当L有限时,高传输效率的定长码往往要引入一定的失真和错误(就不是无失真了),不像变长码那样可以实现无失真编码。

3.3 变长编码定理

单个符号变长编码定理:

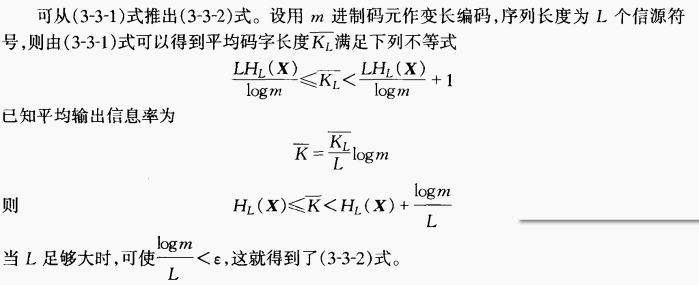

离散无记忆信源的符号熵为H(X),每个信源符号 用m进制码元进行变长编码,则存在无失真编码,其码字平均长度K-满足(可以把logm乘过来,就变成H(X)+logm>K-*logm>=H(X),信源信息量加一个码字信息量>码字信息量>=信源信息量):

离散平稳无记忆序列变长编码定理:

平均符号熵 ,必存在一种无失真编码,平均信息率K-满足:

,必存在一种无失真编码,平均信息率K-满足:

可以由上式,推导:

那L多长呢?

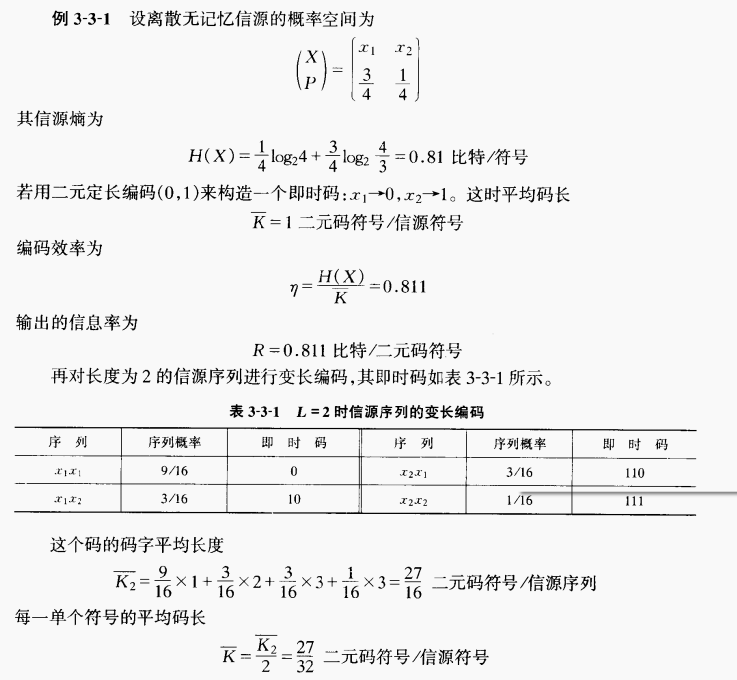

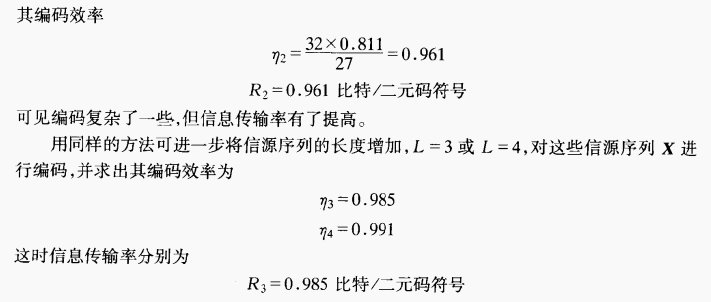

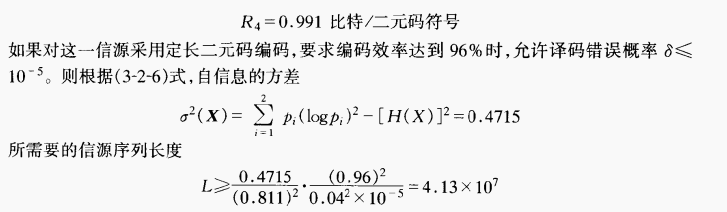

且,对于例3-2-1:

上两个小节的关键理解:

3.4 最佳编码

最佳码:码字平均长度短,可分离的变长码。(香农码、费诺编码、Huffman编码)

香农编码:

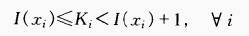

每个码字长度Ki满足: 为香农编码。

为香农编码。

方法:

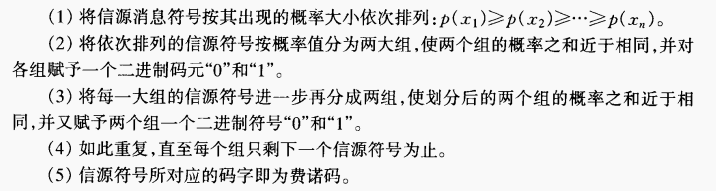

费诺编码:(不是最佳编码,但是比香农码平均码长小,消息传输速率大,编码效率高。)

方法:

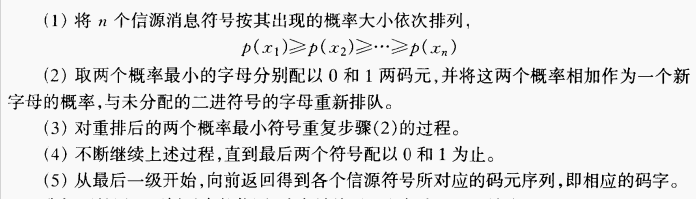

Huffman编码:

但是,Huffman编码不唯一,但是可以得到码方差最小的码(唯一),应减少合并次数,充分利用短码。例如:

第四章 限失真信源编码

4.1 平均失真和信息率失真函数

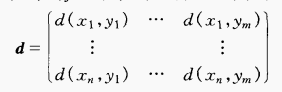

失真函数:信源xi,信源编码后yi,一般失真函数定义为:

此为失真矩阵。

此为失真矩阵。

失真函数的形式:

平均失真:

失真函数的数学期望:

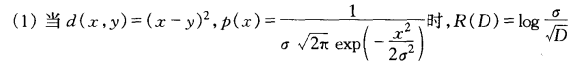

信息率失真函数R(D):

在满足平均失真D的限制下的允许信道PD集合中,寻找一个pij,使得经过此信道传输后,互信息最小。

这里的理解为,此函数给出了失真小于D时,所必须具有的最小信息率,即R(D)对应的值。

对于离散无记忆信源:

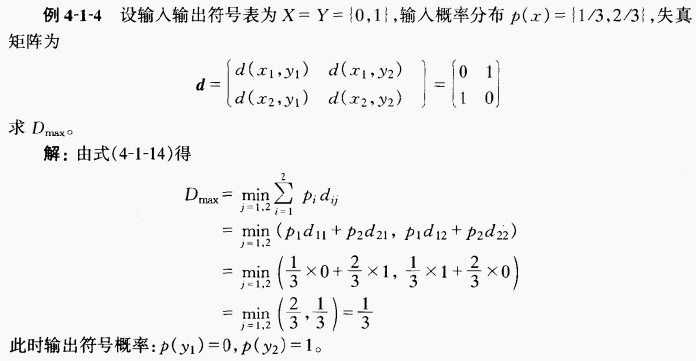

R(D)的定义域:

D是数学期望,非负。

若D=0,则相当于无损信道:

其中,最大值:

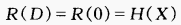

例题:

R(D)是下凸且连续的。

R(D)的单调递增性:容许的失真度越大,所要求的信息率越小(被压缩的越狠)。

4.2 离散信源和连续信源的R(D)计算

给定信源概率pi和失真函数dij,就可以求信源的R(D)函数。但是显示表达式一般比较困难的。

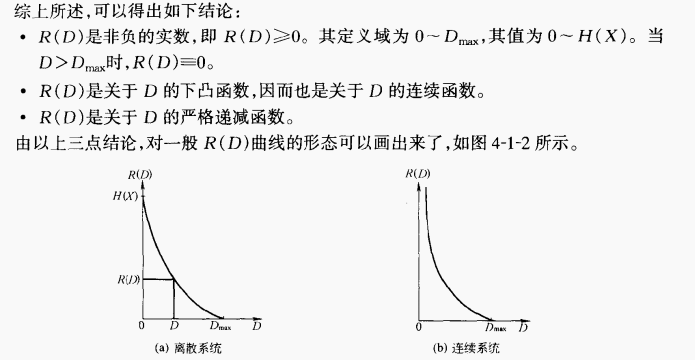

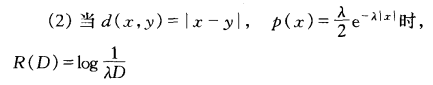

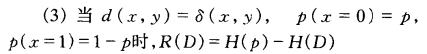

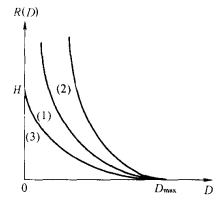

某些特殊情况R(D)的表达式:

上面三个R(D)函数如图:

其中,Dmax分别为

其中,Dmax分别为

对于第一个,Dmax的情况是全部损失信息,也就是说不管x是什么,y都为1或者0,此时的平均失真D-就是方差。

4.3 限失真信源编码定理

对于离散无记忆信源X,依据其信息率R以及R(D)函数之间的大小关系,我们可以判定是否存在一种编码方法,使得失真小于或等于D+e,其中e为任意小的数。

若,R>R(D),则存在,只要信源序列L足够长。反之,则不存在。

907

907

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?