ComfyUI的LoRA工作流相信大家都不陌生。开发者提供了大量基于默认节点功能搭建的工作流,其中就包括了如何使用LoRA。

仅仅使用一个LoRA也许还比较简单。只需要在基本工作流的基础上,再添加一个LoRA加载器的节点即可。如果要添加多个LoRA,就需要往里面继续加入LoRA加载器。这使得工作流变得很长,丧失了优雅和高效。

今天,我来介绍在ComfyUI中使用LoRA的极简工作流。如果只使用一个LoRA的话,只需要两个节点。

如果你需要再添加多个LoRA的话,只需要再添加一个LoRA节点。是不是非常简单呢?

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

安装必要的工具

首先,我们需要安装称为“Efficiency Nodes”的一系列自定义节点。这需要你已经安装了 ComfyUI

Manager。以下是安装自定义节点的步骤:

1️⃣ 打开 ComfyUI Manager 界面。

2️⃣ 点击安装自定义节点的按钮,

3️⃣在对话框中输入“efficiency”,并点击搜索。

4️⃣选择出现的第一个“效率节点”并安装。安装完成后点击重启按钮。

构建基础 LoRA 工作流

安装完效率节点后,就可以开始构建 LoRA 工作流了:

1️⃣

双击空白处打开搜索节点的工具栏,输入“eff”,找到“Efficient

Loader”节点。

2️⃣ 添加“Efficient Loader”节点,这个节点支持SD1.5,整合了多个功能如Checkpoint、VAE、Clip Skip

跳过层、LoRA、提示词、Latent宽高和批次数量。

3️⃣ 接下来,需要搭配一个采样器来生成图片。再次双击空白处,在搜索框输入“efficient”并选择一个基础版采样器。

4️⃣ 连接这两个节点。简单地用五条直线连接即可。

5️⃣设置模型和 LoRA 参数,写入提示词,然后生成图片。

如何同时使用多个 LoRA

如果需要同时调用多个 LoRA,操作如下:

1️⃣ 在“Efficient Loader”上找到“lora_stack”的输入端。

2️⃣ 拖拽并选择“LoRA Stacker”,以叠加多个 LoRA。

3️⃣ 设置要叠加的 LoRA 数量,例如选择两个:一个调节笑容的 LoRA 和一个调节脸型大小的 LoRA。

4️⃣ 设置各自的权重,然后生成图片,观察 LoRA 的效果。从笑容和脸型上,我们可以看出,这两个LoRA都生效了。

5️⃣如果需要在生成过程中保存图片,可以简单地从相应节点拖出一个保存图片的节点,实现保存功能。

总结

通过上述步骤,你可以看到,使用 ComfyUI

和效率节点,我们不仅简化了传统的工作流程,同时也保持了工作流的高效和优雅。

但由于AIGC刚刚爆火,网上相关内容的文章博客五花八门、良莠不齐。要么杂乱、零散、碎片化,看着看着就衔接不上了,要么内容质量太浅,学不到干货。

这里分享给大家一份Adobe大神整理的《AIGC全家桶学习笔记》,相信大家会对AIGC有着更深入、更系统的理解。

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

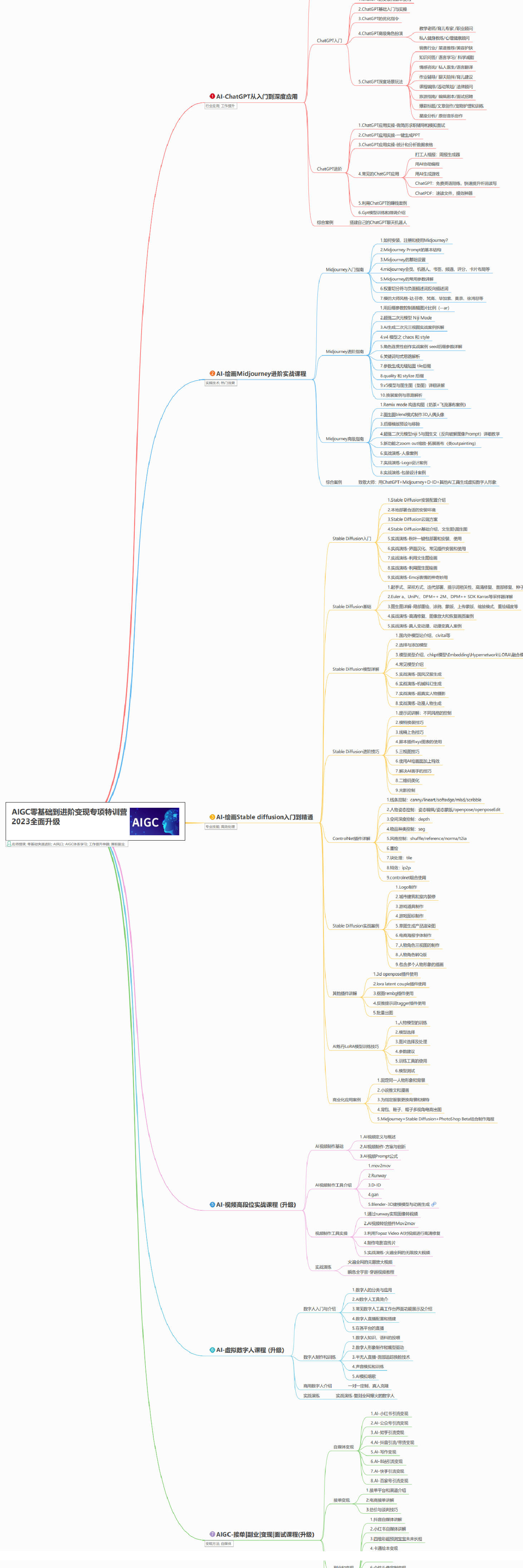

AIGC所有方向的学习路线思维导图

这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。如果下面这个学习路线能帮助大家将AI利用到自身工作上去,那么我的使命也就完成了:

AIGC工具库

AIGC工具库是一个利用人工智能技术来生成应用程序的代码和内容的工具集合,通过使用AIGC工具库,能更加快速,准确的辅助我们学习AIGC

有需要的朋友,可以点击下方卡片免费领取!

精品AIGC学习书籍手册

书籍阅读永不过时,阅读AIGC经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验,结合自身案例融会贯通。

AI绘画视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,科学有趣才能更方便的学习下去。

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

5164

5164

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?