Logistic回归在二分类问题上被广泛地应用,因为其在多数的问题上,比线性回归优异得多。下面是以最简单的二分类因变量为例来加以探讨(当然,逻辑回归还可以应用于多分类的情况下),常定义出现阳性结果时反应时反应变量取值为1,反之则取值为0。例如当对网络用户进行营销的时候,结果是:营销成功,用户购买,则反应变量为1,否则用户没有购买,因此反应变量为0。记出现阳性结果的频率为P(y=1)。很显然,0<=P<=1。

这里可能你会不明白为什么会定义一个P值。其实定义这个P值是很有意义的,也是逻辑回归的核心作用,因此,它就是指在给定特征条件的条件下求出现阳性的条件概率:P(y=1|X),其中X是一个向量。很自然,当P>0.5的时候,我们认为是阳性的,否则可以认为它是阴性的(0)。在这里,假设影响用户购买的因素有两个:消费总金额、工资,因此这里的X是两维的。

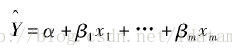

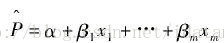

看到这里,你可能会第一步是想到线性回归,首先回顾一下标准的线性回归模型:

如果对分类变量直接拟合,则实质上拟合的是发生概率,参照上面回归方程,很自然地会想到是否可以建立下面形式的回归模型:

显然,该模型可以描述当自变量变化时,因变量的发生概率会怎样变化,可以满足分析的需要。实际上,统计学家们最早也在朝这一方向努力,并考滤到最小二乘法拟合时遇到的各种问题,对计算方法进行了改进,最终提出了加权最小二乘法来对模型进行拟合。

但是这种方法却存在严重的缺陷,存在以下两个问题是这种分析思路所无法解决的。

(一)取值区间:上述模型的右侧的取值范围,或者说应用上述模型进行预报的范围为整个实数集,而模型的左边的取值范围为0<=P<=1,二者并不相符;

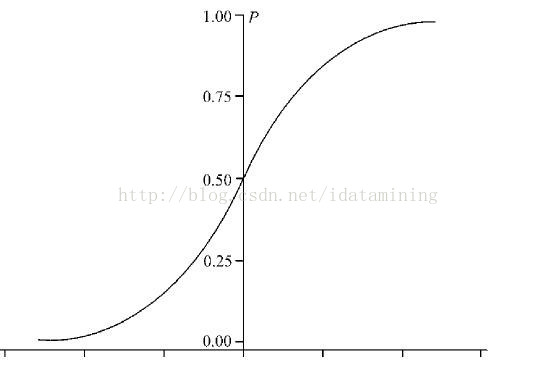

(二)曲线关联:根据大量的观察,反应变量P与自变量的关系通常不是直线关系,而是S型曲线关系。使用上例子来说,当收入非常低时,收入的增加对购买概率影响很小的,但是在达到某一个阀值时,购买概率会随着收入的增加而迅增加;在购买水平达到一定的水平的时候绝大部分在该收入水平的人都会购买,收入的增加的影响又会逐渐减弱。如果用图形来表示,则如下图所示。

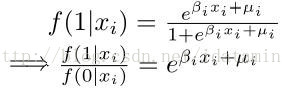

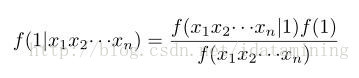

显然,线性关联是线性回归中至关重要的一个前提假设,而在上述模型中这一假设是明显无法满足的。 到了这一步,现在反客为主,如果你是Cox,让你自己做,应该怎么去拟合这个函数概率呢?呵呵,如果我是Cox的话,假设存在n个特征,那么第一步想到的是贝叶斯定理:

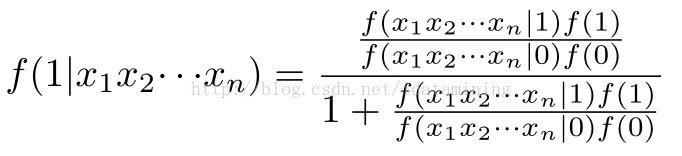

上式就是求目标函数公式,代表的就是出现各项特征的时候的条件概率。根据上式,可以有:

再化成如下形式:

(1)

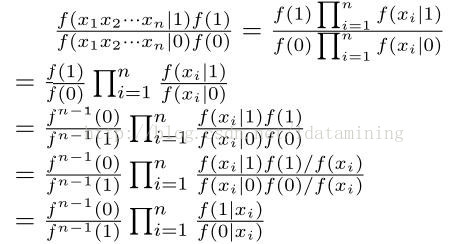

看到右边的等式,你想到了些什么?如果你想到的是朴素贝叶斯定理,你就进了一步了,因为这一步是最为关键的一步,也是泛化到其他回归的算法的思想,也是其他回归而不限于逻辑回归的核心假设。没错,就是使用朴素贝叶斯定理,即假设类条件下,各变量都是独立的,因此有如下结果:

到了这一步再逆转一下,得到:

(2)

接下来要用到上面(2)中的假设了,也就是说,反应变量P与自变量的关系通常不是直线关系,而是S型曲线关系,而每个特征概率曲线为:

结合(1)、(2)、(3)式可得:

因此,使用逻辑回归时,要注意两个重要的假设,就是:

(1)各个变量应该呈S型分布的,满足这个条件假设得到的效果往往是最好的,否则得出的结果效果不好,但是可以根据构建模型的思想,使用特征的实际分布曲线而构造出新的回归模型,因此要学会举一反三;

(2)类条件独立性,就是在给定类别的条件下,各特征因素是相互独立的。经常看到很多书没有提到这一点,而很多人都认为模型是不存在条件独立性这个假设的,因此在这里需要纠正一下。

2766

2766

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?