Display System

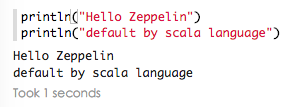

- text

- 默认使用scala语言输出text内容

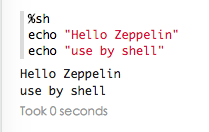

- shell

- 默认使用scala语言输出text内容

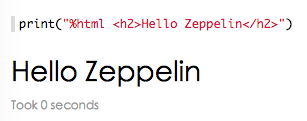

- html

- scala 输出html

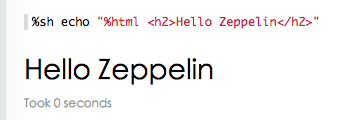

- shell 输出html

- scala 输出html

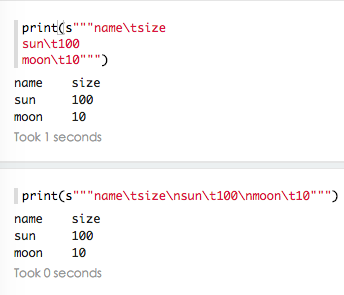

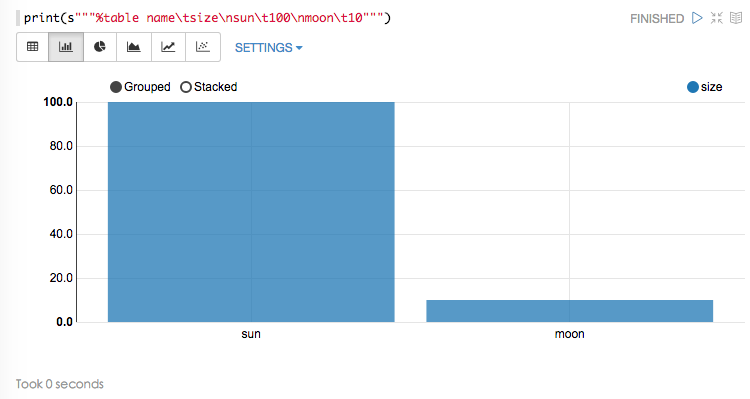

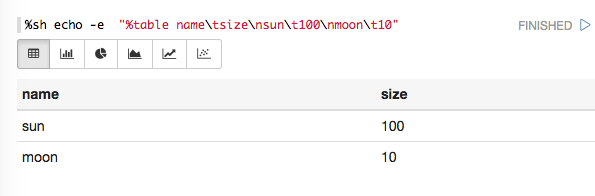

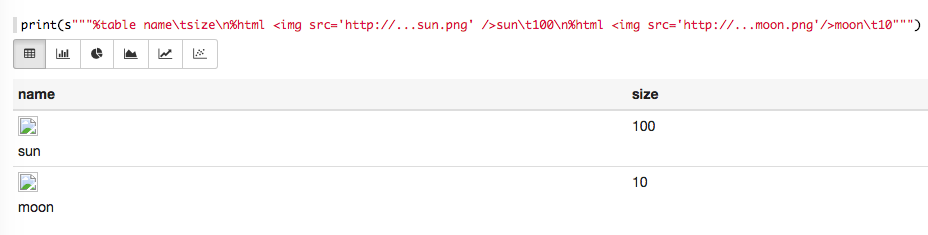

- table

- scala

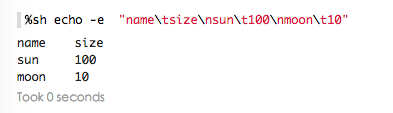

- shell

- table

scala:

shell:

html:

- scala

Manual

-

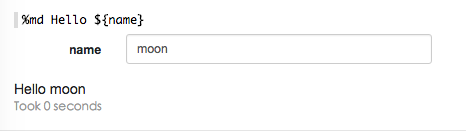

动态表格

- 使用表格模板

文本输入格式:

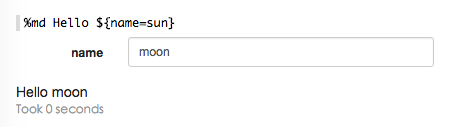

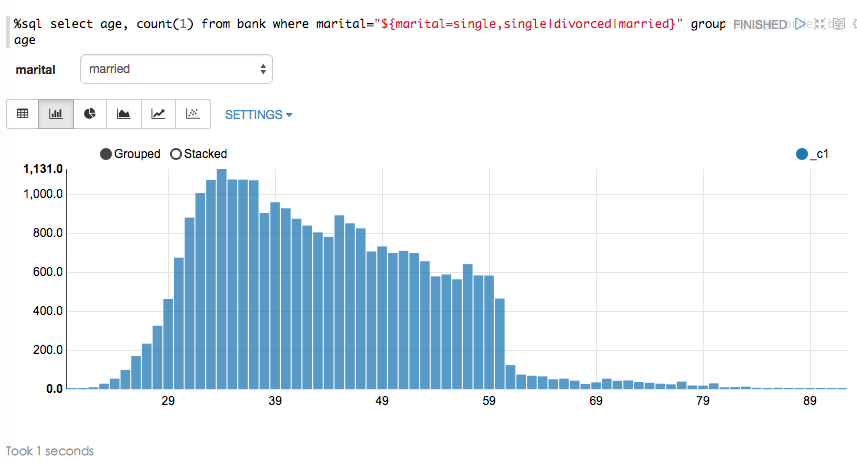

使用 formName模板,使用{formName=defaultValue} 提供默认值 - 下拉选择表格

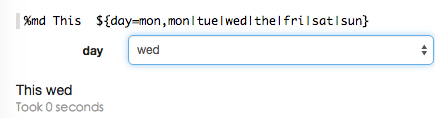

${formName=defaultValue,option1|option2…}

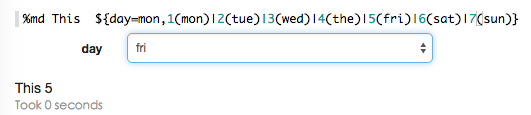

k-v格式,${formName=defaultValue,

option1(DisplayName)|option2(DisplayName)…} - 动态编程

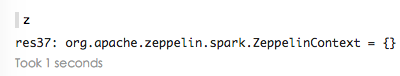

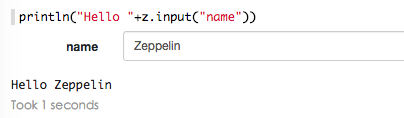

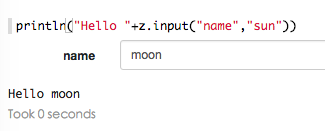

z 是ZeppelinContext对象 - 文本输入格式

- 带默认值的文本输入格式

- 下拉选择表格

- 使用表格模板

-

Notebook as Homepage

这部分不是很重,直接看这个链接吧,http://zeppelin.incubator.apache.org/docs/manual/notebookashomepage.html

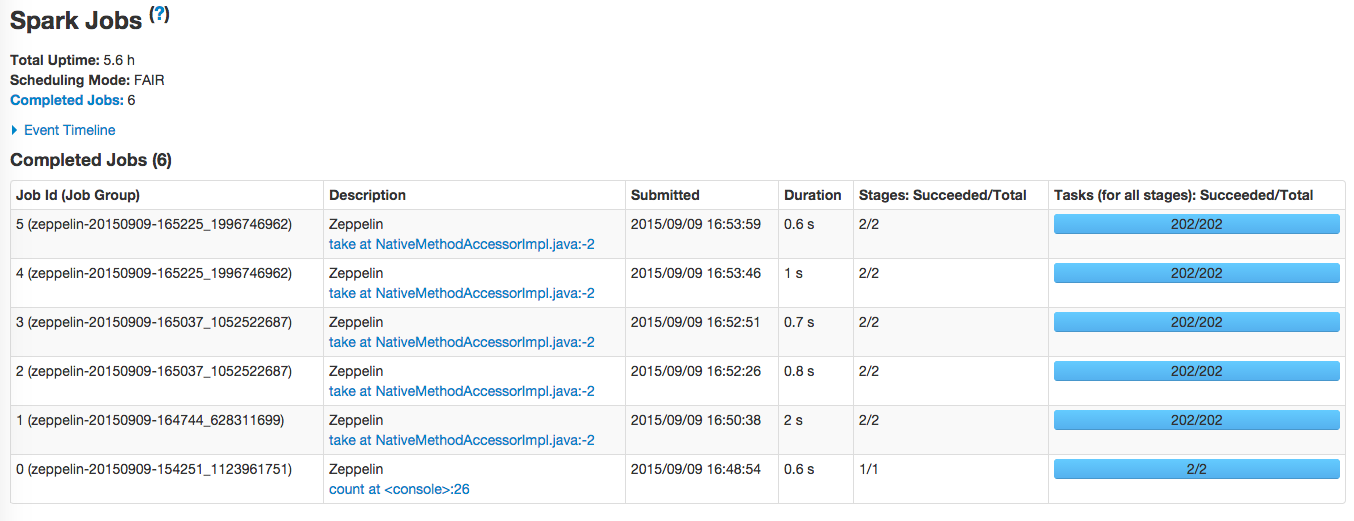

Interpreter

- spark,http://zeppelin.incubator.apache.org/docs/interpreter/spark.html

- hive

- md

- sh

- flink

- and so on

上面都有涉及,如何使用

Tutorial with Local File

- Data Refine

下载需要bank数据,http://archive.ics.uci.edu/ml/machine-learning-databases/00222/bank.zip

首先,将csv格式数据转成Bank对象RDD,并过滤表头列

val bankText = sc.textFile("/home/cluster/data/test/bank/bank-full.csv")

case class Bank(age:Integer, job:String, marital : String, education : String, balance : Integer)

val bank = bankText.map(s=>s.split(";")).filter(s=>s(0)!="\"age\"").map(

s=>Bank(s(0).toInt,

s(1).replaceAll("\"", ""),

s(2).replaceAll("\"", ""),

s(3).replaceAll("\"", ""),

s(5).replaceAll("\"", "").toInt

)

)

// Below line works only in spark 1.3.0.

// For spark 1.1.x and spark 1.2.x,

// use bank.registerTempTable("bank") instead.

bank.toDF().registerTempTable("bank")- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- Data Retrieval

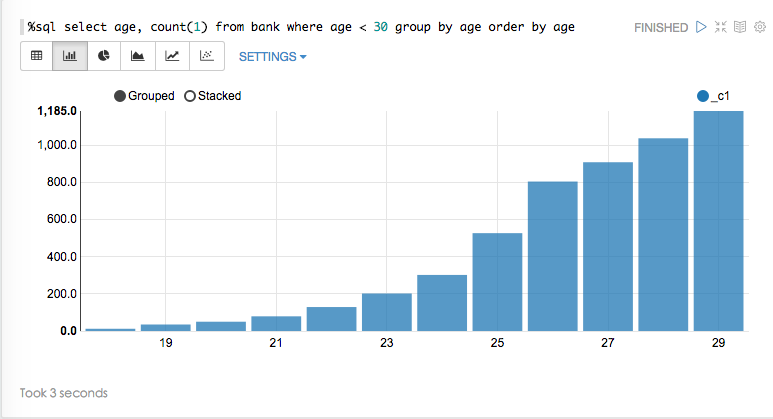

Suppose we want to see age distribution from bank. To do this, run:

执行以下语句,可看到年龄的分布:

%sql select age, count(1) from bank where age < 30 group by age order by age- 1

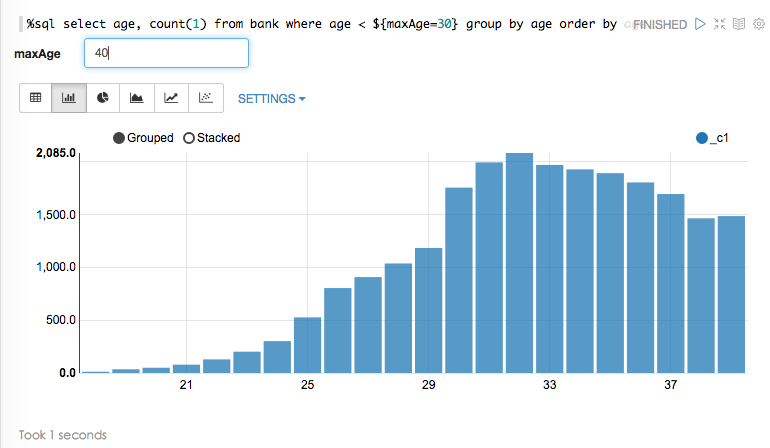

动态输入maxAge参数(默认是30岁):

%sql select age, count(1) from bank where age < ${maxAge=30} group by age order by age- 1

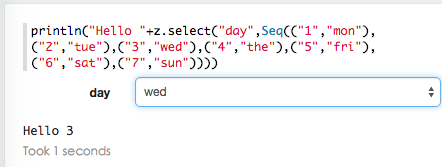

根据婚姻状况选项,查看年龄分布状况:

%sql select age, count(1) from bank where marital="${marital=single,single|divorced|married}" group by age order by age- 1

Zeppelin的工作方式和Spark的Thrift Server很像,都是向Spark提交一个应用(Application),然后每一个查询对应一个stage。

因此,在启动Zeppelin前,可以通过配置环境变量ZEPPELIN_JAVA_OPTS来对即将启动的Spark driver进行配置,例如“-Dspark.executor.memory=6g -Dspark.cores.max=32”。

尊重原创,拒绝转载,http://blog.csdn.net/stark_summer/article/details/48318059

952

952

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?