💓 博客主页:借口的CSDN主页

⏩ 文章专栏:《热点资讯》

计算机科学领域中,基于自监督学习的无标注数据高效利用方法与实践

随着大数据时代的到来,获取大量标注数据的成本变得越来越高。在许多应用场景中,尤其是医疗、金融等领域,由于隐私保护和专业知识门槛等因素,获取高质量的标注数据尤为困难。与此同时,未标注的数据却极其丰富。为了充分利用这些海量的无标签数据,研究者们提出了自监督学习(Self-Supervised Learning, SSL)这一新兴领域。

本文将探讨基于自监督学习的方法如何有效地利用无标注数据,并介绍其在计算机视觉、自然语言处理等领域的应用实例,以及当前面临的技术挑战和发展趋势。

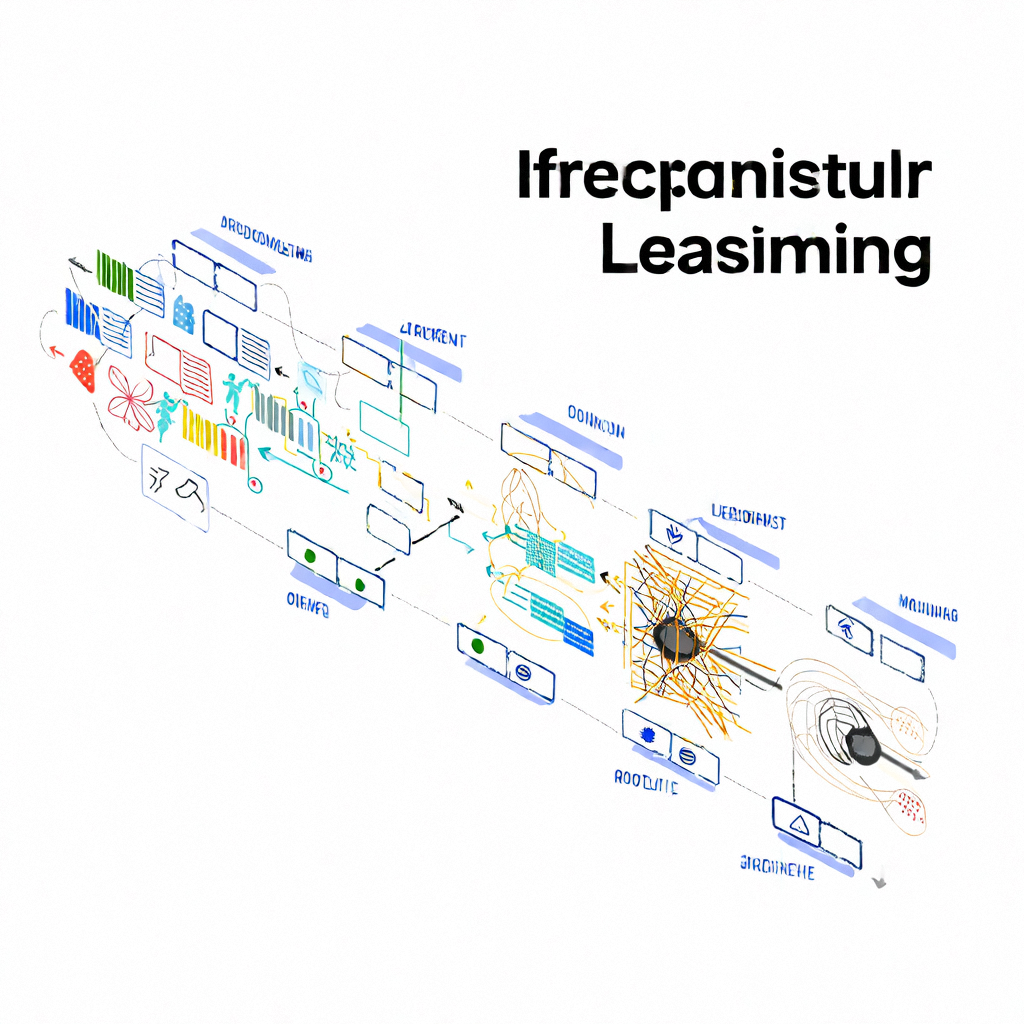

自监督学习是一种特殊的机器学习范式,它通过从原始数据本身构造伪任务或辅助任务来指导模型训练,而不需要人工标注。这种学习方式可以在没有明确监督信号的情况下挖掘数据内在结构,从而获得对下游任务有用的表示。

- 低成本:无需额外付出昂贵的人力成本进行数据标注。

- 广泛适用性:适用于多种类型的数据,如图像、文本、音频等。

- 预训练-微调模式:通常先在一个大规模无标注数据集上进行预训练,然后在特定的小规模有标签数据集上进行微调以适应具体任务。

对比学习是目前最流行的一种自监督学习策略。它的核心思想是比较不同样本之间的相似度,鼓励模型学习到能够区分正负样本对的特征表示。

# Python代码示例:使用SimCLR框架实现对比学习

import tensorflow as tf

from tensorflow.keras import layers

# 假设我们有一个包含图像增强操作的函数data_augmentation

def get_resnet_simclr(hidden_1, hidden_2, projection_dim):

base_model = tf.keras.applications.ResNet50(include_top=False, weights='imagenet')

base_model.trainable = False

inputs = layers.Input(shape=(224, 224, 3))

h = base_model(inputs, training=False)

h = layers.Flatten()(h)

h = layers.Dense(hidden_1, activation='relu')(h)

h = layers.Dense(hidden_2, activation='relu')(h)

representation = layers.Dense(projection_dim)(h)

return tf.keras.Model(inputs, representation)

上述Python代码展示了如何使用SimCLR框架构建一个基于ResNet的对比学习模型。该模型首先通过一系列图像增强操作生成两个视图,接着分别送入编码器得到各自的特征表示,最后计算它们之间的相似度并优化目标函数。

预测学习是指让模型学会根据部分输入去推测其余部分的内容。例如,在自然语言处理中,可以遮蔽句子中的某些单词,要求模型预测缺失的部分;对于图像数据,则可以裁剪出局部区域,让模型恢复整个画面。

# Python代码示例:使用BERT模型实现掩码语言建模

from transformers import BertTokenizer, TFBertForMaskedLM

# 加载预训练好的BERT模型及其分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = TFBertForMaskedLM.from_pretrained('bert-base-uncased')

# 输入一条含有[MASK]标记的句子作为待预测文本

input_text = "The capital of France is [MASK]."

inputs = tokenizer(input_text, return_tensors='tf')

# 使用模型进行预测

logits = model(**inputs).logits

predicted_token_id = tf.argmax(logits[0, -1, :], axis=-1).numpy()

predicted_word = tokenizer.decode([predicted_token_id])

print(predicted_word)

上述Python代码说明了如何使用Hugging Face提供的Transformers库加载预训练的BERT模型,并通过掩码语言建模任务来预测被遮挡的词汇。

在ImageNet等大型数据集上,研究人员发现通过自监督学习获得的表征可以直接用于线性分类器,取得接近甚至超过全监督学习的结果。

自监督学习还可以为物体检测提供强大的预训练模型。例如,MoCo v2+模型在COCO数据集上的表现已经非常接近完全监督下的基线水平。

像BERT这样的预训练语言模型已经在多项NLP基准测试中取得了优异成绩,证明了自监督学习对于捕捉文本深层语义的有效性。

借助于自监督学习得到的知识表示,智能问答系统可以更好地理解问题背景,给出更加准确的答案。

尽管自监督学习减少了对标注数据的依赖,但它仍然可能受到训练数据分布的影响。如果训练集中存在某种偏见,那么模型可能会学到不正确的关联。

一些先进的自监督学习算法需要大量的计算资源和时间来进行训练,这对于普通用户来说是一个不小的障碍。

由于缺乏明确的监督信号,自监督学习模型往往被视为“黑箱”,难以解释其决策过程。未来的研究需要探索如何提高模型透明度。

综上所述,基于自监督学习的方法为解决传统监督学习面临的标注瓶颈提供了新的思路和技术手段。尽管还存在诸多挑战,但随着相关研究和技术的发展,这类方法有望在未来得到更广泛的应用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?