大模型及InternLM模型介绍

定义

人工智能领域中参数数量巨大,拥有庞大计算能力和参数规模的模型

特点及应用

利用大量数据进行训练

拥有数十亿甚至数千亿个参数

模型在各种任务中展现出惊人的性能

lnternLM模型全链条开源

InternLM:一个开源的轻量级训练框架,产出预训练模型:InternLM-7B和InternLM-20B。

Lagent:一个轻量级、开源的基于大语言模型的智能体框架,作用:快速地将一个大语言模型转变为多种类型的智能体

浦语·灵笔:基于书生·浦语大语言模型研发的视觉·语言大模型,有着出色的图文理解和创作能力

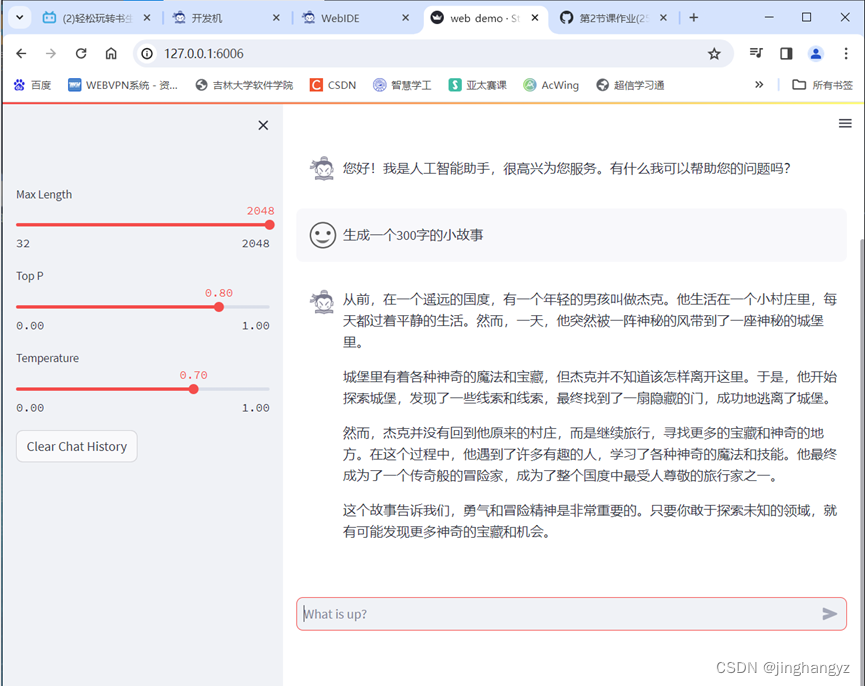

InternLM-Chat-7B智能对话Demo

通过单一的代码库,InternLM支持在拥有数千个GPU的大型集群上进行预训练,并在单个GPU上进行微调,同时实现了卓越的性能优化。在1024个GPU上训练时,InternLM可以实现近90%的加速效率。

InternLM-7B包含了一个拥有70亿参数的基础模型和一个为实际场景量身定制的对话模型。该模型具有以下特点:

利用数万亿的高质量token 进行训练,建立了一个强大的知识库

支持8k token 的上下文窗口长度,使得输入序列更长并增强了推理能力

产品如下:

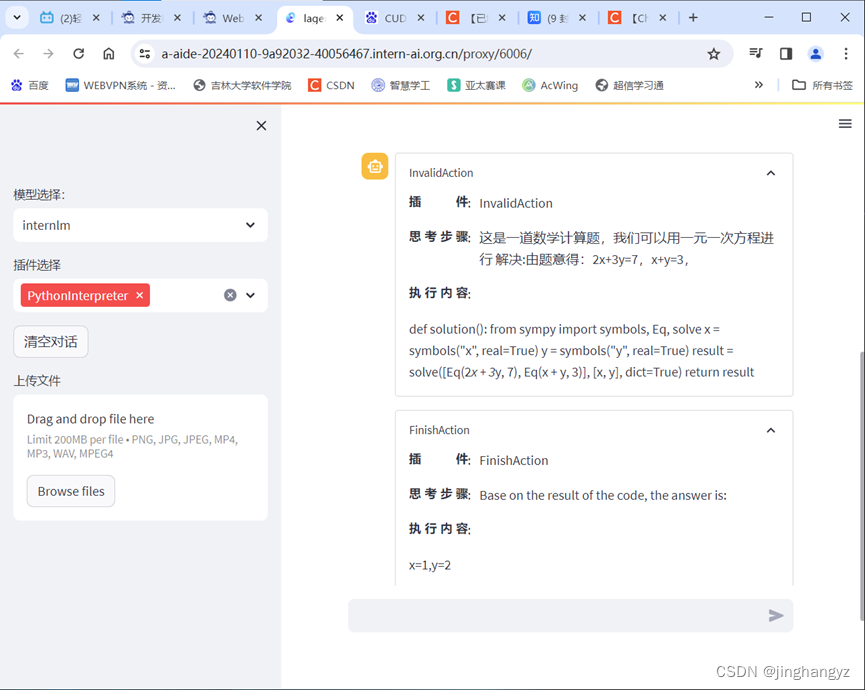

Lagent智能体工具调用Demo

Lagent是一个轻量级、开源的基于大语言模型的智能体框架,用户可以快速地将一个大语言模型转变为多种类型的智能体,并提供了一些典型工具为大语言模型赋能。

产品如下:

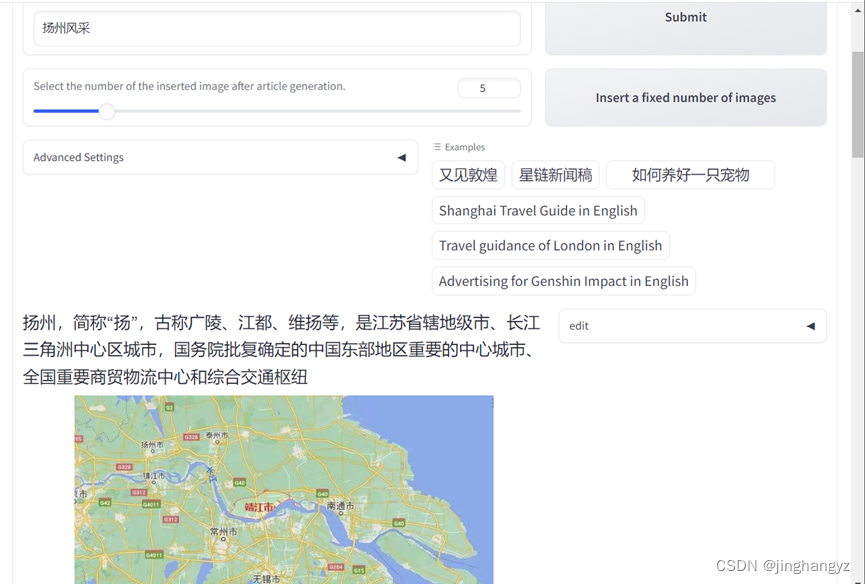

浦语·灵笔图文创作理解Demo

lnternLM-Xcomposer-7B介绍

浦语·灵笔是基于书生·浦语大语言模型研发的视觉-语言大模型,提供出色的图文理解和创作能力,具有多项优势:

1.为用户打造图文并貌的专属文章

2.设计了高效的训练策略,为模型注入海量的多模态概念和知识数据,赋予其强大的图文理解和对话能力

产品如下:

实践中学到的知识

退出时要ctrl+c,否则会造成端口占用和显存不足

本文介绍了人工智能领域中的大模型,如InternLM-7B和20B,它们基于大规模数据训练,拥有数十亿至数千亿参数,表现出色。文章还提及了Lagent智能体框架和浦语·灵笔的图文创作能力。通过开源和微调技术,这些模型展示了高性能和效率提升。

本文介绍了人工智能领域中的大模型,如InternLM-7B和20B,它们基于大规模数据训练,拥有数十亿至数千亿参数,表现出色。文章还提及了Lagent智能体框架和浦语·灵笔的图文创作能力。通过开源和微调技术,这些模型展示了高性能和效率提升。

419

419

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?