通过caffe深度学习框架在cifar10数据集训练得到模型,观察并分析模型的train loss 、test loss及accuracy曲线,并对得到的caffemodel进行测试。

实验环境:Ubuntu14.04+caffe+gtx960+cuda7.5

网络模型

(1)下载数据集

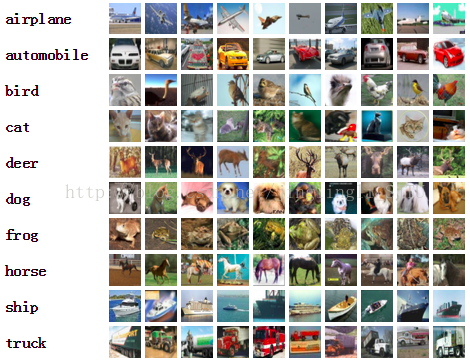

数据集介绍:cifar-10是一个使用非常广泛的物体识别图像数据集,CIFAR-10数据中包含了60000张32×32的彩色图像,其中训练集50000张,测试集10000张。共有10类物体,分别是airplane,automobile,bird,cat,deer,dog,frog,horse,ship,truck。

实验环境:Ubuntu14.04+caffe+gtx960+cuda7.5

网络模型

(1)下载数据集

首先需要从CIFAR-10网站上下载数据集并将图片转为lmdb格式以及计算二进制格式均值,caffe框架中的

本文介绍了CIFAR-10数据集,它包含60000张32x32彩色图像,分为10个类别。训练涉及将原始数据转换为lmdb格式,计算二进制平均值,并使用Caffe框架进行处理。讨论了Caffe对lmdb和h5py数据格式的支持,以及图像预处理对模型训练和测试的影响。

本文介绍了CIFAR-10数据集,它包含60000张32x32彩色图像,分为10个类别。训练涉及将原始数据转换为lmdb格式,计算二进制平均值,并使用Caffe框架进行处理。讨论了Caffe对lmdb和h5py数据格式的支持,以及图像预处理对模型训练和测试的影响。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3662

3662

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?