Hadoop (二)Hadoop安装环境搭建

一、选择Primary Namenode和Secondary Namenode

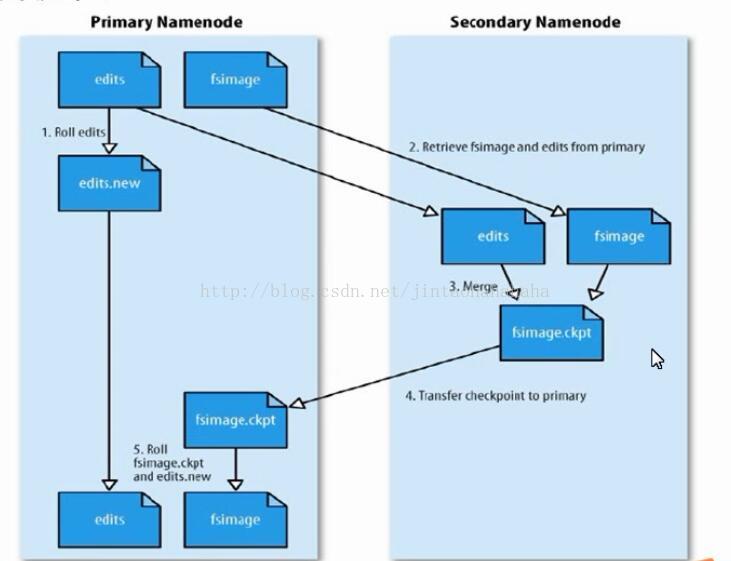

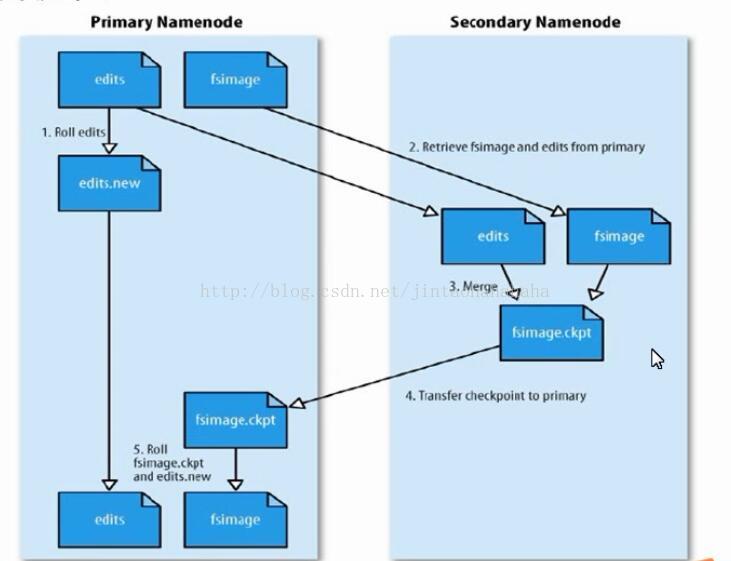

Primary Namenode和Secondary Namenode关系如下图所示:

图1.1 SNN(Secondary Namenode)合并流程

Primary Namenode和Secondary Namenode关系如下图所示:

图1.1 SNN(Secondary Namenode)合并流程

由上图可知,Secondary Namenode在一定程度上可以作为Primary Namenode的备份,并且Primary Namenode中所存储元数据是十分重要的。因此我们一般将Secondary Namenode和Primary Namenode选择两台不同机架上的两台主机。

在此,我使用192.168.1.201作为Primary Namenode;使用192.168.1.202作为Secondary Namenode。在之前的四台服务器基础上再加一台192.168.1.205,使192.168.1.203~192.168.1.205这三台服务器作为DataNode。一共使用五台服务器,便可以搭建起一个Hadoop环境。

二、在Hadoop官网下载Hadoop

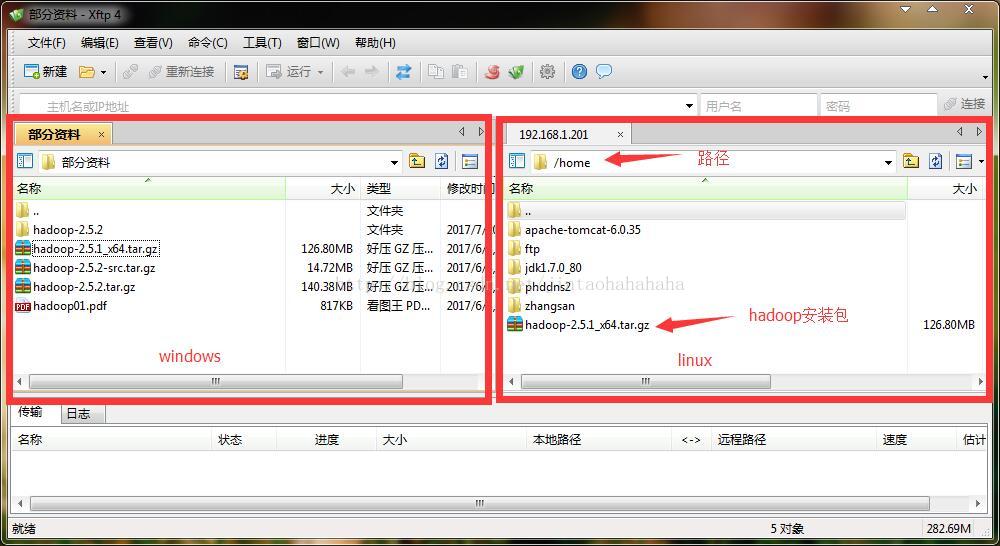

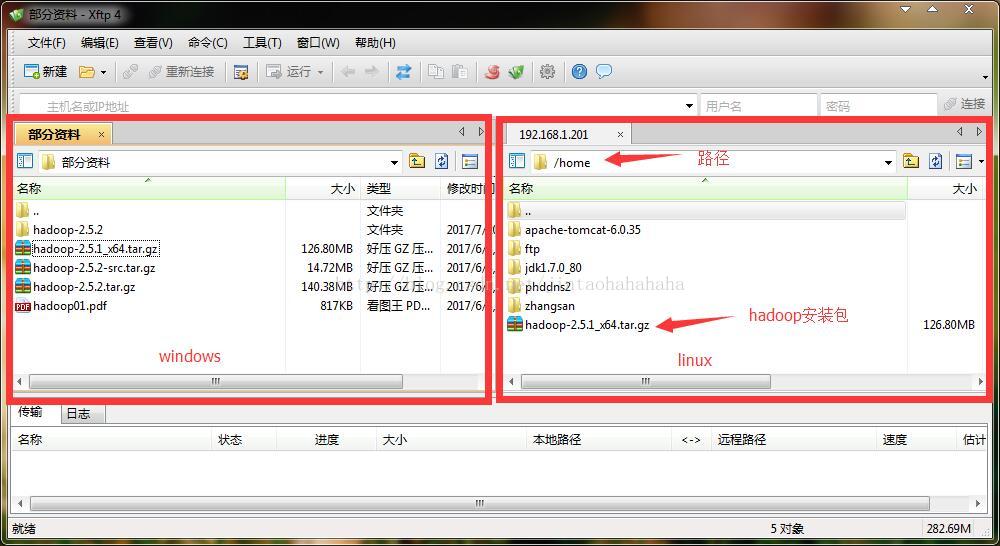

三、将下载的文件传至192.168.1.201某个目录(我在这放在/home下)中

四、解压Hadoop压缩包

进入/home目录,执行命令

五、修改hosts文件

给linux中、etc/hosts文件添加如下配置,配置主机名与ip的对应关系

1、配置jdk

进入hadoop-2.5.1目录中

2、配置Primary Namenode端口

进入hadoop-2.5.1目录中

保存,退出编辑模式。

3、配置Secondary Namenode端口

进入hadoop-2.5.1目录中

保存,退出编辑模式。

4、配置Datanode主机

进入hadoop-2.5.1目录中

5、配置Secondary Namenode主机

进入hadoop-2.5.1目录中

七、将/home下hadoop文件夹拷贝至另外几台服务器

在192.168.1.201下分别执行下列命令

进入如下文件

九、将配置的Hadoop环境变量应用至所有服务器

在192.168.1.201下分别执行下列命令

在每一个服务器下都执行下方命令,应用环境变量

在192.168.1.201上执行下方命令

十二、启动Hadoop

在192.168.1.201上执行下方命令

十三、进入监控页面

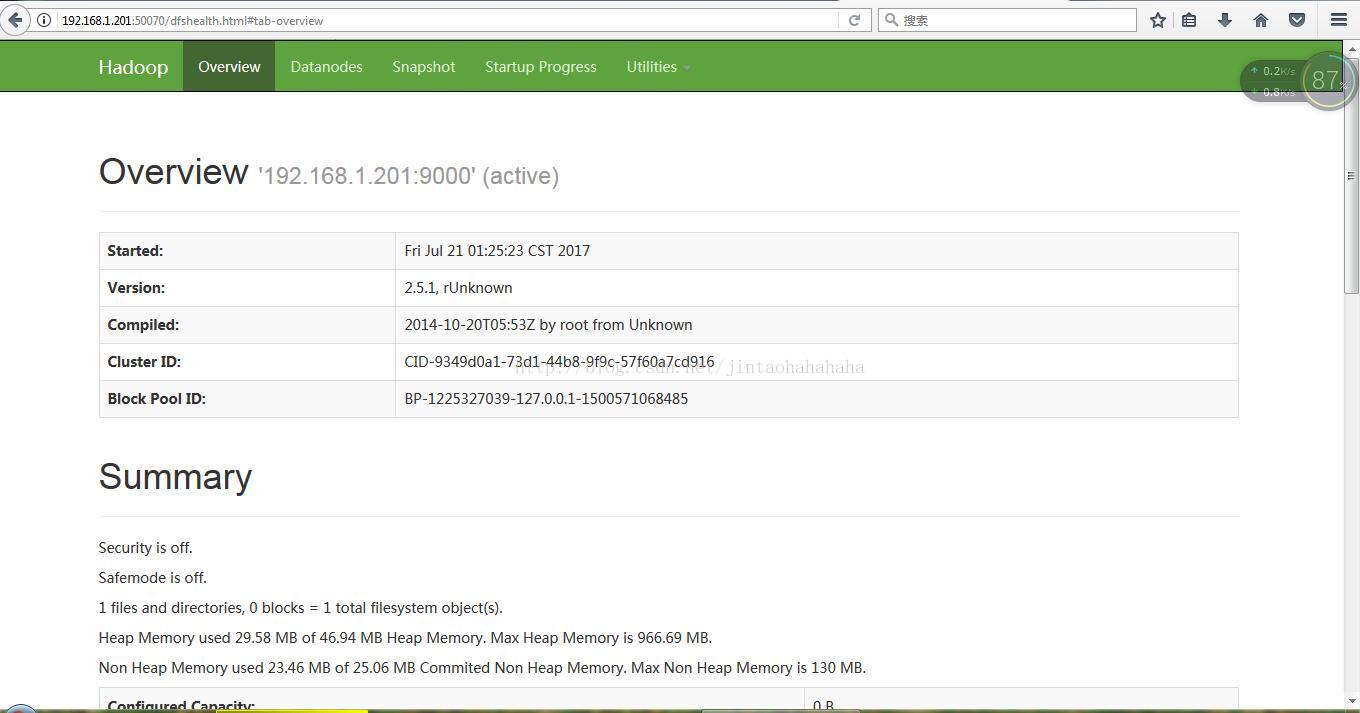

浏览器输入http://192.168.1.201:50070,会看到如下界面,则表示我满启动成功

【注意:要打开防火墙对端口的限制啊】

在此,我使用192.168.1.201作为Primary Namenode;使用192.168.1.202作为Secondary Namenode。在之前的四台服务器基础上再加一台192.168.1.205,使192.168.1.203~192.168.1.205这三台服务器作为DataNode。一共使用五台服务器,便可以搭建起一个Hadoop环境。

二、在Hadoop官网下载Hadoop

三、将下载的文件传至192.168.1.201某个目录(我在这放在/home下)中

四、解压Hadoop压缩包

进入/home目录,执行命令

tar -sxvf hadoop-2.5.1_x64.tar.gz五、修改hosts文件

给linux中、etc/hosts文件添加如下配置,配置主机名与ip的对应关系

192.168.1.201 namenode

192.168.1.202 secondary_namenode

192.168.1.203 datenode1

192.168.1.204 datenode2

192.168.1.205 datanode31、配置jdk

进入hadoop-2.5.1目录中

cd /home/hadoop-2.5.1/etc/hadoop/

vi hadoop-env.sh

2、配置Primary Namenode端口

进入hadoop-2.5.1目录中

cd /home/hadoop-2.5.1/etc/hadoop

vi core-site.xml

<configuration>

</configuration><configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://namenode:9000</value>

</property>

<property>

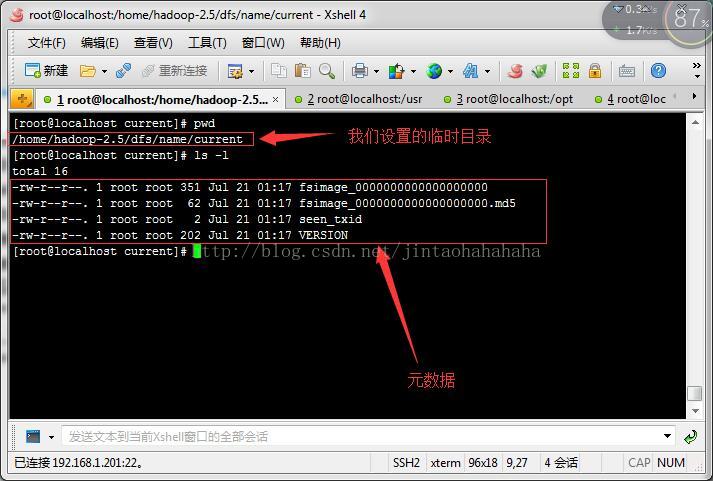

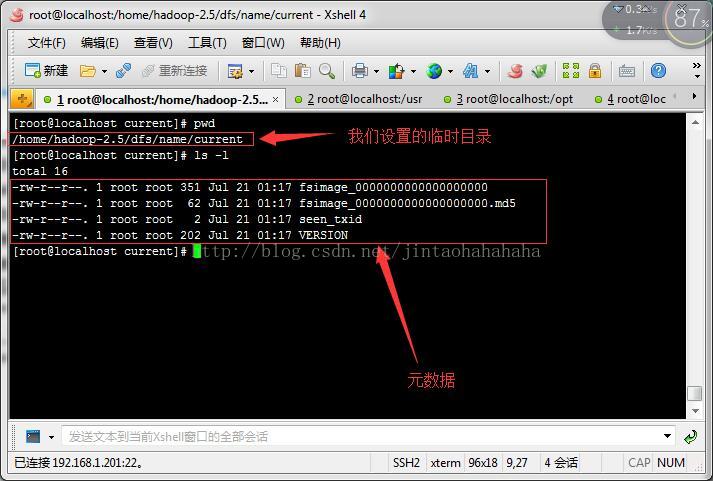

<name>hadoop.tmp.dir</name> ---hadoop临时目录

<value>/home/hadoop-2.5</value> ---hadoop临时目录地址

</property>

</configuration>保存,退出编辑模式。

3、配置Secondary Namenode端口

进入hadoop-2.5.1目录中

cd /home/hadoop-2.5.1/etc/hadoop

vi vi hdfs-site.xml

<configuration>

</configuration><configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>secondary_namenode:50090</value>

</property>

<property>

<name>dfs.namenode.secondary.https-address</name>

<value>secondary_namenode:50091</value>

</property>

</configuration>

保存,退出编辑模式。

4、配置Datanode主机

进入hadoop-2.5.1目录中

cd /home/hadoop-2.5.1/etc/hadoop

vi slaves

datanode1

datanode2

datanode3

5、配置Secondary Namenode主机

进入hadoop-2.5.1目录中

cd /home/hadoop-2.5.1/etc/hadoop

vi masters

secondary_namenode

七、将/home下hadoop文件夹拷贝至另外几台服务器

在192.168.1.201下分别执行下列命令

scp -r /home/hadoop-2.5.1/ root@192.168.1.202:/home/

scp -r /home/hadoop-2.5.1/ root@192.168.1.203:/home/

scp -r /home/hadoop-2.5.1/ root@192.168.1.204:/home/进入如下文件

vi ~/.bash_profile export HADOOP_HOME=/home/hadoop-2.5.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin九、将配置的Hadoop环境变量应用至所有服务器

在192.168.1.201下分别执行下列命令

scp ~/.bash_profile root@192.168.1.202:/root/

scp ~/.bash_profile root@192.168.1.203:/root/

scp ~/.bash_profile root@192.168.1.204:/root/在每一个服务器下都执行下方命令,应用环境变量

source ~/.bash_profile在192.168.1.201上执行下方命令

hdfs namenode -format

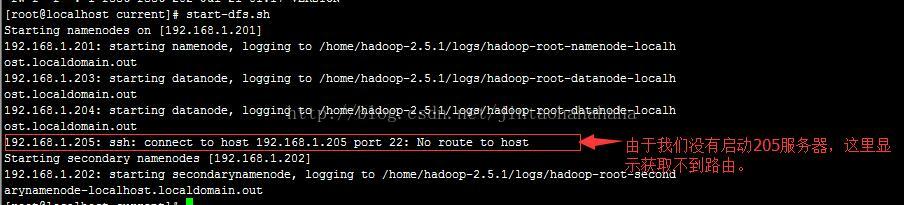

十二、启动Hadoop

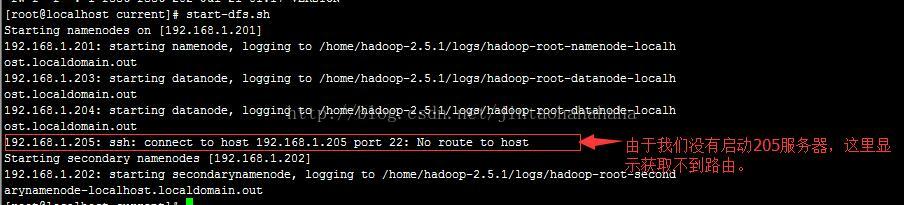

在192.168.1.201上执行下方命令

start-dfs.sh

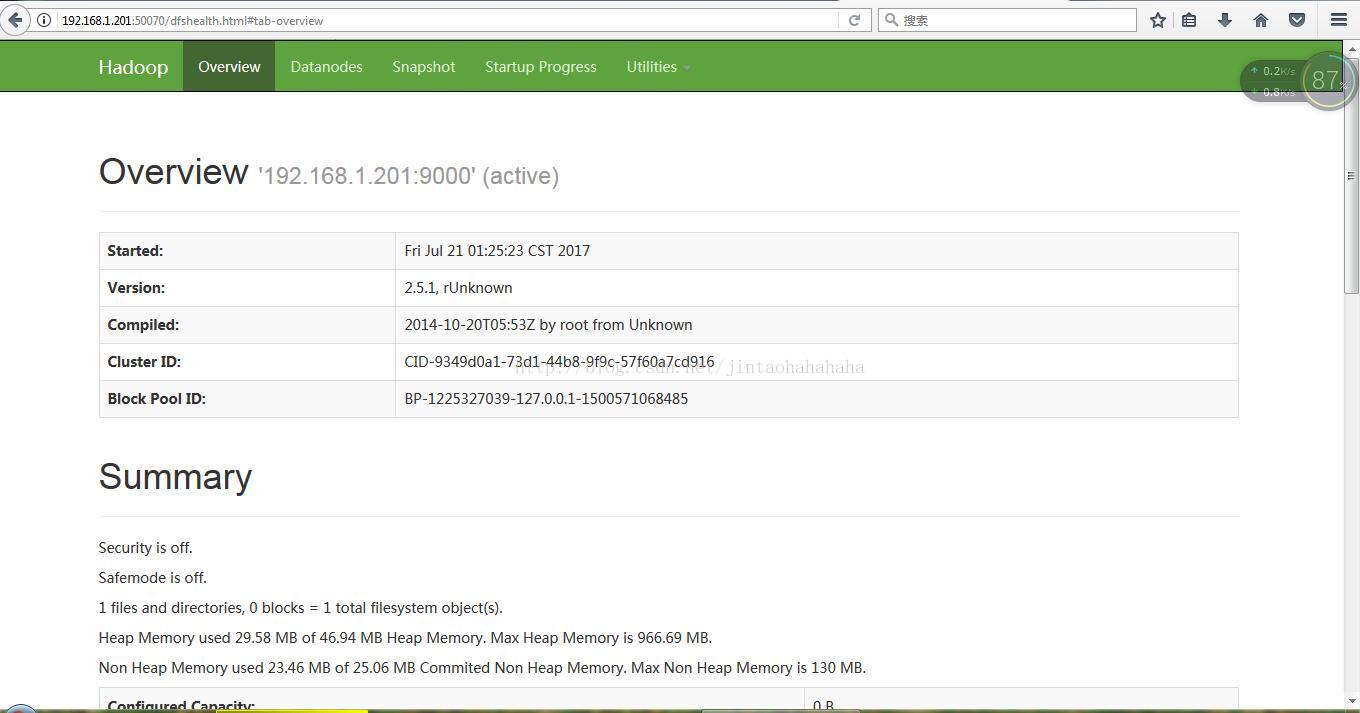

十三、进入监控页面

浏览器输入http://192.168.1.201:50070,会看到如下界面,则表示我满启动成功

【注意:要打开防火墙对端口的限制啊】

424

424

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?