面试的时候,虽然做过医疗文献搜索,也应用过L2R的相关模型,但涉及到其中的一些技术细节,都会成为我拿不下offer永远的痛。也尝试过去理解去背下一些知识点,终究没有力透纸背,随着时间又开始变得模糊,下面对相关问题进行一个总结。

一、PointWise、PairWise和ListWise

这个并不是特定的算法,而是排序模型的设计思路,主要体现在损失函数(Loss Function)以及相应的标签标注方式和优化方法的不同。

PointWise

可以训练一个二分类网络:,其中

。训练的目标是最小化数据集中所有问题和候选句子对的交叉熵。

缺陷是虽然预测分数,但损失函数只考虑正负样本,并不要求精确打分,正样本内的先后关系并不在考虑范围。

Pointwise常见算法有SVM等

PairWise

损失函数为合页损失函数:

这里m为边界阈值,即正样本的得分不仅要比负样本的高,而且还要高出一定阈值范围,。

缺陷是对噪音更加敏感,比如一个样本标注错误,会引起多个pair对错误,仅考虑了pair对的相对位置信息,并没有考虑到绝对位置信息。

Pairwise常见算法有Ranking SVM、RankNet、RankBoost等。

ListWise

在训练过程中给定提问和它的一系列候选句子

和标签

,归一化的得分向量

通过如下公式计算:

标签归一化为,

训练的目标可以为最小化和

的KL散度。

Listwise常见算法有AdaRank,SoftRank,LambdaMART等

二、RankNet、LambdaRank和LambdaMart

RankNet

RankNet的训练数据是一个个的pair对,比如文章(i,j),然后模型对两个候选进行打分,我们建模的目标是一个概率,即模型认为候选i比候选j更相关的概率:

,

LambdaRank

首先对RankNet的损失函数进行分解,得到其中的梯度,

可以表示梯度的强度,进一步简化,假设对于文档对(i,j),都有文档i在文档j前面,即

,则

LambdaRank主要创新点在于不直接定义模型的损失函数再求梯度,而是通过分析RankNet排序损失函数的梯度再直接对梯度lambda进行修改。

现在将NDCG,ERR等指标引入lambda中,论文中的做法是交换两个文档i,j的位置,然后计算评估指标的变化情况,把

作为lambda的因子,Z可以是NDCG等评价指标

通过梯度lambda也可以反推出LambdaRank的损失函数,如下,

三、LambdaMart的实现原理

MART: Multiple Additive Regression Tree

GBDT: Gradient Boosting Decision Tree

- 基于多个决策树来预测结果;

- 决策树之间通过加法模型叠加结果;

- 每棵决策树都是针对之前决策树的不足进行改进。

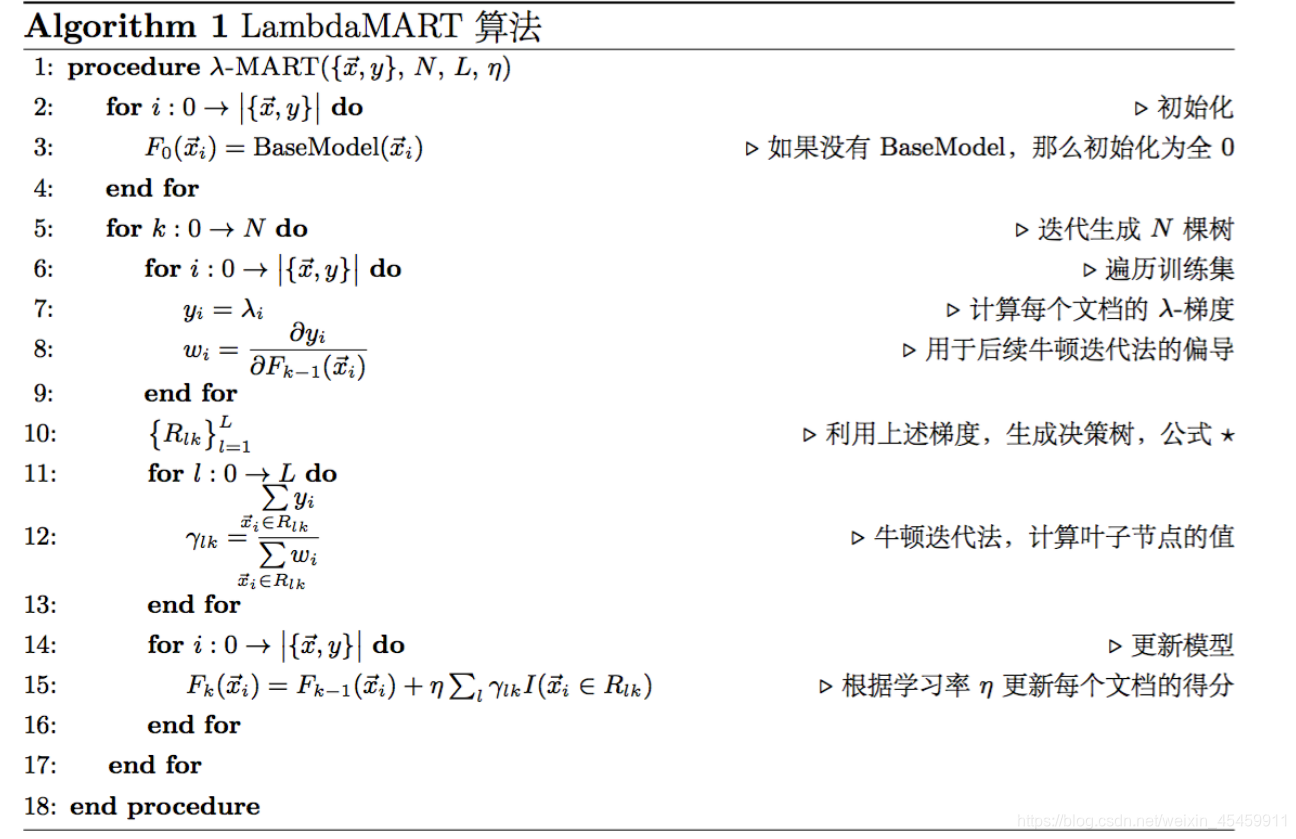

综上的伪代码可知,lambdaMart的计算经历这样几个步骤

- 利用训练数据每个query的pair对情况,计算

,

同时,计算的,还有权重参数,用于牛顿迭代法,但实际代码中感觉没有用到这一块。

2. 以每个样本特征为,以

为拟合目标

,构建决策树,

3. 然后用训练的决策树去预测的分数,将得到分数加入

中,

4、然后重复上面3个步骤,训练多棵决策树。

说到决策树的训练:lambdaMART采用最朴素的最小二乘法,也就是最小化平方误差和来分裂节点:即对于某个选定的feature,选定一个值val,所有<=val的样本分到左子节点,>val的分到右子节点。然后分别对左右两个节点计算平方误差和,并加在一起作为这次分裂的代价。遍历所有feature以及所有可能的分裂点val(每个feature按值排序,每个不同的值都是可能的分裂点),在这些分裂中找到代价最小的。

五、评价指标

NDCG

这里计算的时候,会可能会采取两种策略,需要注意下:

1、预测结果的分数不要,只要文档的顺序,而具体分数用文档真实的分数,也就是分子分母计算的用的是同一套,只不过由于预测文档的先后顺序出现变动,最大分数未必会出现在第一位;

2、分子用预测分数,分母用真实分数。

另外需要注意的一点是分子分母计算面对可能并非完全一样的样本集。

649

649

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?